歷史表明,網(wǎng)絡(luò)安全威脅隨著新的技術(shù)進(jìn)步而增加。關(guān)系數(shù)據(jù)庫帶來了SQL注入攻擊,Web腳本編程語言助長了跨站點腳本攻擊,物聯(lián)網(wǎng)設(shè)備開辟了創(chuàng)建僵尸網(wǎng)絡(luò)的新方法。而互聯(lián)網(wǎng)打開了潘多拉盒子的數(shù)字安全弊病,社交媒體創(chuàng)造了通過微目標(biāo)內(nèi)容分發(fā)來操縱人們的新方法,并且更容易收到網(wǎng)絡(luò)釣魚攻擊的信息,比特幣使得加密ransowmare攻擊成為可能。類似的威脅網(wǎng)絡(luò)安全的方法還在不斷產(chǎn)生。關(guān)鍵是,每項新技術(shù)都會帶來以前難以想象的新安全威脅。

最近,深度學(xué)習(xí)和神經(jīng)網(wǎng)絡(luò)在支持各種行業(yè)的技術(shù)方面變得非常突出。從內(nèi)容推薦到疾病診斷和治療以及自動駕駛,深度學(xué)習(xí)在做出關(guān)鍵決策方面發(fā)揮著非常重要的作用。

現(xiàn)在我們所面臨的問題是,知道神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)算法所特有的安全威脅是什么?在過去幾年中,我們已經(jīng)看到了惡意行為者開始使用深度學(xué)習(xí)算法的特征和功能來進(jìn)行網(wǎng)絡(luò)攻擊的示例。雖然我們?nèi)匀徊恢篮螘r會出現(xiàn)大規(guī)模的深度學(xué)習(xí)攻擊,但這些例子可以說成是將要發(fā)生事情的序幕。

你應(yīng)該知道

深度學(xué)習(xí)和神經(jīng)網(wǎng)絡(luò)可用于放大或增強(qiáng)已存在的某些類型的網(wǎng)絡(luò)攻擊。例如,你可以使用神經(jīng)網(wǎng)絡(luò)在網(wǎng)絡(luò)釣魚詐騙中復(fù)制目標(biāo)的寫作風(fēng)格。正如DARPA網(wǎng)絡(luò)大挑戰(zhàn)在2016年所展示的那樣,神經(jīng)網(wǎng)絡(luò)也可能有助于自動發(fā)現(xiàn)和利用系統(tǒng)漏洞。但是,如上所述,我們專注于深度學(xué)習(xí)所特有的網(wǎng)絡(luò)安全威脅,這意味著在深度學(xué)習(xí)算法進(jìn)入我們的軟件之前,它們不可能存在。我們也不會涵蓋算法偏見和神經(jīng)網(wǎng)絡(luò)的其他社會和政治含義,如操縱選舉。要研究深度學(xué)習(xí)算法的獨特安全威脅,首先必須了解神經(jīng)網(wǎng)絡(luò)的獨特特征。

什么使深度學(xué)習(xí)算法獨一無二?

深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一個子集,機(jī)器學(xué)習(xí)是一個人工智能領(lǐng)域,其中軟件通過檢查和比較大量數(shù)據(jù)來創(chuàng)建自己的邏輯。機(jī)器學(xué)習(xí)已存在很長時間,但深度學(xué)習(xí)在過去幾年才開始流行。

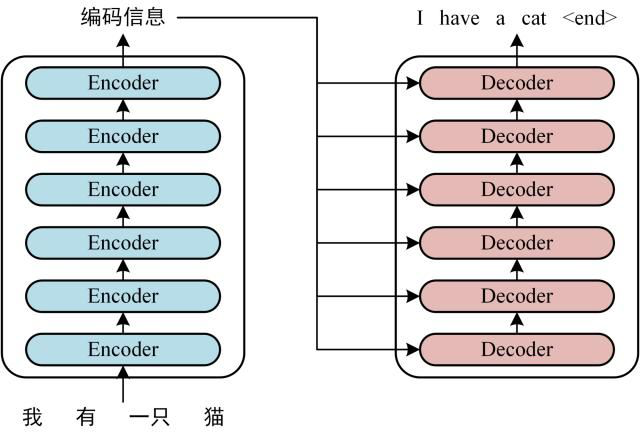

人工神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)算法的基礎(chǔ)結(jié)構(gòu),大致模仿人類大腦的物理結(jié)構(gòu)。與傳統(tǒng)的軟件開發(fā)方法相反,傳統(tǒng)的程序員精心編寫定義應(yīng)用程序行為的規(guī)則,而神經(jīng)網(wǎng)絡(luò)通過閱讀大量示例創(chuàng)建自己的行為規(guī)則。

當(dāng)你為神經(jīng)網(wǎng)絡(luò)提供訓(xùn)練樣例時,它會通過人工神經(jīng)元層運行它,然后調(diào)整它們的內(nèi)部參數(shù),以便能夠?qū)哂邢嗨茖傩缘奈磥頂?shù)據(jù)進(jìn)行分類。這對于手動編碼軟件來說是非常困難的,但神經(jīng)網(wǎng)絡(luò)卻非常有用。

例如,如果你使用貓和狗的樣本圖像訓(xùn)練神經(jīng)網(wǎng)絡(luò),它將能夠告訴你新圖像是否包含貓或狗。使用經(jīng)典機(jī)器學(xué)習(xí)或較舊的AI技術(shù)執(zhí)行此類任務(wù)非常困難,一般很緩慢且容易出錯。計算機(jī)視覺、語音識別、語音轉(zhuǎn)文本和面部識別都是由于深度學(xué)習(xí)而取得巨大進(jìn)步的。

但神經(jīng)網(wǎng)絡(luò)在保證準(zhǔn)確性的同時,失去的卻是透明度和控制力。神經(jīng)網(wǎng)絡(luò)可以很好地執(zhí)行特定任務(wù),但很難理解數(shù)十億的神經(jīng)元和參數(shù)是如何進(jìn)行網(wǎng)絡(luò)決策的。這被稱為“AI黑匣子”問題。在許多情況下,即使是創(chuàng)建深度學(xué)習(xí)算法的人也很難解釋他們的內(nèi)部工作原理。

總結(jié)深度學(xué)習(xí)算法和神經(jīng)網(wǎng)絡(luò)兩個與網(wǎng)絡(luò)安全相關(guān)的特征:

他們過分依賴數(shù)據(jù),這意味著他們與他們訓(xùn)練的數(shù)據(jù)一樣好(或壞)。它們是不透明的,這意味著我們不知道它們?nèi)绾纹鹱饔谩=酉聛恚覀兛纯磹阂庑袨檎呷绾卫蒙疃葘W(xué)習(xí)算法的獨特特征來進(jìn)行網(wǎng)絡(luò)攻擊。

對抗性攻擊

神經(jīng)網(wǎng)絡(luò)經(jīng)常會犯錯,這對人類來說似乎是完全不合邏輯甚至是愚蠢的。例如,去年,英國大都會警察局用來檢測和標(biāo)記虐待兒童圖片的人工智能軟件錯誤地將沙丘圖片標(biāo)記為裸體。在另一個案例中,麻省理工學(xué)院的學(xué)生表示,對玩具龜進(jìn)行微小改動會導(dǎo)致神經(jīng)網(wǎng)絡(luò)將其歸類為步槍。

這些錯誤一直伴隨著神經(jīng)網(wǎng)絡(luò)而存在。雖然神經(jīng)網(wǎng)絡(luò)通常會輸出與人類產(chǎn)生的結(jié)果非常相似的結(jié)果,但它們并不一定經(jīng)歷相同的決策過程。例如,如果你只用白貓和黑狗的圖像訓(xùn)練一個神經(jīng)網(wǎng)絡(luò),它可能會優(yōu)化其參數(shù),根據(jù)動物的顏色而不是它們的物理特征對動物進(jìn)行分類。

對抗性的例子,導(dǎo)致神經(jīng)網(wǎng)絡(luò)產(chǎn)生非理性錯誤的輸入,強(qiáng)調(diào)了AI算法和人類思維的功能之間的差異。在大多數(shù)情況下,可以通過提供更多訓(xùn)練數(shù)據(jù)并允許神經(jīng)網(wǎng)絡(luò)重新調(diào)整其內(nèi)部參數(shù)來修復(fù)對抗性示例。但由于神經(jīng)網(wǎng)絡(luò)的不透明性,找到并修復(fù)深度學(xué)習(xí)算法的對抗性示例可能非常困難。

惡意行為者可以利用這些錯誤對依賴深度學(xué)習(xí)算法的系統(tǒng)進(jìn)行對抗性攻擊。例如,在2017年,密歇根州華盛頓大學(xué)以及加州大學(xué)伯克利分校的研究人員表示,通過進(jìn)行小幅調(diào)整來停止標(biāo)志,他們可以使自動駕駛汽車的計算機(jī)視覺算法不可見。這意味著黑客可以強(qiáng)迫自動駕駛汽車以危險的方式行事并可能導(dǎo)致事故。如下面的例子所示,沒有人類駕駛員不會注意到“被黑”的停車標(biāo)志,但神經(jīng)網(wǎng)絡(luò)可能完全失明。

在另一個例子中,卡內(nèi)基梅隆大學(xué)的研究人員表示,他們可以欺騙面部識別系統(tǒng)背后的神經(jīng)網(wǎng)絡(luò),通過佩戴一副特殊的眼鏡將一個人誤認(rèn)為另一個人。這意味著攻擊者可以使用對抗攻擊來繞過面部識別身份驗證系統(tǒng)。

對抗性攻擊不僅限于計算機(jī)視覺,它們還可以應(yīng)用于依賴神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)的語音識別系統(tǒng)。加州大學(xué)伯克利分校的研究人員涉及了一種概念驗證,在這種概念驗證中,他們操縱音頻文件的方式會讓人耳不被注意,但會導(dǎo)致AI轉(zhuǎn)錄系統(tǒng)產(chǎn)生不同的輸出。例如,這種對抗性攻擊可用于以在播放時向智能揚聲器發(fā)送命令的方式來改變音樂文件,播放文件的人不會注意到文件包含的隱藏命令。

目前,只在實驗室和研究中心探索對抗性攻擊。暫時還沒有證據(jù)表明發(fā)生過對抗性攻擊的真實案例。發(fā)展對抗性攻擊與發(fā)現(xiàn)和修復(fù)它們一樣困難,因為對抗性攻擊也非常不穩(wěn)定,它們只能在特定情況下工作。例如,視角或照明條件的微小變化可以破壞對計算機(jī)視覺系統(tǒng)的對抗性攻擊。

但它們?nèi)匀皇且粋€真正的威脅,對抗性攻擊將變得商業(yè)化只是時間問題,正如我們在深度學(xué)習(xí)的其他不良用途中看到的那樣。

但我們也看到人工智能行業(yè)也正在努力幫助減輕對抗深度學(xué)習(xí)算法的對抗性攻擊的威脅。在這方面可以提供幫助的方法之一是使用生成對抗網(wǎng)絡(luò)(GAN)。GAN是一種深度學(xué)習(xí)技術(shù),它使兩個神經(jīng)網(wǎng)絡(luò)相互對抗以產(chǎn)生新數(shù)據(jù)。第一個網(wǎng)絡(luò)即生成器創(chuàng)建輸入數(shù)據(jù),第二個網(wǎng)絡(luò),即分類器,評估由生成器創(chuàng)建的數(shù)據(jù),并確定它是否可以作為特定類別傳遞。如果它沒有通過測試,則生成器修改其數(shù)據(jù)并再次將其提交給分類器。兩個神經(jīng)網(wǎng)絡(luò)重復(fù)該過程,直到生成器可以欺騙分類器認(rèn)為它創(chuàng)建的數(shù)據(jù)是真實的。GAN可以幫助自動化查找和修補(bǔ)對抗性示例的過程。

另一個可以幫助強(qiáng)化神經(jīng)網(wǎng)絡(luò)抵御對抗性攻擊的趨勢是創(chuàng)建可解釋的人工智能。可解釋的AI技術(shù)有助于揭示神經(jīng)網(wǎng)絡(luò)的決策過程,并有助于調(diào)查和發(fā)現(xiàn)對抗性攻擊的可能漏洞。一個例子是RISE,一種由波士頓大學(xué)研究人員開發(fā)的可解釋的人工智能技術(shù)。RISE生成熱圖,表示輸入的哪些部分對神經(jīng)網(wǎng)絡(luò)產(chǎn)生的輸出有貢獻(xiàn)。諸如RISE之類的技術(shù)可以幫助在神經(jīng)網(wǎng)絡(luò)中找到可能存在問題的參數(shù),這些參數(shù)可能使它們?nèi)菀资艿綄剐怨簟?/p>

RISE產(chǎn)生的顯著圖的例子

數(shù)據(jù)中毒(Data poisoning)

雖然對抗性攻擊在神經(jīng)網(wǎng)絡(luò)中可以發(fā)現(xiàn)并解決相關(guān)問題,但數(shù)據(jù)中毒通過利用其過度依賴數(shù)據(jù)在深度學(xué)習(xí)算法中產(chǎn)生問題行為。深度學(xué)習(xí)算法沒有道德、常識和人類思維所具有的歧視的概念。它們只反映了他們訓(xùn)練的數(shù)據(jù)隱藏的偏見和趨勢。2016年,推特用戶向微軟部署的人工智能聊天機(jī)器人提供仇恨言論和種族主義言論,在24小時內(nèi),聊天機(jī)器人變成了納粹支持者和大屠殺否認(rèn)者,然后毫不猶豫地發(fā)出了惡意評論。

由于深度學(xué)習(xí)算法僅與其數(shù)據(jù)質(zhì)量保持一致,因此為神經(jīng)網(wǎng)絡(luò)提供精心定制的訓(xùn)練數(shù)據(jù)的惡意行為者可能會導(dǎo)致其表現(xiàn)出有害行為。這種數(shù)據(jù)中毒攻擊對于深度學(xué)習(xí)算法特別有效,這些算法從公開可用或由外部參與者生成的數(shù)據(jù)中提取訓(xùn)練。

已經(jīng)有幾個例子說明刑事司法、面部識別和招募中的自動化系統(tǒng)由于其訓(xùn)練數(shù)據(jù)中的偏差或缺點而犯了錯誤。雖然這些例子中的大多數(shù)是由于困擾我們社會的其他問題而在我們的公共數(shù)據(jù)中已經(jīng)存在的無意錯誤,但沒有什么能阻止惡意行為者故意毒害訓(xùn)練神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)。

例如,考慮一種深度學(xué)習(xí)算法,該算法監(jiān)視網(wǎng)絡(luò)流量并對安全和惡意活動進(jìn)行分類。這是一個無監(jiān)督學(xué)習(xí)的系統(tǒng)。與依賴于人類標(biāo)記的示例來訓(xùn)練其網(wǎng)絡(luò)的計算機(jī)視覺應(yīng)用相反,無監(jiān)督的機(jī)器學(xué)習(xí)系統(tǒng)通過未標(biāo)記的數(shù)據(jù)來仔細(xì)查找共同的模式,而無需接收關(guān)于數(shù)據(jù)所代表的具體指令。

例如,AI網(wǎng)絡(luò)安全系統(tǒng)將使用機(jī)器學(xué)習(xí)為每個用戶建立基線網(wǎng)絡(luò)活動模式。如果用戶突然開始下載比正常基線顯示的數(shù)據(jù)多得多的數(shù)據(jù),系統(tǒng)會將其歸類為潛在的惡意意圖人員。但,具有惡意意圖的用戶可以通過以小增量增加他們的下載習(xí)慣來欺騙系統(tǒng)以慢慢地“訓(xùn)練”神經(jīng)網(wǎng)絡(luò)以認(rèn)為這是他們的正常行為。

數(shù)據(jù)中毒的其他示例可能包括訓(xùn)練面部識別認(rèn)證系統(tǒng)以驗證未授權(quán)人員的身份。去年,在Apple推出新的基于神經(jīng)網(wǎng)絡(luò)的Face ID身份驗證技術(shù)之后,許多用戶開始測試其功能范圍。正如蘋果已經(jīng)警告的那樣,在某些情況下,該技術(shù)未能說出同卵雙胞胎之間的區(qū)別。

但其中一個有趣的失敗是兩兄弟的情況,他們不是雙胞胎,看起來不一樣,年齡相差多年。這對兄弟最初發(fā)布了一段視頻,展示了如何用Face ID解鎖iPhone X.但后來他們發(fā)布了一個更新,其中他們表明他們實際上通過用他們的面部訓(xùn)練其神經(jīng)網(wǎng)絡(luò)來欺騙Face ID。其實這是一個無害的例子,但很容易看出同一模式如何為惡意目的服務(wù)。

由于神經(jīng)網(wǎng)絡(luò)不透明且開發(fā)人員不創(chuàng)建規(guī)則,因此很難調(diào)查并發(fā)現(xiàn)用戶可能故意對深度學(xué)習(xí)算法造成的有害行為。

基于深度學(xué)習(xí)的惡意軟件

今年早些時候,IBM的研究人員引入了一種新的惡意軟件,它利用神經(jīng)網(wǎng)絡(luò)的特性針對特定用戶隱藏惡意負(fù)載,有針對性的攻擊以前是擁有大量計算和情報資源的國家和組織。

但是,由IBM開發(fā)的概念驗證惡意軟件DeepLocker表明,此類攻擊可能很快成為惡意黑客的正常操作方式。DeepLocker已將其惡意行為和有效負(fù)載嵌入到神經(jīng)網(wǎng)絡(luò)中,以將其隱藏在端點安全工具之外,后者通常會在應(yīng)用程序的二進(jìn)制文件中查找簽名和預(yù)定義模式。

DeepLocker的另一個特點是使用神經(jīng)網(wǎng)絡(luò)為其有效載荷指定特定目標(biāo)。為了顯示基于深度學(xué)習(xí)的惡意軟件的破壞性功能,IBM研究人員為DeepLocker提供了勒索軟件病毒,并將其嵌入到視頻會議應(yīng)用程序中。

同時,惡意軟件的開發(fā)人員在通過網(wǎng)絡(luò)攝像頭看到特定用戶的面部時,可以訓(xùn)練神經(jīng)網(wǎng)絡(luò)來激活有效負(fù)載。由于惡意軟件嵌入在視頻會議應(yīng)用程序中,因此它可以合法訪問網(wǎng)絡(luò)攝像頭的視頻源,并能夠監(jiān)控應(yīng)用程序的用戶。一旦目標(biāo)在攝像機(jī)前顯示他們的臉,DeepLocker就會釋放勒索軟件并開始加密用戶計算機(jī)上的所有文件。

黑客將能夠使用DeepLocker等惡意軟件根據(jù)他們的性別和種族,用特定深度學(xué)習(xí)算法來定位特定用戶或群體。我們尚未了解深度學(xué)習(xí)算法和神經(jīng)網(wǎng)絡(luò)的網(wǎng)絡(luò)安全威脅的規(guī)模。創(chuàng)建DeepLocker的研究人員表示,他們并不確定此類惡意軟件是否已經(jīng)在黑客放棄。未來在神經(jīng)網(wǎng)絡(luò)領(lǐng)域面臨的網(wǎng)絡(luò)安全問題,還存在諸多不確定性!

電子發(fā)燒友App

電子發(fā)燒友App

評論