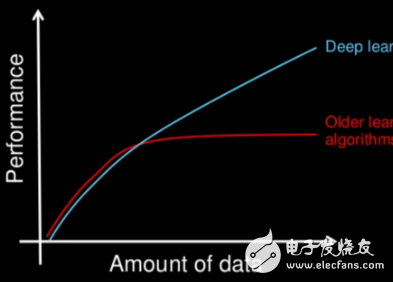

訓(xùn)練數(shù)據(jù)仍然需要大量的人工,為進(jìn)一步減少這一部分的人工,我們對弱標(biāo)注數(shù)據(jù)下的深度學(xué)習(xí)進(jìn)行了一些探索。隨著所要求監(jiān)督信息的減弱,可用訓(xùn)練數(shù)據(jù)會(huì)大量增加。同時(shí),深度模型已經(jīng)具有了很好的推廣能力,我們用深度

2017-03-22 17:16:00

5月份Github上最熱門的數(shù)據(jù)科學(xué)和機(jī)器學(xué)習(xí)項(xiàng)目

2019-07-29 06:57:57

深度學(xué)習(xí)的概念源于人工神經(jīng)網(wǎng)絡(luò)的研究。含多隱層的多層感知器就是一種深度學(xué)習(xí)結(jié)構(gòu)。深度學(xué)習(xí)通過組合低層特征形成更加抽象的高層表示屬性類別或特征,以發(fā)現(xiàn)數(shù)據(jù)的分布式特征表示。晦澀難懂的概念,略微有些難以

2018-07-04 16:07:53

算法性能。換而言之,開發(fā)集和測試集的使命就是引導(dǎo)你的團(tuán)隊(duì)對機(jī)器學(xué)習(xí)系統(tǒng)做出最重要的改變?。所以你應(yīng)當(dāng)這樣處理:合理地選擇開發(fā)集和測試集,使之能夠代表將來實(shí)際數(shù)據(jù)的情況,并期望算法能夠運(yùn)行良好。也就是說你

2018-11-30 16:58:52

汽車安全系統(tǒng)的發(fā)展進(jìn)步中發(fā)揮重要的作用。而這些系統(tǒng)遠(yuǎn)不止僅供典型消費(fèi)者群體掌握和使用。深度學(xué)習(xí)這一概念在幾十年前就已提出,但如今它與特定的應(yīng)用程序、技術(shù)以及通用計(jì)算平臺(tái)上的可用性能更密切相關(guān)。深度學(xué)習(xí)

2022-11-11 07:55:50

深度學(xué)習(xí)入門 中根據(jù)源代碼下載到mnist數(shù)據(jù)集,訓(xùn)練識(shí)別率超級(jí)低問題

2020-07-08 16:53:17

安全系統(tǒng)的發(fā)展進(jìn)步中發(fā)揮重要的作用。而這些系統(tǒng)遠(yuǎn)不止僅供典型消費(fèi)者群體掌握和使用。深度學(xué)習(xí)這一概念在幾十年前就已提出,但如今它與特定的應(yīng)用程序、技術(shù)以及通用計(jì)算平臺(tái)上的可用性能更密切相關(guān)。深度學(xué)習(xí)

2019-03-13 06:45:03

深度學(xué)習(xí)常用模型有哪些?深度學(xué)習(xí)常用軟件工具及平臺(tái)有哪些?深度學(xué)習(xí)存在哪些問題?

2021-10-14 08:20:47

具有深度學(xué)習(xí)模型的嵌入式系統(tǒng)應(yīng)用程序帶來了巨大的好處。深度學(xué)習(xí)嵌入式系統(tǒng)已經(jīng)改變了各個(gè)行業(yè)的企業(yè)和組織。深度學(xué)習(xí)模型可以幫助實(shí)現(xiàn)工業(yè)流程自動(dòng)化,進(jìn)行實(shí)時(shí)分析以做出決策,甚至可以預(yù)測預(yù)警。這些AI

2021-10-27 06:34:15

深度融合模型的特點(diǎn),背景深度學(xué)習(xí)模型在訓(xùn)練完成之后,部署并應(yīng)用在生產(chǎn)環(huán)境的這一步至關(guān)重要,畢竟訓(xùn)練出來的模型不能只接受一些公開數(shù)據(jù)集和榜單的檢驗(yàn),還需要在真正的業(yè)務(wù)場景下創(chuàng)造價(jià)值,不能只是為了PR而

2021-07-16 06:08:20

在串口控制中,如果想用read把緩存全部的數(shù)據(jù)讀取出來,用圖中的結(jié)構(gòu)即可。開始當(dāng)用GPIB控制時(shí),應(yīng)該用什么方法把緩存的數(shù)據(jù)全部讀出來呢?求教!

2016-10-28 11:27:30

問題是這樣的,緩存中的數(shù)據(jù)比較多,1000個(gè)數(shù)據(jù)。讀取到的字符串格式是這樣的,a1,a2,b1,b2,c1,c2...........。我如何能將這些數(shù)據(jù)轉(zhuǎn)成兩列的數(shù)組呢?如: a1 a2b1 b2c1 c2d1 d2這樣的格式呢?

2012-05-22 21:35:34

CV之YOLOv3:深度學(xué)習(xí)之計(jì)算機(jī)視覺神經(jīng)網(wǎng)絡(luò)Yolov3-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄

2018-12-24 11:51:47

CV之YOLO:深度學(xué)習(xí)之計(jì)算機(jī)視覺神經(jīng)網(wǎng)絡(luò)tiny-yolo-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄

2018-12-24 11:50:57

LabVIEW讀取示波器發(fā)過來的數(shù)據(jù),每次只能讀去1000個(gè)點(diǎn),但是示波器數(shù)據(jù)的存儲(chǔ)深度遠(yuǎn)遠(yuǎn)大于1000,請問怎樣可以改變LabVIEW讀取示波器數(shù)據(jù)的存儲(chǔ)深度?

2012-07-14 08:58:32

舉個(gè)例子,信號(hào)源的頻率為20KHz,采樣頻率為200KHz,采樣數(shù)為2000,那么每次采樣數(shù)寫入文件后,緩存區(qū)中剩余的數(shù)據(jù)怎么處理?

2016-03-19 11:12:40

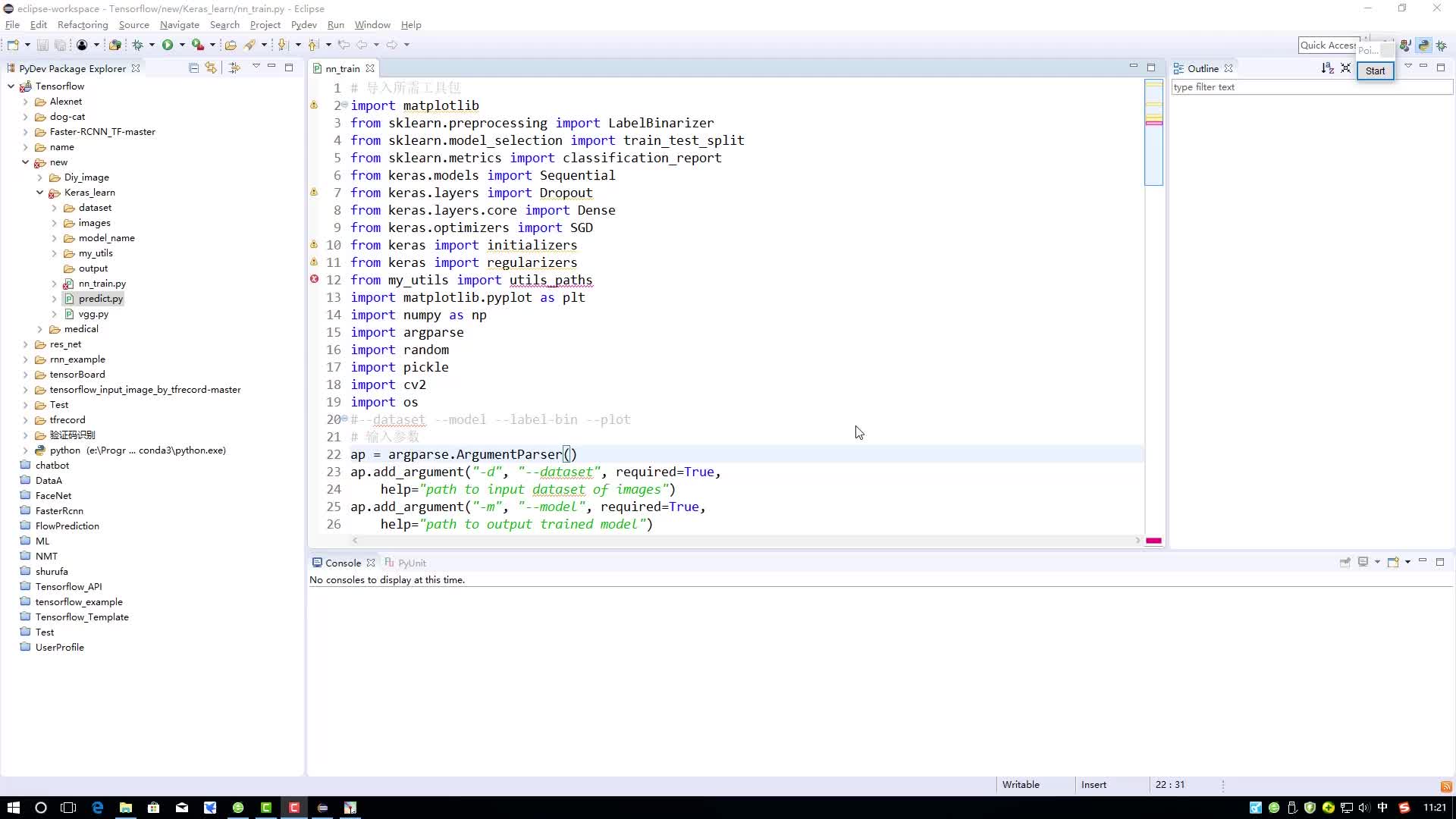

://www.sohu.com/a/204207587_99960938而我現(xiàn)在要考慮的是跨平臺(tái)、跨系統(tǒng)性能強(qiáng),并支持Nanopi2的深度學(xué)習(xí)算法庫。近兩年TensorFlow開源后,對于初學(xué)深度學(xué)習(xí)

2018-06-04 22:32:12

《實(shí)戰(zhàn)Google深度學(xué)習(xí)框架》之RNN學(xué)習(xí)筆記2 LSTM對PTB數(shù)據(jù)集的建模

2019-09-26 16:21:19

用STM32向串口發(fā)送大量數(shù)據(jù),我的想法是定義一個(gè)大的緩存區(qū),等緩存區(qū)滿了后一次性將緩存區(qū)的數(shù)據(jù)發(fā)送出去。 數(shù)據(jù)量太大,我想每次發(fā)送的大小大概60K 字節(jié)。選用的型號(hào)是STM32VE,512K

2020-06-09 10:49:06

的網(wǎng)絡(luò)結(jié)構(gòu)。當(dāng)然,深度學(xué)習(xí)的方法用來檢測,也有自己的很多缺點(diǎn)。例如:數(shù)據(jù)量要求大,工業(yè)數(shù)據(jù)收集成本高。但是隨著數(shù)據(jù)增強(qiáng)技術(shù),無監(jiān)督學(xué)習(xí)的不斷進(jìn)步,在某些應(yīng)用場景上,這些缺點(diǎn)漸漸被隱藏了。例如學(xué)術(shù)界正在研究

2021-05-10 22:33:46

labview數(shù)據(jù)采集中,緩存在什么時(shí)候使用

2018-05-12 10:21:38

各位好!請教一個(gè)問題,現(xiàn)在我用labview寫一個(gè)串口通信的程序,通信設(shè)備是一個(gè)位移傳感器,計(jì)算機(jī)通過串口發(fā)送指令到傳感器,就能返回數(shù)據(jù),目前的情況是,我想要接收傳感器的緩存數(shù)據(jù),高亮執(zhí)行時(shí)數(shù)據(jù)接收

2014-04-27 16:56:19

算法。其編程特點(diǎn)是上手快,開發(fā)效率高,兼容性強(qiáng),能快速調(diào)用c++,c#等平臺(tái)的dll類庫。如何將labview與深度學(xué)習(xí)結(jié)合起來,來解決視覺行業(yè)越來越復(fù)雜的應(yīng)用場景所遇到的困難。下面以開關(guān)面板為例講解

2020-07-23 20:33:10

測試產(chǎn)品的時(shí)候先讀取儀器上面的數(shù)據(jù)出來以后緩存到一個(gè)地方,然后等后面的程序來判斷這個(gè)產(chǎn)品是否合格,如果合格就把之測試的數(shù)據(jù)存到EXCEL里面。怎么讓數(shù)據(jù)先緩存起來?有沒有直接的緩存模塊?

2017-09-04 14:54:26

深度學(xué)習(xí)訓(xùn)練的第一個(gè)困難是技術(shù)難度高。企業(yè)要進(jìn)行深度學(xué)習(xí)的模型訓(xùn)練,有很高的技術(shù)門檻。比如要自己搭建深度學(xué)習(xí)平臺(tái),要有懂得編程的技術(shù)人員,還要有海量的訓(xùn)練數(shù)據(jù)等等。而華為云深度學(xué)習(xí)服務(wù),可以提供深度

2018-08-02 20:44:09

計(jì)算的研究者,二是希望為現(xiàn)實(shí)世界中的新應(yīng)用來部署這些模型的應(yīng)用科學(xué)家。然而,他們都面臨著一個(gè)限制條件,即硬件加速能力仍需加強(qiáng),才可能滿足擴(kuò)大現(xiàn)有數(shù)據(jù)和算法規(guī)模的需求。對于深度學(xué)習(xí)來說,目前硬件加速

2018-08-13 09:33:30

組合成一個(gè)方程式時(shí),就可以解決具體的問題。最后,你是否聽過這句話,“進(jìn)入的是垃圾,出去的也是垃圾”? 當(dāng)您準(zhǔn)備訓(xùn)練數(shù)據(jù)集時(shí),這尤其重要。 您的數(shù)據(jù)質(zhì)量越好,您的模型越好。深度學(xué)習(xí)和自然語言處理我們前面

2017-09-25 10:03:05

人工智能、數(shù)據(jù)挖掘、機(jī)器學(xué)習(xí)和深度學(xué)習(xí)之間,主要有什么關(guān)系?

2020-03-16 11:35:54

深度學(xué)習(xí)是什么意思

2020-11-11 06:58:03

準(zhǔn)確的模型。有了上述機(jī)制,現(xiàn)在可以通過讓神經(jīng)網(wǎng)絡(luò)模型學(xué)習(xí)各種問題來自動(dòng)解決問題,創(chuàng)建高精度模型,并對新數(shù)據(jù)進(jìn)行推理。然而,由于單個(gè)神經(jīng)網(wǎng)絡(luò)只能解決簡單的問題,人們嘗試通過構(gòu)建深度神經(jīng)網(wǎng)絡(luò) (DNN

2023-02-17 16:56:59

,labview訓(xùn)練和調(diào)用的編程方法,還講解了大量的案例,手把手幫助學(xué)員學(xué)會(huì)如何在labview中應(yīng)用深度學(xué)習(xí)6、課程贈(zèng)送相關(guān)工業(yè)圖像數(shù)據(jù)集,其價(jià)值遠(yuǎn)遠(yuǎn)大于課程本身。2、用戶購買后,將會(huì)獲得哪些收益?1

2020-08-10 10:38:12

應(yīng)用程序,能夠處理包括跨大型數(shù)據(jù)集的交互式查詢,來自傳感器或金融系統(tǒng)的流數(shù)據(jù)以及機(jī)器學(xué)習(xí)任務(wù),且Spark將數(shù)據(jù)集緩存在內(nèi)存中的能力大大加快了迭代數(shù)據(jù)處理速度,使得Spark成為實(shí)現(xiàn)迭代

2018-04-10 16:05:02

用TensorFlow導(dǎo)入MNIST數(shù)據(jù)集

2020-11-11 07:33:24

小白 機(jī)器學(xué)習(xí)和深度學(xué)習(xí)必讀書籍+機(jī)器學(xué)習(xí)實(shí)戰(zhàn)視頻PPT+大數(shù)據(jù)分析書籍推薦!

2019-07-22 17:02:39

支持labview的便攜手持終端有哪些?想弄個(gè)計(jì)算系統(tǒng)(只計(jì)算用,不采集數(shù)據(jù))想用labview開發(fā),但不知道哪些終端好用,用過的朋友給些建議!野外勘探輸出大約9個(gè)數(shù)據(jù),計(jì)算出3個(gè)數(shù)據(jù),如果有其他易開發(fā)的其他平臺(tái)終端也行。

2013-08-22 15:27:10

想使用labview弄一個(gè)數(shù)據(jù)庫和串口通信,把怎么樣把它們連接到一起.就是可以用串口緩存的數(shù)據(jù)放入數(shù)據(jù)庫!本人菜鳥,求大神!

2015-04-30 12:30:22

使得實(shí)現(xiàn)復(fù)雜的 DNN 結(jié)構(gòu)成為可能,而不需要深入復(fù)雜的數(shù)學(xué)細(xì)節(jié),大數(shù)據(jù)集的可用性為 DNN 提供了必要的數(shù)據(jù)來源。TensorFlow 成為最受歡迎的深度學(xué)習(xí)庫,原因如下:TensorFlow 是一個(gè)

2020-07-28 14:34:04

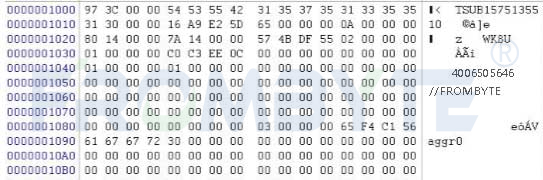

`深度學(xué)習(xí)領(lǐng)域的“Hello World!”,入門必備!MNIST是一個(gè)手寫數(shù)字數(shù)據(jù)庫,它有60000個(gè)訓(xùn)練樣本集和10000個(gè)測試樣本集,每個(gè)樣本圖像的寬高為28*28。此數(shù)據(jù)集是以二進(jìn)制存儲(chǔ)

2018-08-29 10:36:45

本帖最后由 _aqing 于 2012-4-10 20:04 編輯

急用:問題 正常情況下緩存數(shù)據(jù)格式為:0103 0205 8CBA B1當(dāng)05的位置變成0A的時(shí)候,數(shù)據(jù)變成了 0103

2012-04-10 19:47:46

,我們在創(chuàng)建新磁盤以及映射物理分區(qū)時(shí),都會(huì)看到設(shè)置緩存大小的地方,這里就是深度無盤程序里面自帶的IO讀緩存,這里說下讀緩存的作用:服務(wù)端讀緩存提升了服務(wù)器數(shù)據(jù)吞讀能力,有效提高了客戶機(jī)數(shù)據(jù)讀取速度,使

2011-07-15 13:24:41

在這些存儲(chǔ)技術(shù)中使用最廣的就是高速緩存(Cache)和磁盤冗余陣列(RAID)了,本文就將探討緩存和磁盤陣列提高存儲(chǔ)IO性能的方法。

2011-03-28 11:56:49 2962

2962 鄧力博士介紹,他的主題報(bào)告將會(huì)講述深度監(jiān)督學(xué)習(xí)、深度非監(jiān)督學(xué)習(xí)和深度強(qiáng)化學(xué)習(xí)之間的關(guān)系和區(qū)別,以及這三類深度學(xué)習(xí)模式跟大數(shù)據(jù)的關(guān)系,并通過實(shí)踐案例來說明三類學(xué)習(xí)算法的適用環(huán)境及效果。他認(rèn)為,目前

2016-07-28 18:10:44 1003

1003 為幫助數(shù)據(jù)科學(xué)家和開發(fā)人員充分利用深度學(xué)習(xí)領(lǐng)域中的機(jī)遇,NVIDIA為其深度學(xué)習(xí)軟件平臺(tái)發(fā)布了三項(xiàng)重大更新,它們分別是NVIDIA DIGITS 4、CUDA深度神經(jīng)網(wǎng)絡(luò)庫(cuDNN)5.1和全新的GPU推理引擎(GIE)。

NVIDIA深度學(xué)習(xí)軟件平臺(tái)推三項(xiàng)重大更新

2016-08-06 15:00:26 1806

1806 NetApp_FAS62000_系列數(shù)據(jù)手冊

2016-12-28 14:54:09 0

0 NetApp_FlexPod_Datacenter_平臺(tái)的總體經(jīng)濟(jì)影響

2016-12-28 14:54:09 0

0 NetApp為中央財(cái)經(jīng)大學(xué)打造高效、便捷的兩地三中心數(shù)據(jù)服務(wù)平臺(tái)

2016-12-28 11:17:18 0

0 利用_NetApp_存儲(chǔ)改善數(shù)據(jù)庫環(huán)境

2016-12-28 11:13:11 0

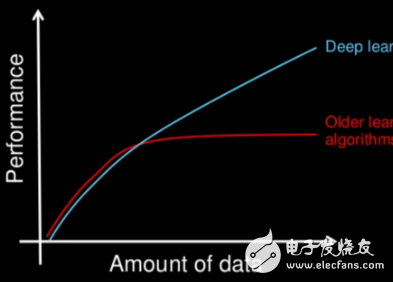

0 機(jī)器學(xué)習(xí)和深度學(xué)習(xí)變得越來越火。突然之間,不管是了解的還是不了解的,所有人都在談?wù)摍C(jī)器學(xué)習(xí)和深度學(xué)習(xí)。無論你是否主動(dòng)關(guān)注過數(shù)據(jù)科學(xué),你應(yīng)該已經(jīng)聽說過這兩個(gè)名詞了。如果你想讓自己弄清楚機(jī)器學(xué)習(xí)和深度學(xué)習(xí)的區(qū)別,請閱讀本篇文章,我將用通俗易懂的語言為你介紹他們之間的差別。

2017-11-16 01:38:06 2821

2821

現(xiàn)在都在談?wù)撊斯ぶ悄芑蛘叽?b class="flag-6" style="color: red">數(shù)據(jù)相關(guān)的知識(shí),但是與之相關(guān)的機(jī)器學(xué)習(xí)、深度學(xué)習(xí)等你能分清嗎?數(shù)據(jù)科學(xué)比機(jī)器學(xué)習(xí)范圍大得多,數(shù)據(jù)科學(xué)實(shí)際上涵蓋了整個(gè)數(shù)據(jù)處理的范圍,而不只是算法或者統(tǒng)計(jì)學(xué)方面。

2017-12-18 16:28:50 779

779

今天我們將討論深度學(xué)習(xí)中最核心的問題之一:訓(xùn)練數(shù)據(jù)。深度學(xué)習(xí)已經(jīng)在現(xiàn)實(shí)世界得到了廣泛運(yùn)用,例如:無人駕駛汽車,收據(jù)識(shí)別,道路缺陷自動(dòng)檢測,以及交互式電影推薦等等。

2017-12-25 10:34:28 10255

10255 從Python菜鳥到Python Kaggler的旅程(譯注:kaggle是一個(gè)數(shù)據(jù)建模和數(shù)據(jù)分析競賽平臺(tái))

假如你想成為一個(gè)數(shù)據(jù)科學(xué)家,或者已經(jīng)是數(shù)據(jù)科學(xué)家的你想擴(kuò)展你的技能,那么你已經(jīng)來對地

2018-01-25 17:03:15 0

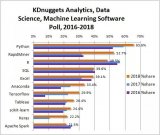

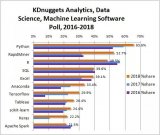

0 近日,kdnuggets做了一個(gè)關(guān)于數(shù)據(jù)科學(xué)、機(jī)器學(xué)習(xí)語言使用情況的問卷調(diào)查,他們分析了954個(gè)回答,得出結(jié)論——Python已經(jīng)打敗R語言,成為分析、數(shù)據(jù)科學(xué)和機(jī)器學(xué)習(xí)平臺(tái)中使用頻率最高的語言。

2018-06-28 08:33:00 1590

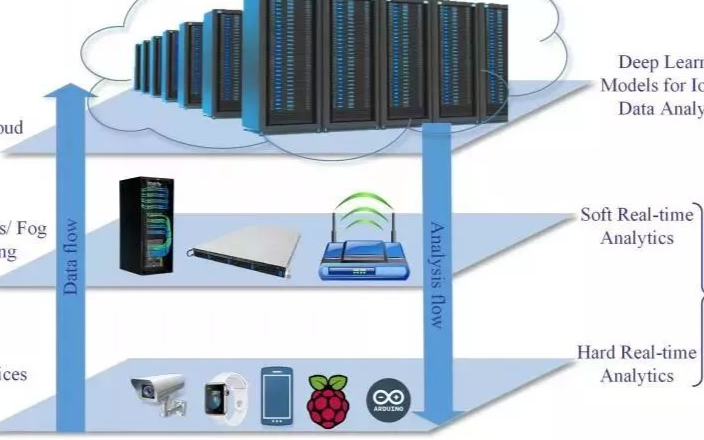

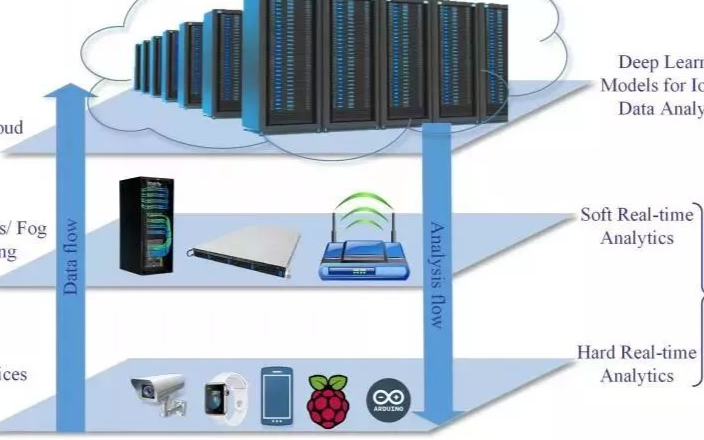

1590 這篇論文對于使用深度學(xué)習(xí)來改進(jìn)IoT領(lǐng)域的數(shù)據(jù)分析和學(xué)習(xí)方法進(jìn)行了詳細(xì)的綜述。

2018-03-01 11:05:12 7452

7452

據(jù)報(bào)導(dǎo),醫(yī)療產(chǎn)業(yè)必須分析世界各地的科學(xué)報(bào)告,同時(shí)管控病患的資料來決定最適合的治療方案。既然要處理的資料如此多,就必須透過深度學(xué)習(xí)進(jìn)行大數(shù)據(jù)分析。

2018-05-03 11:15:00 1543

1543 渲染涉及大量的緩存,這里緩存只是一個(gè)簡單的存有像素數(shù)據(jù)的矩形內(nèi)存塊,最重要緩存是幀緩存和深度緩存。

2018-05-14 11:44:45 5584

5584

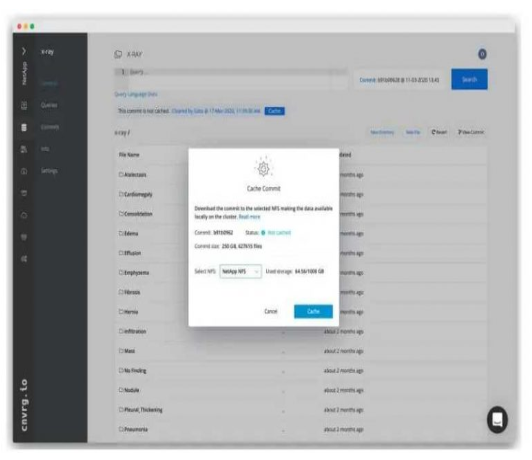

比較深入學(xué)習(xí)算法的IO模式,可以發(fā)現(xiàn)它與傳統(tǒng)工程師、HPC和企業(yè)應(yīng)用程序的做法幾乎完全相反。深度學(xué)習(xí)非常重讀IO導(dǎo)向,數(shù)據(jù)在設(shè)計(jì)和訓(xùn)練模型時(shí)被重復(fù)使用。即使在模型被訓(xùn)練之后,仍然需要用新數(shù)據(jù)來增加現(xiàn)有的訓(xùn)練數(shù)據(jù)集,特別是模型輸出中的誤差。這是為了隨著時(shí)間的推移對模型進(jìn)行的改進(jìn)。

2018-05-23 11:19:40 4184

4184 近日,數(shù)據(jù)科學(xué)網(wǎng)站KDnuggets發(fā)布 2018年數(shù)據(jù)科學(xué)和機(jī)器學(xué)習(xí)工具調(diào)查結(jié)果。

2018-06-07 17:05:45 4004

4004

Airbnb資深機(jī)器學(xué)習(xí)科學(xué)家Shijing Yao、前Airbnb數(shù)據(jù)科學(xué)負(fù)責(zé)人Qiang Zhu、Airbnb機(jī)器學(xué)習(xí)工程師Phillippe Siclait分享了在Airbnb產(chǎn)品上大規(guī)模應(yīng)用深度學(xué)習(xí)技術(shù)的經(jīng)驗(yàn)。

2018-07-07 09:24:03 3610

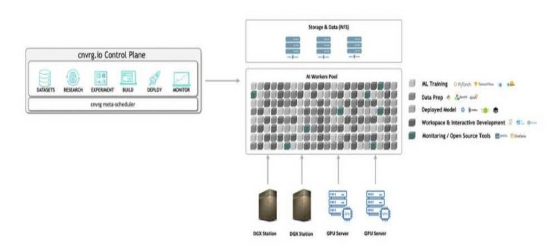

3610 NetApp宣布推出NetApp? ONTAP?AI架構(gòu),該架構(gòu)基于NVIDIA DGX?超級(jí)計(jì)算機(jī)和NetApp AFF A800云互聯(lián)全閃存存儲(chǔ),可簡化、加速并擴(kuò)展邊緣、核心及云端的數(shù)據(jù)管道以助力深度學(xué)習(xí)部署,并助力客戶通過AI在業(yè)務(wù)方面真正收獲成效。

2018-08-03 16:33:15 4146

4146 深度學(xué)習(xí),有太多令人驚嘆的能力!從12年的圖像識(shí)別開始,深度學(xué)習(xí)的一個(gè)個(gè)突破,讓人們一次又一次的刷新對它的認(rèn)知。然而,應(yīng)用深度學(xué)習(xí),一直有一個(gè)巨大的前提:大量標(biāo)注數(shù)據(jù)。但是難道數(shù)據(jù)少,就享受不到深度

2018-08-12 11:49:53 19112

19112 在研究基于大數(shù)據(jù)框架將深度學(xué)習(xí)的分布式實(shí)現(xiàn)后,王萬良指出,人工智能是大數(shù)據(jù)分析領(lǐng)域的研究主流,基于深度學(xué)習(xí)的大數(shù)據(jù)分析方法發(fā)展最為迅速,GPU成為深度學(xué)習(xí)的更高效的硬件平臺(tái),研究分布式計(jì)算智能優(yōu)化算法將解決大數(shù)據(jù)優(yōu)化問題,能夠提升算法的效果并降低計(jì)算復(fù)雜度。

2018-09-26 16:56:13 8878

8878 本文通過使用部署在多接入邊緣計(jì)算(MEC)結(jié)構(gòu)上的深度學(xué)習(xí)方法,為自動(dòng)駕駛汽車提出了基于深度學(xué)習(xí)的緩存。通過仿真測試,結(jié)果發(fā)現(xiàn)該方法可以最大限度地減少延遲。

2018-10-10 09:26:32 4217

4217 2018年10月,IBM宣布計(jì)劃將全新RAPIDS? 開源軟件納入到其企業(yè)級(jí)數(shù)據(jù)科學(xué)平臺(tái)中,涵蓋本地預(yù)置、混合云和多云環(huán)境。憑借其龐大的深度學(xué)習(xí)與機(jī)器學(xué)習(xí)解決方案組合,IBM能為偏好不同部署模型的數(shù)據(jù)科學(xué)家提供這一開源技術(shù)。

2018-10-20 09:43:08 2805

2805 最近有很多關(guān)于數(shù)據(jù)是否是新模型驅(qū)動(dòng) [1] [2] 的討論,無論結(jié)論如何,都無法改變我們在實(shí)際工作中獲取數(shù)據(jù)成本很高這一事實(shí)(人工費(fèi)用、許可證費(fèi)用、設(shè)備運(yùn)行時(shí)間等方面)。 因此,在機(jī)器學(xué)習(xí)項(xiàng)目

2019-06-13 16:37:10 2996

2996 MathWorks與世界領(lǐng)先的在線學(xué)習(xí)平臺(tái) Coursera今日宣布,雙方將攜手為彌補(bǔ)數(shù)據(jù)科學(xué)技能差距而共同努力。

2019-11-01 15:57:52 2804

2804 晶心科技今日宣布將攜手合作,在基于AndeStar? V5架構(gòu)的晶心RISC-V CPU核心上配置高度優(yōu)化的深度學(xué)習(xí)模型,使AI深度學(xué)習(xí)模型變得更輕巧、快速和節(jié)能。

2019-12-31 16:30:11 1002

1002 CORE通過端到端AI模型跟蹤和監(jiān)視來促進(jìn)機(jī)器學(xué)習(xí)工作流管理。其內(nèi)置的群集編排支持混合云和多云配置,其計(jì)算查詢和自動(dòng)擴(kuò)展(可從儀表板進(jìn)行微調(diào))可確保充分利用所有可用資源。

2020-04-09 14:32:37 1930

1930 作為云數(shù)據(jù)服務(wù)領(lǐng)域的領(lǐng)導(dǎo)者,NetApp宣布推出 Project Astra,其愿景是攜手 Kubernetes 社區(qū),開發(fā)軟件定義的平臺(tái)。

2020-04-30 11:53:14 2802

2802 百度飛槳是自主研發(fā)、開源開放、功能最完備的產(chǎn)業(yè)級(jí)深度學(xué)習(xí)平臺(tái),集深度學(xué)習(xí)核心框架、基礎(chǔ)模型庫、端到端開發(fā)套件、工具組件和服務(wù)平臺(tái)于一體,包含完整的開發(fā)、訓(xùn)練、推理的端到端深度學(xué)習(xí)AI模型開發(fā)工具鏈。

2020-05-29 14:59:40 2667

2667 作為一門逐漸成熟的新興領(lǐng)域,與數(shù)據(jù)科學(xué)相關(guān)的很多領(lǐng)域開始變得備受青睞,比如數(shù)據(jù)工程,數(shù)據(jù)分析以及機(jī)器學(xué)習(xí)和深度學(xué)習(xí)。數(shù)據(jù)科學(xué)家們必須帶著具有科學(xué)性、創(chuàng)造性和研究性的思維,從各路數(shù)據(jù)集中提取有用信息,以解決客戶面臨的潛在挑戰(zhàn)。

2020-06-30 11:28:52 2028

2028 cnvrg.io用于機(jī)器學(xué)習(xí)的AI OS宣布將NVIDIA多實(shí)例GPU(MIG)技術(shù)與其數(shù)據(jù)科學(xué)平臺(tái)進(jìn)行了原生集成。cnvrg.io是第一個(gè)集成MIG的ML平臺(tái),這是一項(xiàng)突破性的新功能

2020-09-16 16:53:39 2371

2371 據(jù)國外媒體報(bào)道,英特爾繼續(xù)通過收購優(yōu)質(zhì)的初創(chuàng)公司,深耕機(jī)器學(xué)習(xí)和人工智能領(lǐng)域。該公司近日收購了一家以色列公司 Cnvrg.io——建立和運(yùn)營一個(gè)供數(shù)據(jù)科學(xué)家構(gòu)建和運(yùn)行機(jī)器學(xué)習(xí)模型的平臺(tái),平臺(tái)可以追蹤和培訓(xùn)多個(gè)模型并對其進(jìn)行比較,創(chuàng)建推薦等等。

2020-11-04 16:26:42 1751

1751 深度學(xué)習(xí)在軌跡數(shù)據(jù)挖掘中的應(yīng)用研究綜述 來源:《?計(jì)算機(jī)科學(xué)與應(yīng)用》?,作者 李旭娟 等 摘要:? 在過去十年,深度學(xué)習(xí)已被證明在很多領(lǐng)域應(yīng)用非常成功,如視覺圖像、自然語言處理、語音識(shí)別等,同時(shí)

2022-03-08 17:24:10 1271

1271

Kubeflow是一個(gè)基于K8S的機(jī)器學(xué)習(xí)平臺(tái),為開發(fā)者提供了從實(shí)驗(yàn)(Notebook)、訓(xùn)練(MLOps流水線)、調(diào)優(yōu)以及部署、監(jiān)控的端到端能力,也是當(dāng)前排名第一的開源MlOps工具。

2022-10-26 10:20:44 575

575 人工智能的概念在1956年就被提出,如今終于走入現(xiàn)實(shí),離不開一種名為“深度學(xué)習(xí)”的技術(shù)。深度學(xué)習(xí)的運(yùn)作模式,如同一場傳話游戲。給神經(jīng)網(wǎng)絡(luò)輸入數(shù)據(jù),對數(shù)據(jù)的特征進(jìn)行描述,在神經(jīng)網(wǎng)絡(luò)中層層傳遞,最終

2023-01-14 23:34:43 588

588

在云服務(wù)中,緩存是極其重要的一點(diǎn)。所謂緩存,其實(shí)是一個(gè)高速數(shù)據(jù)存儲(chǔ)層。當(dāng)緩存存在后,日后再次請求該數(shù)據(jù)就會(huì)直接訪問緩存,提升數(shù)據(jù)訪問的速度。

2023-01-30 17:41:59 472

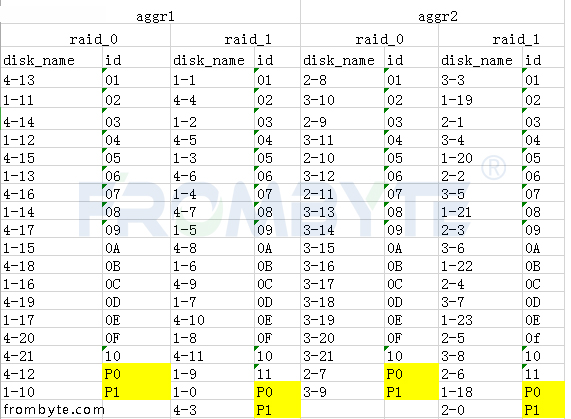

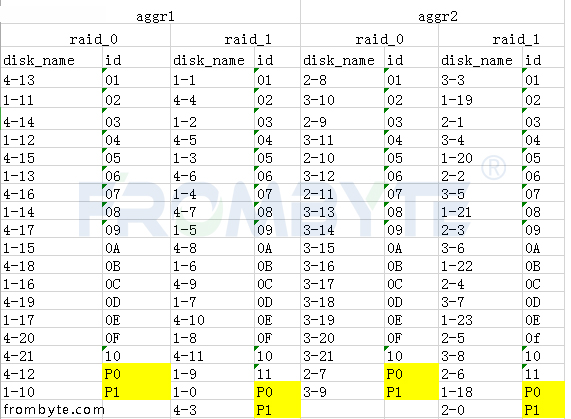

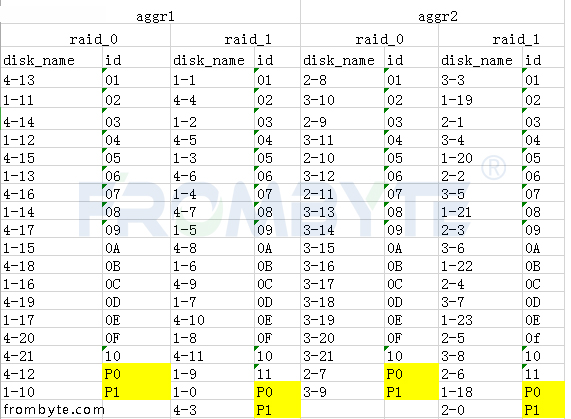

472 服務(wù)器數(shù)據(jù)恢復(fù)環(huán)境:

某公司的一臺(tái)NetApp某型號(hào)存儲(chǔ);

幾十塊磁盤組建兩組存儲(chǔ)池,兩組存儲(chǔ)池互為鏡像;

存儲(chǔ)池劃分卷并映射到ESXI作為數(shù)據(jù)存儲(chǔ)使用,卷內(nèi)有數(shù)百臺(tái)虛擬機(jī)。

服務(wù)器故障

2023-03-23 11:38:58 373

373

機(jī)器學(xué)習(xí)應(yīng)用從開發(fā)到上線全流程(MLOps) OpenMLDB 是一個(gè)開源機(jī)器學(xué)習(xí)數(shù)據(jù)庫,提供線上線下一致的特征平臺(tái)

2023-03-31 15:43:35 0

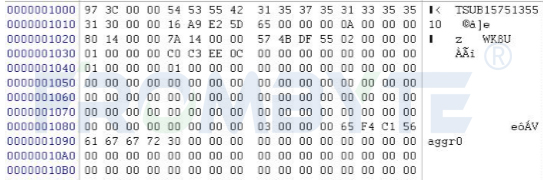

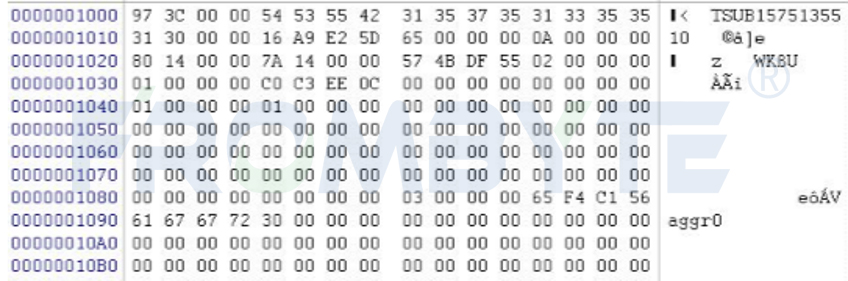

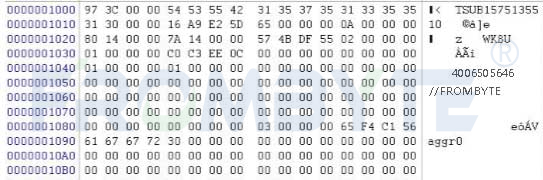

0 存儲(chǔ)數(shù)據(jù)恢復(fù)環(huán)境:

NetApp存儲(chǔ)設(shè)備,WAFL文件系統(tǒng),底層是由多塊硬盤組建的raid磁盤陣列。

存儲(chǔ)故障:

工作人員誤操作導(dǎo)致NetApp存儲(chǔ)內(nèi)部分重要數(shù)據(jù)被刪除。

2023-05-08 13:58:38 337

337 智造之眼?科學(xué)設(shè)計(jì)深度學(xué)習(xí)各應(yīng)用流程,在盡量簡化前期準(zhǔn)備工作的基礎(chǔ)上為客戶提供穩(wěn)定且準(zhǔn)確的深度學(xué)習(xí)解決方案。

2023-05-04 16:55:52 424

424

什么是深度學(xué)習(xí)算法?深度學(xué)習(xí)算法的應(yīng)用 深度學(xué)習(xí)算法被認(rèn)為是人工智能的核心,它是一種模仿人類大腦神經(jīng)元的計(jì)算模型。深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一種變體,主要通過變換各種架構(gòu)來對大量數(shù)據(jù)進(jìn)行學(xué)習(xí)以及分類處理

2023-08-17 16:03:04 1300

1300 了基于神經(jīng)網(wǎng)絡(luò)的機(jī)器學(xué)習(xí)方法。 深度學(xué)習(xí)算法可以分為兩大類:監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)。監(jiān)督學(xué)習(xí)的基本任務(wù)是訓(xùn)練模型去學(xué)習(xí)輸入數(shù)據(jù)的特征和其對應(yīng)的標(biāo)簽,然后用于新數(shù)據(jù)的預(yù)測。而無監(jiān)督學(xué)習(xí)通常用于聚類、降維和生成模型等任務(wù)中

2023-08-17 16:11:26 637

637 混合和多云部署模型是企業(yè)IT組織的新常態(tài)。隨著這些復(fù)雜的環(huán)境,圍繞數(shù)據(jù)管理的新挑戰(zhàn)出現(xiàn)了。NetApp的數(shù)據(jù)管理愿景是一種無縫連接不同的數(shù)據(jù)結(jié)構(gòu)云,無論它們是私有環(huán)境、公共環(huán)境還是混合環(huán)境。數(shù)據(jù)

2023-08-25 17:15:02 0

0 電子發(fā)燒友網(wǎng)站提供《可用性和業(yè)務(wù)連續(xù)性與NetApp的數(shù)據(jù)結(jié)構(gòu)和NetApp-Brocade 7840擴(kuò)展的解決方案.pdf》資料免費(fèi)下載

2023-08-30 09:37:47 0

0 Netapp存儲(chǔ)數(shù)據(jù)恢復(fù)環(huán)境:

北京某公司一臺(tái)netAPP存儲(chǔ),72塊SAS硬盤劃分了若干個(gè)lun。

Netapp存儲(chǔ)故障:

工作人員誤操作刪除了12個(gè)lun。

2023-10-13 16:13:55 258

258

某單位一臺(tái)Netapp存儲(chǔ),該Netapp存儲(chǔ)內(nèi)共有數(shù)十塊SAS硬盤。

工作人員誤操作刪除了Netapp存儲(chǔ)中12個(gè)lun,刪除的數(shù)據(jù)包括客戶信息和其他重要數(shù)據(jù)。

2024-01-04 15:26:55 163

163

NetApp數(shù)據(jù)恢復(fù)環(huán)境:

NetApp某型號(hào)存儲(chǔ),存儲(chǔ)中有數(shù)十塊SAS硬盤,該型號(hào)NetApp存儲(chǔ)硬盤是扇區(qū)大小是520字節(jié)。存儲(chǔ)中的lun都映射給小型機(jī)使用,存放Oracle數(shù)據(jù)庫文件,采用

2024-01-11 11:40:52 221

221

隨著科技的飛速發(fā)展,物聯(lián)網(wǎng)平臺(tái)已經(jīng)成為了我們生活中不可或缺的一部分。IO數(shù)據(jù)采集物聯(lián)網(wǎng)平臺(tái)作為一種高效的數(shù)據(jù)采集和分析工具,在越來越多行業(yè)場景得到應(yīng)用。對此,數(shù)之能提供具備IO數(shù)據(jù)采集的軟硬件一體化

2024-01-25 17:09:56 183

183 NetApp存儲(chǔ)數(shù)據(jù)恢復(fù)環(huán)境:

北京某公司的一臺(tái)NetApp某型號(hào)存儲(chǔ),通過96塊磁盤組建了兩組存儲(chǔ)池,這2組存儲(chǔ)池互為鏡像。存儲(chǔ)池內(nèi)劃分卷并映射到ESXI作為數(shù)據(jù)存儲(chǔ)使用,卷內(nèi)有幾百臺(tái)虛擬機(jī)

2024-03-07 15:42:59 96

96

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論