人臉識(shí)別作為一種生物特征識(shí)別技術(shù)具有遼闊 的應(yīng)用E,尤其集中體現(xiàn)在身份認(rèn)證、安防監(jiān)控和 人機(jī)交互等方面。

常見的人臉識(shí)別算法包括基于特征臉(PCA) 的方法⑵、基于線性分析(LDA)的方法同、基于 局部二值模式(LBP )的方法囹、基于神經(jīng)網(wǎng)絡(luò)(NN )[5] 的方法等等。其中卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN )模型中,其超參數(shù)通過傳統(tǒng) 的梯度下降法和自帶的網(wǎng)絡(luò)模型進(jìn)行學(xué)習(xí)。

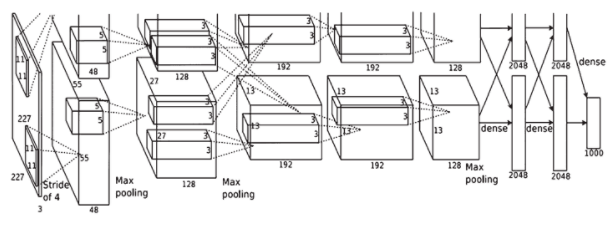

AlexNet[6] 網(wǎng)絡(luò)主要突出在圖像的分類上;R-CNN ( Regions with CNN)卩]成功獲得對(duì)目標(biāo)檢測區(qū)域的特征提 取。圖像的端到端語義分割在全卷積網(wǎng)絡(luò)(Fully Convolutional Network, FCN )兇上得到了廣泛的應(yīng) 用,提高了傳統(tǒng)的語義分割算法的準(zhǔn)確性。AlexNet 網(wǎng)絡(luò)有8層,其中,conv層有5個(gè),F(xiàn)C層有3個(gè), FC8層也稱為分類層,參數(shù)量大于60 Mo分類層的 輸出具備1 000個(gè)輸出的歸一化指數(shù)函數(shù)回歸模型。

本文設(shè)計(jì)了一種7層卷積神經(jīng)網(wǎng)絡(luò)模型結(jié)構(gòu), 應(yīng)用于ORL人臉數(shù)據(jù)庫的人臉識(shí)別。7層卷積神經(jīng) 網(wǎng)絡(luò)采用整流線性單元激活函數(shù)(以下稱為ReLU ) 和固定學(xué)習(xí)速率。

卷積神經(jīng)網(wǎng)絡(luò)的設(shè)計(jì)

1.1 AlexNet在人臉識(shí)別領(lǐng)域的應(yīng)用

Alexnet網(wǎng)絡(luò)利用ReLU激活功能作用于每個(gè)卷 積層和完全連接層,并且局部響應(yīng)歸一化層連接在 第一個(gè)卷積層和第二個(gè)卷積層之后。卷積1層,卷 積2層和卷積5層的輸出上均與最大池化層相連接。AlexNet (后文稱為原網(wǎng)絡(luò))的基本架構(gòu)如圖1所示。

圖1 AlexNet結(jié)構(gòu)圖

本設(shè)計(jì)使用ORL人臉數(shù)據(jù)庫的新卷積神經(jīng)網(wǎng) 絡(luò)結(jié)構(gòu)模型進(jìn)行訓(xùn)練;對(duì)于訓(xùn)練過程中發(fā)生的過擬 合問題,Hinton提出了 “Dropout”方法,即在網(wǎng)絡(luò) 學(xué)習(xí)的時(shí)候以固定的(概率),通常 設(shè)置為0.5,再把輸入層或者隱藏層的神經(jīng)元輸出 設(shè)置為0,這個(gè)神經(jīng)元沒法連續(xù)正向傳播和誤差反 向傳播,但在測試時(shí),p乘以輸入層或者隱層的神 經(jīng)元輸出作為該層的輸出。由于網(wǎng)絡(luò)中每個(gè)輸入圖 像神經(jīng)元被隨機(jī)設(shè)置為0,因此需要要求圖像中最 基本的特征是由隱藏層神經(jīng)元提取,采用“Dropout” 解決過擬合問題。

1.2 AlexNet 的改進(jìn)

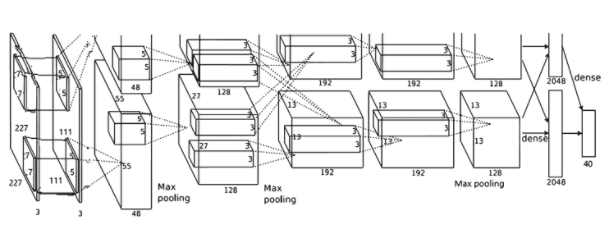

本文網(wǎng)絡(luò)的模型結(jié)構(gòu)如圖2所示。

圖2本文網(wǎng)絡(luò)的結(jié)構(gòu)圖

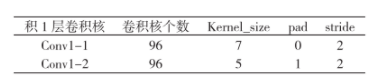

(1)用7x7和5x5的兩個(gè)小卷積核替 代原來的11x11的大卷積核,為了保證原結(jié)構(gòu) maxpooll (第一最大池化層)的輸出不發(fā)生變化, Convl-1 (第一卷積層的第一卷積核)、Convl-2 (第 一卷積層的第二卷積核)個(gè)數(shù)保持不變,并對(duì)其進(jìn) 行補(bǔ)充操作。后面的模型結(jié)構(gòu)圖和原網(wǎng)絡(luò)相同,原 來的FC8層變?yōu)镕C7層,具體參數(shù)如表1所示。

表1 Conv1-1和Conv1-2具體參數(shù)

(2 )在激活函數(shù)與池化層之間刪除LRN層。

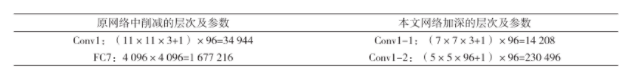

(3)本文網(wǎng)絡(luò)模型減少了 1層(FC7層), 第一層變?yōu)閮蓚€(gè)小卷積模塊形式。其中改進(jìn)層具體 參數(shù)變化如表2所示。

表2原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)參數(shù)對(duì)比

1.3 人臉圖像的預(yù)處理

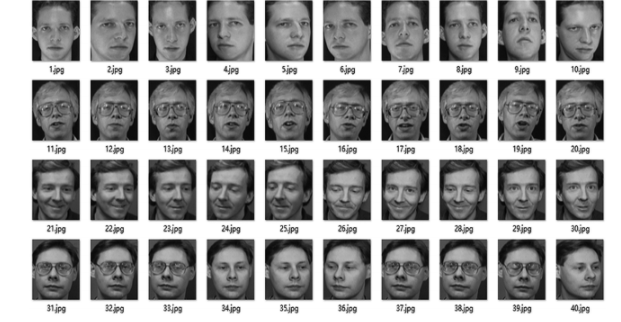

人臉原圖片的尺寸是112 x 92,標(biāo)準(zhǔn)化變?yōu)?56x256的人臉,就可以隨機(jī)在標(biāo)準(zhǔn)化后的圖片上裁剪一個(gè)227x227的圖像來訓(xùn)練,并橫向的進(jìn)行翻轉(zhuǎn)、平移等-系列的操作來拓展數(shù)據(jù)集大小。0RL人臉數(shù)據(jù)庫的樣例如圖3所示。

圖3 ORL人臉數(shù)據(jù)庫樣例

對(duì)ORL數(shù)據(jù)庫做以下處理:

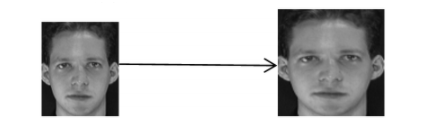

(1)將數(shù)據(jù)庫中的訓(xùn)練集、驗(yàn)證集、測試 集的比例設(shè)置為3:1:1,然后再把ORL中圖片 標(biāo)準(zhǔn)化大小,如圖4所示,經(jīng)cvResize函數(shù)將原圖 112x92 標(biāo)準(zhǔn)化 256x256。

圖4 人臉標(biāo)準(zhǔn)化過程

(2)將訓(xùn)練集、驗(yàn)證集、測試集的40個(gè)人分 別分為40類制作標(biāo)簽,放到40個(gè)編號(hào)0?39的文 件夾內(nèi)。

(3 )制作標(biāo)簽txt文件。

(4)轉(zhuǎn)換Imdb格式的數(shù)據(jù)集。

(5)訓(xùn)練集均值文件。

至此,人臉圖像的預(yù)處理結(jié)束。

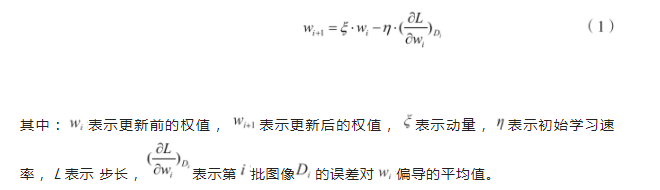

網(wǎng)絡(luò)的訓(xùn)練和測試

本文利用批量隨機(jī)梯度下降的方式,準(zhǔn)確率提 升得更快。對(duì)于ORL人臉數(shù)據(jù)庫原網(wǎng)絡(luò)和本文網(wǎng)絡(luò) 的網(wǎng)絡(luò)訓(xùn)練,最大迭代次數(shù)均為10 000,批處理圖 片大小分別為4個(gè)和8個(gè),動(dòng)量均為0.9,常數(shù)因子 均為0.1 (本實(shí)驗(yàn)由于最大迭代次數(shù)和步長設(shè)置相同, 所以此參數(shù)可以忽略),初始權(quán)值均為0.000 5,步 長均為10 000,初始學(xué)習(xí)速率均為0.000 1,均為訓(xùn)練1次測試一次,訓(xùn)練1 000次存儲(chǔ)一個(gè)模型。每 次訓(xùn)練網(wǎng)絡(luò),更新的參數(shù)都會(huì)遍歷它的批處理量。更新公式為:

實(shí)驗(yàn)與結(jié)果分析

AlexNet網(wǎng)絡(luò)和本文網(wǎng)絡(luò)通過迭代次數(shù)找到最 適合ORL人臉數(shù)據(jù)庫的網(wǎng)絡(luò)模型。本設(shè)計(jì)的測試 集的識(shí)別率只是通過網(wǎng)絡(luò)模型測試人臉數(shù)據(jù)的優(yōu)劣 性,最終的識(shí)別率是全部樣本的識(shí)別率。同時(shí)通過 比較各個(gè)集合的損失值得出網(wǎng)絡(luò)模型在保留盡可能 多的人臉信息的前提下保證其識(shí)別率的準(zhǔn)確性。

3.1 卷積神經(jīng)網(wǎng)絡(luò)的人臉識(shí)別

AlexNet網(wǎng)絡(luò)的迭代次數(shù)取為1 000 ~ 10 000), 本文網(wǎng)絡(luò)的迭代次數(shù)取為(1 000 ~ 10 000)用這些 模型進(jìn)行人臉識(shí)別的測試來比較它們的損失值和識(shí) 別率。

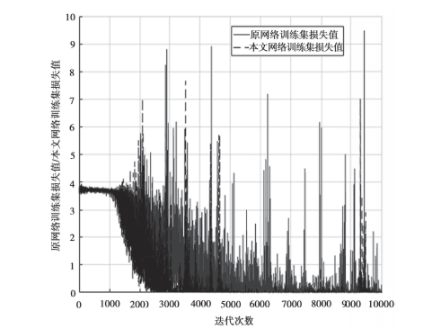

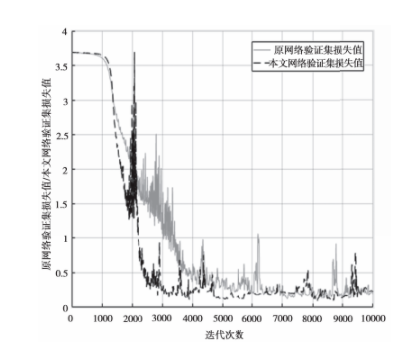

圖5表示出對(duì)應(yīng)于ORL中的原網(wǎng)絡(luò)和本文網(wǎng) 絡(luò)的迭代次數(shù)的訓(xùn)練集成本函數(shù)損失。

圖5 原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)訓(xùn)練集損失曲線

由圖5可以看出本文網(wǎng)絡(luò)只有在迭代2 000、3 000、3 500、4 000、4 500、4 800、9 400、9 600 次的時(shí)候訓(xùn)練集損失的值要比改進(jìn)前的網(wǎng)絡(luò)高,其余的時(shí)候遠(yuǎn)遠(yuǎn)低于原網(wǎng)絡(luò),最后趨于零達(dá)到平穩(wěn)。

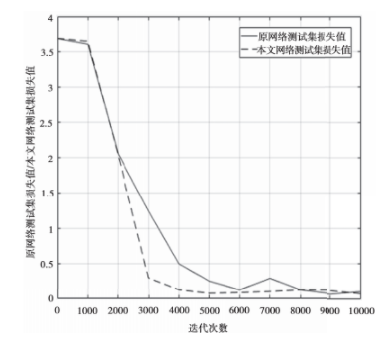

圖6顯示于ORL中原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)的迭代 次數(shù)的驗(yàn)證集成本函數(shù)損失

圖6 原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)驗(yàn)證集損失曲線

由圖6可以看出驗(yàn)證集本文網(wǎng)絡(luò)在迭代1 000 次、2 200次、9 500次、9 700次的時(shí)候損失值比 原網(wǎng)絡(luò)損失值高,其余的時(shí)候均比原網(wǎng)絡(luò)損失值低, 最后趨于零達(dá)到平穩(wěn)。

圖7顯示了對(duì)應(yīng)于ORL中原網(wǎng)絡(luò)和本文網(wǎng)絡(luò) 的迭代次數(shù)的測試集成本函數(shù)損失。

圖7 原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)測試集損失曲線

由圖7可以看出本文網(wǎng)絡(luò)下降的速度比原網(wǎng)絡(luò) 下降的快,在迭代5 000次之后,基本趨于穩(wěn)定, 雖然在迭代8 000-9 500次的時(shí)候損失值略高于原 網(wǎng)絡(luò),但是原網(wǎng)絡(luò)的損失值一直在上下震蕩,最后 本文網(wǎng)絡(luò)的損失值收斂在0.1附近。

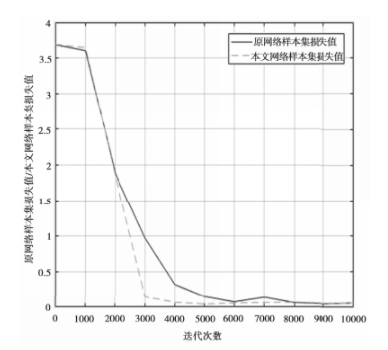

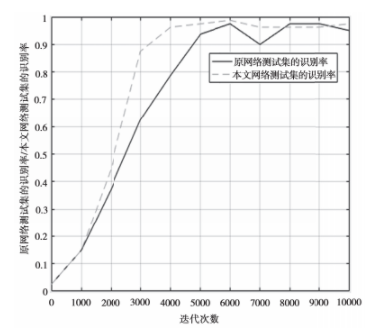

圖8顯示了 ORL中原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)的迭代 次數(shù)樣本集成本函數(shù)損失。

圖8原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)樣本集損失曲線

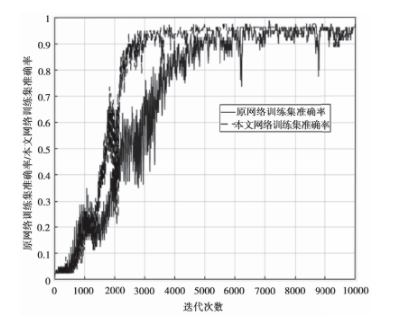

圖8和圖7的曲線類似,不同的是圖8的樣本 集損失值一直處在原網(wǎng)絡(luò)的下方,最后樣本集的損 失值也收斂在0.1附近。圖9顯示了 ORL人臉數(shù)據(jù)庫中原網(wǎng)絡(luò)和本文 網(wǎng)絡(luò)迭代次數(shù)訓(xùn)練集的準(zhǔn)確率。

圖9原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)驗(yàn)證集對(duì)訓(xùn)練集測試的準(zhǔn)確率曲線 由圖9可以看出本文網(wǎng)絡(luò)驗(yàn)證集對(duì)訓(xùn)練集的準(zhǔn) 確率的上升速度比原網(wǎng)絡(luò)快,并且在迭代6 000次 之前都是穩(wěn)步上升的,而迭代6 000次之后原網(wǎng)絡(luò) 上下強(qiáng)烈震蕩,本文網(wǎng)絡(luò)減小了震蕩,在97.5%的 時(shí)候趨于平穩(wěn)。圖10顯示了 ORL人臉數(shù)據(jù)庫原網(wǎng)絡(luò)和本文網(wǎng) 絡(luò)迭代次數(shù)中每次迭代的測試集識(shí)別率。

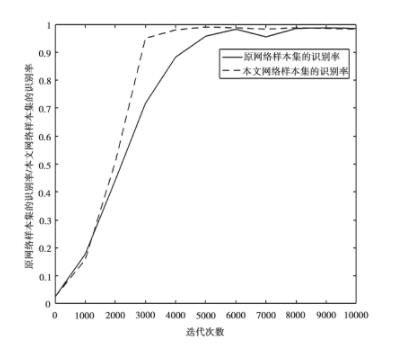

圖10原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)測試集識(shí)別率曲線由圖10可以看出在迭代6 000次之前,原網(wǎng) 絡(luò)和本文網(wǎng)絡(luò)對(duì)測試集的識(shí)別率均穩(wěn)步上升,其 中原網(wǎng)絡(luò)識(shí)別率最高為97.5%,而本文網(wǎng)絡(luò)識(shí)別率 最高為98.75%。但在迭代6 000次之后原網(wǎng)絡(luò)發(fā) 生強(qiáng)烈震蕩,本文網(wǎng)絡(luò)也略微下降,在迭代8 000? 9 200次的時(shí)候略低于原網(wǎng)絡(luò)測試集的識(shí)別率,本文 網(wǎng)絡(luò)隨后繼續(xù)上升直到識(shí)別率為96.25%的時(shí)候趨于 穩(wěn)定。圖11顯示了 ORL原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)迭代次數(shù) 的樣本集識(shí)別率。

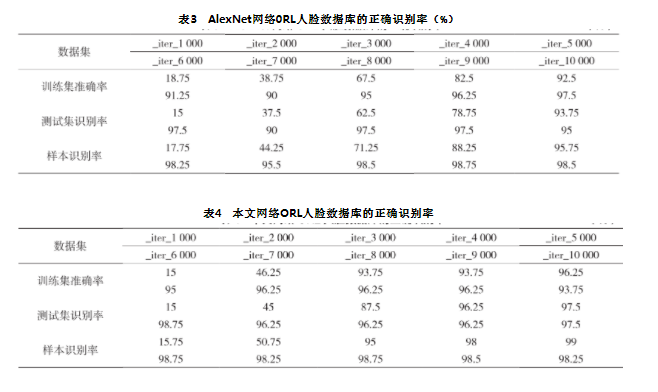

圖11原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)樣本集識(shí)別率曲線圖11和圖10基本相似,不同的本文網(wǎng)絡(luò)的 樣本集識(shí)別率幾乎一直在原網(wǎng)絡(luò)樣本集識(shí)別率之上 (除了迭代9 000?10 000次)。其中,原網(wǎng)絡(luò)對(duì)樣 本集的最高識(shí)別率為98.75%,本文網(wǎng)絡(luò)對(duì)樣本集的最高識(shí)別率為99%。原網(wǎng)絡(luò)和本文網(wǎng)絡(luò)對(duì)全部樣本的識(shí)別率分別在98.5%和98.75%達(dá)到平衡。綜上所說,本文網(wǎng)絡(luò)損失曲線和識(shí)別率曲線要比原網(wǎng)絡(luò)損失曲線和識(shí)別率曲線震蕩減小趨于平穩(wěn),達(dá)到的實(shí)踐效果更好。測量對(duì)于相應(yīng)的人臉數(shù)據(jù)庫訓(xùn)練集和測試集的每個(gè)模型的正確識(shí)別率,結(jié)果如表3、表4所示。

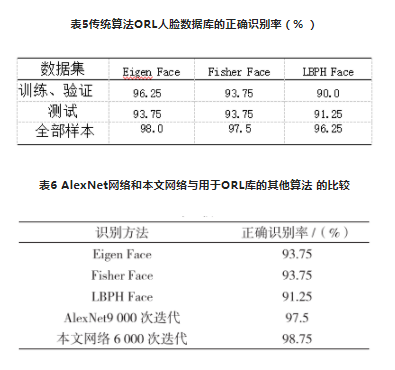

? ? ? 由上述表格的數(shù)據(jù)得到,原網(wǎng)絡(luò)最佳的模型AlexNet網(wǎng)絡(luò)的_iter_9000;本文最佳的網(wǎng)絡(luò)模 型本文網(wǎng)絡(luò)的_iter_6000;本文人臉的識(shí)別率是以 測試集的識(shí)別率為準(zhǔn),本文網(wǎng)絡(luò)的人臉識(shí)別率比原 網(wǎng)絡(luò)高1.25%,在一定程度內(nèi)能提高識(shí)別率的收斂速度。3.2 AlexNet網(wǎng)絡(luò)的模型和本文網(wǎng)絡(luò)的模型與其他算法的比較傳統(tǒng)人臉識(shí)別算法的識(shí)別率如表5所示。表5傳統(tǒng)算法ORL人臉數(shù)據(jù)庫的正確識(shí)別率(% )

AlexNet網(wǎng)絡(luò)結(jié)構(gòu)模型對(duì)ORL人臉數(shù)據(jù)庫的 識(shí)別率是97.5%,樣本識(shí)別率是98.75%。而本文網(wǎng)絡(luò)結(jié)構(gòu)模型對(duì)ORL人臉數(shù)據(jù)庫的識(shí)別率達(dá)到 98.75%,樣本識(shí)別率是99%。表6是本文設(shè)計(jì)的網(wǎng) 絡(luò)與傳統(tǒng)算法在ORL人臉數(shù)據(jù)庫識(shí)別率的對(duì)比。從 中可以得出結(jié)論,本文所設(shè)計(jì)的網(wǎng)絡(luò)對(duì)ORL人臉數(shù) 據(jù)庫中的識(shí)別率提高1.25%,樣本識(shí)別率提升0.25%。3.3 實(shí)驗(yàn)總結(jié)本文提出了一個(gè)7層網(wǎng)絡(luò)應(yīng)用于0RL人臉數(shù) 據(jù)庫的人臉識(shí)別,提高了 AlexNet網(wǎng)絡(luò)中的超參數(shù) 的批處理量,在迭代次數(shù)很小的時(shí)候就達(dá)到飽和程 度,發(fā)現(xiàn)訓(xùn)練的收斂程度更快,驗(yàn)證的準(zhǔn)確率更高。從訓(xùn)練集、驗(yàn)證集、測試集的損失曲線可以看出本 文網(wǎng)絡(luò)損失更少,并且訓(xùn)練出的模型測試人臉的識(shí) 別率為98.75% (比原網(wǎng)絡(luò)提高1.25%),所有樣本 的識(shí)別率可以達(dá)到99% (比原網(wǎng)絡(luò)提高0.25% ), 人臉識(shí)別的準(zhǔn)確率相對(duì)有所加強(qiáng)。同時(shí)對(duì)人臉數(shù)據(jù) 的損失值和識(shí)別率曲線的振蕩問題進(jìn)行了改進(jìn),結(jié) 果趨于穩(wěn)定。

結(jié) 語

隨著深度學(xué)習(xí)的熱潮和人工智能的推進(jìn),人臉 識(shí)別的應(yīng)用已經(jīng)進(jìn)入各行各業(yè),而對(duì)人臉識(shí)別的準(zhǔn)確性也將成為一個(gè)探究的課題。本文針對(duì)AlexNet 網(wǎng)絡(luò)方法的參數(shù)訓(xùn)練過程提出了新型網(wǎng)絡(luò)算法,經(jīng) 試驗(yàn)證明有優(yōu)良的性能,它逐層的準(zhǔn)確度匹配程度 也得以逐漸加快,從而達(dá)到識(shí)別結(jié)果精確。

引用本文:趙遠(yuǎn)東,劉振宇,柯麗等?人臉識(shí)別中AlexNet網(wǎng)絡(luò)設(shè)計(jì)和改進(jìn)方法研究[J]。通信技術(shù), 2019, 52 (03) : 592-598.

作者簡介 》》》

趙遠(yuǎn)東,碩士研究生, 主要研究方向?yàn)橐曈X伺服信息處理、深度 學(xué)習(xí)、圖像處理、人臉識(shí)別;

劉振宇,博士,教授, 博士研究生導(dǎo)師,主要研究方向?yàn)橐曈X伺 圖像處理與模式識(shí)別;

柯 麗,博士,教授,博士研究生導(dǎo)師, 主要研究方向?yàn)樯?a target="_blank">醫(yī)學(xué)成像、醫(yī)學(xué)圖像處理、生物特 征識(shí)別;

陳香敏,博士研究生,講師,主要 研究方向?yàn)榭祻?fù)機(jī)器人,圖像處理。

選自《通信技術(shù)》2019年第3期(為便于排版,已省去原文參考文獻(xiàn))

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論