今天,各行各業(yè)正與人工智能(AI)加速融合,通過智能化創(chuàng)新來尋求業(yè)務(wù)轉(zhuǎn)型升級(jí)。與為數(shù)不多的頂級(jí) AI 研發(fā)公司相比,大多數(shù)傳統(tǒng)行業(yè)或企業(yè)有著更豐富的 AI 應(yīng)用場(chǎng)景,推動(dòng)著規(guī)模化的 AI 應(yīng)用落地,其 AI 應(yīng)用更具有實(shí)踐意義。然而,在智能化技術(shù)架構(gòu)和平臺(tái)選擇上,它們又往往面臨著「拿著釘子到處找錘子」的尷尬局面。

盡管有人津津樂道于承載 AI 應(yīng)用的一些專用架構(gòu)平臺(tái),但實(shí)際情況是:僅采用專用加速芯片或優(yōu)化單一框架,已經(jīng)無(wú)法滿足運(yùn)行不同工作負(fù)載和適應(yīng)不同應(yīng)用場(chǎng)景所需。這是因?yàn)椋珹I 的應(yīng)用需求是多種多樣的,不同的應(yīng)用也決定了從數(shù)據(jù)中心到邊緣再到設(shè)備所需的硬件能力都會(huì)有所差別。而且,解決企業(yè) AI 規(guī)模化落地,需要充分利用以數(shù)據(jù)為中心的基礎(chǔ)架構(gòu),考慮芯片處理器、核心算法和軟件工具等平臺(tái)解決方案的選擇。

無(wú)論是算法工程師、AI 開發(fā)者還是數(shù)據(jù)科學(xué)家,他們?cè)谶x擇 AI 技術(shù)架構(gòu)和平臺(tái)時(shí)會(huì)有多方面的考量。一個(gè)共識(shí)是,基于既有的 IT 基礎(chǔ)設(shè)施,統(tǒng)一大數(shù)據(jù)和人工智能平臺(tái),可以更加高效釋放數(shù)據(jù)價(jià)值,實(shí)現(xiàn) AI 業(yè)務(wù)目標(biāo)。人們正在發(fā)現(xiàn),更加通用的英特爾架構(gòu)具有重要的先發(fā)優(yōu)勢(shì)。由英特爾計(jì)算架構(gòu)和至強(qiáng)平臺(tái)的助力,人工智能技術(shù)可以幫助企業(yè)從既有的平臺(tái)起步,加速「破局」AI 產(chǎn)業(yè)實(shí)踐。

英特爾 AI 架構(gòu)帶來的優(yōu)勢(shì)可以從七個(gè)方面說起,其中包括性能、數(shù)據(jù)預(yù)處理、可擴(kuò)展性、內(nèi)存、模型部署、大數(shù)據(jù)分析,以及跨平臺(tái)部署應(yīng)用。

第一重助力:性能

今天,CPU 性能優(yōu)化已有數(shù)量級(jí)的提升,VNNI 和框架優(yōu)化等大幅提升了 CPU 架構(gòu)運(yùn)行深度學(xué)習(xí)推理的速度。

很多人可能都認(rèn)為 AI 這種新出現(xiàn)的技術(shù),或者說應(yīng)用負(fù)載,也應(yīng)該用新的架構(gòu)來支撐,其實(shí)不然。實(shí)際上隨著 CPU 性能的數(shù)量級(jí)提升,以及在軟硬件層面針對(duì) AI 應(yīng)用的不斷優(yōu)化,CPU 平臺(tái)也能很好地承載 AI 應(yīng)用。現(xiàn)在 CPU 能兼容幾乎所有的 AI 主流技術(shù),深度學(xué)習(xí)的應(yīng)用任務(wù),特別是推理,完全可以用 CPU 來搞定。而且 CPU 還有一個(gè)特定的優(yōu)勢(shì),就是當(dāng)用戶混合使用機(jī)器學(xué)習(xí)和深度學(xué)習(xí)方法時(shí),CPU 更適合承載這樣的任務(wù)。

不斷更新?lián)Q代的英特爾 CPU 平臺(tái),已經(jīng)在眾多 AI 應(yīng)用,特別是推理上提供了強(qiáng)大的算力。以第二代英特爾至強(qiáng)可擴(kuò)展處理器為例,它集成了加速人工智能深度學(xué)習(xí)推理的英特爾深度學(xué)習(xí)加速(英特爾 DL Boost)技術(shù),將人工智能性能提升到一個(gè)全新的水平,可加速數(shù)據(jù)中心、企業(yè)和智能邊緣計(jì)算環(huán)境中的人工智能推理工作負(fù)載。以常見的 Caffe Resnet-50 模型為例來看性能變化,第二代英特爾至強(qiáng)鉑金 8280 處理器借助英特爾 DL Boost 技術(shù),圖像識(shí)別的速度可比上一代英特爾至強(qiáng)可擴(kuò)展處理器提升 14 倍。

另外,英特爾 CPU 平臺(tái)還與各類主流深度學(xué)習(xí)框架(包括 TensorFlow、PyTorch、caffe 、MXNet、PaddlePaddle、BigDL 等)合作,針對(duì) CPU 的 AI 訓(xùn)練和 AI 推理功能進(jìn)行全面優(yōu)化,Xeon 處理器訓(xùn)練性能因此得到不斷提升,客戶也可以選擇使用適合自身需求的深度學(xué)習(xí)框架做模型訓(xùn)練,而無(wú)需購(gòu)買或者設(shè)置不同的硬件基礎(chǔ)設(shè)施。

隨著軟件工具的不斷更新及面向主流框架的深度優(yōu)化,CPU 平臺(tái)不論是支持基于單一 AI 技術(shù)的應(yīng)用,還是在運(yùn)行融合了多種 AI 技術(shù)的應(yīng)用時(shí),其性能表現(xiàn)都更為突出。

對(duì)于全新硬件架構(gòu)的每一個(gè)數(shù)量級(jí)的性能提升潛力,軟件能帶來超過兩個(gè)數(shù)量級(jí)的性能提升。以第二代英特爾至強(qiáng)可擴(kuò)展處理器上的 VNNI 深度學(xué)習(xí)加速指令為例,過去卷積神經(jīng)需要三條指令,而現(xiàn)在的話一條指令就可以了,通過在底層的軟硬件協(xié)同優(yōu)化,可根據(jù)不同深度學(xué)習(xí)框架將推理性能加速 2-3 倍甚至更多。

第二重助力:數(shù)據(jù)預(yù)處理

數(shù)據(jù)的處理分析和之后的 AI 應(yīng)用如果在一個(gè)平臺(tái)上,可以給用戶帶來更大的便利性,也能節(jié)省成本和降低風(fēng)險(xiǎn)。

盡管當(dāng)前市場(chǎng)對(duì)于 AI 技術(shù)抱有很大興趣,但實(shí)施水平仍然相當(dāng)?shù)拖隆N覀冃枰鶕?jù)應(yīng)用需求構(gòu)建起完整的數(shù)據(jù)分析/AI 流水線,從高質(zhì)量數(shù)據(jù)源整理、數(shù)據(jù)預(yù)處理與清洗、適當(dāng)特征數(shù)據(jù)的選擇與構(gòu)建等前期工作開始,這就要求數(shù)據(jù)工程師、算法工程師等協(xié)同工作。

算法工程師往往要花很多時(shí)間,來處理用于深度學(xué)習(xí)模型訓(xùn)練和測(cè)試的龐大數(shù)據(jù),數(shù)據(jù)預(yù)處理會(huì)涉及很多很零碎的事情,比如校對(duì)數(shù)據(jù)的標(biāo)注是否符合某種邏輯。在進(jìn)行數(shù)據(jù)預(yù)處理時(shí),所寫的代碼不一定是執(zhí)行起來效率最高的,因?yàn)橛锌赡苓@些零碎的校驗(yàn)數(shù)據(jù)功能只用一次,而不是反復(fù)使用。在這種情況下,可以使用方便快速實(shí)現(xiàn)功能的 Python 語(yǔ)言調(diào)用 CPU 來實(shí)現(xiàn),而且基于 CPU 有很多現(xiàn)成的包和工具,具有更快數(shù)據(jù)預(yù)處理的優(yōu)勢(shì)。CPU 還可以通過使用更多內(nèi)存、減少 I/O 操作來提升 AI 運(yùn)行效率。

如今的深度學(xué)習(xí)和 AI 領(lǐng)域,優(yōu)秀的算法和框架數(shù)不勝數(shù),但英特爾開源的 BigDL 和采用了這一技術(shù)的 Analytics Zoo 平臺(tái)選擇了一個(gè)頗具獨(dú)特性的切入點(diǎn),那就是專為已有大數(shù)據(jù)集群的場(chǎng)景設(shè)計(jì)。目前,來自零售業(yè)、金融服務(wù)行業(yè)、醫(yī)療保健業(yè)、制造業(yè)及電信業(yè)等領(lǐng)域的企業(yè)客戶都已經(jīng)開始在英特爾至強(qiáng)服務(wù)器上利用 Analytics Zoo、或基于 BigDL 構(gòu)建更為平滑無(wú)縫的數(shù)據(jù)分析-AI 應(yīng)用流水線。

第三重助力:可擴(kuò)展性

作為普遍使用的基礎(chǔ)設(shè)施,CPU 平臺(tái)就是為可擴(kuò)展性而搭建的,它們不僅易于在更多節(jié)點(diǎn)上進(jìn)行擴(kuò)展,還能按核實(shí)現(xiàn)彈性擴(kuò)展和調(diào)配。

在深度學(xué)習(xí)和機(jī)器學(xué)習(xí)領(lǐng)域,不管是模型訓(xùn)練還是推理,為了分配和部署計(jì)算能力,常常需要基于現(xiàn)有的 IT 基礎(chǔ)設(shè)施或者云平臺(tái)進(jìn)行硬件擴(kuò)展。目前一些專有的 AI 架構(gòu)平臺(tái)只能以卡或芯片為單位來管理和擴(kuò)展,而英特爾至強(qiáng)平臺(tái)不僅更容易在更多節(jié)點(diǎn)上擴(kuò)展,還能按核實(shí)現(xiàn)彈性的擴(kuò)展和調(diào)配,能真正做到精細(xì)化的資源管理和調(diào)配。這使得 AI 平臺(tái)可以盡可能通過云化來提高靈活性,提升自動(dòng)化管理水平,并充分利用到每個(gè)計(jì)算核心的價(jià)值等。

比如有開發(fā)者指出,在新一代 Skylake-SP 微構(gòu)架芯片設(shè)計(jì)上,英特爾首次開始采用了全新網(wǎng)格互連構(gòu)架(Mesh Interconnect Architecture)設(shè)計(jì)方式,從傳統(tǒng)的利用環(huán)形連接,到了新設(shè)計(jì)則全面改采用網(wǎng)格互連的方式,來進(jìn)行資料存取與控制指令的傳送。因?yàn)樽钚挝豢梢允且悦啃小⒚苛衼磉B接,所以每顆 Skylake-SP 核心、緩存、內(nèi)存控制器及 I/O 控制器之間的路徑選擇變得更多元,還可以跨不同的節(jié)點(diǎn)互連,以尋找最短的數(shù)據(jù)傳遞捷徑,即使是加大核心數(shù)量,也能夠維持很快存取數(shù)據(jù),并支持更高內(nèi)存頻寬,以及更高速的 I/O 傳輸。

第四重助力:內(nèi)存

CPU 易擴(kuò)展緩存,而英特爾傲騰 DC 持久內(nèi)存 Apache Pass 更是集大容量、經(jīng)濟(jì)性和持久性于一身,性能接近 DRAM。

不論是 AI 訓(xùn)練還是推理,靠近計(jì)算單元的內(nèi)存或者說較高速的數(shù)據(jù)緩存都非常重要。在 AI 分析中,它們對(duì)訓(xùn)練中的神經(jīng)網(wǎng)絡(luò)構(gòu)建,并通過該網(wǎng)絡(luò)進(jìn)行推理比較都有著重要的影響。因此我們希望在靠近計(jì)算單元的地方盡可能緩存更多數(shù)據(jù)。其容量的增加,會(huì)很大程度上提高 AI 的整體性能、準(zhǔn)確性、響應(yīng)速度。

訓(xùn)練深度學(xué)習(xí)模型時(shí),占用 CPU 內(nèi)存比較大,一般來說單臺(tái)刀片可以輕松做到 256GB 以上的內(nèi)存,做分布式訓(xùn)練時(shí)還可以把數(shù)據(jù)分配到不同機(jī)器上進(jìn)行計(jì)算,而且可以盡量把數(shù)據(jù)預(yù)存到 CPU。此外,CPU 大內(nèi)存的優(yōu)勢(shì)不僅體現(xiàn)在訓(xùn)練上,更主要的是推理,比如對(duì)尺寸很大的醫(yī)療影像模型進(jìn)行推理處理。

即使沒有英特爾傲騰數(shù)據(jù)中心級(jí)持久內(nèi)存的出現(xiàn),英特爾至強(qiáng)處理器平臺(tái)也很容易擴(kuò)展內(nèi)存的容量。但有了這種全新類型的產(chǎn)品后,內(nèi)存的存儲(chǔ)密度/價(jià)格比可能會(huì)更理想,其性能也接近 DRAM,讓更大量的數(shù)據(jù)可以更接近 CPU 進(jìn)行移動(dòng)和處理,極大地降低從系統(tǒng)存儲(chǔ)獲取數(shù)據(jù)的延遲。相比之下,專有架構(gòu)平臺(tái)要擴(kuò)展緩存,還是很不方便的。

第五重助力:模型部署

英特爾技術(shù)產(chǎn)品從端到端是有統(tǒng)一的應(yīng)用兼容性的,這樣可以保證我們?cè)诤蠖擞?xùn)練迭代算法,前端部署推理。

在深度學(xué)習(xí)實(shí)踐中,是否應(yīng)該去搭建一套新的專用平臺(tái)?持否定意見的開發(fā)者認(rèn)為,目前主要用于 AI 模型推理的平臺(tái)都是基于 CPU 架構(gòu)的,應(yīng)該利用現(xiàn)有的數(shù)據(jù)中心基礎(chǔ)設(shè)施,利用現(xiàn)有的、熟悉的處理器平臺(tái),以最低的成本部署人工智能,這相比另起爐灶、尋找其他計(jì)算平臺(tái)的方法,用時(shí)更短 、風(fēng)險(xiǎn)更低、性價(jià)比更高。

有開發(fā)者據(jù)此總結(jié)了三條理由:首先,現(xiàn)如今標(biāo)準(zhǔn) CPU 平臺(tái)完全能夠勝任 AI 所有應(yīng)用;其次,現(xiàn)在 AI 屬于「試錯(cuò)階段「,同時(shí)技術(shù)也在快速演變和迭代,利用現(xiàn)有的 CPU 平臺(tái),可以最小成本做最大的事,無(wú)需大量額外投資,但如果另起爐灶可能得不償失;最后,用多年熟悉且信任的 CPU 平臺(tái),構(gòu)建「激進(jìn)」的 AI 項(xiàng)目,本身就是一個(gè)絕好的平衡,讓技術(shù)風(fēng)險(xiǎn)變得可控。

在現(xiàn)有英特爾架構(gòu)支持的數(shù)據(jù)應(yīng)用基礎(chǔ)上構(gòu)建 AI 應(yīng)用,生產(chǎn)環(huán)境非常成熟,易于部署,運(yùn)維人員學(xué)習(xí)難度低。英特爾從云到端都有硬件平臺(tái)就緒,不論是通用計(jì)算還是專用芯片(如 Movidius),而且還有相關(guān)的軟件支持,如眾多優(yōu)化庫(kù)、框架和工具。另外,英特爾為 AI 應(yīng)用的開發(fā)者們提供了 OpenVINO 等工具包,可以方便實(shí)現(xiàn)模型部署,優(yōu)勢(shì)顯著。

第六重助力:大數(shù)據(jù)分析

英特爾至強(qiáng)處理器和 BigDL 軟硬搭配,在 Hadoop 和 Spark 等主流大數(shù)據(jù)框架上,可以簡(jiǎn)化訓(xùn)練(數(shù)據(jù)獲取+處理)過程。

Hadoop 和 Spark 是目前非常流行的大數(shù)據(jù)管理和處理框架,想利用它們承載的數(shù)據(jù)進(jìn)行深度學(xué)習(xí)訓(xùn)練,通常需要把這些數(shù)據(jù)導(dǎo)出,然后進(jìn)行處理,這個(gè)過程不僅耗時(shí)而且投資較大,所以在這些大數(shù)據(jù)平臺(tái)上進(jìn)行深度學(xué)習(xí)訓(xùn)練顯得尤為重要。

有開發(fā)者認(rèn)為,可以針對(duì)各種不同來源的數(shù)據(jù),首先根據(jù)目標(biāo)算法需要的數(shù)據(jù)格式,進(jìn)行數(shù)據(jù)整合。得到目標(biāo)數(shù)據(jù)之后,再根據(jù)業(yè)務(wù)需要,按照對(duì)應(yīng)的比例,將最原始的數(shù)據(jù)分成訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù),通過算法對(duì)數(shù)據(jù)不斷進(jìn)行訓(xùn)練,后期進(jìn)行相應(yīng)的測(cè)試。

其實(shí)更好的方式是打通數(shù)據(jù)流水線。英特爾的 Analytics Zoo(內(nèi)含 BigDL)打通端到端數(shù)據(jù)流水線,在 Hadoop 和 Spark 等主流的大數(shù)據(jù)框架上,把數(shù)據(jù)的收集、存儲(chǔ)、傳輸、預(yù)處理、后期處理等環(huán)節(jié),與 AI 的訓(xùn)練和預(yù)測(cè)等部分有機(jī)結(jié)合起來,就可以讓企業(yè)的數(shù)據(jù)分析流水線變得高效而統(tǒng)一。例如,英特爾協(xié)助美的公司基于 Analytics Zoo 構(gòu)建了一套端到端的產(chǎn)品缺陷檢測(cè)方案,準(zhǔn)確率優(yōu)于人工檢查方法,并避免了檢查工作給生產(chǎn)線帶來侵入性影響。

Analytics Zoo 將 Spark、TensorFlow 以及 BigDL 程序整合至同一流水線當(dāng)中,整個(gè)流水線能夠在 Spark 集群之上以透明方式實(shí)現(xiàn)擴(kuò)展,從而進(jìn)行分布式訓(xùn)練與推理。最終使美的的圖像預(yù)處理時(shí)長(zhǎng)由 200 毫秒降低至 50 毫秒,并將延遲影響由 2,000 毫秒縮短至 124 毫秒。

第七重助力:跨平臺(tái)部署應(yīng)用

英特爾至強(qiáng)處理器、Analytics Zoo 以及 OpenVINO 工具包,能夠簡(jiǎn)化深度學(xué)習(xí)流水線,實(shí)現(xiàn)一站式端到端的 AI 應(yīng)用部署。

深度學(xué)習(xí)應(yīng)用的開發(fā)周期很長(zhǎng),而且往往會(huì)涉及多個(gè)工具和平臺(tái),如何將新技術(shù)、新創(chuàng)新應(yīng)用到非常大規(guī)模、大數(shù)據(jù)的生產(chǎn)系統(tǒng)中,目前在軟硬件架構(gòu)上有非常大的斷層。這提升了技術(shù)開發(fā)門檻,開發(fā)者十分期待從云端到終端能跨平臺(tái)部署深度學(xué)習(xí)應(yīng)用。

2018 年,英特爾開源了 Analytics Zoo,構(gòu)建了端到端的大數(shù)據(jù)分析+AI 平臺(tái),無(wú)論是用 TensorFlow 還是 Keras,都能將這些不同模塊的程序無(wú)縫運(yùn)行在端到端流水線上,大大提升了開發(fā)效率。

并且,Analytics Zoo 也兼容 OpenVINO在 AI 應(yīng)用上的加速特性。基于英特爾硬件平臺(tái)、專注于加速深度學(xué)習(xí)的 OpenVINO工具套件,是一個(gè)快速開發(fā)高性能計(jì)算機(jī)視覺和深度學(xué)習(xí)視覺應(yīng)用的工具包。

英特爾 OpenVINO 工具套件不僅適用于開發(fā)可模擬人類視覺的應(yīng)用和解決方案,它還可以通過英特爾 FPGA 深度學(xué)習(xí)加速套件支持 FPGA,旨在通過優(yōu)化廣泛使用的 Caffe 和 TensorFlow 框架來簡(jiǎn)化采用英特爾 FPGA 的推理工作負(fù)載,并用于包括圖像分類、機(jī)器視覺、自動(dòng)駕駛、軍事以及醫(yī)療診斷等應(yīng)用。

OpenVINO工具包基于卷積神經(jīng)網(wǎng)絡(luò)(CNN),可擴(kuò)展英特爾硬件(包括加速器)的工作負(fù)載,并最大限度地提高性能。

具體來說,OpenVINO 具有面向 OpenCV 和 OpenVx 的優(yōu)化計(jì)算機(jī)視覺庫(kù),并支持跨計(jì)算機(jī)視覺加速器的異構(gòu)執(zhí)行,可通過基于英特爾架構(gòu)的處理器(CPU)及核顯(Integrated GPU)和深度學(xué)習(xí)加速器(FPGA、Movidius VPU)的深度學(xué)習(xí)加速芯片,增強(qiáng)視覺系統(tǒng)功能和性能。它支持 在邊緣端進(jìn)行深度學(xué)習(xí)推理,并加速高性能計(jì)算機(jī)視覺應(yīng)用,幫助開發(fā)人員和數(shù)據(jù)科學(xué)家提高計(jì)算機(jī)視覺應(yīng)用性能,簡(jiǎn)化深度學(xué)習(xí)部署過程。

AI 應(yīng)用落地的實(shí)際選擇

經(jīng)過上述分析我們可以發(fā)現(xiàn),在七個(gè)方面中,每個(gè)維度都支持 CPU 架構(gòu)和平臺(tái)的優(yōu)勢(shì)。一方面,CPU 的計(jì)算能力通過軟硬件協(xié)同優(yōu)化不斷提升,可以更好地適應(yīng) AI 場(chǎng)景需求,企業(yè)漸漸意識(shí)到用 CPU 做 AI 已經(jīng)「足夠好」;另一方面,通過收購(gòu)和探索不同芯片架構(gòu),英特爾的 AI 軟硬件產(chǎn)品組合正在不斷完善,這使得英特爾能夠建立一個(gè)完整的 AI 基礎(chǔ)架構(gòu),非常豐富的產(chǎn)品組合是英特爾與其他公司實(shí)現(xiàn)差異化的最大亮點(diǎn)。

-

英特爾

+關(guān)注

關(guān)注

61文章

10178瀏覽量

174115 -

AI

+關(guān)注

關(guān)注

88文章

34520瀏覽量

276031

發(fā)布評(píng)論請(qǐng)先 登錄

直擊Computex2025:英特爾重磅發(fā)布新一代GPU,圖形和AI性能躍升3.4倍

英特爾發(fā)布全新GPU,AI和工作站迎來新選擇

AI驅(qū)動(dòng)零售變革!英特爾AI方案助力中國(guó)廠商海外破局

英特爾推出全新英特爾銳炫B系列顯卡

英特爾發(fā)布全新企業(yè)AI一體化方案

英特爾目標(biāo)明年出貨1億臺(tái)AI PC

英特爾計(jì)劃明年AI PC出貨一億臺(tái)

英特爾聚焦AI座艙

英特爾考慮出售Altera股權(quán)

Inflection AI攜手英特爾推出企業(yè)級(jí)AI系統(tǒng)

英特爾攜手運(yùn)營(yíng)商伙伴,共探AI驅(qū)動(dòng)通信網(wǎng)絡(luò)新未來

英特爾和AWS共同投資定制芯片

英特爾IT的發(fā)展現(xiàn)狀和創(chuàng)新動(dòng)向

從運(yùn)動(dòng)員到開發(fā)者: 英特爾以開放式AI系統(tǒng)應(yīng)對(duì)多重挑戰(zhàn)

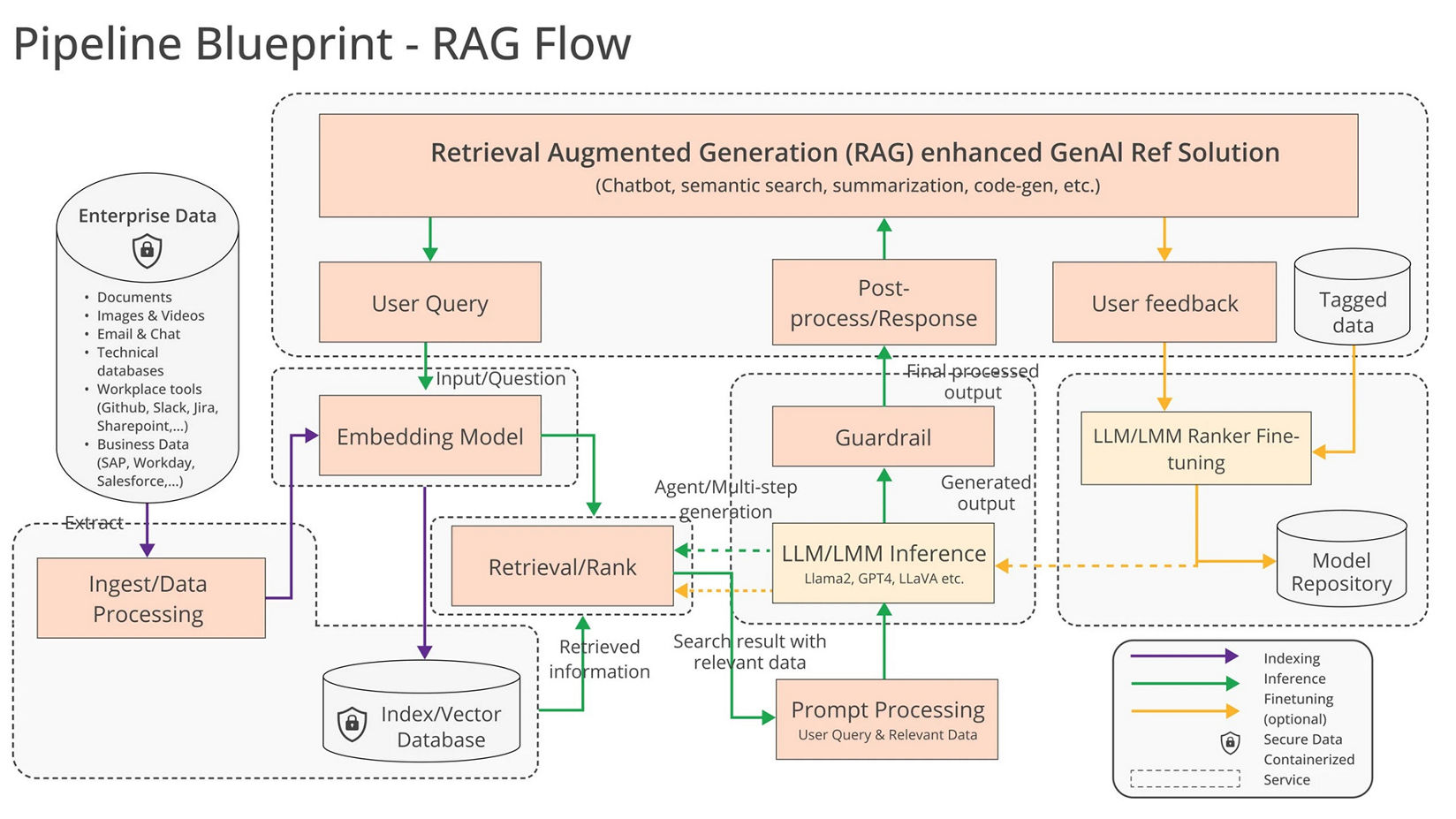

英特爾以生成式AI RAG解決方案,為巴黎奧運(yùn)健兒提供便捷體驗(yàn)

評(píng)論