伴隨著數據的指數級增長,給我們的生活帶來便利的同時,也給電信網絡帶來更高的壓力和需求。隨著數據中心流量的增加,許多平臺都迫切需要提高服務器和網絡帶寬。除此之外,數據中心還需要一種可以有效擴展以適應未來需要的產品,10GE 作為當前部署的主流帶寬在這方面已有些力不從心。在互聯網企業中,25GE 以太網逐步開始承載云平臺和關鍵業務,25GE 擁有 10GbE 無可比擬的帶寬優勢,同時也具備極好的可擴展行來滿足未來節點數增長的需求。25GE 技術可在成本和功耗較低的情況下在單個通道中提供較高帶寬,從而提供更高的服務器和交換機端口密度。25GE 是一種新標準,可利用為 100GE 以太網(作為在四個光纜或銅纜對上運行的四個 25Gbps 通道 (IEEE802.3bj) 而實施)定義的技術。以 25GE 為基礎構建的解決方案可與 10GE、50GE、100GE 以及未來的 200GE 和 400 GE 產品向后和向前兼容,從而可確保適應未來解決方案的升級途徑。隨著高帶寬互連越來越普遍,網絡請求處理向 CPU 施加了沉重負擔。借助網卡端的卸載和交換端的流控技術(如 RoCE, PFC 和 ECN),可以實現高效率以便進一步提高 25GbE 網絡的性能。RDMA 使網絡適配器可以直接訪問應用程序緩沖區,從而繞過內核、CPU 和協議堆棧,因此 CPU 可以在 I/O 傳輸進行期間執行更有用的任務。這樣可提高服務器中的性能,從而使應用程序工作負載可以在高帶寬網絡中高效擴展。

存儲是除了 CPU 和網絡之外,影響系統性能極為關鍵的一環。客戶相關的各類數據,網絡運行的日志和維護記錄等都需要通過存儲保存。傳統的 FC 存儲使用不同于標準以太網的 FC 網絡,而存儲介質以硬盤為主,對于當前大量的非結構化數據來說,單盤每秒能進行的書寫次數在 100 以內。要搭建高性能的系統,一是要有能支持更高讀寫速度的介質,二是要有合適的協議能高效承載數據,然后就是配套的網絡和 CPU 能滿足對應的性能要求。

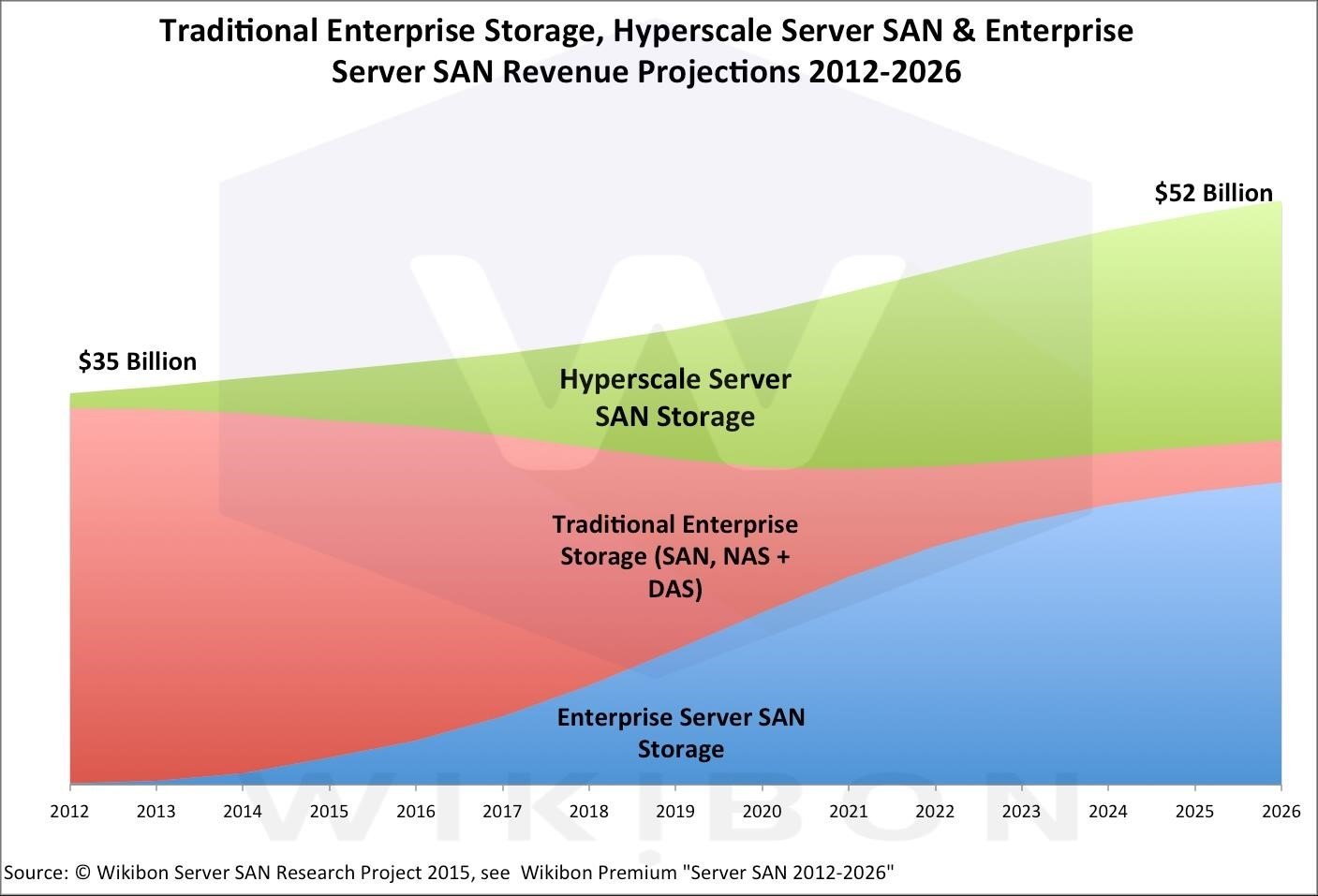

根據國際權威機構 Wikibon 對未來存儲市場的預測,存儲市場整體穩步增長。但傳統SAN/ NAS 存儲的市場占比則持續降低,Hyper-Scale Server SAN 和和企業級 Server SAN 等分布式存儲在 2021 年市場份額預計占比超過 80%,2026 年將超過 90%。決定分布式存儲的關鍵則是核心軟件和分布式的通訊互聯。

圖 1. 存儲市場預測當前的問題和解決思路

目前主要問題是越來越大的需處理數據量與傳統低速存儲的矛盾。要解決這一問題,在本文開頭的概述中我們提到需要更高性能的介質配合網絡和 CPU,以提升節點的性能并打造可擴展的系統,應對日益增長的數據需求和性能要求。因此,福建電信探索通過 25G 網絡及 RoCE 技術,實現高效的分布式數據解決方案,解決當前數據倉庫的性能問題。

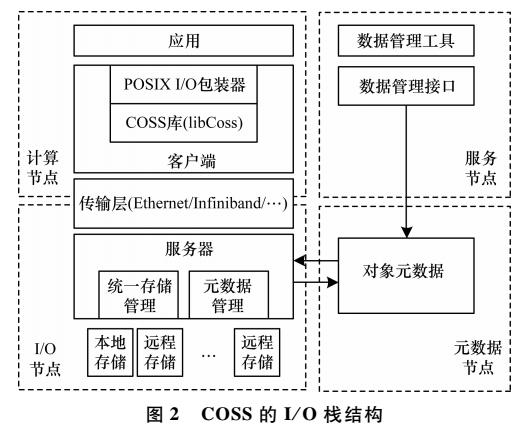

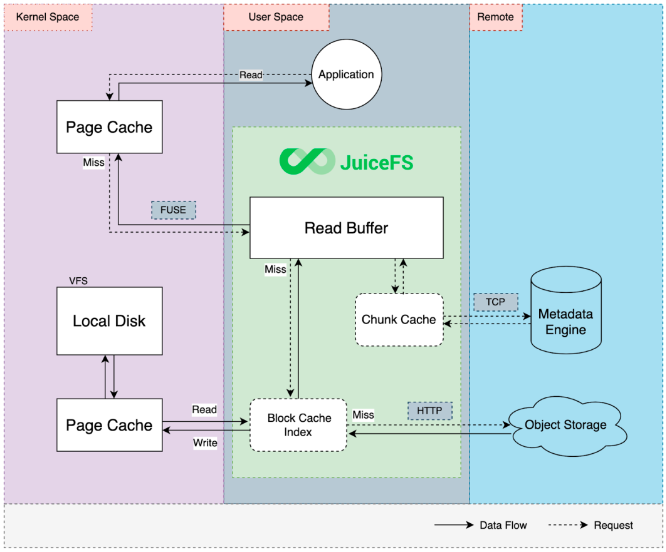

首先需要解決的是存儲的架構問題。在資源池化的大環境下,傳統存儲肯定無法繼續使用。出于海量數據本身的需求,為優化不同節點對存儲的并行訪問性能,使用分布式存儲來解決問題是一個較好的思路。在分布式存儲系統中,如何提升存儲的遠端訪問性能,進而提升分布式存儲整體效率,這是一個挑戰。從協議的角度,可以使用 iSER 或 NVMF 等基于 RoCE 的訪問技術;從網絡的角度,更好利用網卡的卸載特性、以太網交換機的低延時、零丟包特性和先進的流控機制,能有效提高網絡效率并降低 TCO,進一步提升分布式存儲的性能和效率。

其次,對于使用哪種存儲介質能滿足高性能存儲的要求,筆者認為 NVMe SSD 擁有較好的隨機讀寫性能。且可以選擇 U.2 接口的 NVMe SSD,可支持熱插拔,也可根據需要實現 RAID,以滿足存儲的高可靠性要求。由于單塊 NVMe SSD 的讀寫就需要高于 20Gb/S 的帶寬,25GE 網絡成為滿足存儲 IO 需求的起步配置。 然后,對于解決容量問題的需求,解決的思路是使用高速的 NVMe SSD 作為緩存,在之后使用大容量的硬盤來存儲冷數據,這樣通過智能緩存加速 IO 讀寫,同時通過海量硬盤實現大容量。

在既定的分布式架構下,存儲性能的關鍵在于如何實現存儲訪問的加速。這個技術可以分為兩個方面,一方面是保證遠端存儲和本地存儲有近似的 IO 性能,另一方面是怎么樣通過硬件卸載來保證 CPU 不被過度占用進而影響存儲性能。之前提到的基于 RoCE 的網絡技術能非常好的實現這個存儲訪問的加速。

除上述問題之外,由于是分布式架構,網絡如何保證數據的完整性也是非常重要的。這里需要交換機和網卡端的配合來實現端到端的流控機制。如果硬件本身的可靠性和可用性都非常高,這也是對系統性能的一個有力保證。

采用以 Mellanox 為代表的高帶寬低延遲智能網絡和 RDMA/RoCE 技術能加速數據傳遞和高效無損無疑是構建分布式存儲網絡的關鍵之一。

方案框架

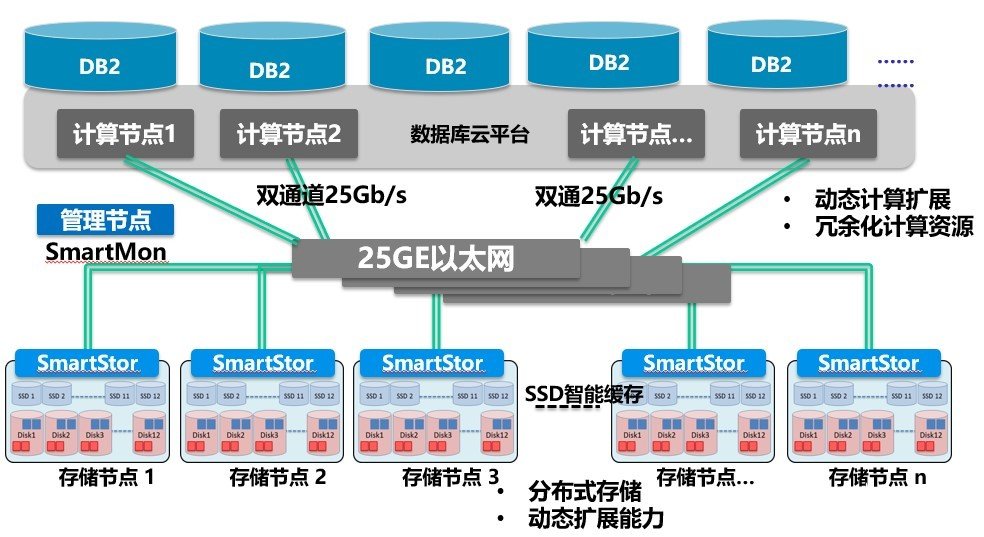

圖 2. 分布式存儲方案簡圖

基于上一章節的分析,此處給出實現分布式存儲的框架,用于數據庫云的承載。在圖2 中計算節點和存儲節點都連到 25GE 組網。無論計算節點還是存儲節點,都使用雙路25GE 捆綁替換原來的雙路 10GE 網絡。在前期實驗網絡中,共接入 27 個存儲節點,每個存儲節點配 4 塊 3.2T NVMe 硬盤。在云平臺之上承載容器化數據庫,根據應用的需要,可以擴展計算節點或存儲節點,以支持更高容量或更多用戶。由于方案側重遠端資源池化的實現,因此我們的性能對比測試也主要針對不同網絡的場景。

o 網絡交換

在網絡交換上,我們選擇了業界低延時的存儲網絡交換機 Mellanox MSN2410,每臺MSN2410 能支持高達 48 個 25GE 接口,同時支持 8 個 100GE 接口。在提供可靠硬件和靈活的端口支持基礎長,MSN2410 能為分布式存儲提供無與倫比的網絡特性:

- 支持低至 300ns 的延時,且抖動小;

- 任意 64 字節及以上報文都能實現線速轉發;

- 公平、可預測的端口資源分配保證最合理的帶寬使用;

在報文處理的細節方面,MSN2410 能夠通過其大緩存實現對于 Micro Burst 的最佳支持,同時先進的 ECN 標記方法和最快的 PFC 響應都能極好保證存儲數據無損到達對端。

Mellanox 交換機配置簡單,降低了安裝和管理高速網絡的復雜性,具有完善的監控和管理功能,可以通過軟件實現監測管理。

o RoCE 網卡

在數據不斷增長的環境中,所有數據的快速傳輸對于高效使用信息至關重要。基于遠程直接內存訪問 (RDMA) 的互連可為提升數據中心效率、降低整體復雜性以及提高數據交付性能提供理想選擇。RDMA 使數據可以從存儲傳輸到服務器,而無需通過 TCP/IP 以太網的 CPU 和主內存路徑傳遞數據。可獲得更高 CPU 和整體系統效率,因為存儲和服務器的計算能力只用于計算(而不是處理)網絡流量。盡管高帶寬十分重要,但是如果沒有低延遲,帶寬就沒什么價值。通過網絡移動大量數據可以使用 TCP/IP 來實現,但是只有 RDMA 才能實現低延遲,避免成本高昂的傳輸延遲。而且,RDMA 卸載可減少抖動,這意味著低響應時間的一致性顯著提高 RoCE 最終將 RDMA 技術引入基于以太網的數據中心,從而使這類數據中心可以受益于 RDMA 的低延遲。

Mellanox 從 ConnectX-4 系列網卡開始,可利用網卡中內置的基于管線的可編程 eSwitch 來快速處理虛擬化換將下的數據交互,ConnectX-4 Lx 可以在硬件中處理大部分數據包處理操作。這些操作包括 VXLAN 封裝/解封、基于一組通用 L2-L4 包頭字段的數據包分類、QoS 和訪問控制列表 (ACL)。在存儲方面,ConnectX-4 Lx 能支持 iSER 和 NVMf,此外,該網卡還能實現基于 VF 的限速機制以及糾刪碼的卸載,大大降低服務器與、網絡交換機和存儲節點之間的協調復雜性問題,提升服務質量。

性能對比

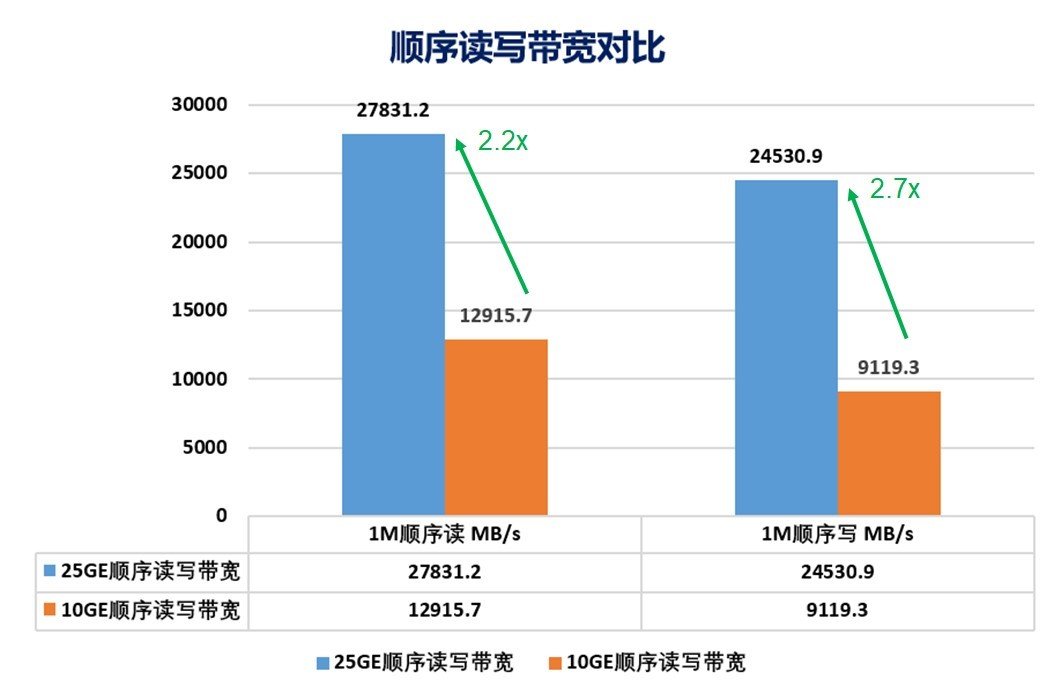

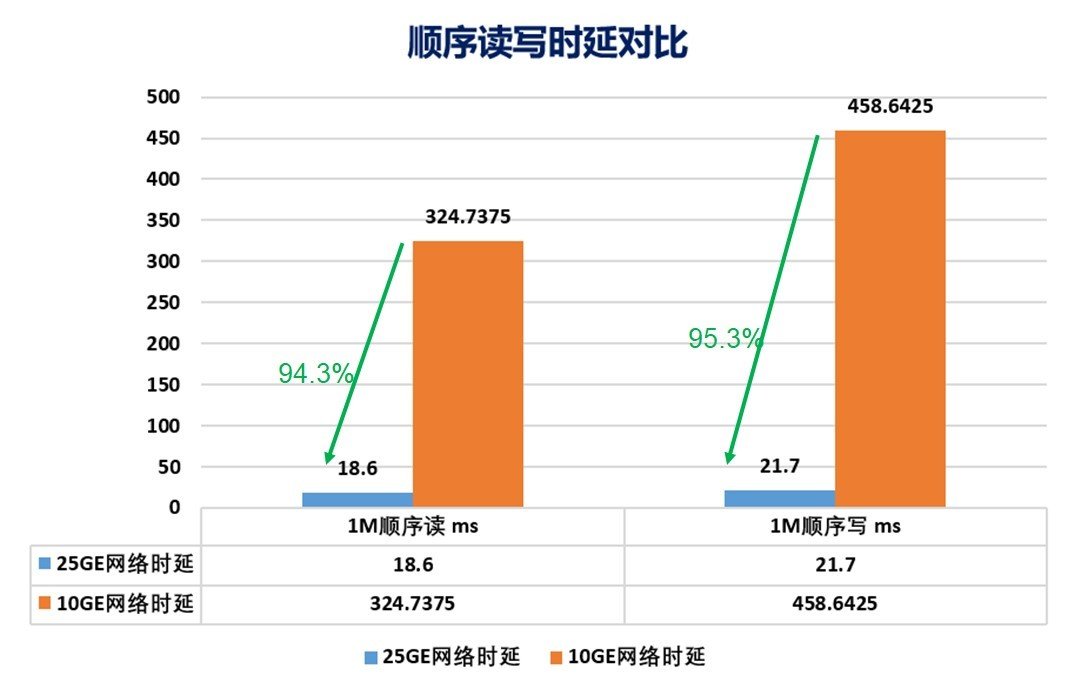

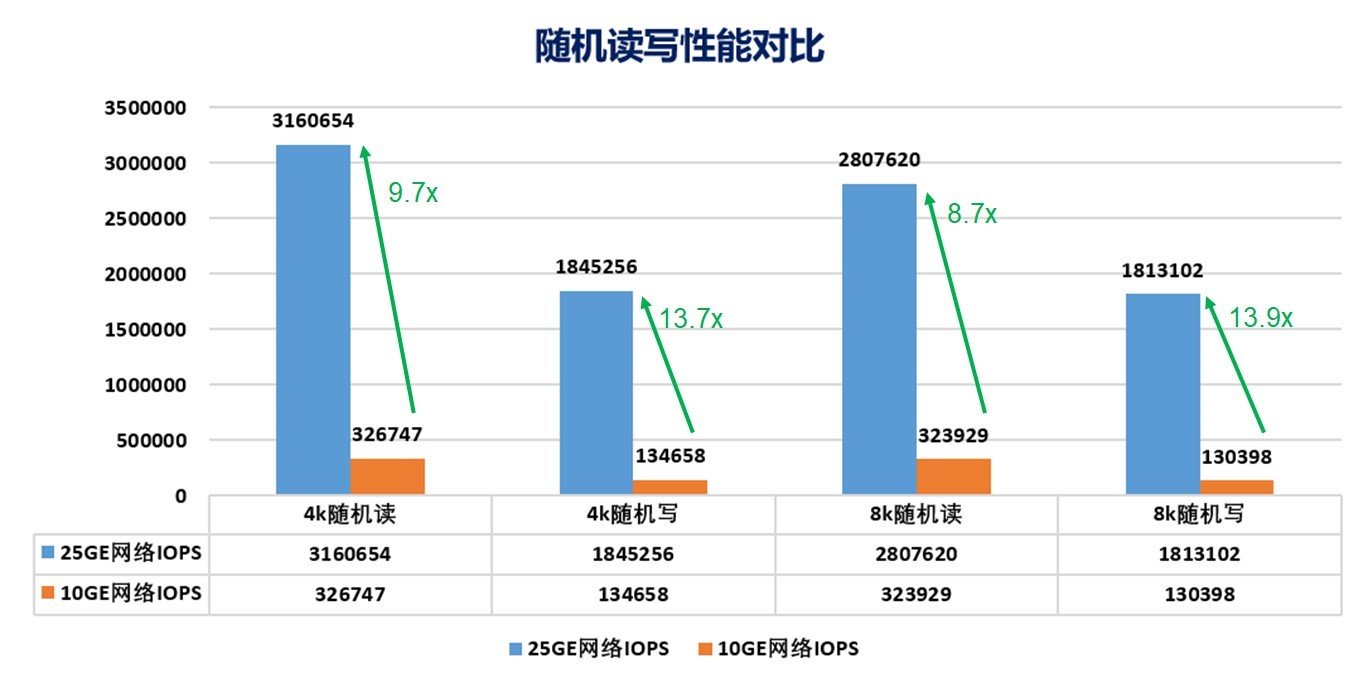

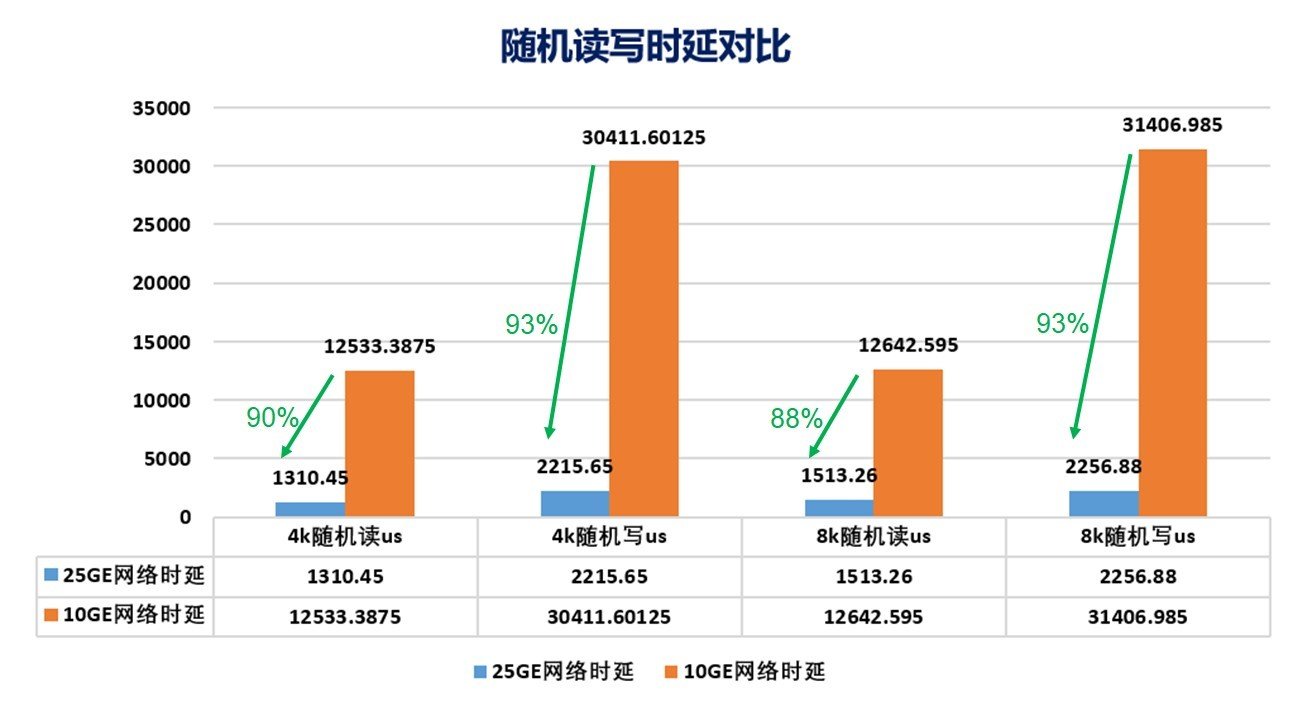

福建電信以 8 計算節點情形作性能測試,以衡量技術創新帶來的優勢。在關鍵的 4K 隨機讀寫測試中,25GE RoCE 網絡的吞吐是 10GE 網絡的 9~14 倍左右,而延時相比 10GE 網絡僅為其 5~10%。明顯可見,25GE RoCE 網絡大大提升了分布式存儲的吞吐,也極好的降低了系統延時。在相同環境下,25GE 網絡順序讀寫的帶寬也是 10GE 網絡 2.2 倍以上,而延時則僅為 10GE 網絡的 5%左右。

圖 3. 順序讀寫帶寬對比

圖 4. 順序讀寫時延對比

圖 5. 隨機讀寫性能對比

圖 6. 隨機讀寫時延對比

結論與下一步展望

在相同高性能分布式存儲上,使用 25GE 網卡比使用傳統萬兆以太網卡不僅有更高的IOPS 和 IO 吞吐量,特別是 IO 時延方面有明顯優勢。本文驗證了分布式存儲在核心生產系統部署的可行性、穩定性及高性能。下一步的工作可以結合應用來看,如何提升分布式存儲和應用之間的貼合度,這是在電信生產系統中面臨的進一步性能優化問題。此外 RoCE 技術在電信網絡其他領域的推廣也是一個值得探討的方向。

責任編輯:gt

-

以太網

+關注

關注

40文章

5419瀏覽量

171628 -

cpu

+關注

關注

68文章

10855瀏覽量

211609 -

存儲

+關注

關注

13文章

4298瀏覽量

85810

發布評論請先 登錄

相關推薦

擴展模塊驅動分布式I/O在新能源鋰電池自動化生產中的發展

使用分布式I/O進行實時部署系統的設計

分布式能源系統當微型電網技術應用

淺談分布式緩存技術

IEEE 1588在時鐘同步技術在分布式系統中有什么應用?

HarmonyOS分布式數據庫,為啥這么牛?

深度解讀分布式存儲技術之分布式剪枝系統

一種面向高性能計算的分布式對象存儲系統

分布式存儲在核心生產系統部署的性能及RoCE技術在電信領域的應用

分布式存儲在核心生產系統部署的性能及RoCE技術在電信領域的應用

評論