這個問題已經在世界各地的會議和社交聊天的討論表中浮出水面了-“機器可以打開人類嗎?”這個問題經常伴隨著《終結者》等電影的場景和視覺效果,但是我們所知道的和所看到的在大數據中使用AI的原因在于,在設計具有更復雜環境的更大規模的系統時,必須考慮某些不確定性和偏差。

機器“感覺”是什么?是什么使他們的行為方式不同于插入大型機的代碼?如今,艾薩克·阿西莫夫(Isaac Asimov)的三項法律在定義機器在復雜環境中的行為標準時是否仍然立于不敗之地?這些問題的答案在于我們選擇定義游戲規則以及機器如何應對突然變化的方式。

在人工智能研究中,道德偏見是不確定性的一個特殊區域,涉及小裝飾品和杠桿,這些小裝飾品和杠桿會拉動機器以有時看起來有些奇怪甚至有害的方式運行。隨著無人駕駛汽車的興起和AI驅動的生產方法逐漸占領世界,一個懸而未決的問題再次需要答案。我們如何處理這些機器?

您可能還會喜歡: AI可以自我警戒并減少偏見嗎?

偏向簡介

從數據角度來看,偏差和方差與測量值與實際值的接近程度有關。在這種情況下,方差是測量值彼此之間相差多少的度量,偏差是指測量值與實際值相差多少。在具有高精度的模型的高度特定的情況下,方差和偏差都將很小。

但是,這可能反映出該模型對新數據的執行效果有多差。然而,很難實現低偏差和方差,這是各地數據分析師的禍根。對于涉及簡單決策而用簡單的二進制計算還不夠的用例,偏差尤其難以處理。

您可能會想問偏見如何進入系統。而且,如果一臺機器無法在不低于人類的臨界點上做出決定,那么為什么要首先使用它們呢?要回答這些問題,您需要查看在大數據領域中如何構建模型的一般方法。

首先從執行器和傳感器中收集并清除數據,這些數據可為分析人員提供原始數據。這些值然后經過預處理步驟,在此將它們標準化,標準化或轉換為除去尺寸和單位的形式。一旦將數據轉換為合適的表格或逗號分隔格式,就將其插入到層或功能方程式網絡中。如果模型使用一系列隱藏層,請放心,它們將具有激活函數,該函數將在每個步驟中引入偏差。

但是,偏差也可以通過許多收集方法的陷阱進入系統。也許數據沒有針對某一組或某類輸出進行平衡,也許數據不完整/錯誤,或者可能沒有任何數據開始。

隨著數據集變得越來越多且記錄不完整,系統肯定有可能用一些預定義的值填補這些空白。這導致另一種假設偏見。

黑匣子難題

許多學者還認為,沒有適當的上下文,數字可能不會意味著同一件事。例如,在有爭議的《鐘形曲線》一書中,作者關于種族群體間智商差異的說法受到了環境約束和差異概念的挑戰。但是,如果一個人能夠達成這樣的解決方案,那么一臺機器要花多長時間才能消除這種邏輯上的判斷失誤?

機會很小。如果機器被送入錯誤或錯誤的數據,它將輸出錯誤的值。問題是由AI模型的構建模棱兩可引起的。這些通常是黑盒模型,作為數據接收器和數據源存在,而沒有解釋內部內容。對于用戶而言,不能質疑或質疑這種黑匣子模型如何得出結果。此外,結果差異還需要解決其他問題。

由于缺乏對黑匣子運作方式的了解,即使使用相同的輸入,分析師也可能得出不同的結果。對于精度不是關鍵因素的值,這種變化可能不會產生太大的影響,但是數據領域卻很少那么慷慨。

例如,如果AI系統無法預測高度特定的參數(例如pH值,溫度或大氣壓),則工業制造商將蒙受損失。但是,當目標是解決諸如貸款兼容性,犯罪再犯甚至適用于大學錄取等問題的答案時,AI缺乏清晰的價值將處于不利地位。但是,AI愛好者有責任從另一個角度解決這個問題。

必須解決層之間干擾的方法和規則,以解釋每一行代碼和系數所代表的含義。因此必須將黑匣子連根拔起并解剖,以了解是什么使機器滴答作響,這說起來容易做起來難。即使看一下最簡單的神經網絡AI,也足以表明此類系統的原始性。節點和層全部堆疊在一起,各個權重與其他層的權重相互作用。

對于訓練有素的人來說,這看起來像是一筆宏偉的交易,但是對于理解機器卻幾乎沒有解釋。難道僅僅是由于人類和機器語言水平的差異?是否可以采用一種外行可以理解的格式來分解機器語言的邏輯?

偏見的類型

回顧數據分析中偏差的歷史,由于技術不正確或負責分析的實體中預定義的偏差,可能會引入多種偏差。歸因于程序員的某些傾向和興趣,由于模型的定位錯誤,可能會產生錯誤的假設和偏見。

這是某些營銷分析師在處理潛在客戶時常犯的錯誤。收集軟件可提供有關轉化者和未轉化者的大量數據。大多數人可能會傾向于只針對未轉換的潛在客戶建立模型,而不是只關注同時針對兩種人群的模型。這樣一來,他們最終將自己弄瞎了已成為客戶的可用數據的豐富性。

困擾AI模型的另一個問題是無法正確分類或錯誤分類數據,最終導致分析人員陷入災難。在生產行業中,此類錯誤屬于Type I和Type II類別-前者是在對不屬于記錄的記錄進行分類時,后者是在無法對屬于的記錄進行分類時。從生產批次的角度來看,質量控制工程師只需對產品的一小部分進行測試,即可迅速提高產品的準確性。它可以節省時間和金錢,但它可能是發生這種假設偏差的理想環境。

在圖像檢測軟件中觀察到了另一個類似的示例,其中神經網絡掃描圖片的損壞部分以重建邏輯形狀。圖像中對象方向的相似性可能會導致多個問題,這些問題可能導致模型給出令人吃驚的爭議性結果。當前時代的卷積神經網絡能夠分解這種復雜性,但需要大量測試和訓練數據才能得出合理的結果。

某些偏差是由于缺乏正確的數據(使用不必要的甚至是不必要的復雜模型)導致的。通常認為,某些模型和神經網絡編程僅應在達到統計上顯著數量的記錄后才應用于數據集。這也意味著必須將算法設計為可重復地及時檢查數據質量。

與AI對抗AI

AI偏見的問題解決方案是否隱藏在AI本身內?研究人員認為,改進分析人員收集和劃分信息的調整方法非常重要,并且應考慮到并非所有信息都是必需的。

話雖這么說,應該更加強調消除和消除使模型完全不適當的輸入和值。數據審計是另一種可以及時檢查和消除偏差的方法。與任何標準審核程序一樣,此方法涉及徹底清除和檢查已處理數據以及原始輸入數據。審核員跟蹤更改并記下可以對數據進行的改進,并確保數據對所有利益相關者具有完全的透明度。

專門的XAI模型也存在疑問,可以在適當的情況下將其放在問題表中。這些模型涉及非常詳細的參數模型開發,其中記錄了每個步驟和更改,從而使分析人員可以查明可能的問題并觸發實例。

AI也已成為驗證模型的準確性和混淆矩陣的前沿,而不是依靠諸如ROC曲線和AUC曲線之類的簡單工具。這些模型著眼于在部署數據集之前執行重復的質量檢查,并嘗試覆蓋數據的整體類,而不管分布或形狀如何。對于數據集來說,這種預測試的性質變得更加困難,因為數據集的單位和范圍的差異在輸入中有很大差異。同樣,對于與媒體相關的數據,分解內容并將其壓縮為數字格式所花費的時間仍然會導致偏差。

但是,由于數據透明性和第三方檢查的基礎知識有了新的變化,公司至少意識到了出問題了。在模型之間也插入了新的解釋器循環,以強調填充大多數AI模型的黑匣子。這些再次由AI模型驅動,這些AI模型經過系統微調以查找不一致和錯誤。

AI道德失范的幾個案例

數據分析人員會熟悉假陰性和假陽性的概念。這些在確定輸出方面的差異會導致特殊情況的錯誤,從而對人員造成不利影響。錯誤的否定看跌期權是系統錯誤地將肯定的類別識別為否定的情況。類似地,當否定類別被錯誤地識別為肯定時,就會出現假肯定。

在實際的大數據研究中,可以更好地理解此類虛假案件的嚴重性。在使用logistic回歸模型對冠心病(冠心病)進行建模的著名案例中,盡管誤報率和誤報率的準確性很高,但混淆矩陣卻產生了大量。對于普通人來說,準確的模型似乎是唯一重要的“成敗”檢查。但是,即使在數據分析的初期,也很明顯,這樣的模型會變得平淡無奇,甚至會誤診新患者。

通過收集更多的數據流并清洗列以進行更好的數據標準化來進行權衡。如今,這一步驟已成為該行業的主食。

Uber的自動駕駛汽車在測試階段遭受撞車并不是業內專業人員關注的唯一危險信號。這些恐懼也擴展到其他領域,例如識別和機器感知。科技巨頭亞馬遜的模式已經學會發展媒體所謂的對女性的“性別偏見”,因此受到媒體的審查。

在令人震驚的求職者偏見的情況下(先前曾與科技公司的求職者見過),這些模型對女性的應聘工作產生的負面依從性高于男性。另一方面,在諸如Apple之類的科技巨頭中也發現了問題,消費者大肆宣傳FaceID,允許不同的用戶訪問鎖定的手機。可能有人爭辯說,即使對于不同的人,用于識別面部表情以進行檢測的模型也可能會產生相似的結果。

工程師堅持消除錯誤并得出結論認為,可疑輸入會產生假設偏差只是時間問題。由于未能整合道德價值觀,人工智能在醫學界的重大飛躍已經縮回了一個臺階。可以取代旅途中的護士和員工的價值觀。這主要是通過解釋所有可能數量的案例示例來解決的,在這些案例中,機器可以正確地替代人員并做出完全相同的決定。雖然,哲學專業的學生可能會爭辯說,即使人類也沒有遵循一套指導方針。有各種道德學派-康德,平等主義者,功利主義者等。這些思想流派如何適應各種倫理難題,取決于個人及其利益。

在著名的拉桿箱中,一個人拉動或不拉動杠桿的傾向純粹是由該人所處的道德框架決定的。當機器代替決策者時,問責制的問題變得模糊。

最后的話-如何使AI更符合道德

我們對這些系統的容忍度在哪里永恒的問題導致將機器納入我們的日常活動中。人工智能一直是諸如運輸,預測研究,金融投資,安全,通信和生產等救生和支持框架的基礎。它已滲透到人類生活的所有重要方面,而沒有引起很多反對者的注意。

當AI無法嵌入創建它的人類所遵循的哲學時,就劃出了界線。我們與葉夫根尼·扎米亞丁(Yevgeny Zamyatin)和艾倫·圖靈(Alan Turing)時代一樣遙遙領先,當時機器被認為是公正的。通過教導人工智能具有道德性,在機器中煥發出新的生命是一項挑戰,而這一挑戰落到了對人類意味著什么的根本問題上。

我們現在知道,要構建一個完善的道德框架,必須將AI精簡到其基本要點,并需要采用一種強調上下文的方法來強調結果的質量。與工作場所多元化的基本原理一樣,步驟很簡單:

密切注意數據。 保持變化但標準化。 讓團隊不時監視預處理步驟。 在輸出中消除任何形式的排除。 刪除可能對模型錯誤或無用的垃圾值。 優化,審核,共享和重新收集結果,并將其納入模型。 消除交互作用和數據孤島,并始終進行健全性檢查,以最終確定目標是什么。 消除數據孤島,教AI思考而不是建模思考。 保持對Johari意識的關注。涵蓋未知的已知和已知的未知。至于未知的未知數,不幸的是,這種偏見將始終存在。

-

傳感器

+關注

關注

2550文章

51046瀏覽量

753137 -

AI

+關注

關注

87文章

30763瀏覽量

268909 -

機器

+關注

關注

0文章

781瀏覽量

40722

發布評論請先 登錄

相關推薦

如何在Android上構建自定義AI功能

AI大模型的倫理與社會影響

Meta推出可自我評估AI模型

AI如何對產品設計帶來更多的可能性?

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創新》第二章AI for Science的技術支撐學習心得

如何利用AI進行提升自我呢?

干貨 | 電路設計中如何減少ESD?

通過增強一致性訓練,有效緩解CoT中的偏見問題

X2電容的容量減少,可能原因有哪些呢?

NanoEdge AI的技術原理、應用場景及優勢

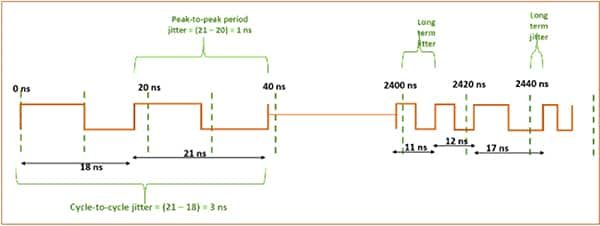

了解并盡量減少抖動對高速鏈路的影響

您可能還會喜歡: AI可以自我警戒并減少偏見嗎?

您可能還會喜歡: AI可以自我警戒并減少偏見嗎?

評論