伴隨著人工智能技術(shù)的飛速發(fā)展,語(yǔ)音識(shí)別、機(jī)器翻譯等各項(xiàng)科技名詞已不是傳統(tǒng)意義上被企業(yè)家束之高閣的前景應(yīng)用,更不是研究人員諱莫如深的復(fù)雜概念,它們已經(jīng)伴隨著大數(shù)據(jù)時(shí)代的來(lái)臨走入了尋常人的身邊。如今的生活中我們無(wú)處不在享受著人工智能技術(shù)帶給我們的便利,從前在科幻電影《星際迷航》中使用的通用翻譯器,已然成為了現(xiàn)在人們出行途中能夠使用的小型翻譯機(jī)。而撥開(kāi)這些實(shí)際應(yīng)用的面紗,它們背后所使用的技術(shù)往往是這些年來(lái)備受關(guān)注的神經(jīng)網(wǎng)絡(luò)模型。

通俗來(lái)講,它是一種對(duì)外部輸入信息進(jìn)行學(xué)習(xí)的數(shù)學(xué)模型或計(jì)算模型。它能夠通過(guò)對(duì)自身內(nèi)部結(jié)構(gòu)的調(diào)整來(lái)擬合輸入數(shù)據(jù),憑借著算法廣泛的通用性,其在語(yǔ)音、圖像、自然語(yǔ)言處理等眾多領(lǐng)域得到了廣泛的應(yīng)用。

電影《星際迷航》里科克船長(zhǎng)和老骨頭所使用的實(shí)時(shí)翻譯設(shè)備

而對(duì)于目前的基于神經(jīng)網(wǎng)絡(luò)技術(shù)的各項(xiàng)任務(wù)而言,主要的過(guò)程依舊是由研究人員手動(dòng)地探索新的網(wǎng)絡(luò)結(jié)構(gòu),比如我們常見(jiàn)的循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent neural network; RNN)、卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network; CNN)等。但這樣做實(shí)際上是一個(gè)非常系統(tǒng)工程的方式,我們把研究人員束縛在崗位上不斷地去“設(shè)計(jì)”所謂的更好的結(jié)構(gòu),而模型的好與壞則往往取決于人對(duì)任務(wù)的理解以及模型設(shè)計(jì)上的想象力,整個(gè)過(guò)程需要研究人員對(duì)相關(guān)領(lǐng)域有著充分的認(rèn)知,間接提高了從業(yè)人員的入門(mén)門(mén)檻,與此同時(shí)通過(guò)人工不斷地對(duì)模型結(jié)構(gòu)進(jìn)行改良也非常耗費(fèi)時(shí)間。

隨著近年來(lái)計(jì)算機(jī)設(shè)備的算力以及存儲(chǔ)能力逐年遞增,人們逐漸開(kāi)始去思考是否我們可以讓計(jì)算機(jī)像學(xué)網(wǎng)絡(luò)參數(shù)一樣學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)模型的結(jié)構(gòu)?希望能通過(guò)這種方式將研究人員從模型結(jié)構(gòu)設(shè)計(jì)者的位置上“解救”出來(lái),于是就有了這樣一個(gè)機(jī)器學(xué)習(xí)領(lǐng)域的研究分支——網(wǎng)絡(luò)結(jié)構(gòu)搜索(Neural Architecture Search; NAS)。

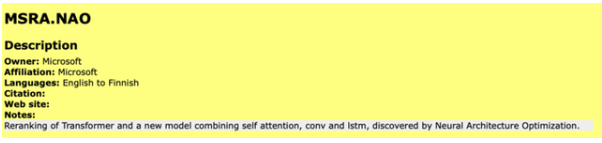

實(shí)際上目前神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)搜索技術(shù)已經(jīng)在各個(gè)領(lǐng)域中嶄露頭角,如谷歌團(tuán)隊(duì)在Searching for Activation Functions【1】論文中通過(guò)對(duì)激活函數(shù)空間進(jìn)行搜索發(fā)現(xiàn)了Swish函數(shù),相對(duì)諸如Relu等傳統(tǒng)人工設(shè)計(jì)的激活函數(shù)具有更快的收斂速度。而微軟團(tuán)隊(duì)在WMT19機(jī)器翻譯評(píng)測(cè)任務(wù)中同樣也采用了其團(tuán)隊(duì)提出的NAO【2】方法來(lái)自動(dòng)地對(duì)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行優(yōu)化,在英語(yǔ)-芬蘭語(yǔ)以及芬蘭語(yǔ)-英語(yǔ)的任務(wù)上均取得了不俗的成績(jī)。

可以看到網(wǎng)絡(luò)結(jié)構(gòu)搜索技術(shù)的使用已經(jīng)為各項(xiàng)任務(wù)中模型結(jié)構(gòu)的設(shè)計(jì)起到非常好的助力,那么其背后究竟使用了怎樣的技術(shù)?如何能夠讓神經(jīng)網(wǎng)絡(luò)自動(dòng)地對(duì)自身結(jié)構(gòu)進(jìn)行改良?雖然目前網(wǎng)絡(luò)結(jié)構(gòu)的搜索技術(shù)依舊方興未艾,但已然存在很多來(lái)自工業(yè)界以及學(xué)術(shù)界的團(tuán)隊(duì)在不斷努力探索更好的方法。

可以預(yù)計(jì)在不遠(yuǎn)的將來(lái),隨著科研人員的努力以及計(jì)算資源的進(jìn)一步提升,網(wǎng)絡(luò)結(jié)構(gòu)搜索的技術(shù)將大幅降低模型結(jié)構(gòu)的更迭所需要的時(shí)間周期,同時(shí)能夠讓研究人員有更多地精力去探索有趣的應(yīng)用或討論神經(jīng)網(wǎng)絡(luò)背后的可解釋性。當(dāng)然在這個(gè)過(guò)程中,我們需要審視這門(mén)技術(shù)的發(fā)展歷史,同時(shí)對(duì)未來(lái)的發(fā)展趨勢(shì)進(jìn)行展望。

微軟團(tuán)隊(duì)在WMT19機(jī)器翻譯評(píng)測(cè)任務(wù)中英語(yǔ)-芬蘭語(yǔ)任務(wù)的提交信息

從“人工”到“自動(dòng)”的突圍

人類對(duì)于自動(dòng)化的追求從未停止,這一點(diǎn)從三次工業(yè)革命的目標(biāo)即可看到端倪,它們無(wú)一不在為了將人們從繁復(fù)的工作中解放出來(lái)不懈努力。而對(duì)于機(jī)器學(xué)習(xí)任務(wù)而言,人們也依舊在不斷地探索,希望能夠讓機(jī)器在無(wú)需人類過(guò)多干預(yù)的情況下,真正地替代人去完成更多的工作,而在這個(gè)過(guò)程中研究人員始終在不斷嘗試,努力做好這次從“人工”到“自動(dòng)”的突圍。

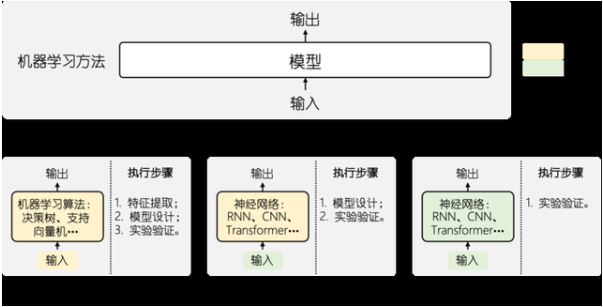

機(jī)器學(xué)習(xí)方法的演化與變遷

傳統(tǒng)機(jī)器學(xué)習(xí)

如果我們將機(jī)器學(xué)習(xí)所處理的任務(wù)建模為一種從輸入到輸出的映射學(xué)習(xí),那么在初代的機(jī)器學(xué)習(xí)算法中,我們不僅需要設(shè)計(jì)一種適用于當(dāng)前任務(wù)的方法(如廣泛使用的決策樹(shù)、支持向量機(jī)等),同時(shí)還要為其提供人工設(shè)計(jì)的特征集合,在完成這些工作之后,才能使用數(shù)據(jù)對(duì)模型中的參數(shù)進(jìn)行調(diào)優(yōu)。

以情感分析為例,我們可以向模型中輸入詞性、詞頻及其情感屬性等信息,然后通過(guò)支持向量機(jī)的模型來(lái)對(duì)情感分析任務(wù)進(jìn)行建模,其中詞性、詞頻以及情感屬性即為我們從句子中提取出的人工設(shè)計(jì)的模型特征,支持向量機(jī)則是我們選擇來(lái)解決當(dāng)前問(wèn)題的機(jī)器學(xué)習(xí)算法。

我們可以看到,不管是輸入的特征還是模型自身,均為研究人員歸納總結(jié)而得,這個(gè)過(guò)程就很容易造成對(duì)有效特征的忽視以及模型設(shè)計(jì)上的不合理,因此基于這種傳統(tǒng)機(jī)器學(xué)習(xí)算法的情感分析任務(wù)在IMDB Movie Reviews【3】集合上的準(zhǔn)確率一般很難超過(guò)92%(如斯坦福大學(xué)的工作Baselines and Bigrams: Simple, Good Sentiment and Topic Classification【4】,通過(guò)使用樸素貝葉斯的方法在IMDB Movie Reviews數(shù)據(jù)集上也僅達(dá)到了91.22%的準(zhǔn)確率)。可以看到在機(jī)器學(xué)習(xí)技術(shù)的初期,整個(gè)系統(tǒng)尚且處于對(duì)“人工”高度依賴的時(shí)代。

隨著深度學(xué)習(xí)技術(shù)的廣泛普及,人們開(kāi)始嘗試將提取特征的過(guò)程交由模型來(lái)自動(dòng)完成,通過(guò)數(shù)據(jù)驅(qū)動(dòng)的方式減少傳統(tǒng)方法中特征遺漏的問(wèn)題。比如說(shuō)對(duì)于圖像處理任務(wù)而言,我們無(wú)需根據(jù)人工經(jīng)驗(yàn)對(duì)圖像中的局部特征進(jìn)行設(shè)計(jì),只需要直接將畫(huà)面完整地送入模型中進(jìn)行訓(xùn)練即可。

下圖中為人臉識(shí)別任務(wù)中不同層的神經(jīng)網(wǎng)絡(luò)對(duì)圖像信息的抽取,我們可以看到在學(xué)習(xí)過(guò)程中底層網(wǎng)絡(luò)主要是對(duì)圖像中局部紋理進(jìn)行捕捉,而隨著層數(shù)的遞增,模型開(kāi)始根據(jù)下層中收集到的紋理信息對(duì)人臉中的局部結(jié)構(gòu)(如眼睛、耳朵等)進(jìn)行建模,而頂層將綜合上述局部特征對(duì)人臉在圖像中的位置進(jìn)行確定,最終達(dá)成人臉識(shí)別的目的。

人臉識(shí)別任務(wù)中不同層對(duì)圖像信息的提取差異

此外,對(duì)于前文提到的情感分析任務(wù)而言,同樣是可以使用深度學(xué)習(xí)的方式對(duì)語(yǔ)言進(jìn)行建模。相對(duì)基于傳統(tǒng)機(jī)器學(xué)習(xí)算法的模型而言,深度學(xué)習(xí)的方式直接接收文本的輸入,將詞匯以高維向量的方式建模為詞嵌入(word embedding)。這種方法利用高維空間對(duì)詞匯中語(yǔ)義信息進(jìn)行捕獲,從而為下一步的情感分析提供了非常充足的信息。

基于深度學(xué)習(xí)的情感分析模型在IMDB Movie Reviews數(shù)據(jù)集上遠(yuǎn)遠(yuǎn)超越了傳統(tǒng)的機(jī)器學(xué)習(xí)方法,在卡內(nèi)基梅隆大學(xué)與谷歌團(tuán)隊(duì)在NIPS 2019上合作發(fā)表的論文XLNet: Generalized Autoregressive Pretraining for Language Understanding【5】中,準(zhǔn)確率達(dá)到了96.8%。

從上述例子中可以看到,深度學(xué)習(xí)技術(shù)在如今的機(jī)器學(xué)習(xí)領(lǐng)域已然達(dá)成諸多優(yōu)異成績(jī),其中非常重要的一個(gè)貢獻(xiàn)在于通過(guò)使用自動(dòng)提取的方式對(duì)初始輸入信息中的有效資訊進(jìn)行捕獲,大幅度降低了手動(dòng)設(shè)計(jì)特征所帶來(lái)的信息折損,為下游任務(wù)提供了更堅(jiān)實(shí)的基礎(chǔ)。

深度學(xué)習(xí)&網(wǎng)絡(luò)結(jié)構(gòu)搜索

深度學(xué)習(xí)技術(shù)的到來(lái)使得原本由人工進(jìn)行的特征提取過(guò)程交由機(jī)器自動(dòng)完成,允許模型根據(jù)自身需求從原始數(shù)據(jù)中進(jìn)行特征的捕獲,通過(guò)這種數(shù)據(jù)驅(qū)動(dòng)的方式有效降低了人工抽取所帶來(lái)的信息丟失風(fēng)險(xiǎn)。但當(dāng)我們回顧整個(gè)深度學(xué)習(xí)系統(tǒng),實(shí)際上其依舊并非我們期望的完全自動(dòng)化的過(guò)程,在模型結(jié)構(gòu)的設(shè)計(jì)上仍然非常依賴行業(yè)專家面向任務(wù)對(duì)模型結(jié)構(gòu)進(jìn)行設(shè)計(jì)。

以機(jī)器翻譯任務(wù)為例,研究人員在模型結(jié)構(gòu)上的探索腳步從未停止,從最初基于RNN【6】對(duì)文本序列進(jìn)行表示發(fā)展到之后注意力機(jī)制【7】的引入,乃至更近一段時(shí)間的基于CNN【8】的翻譯系統(tǒng)以及目前備受關(guān)注的Transformer【9】系統(tǒng),科研人員始終在不斷地針對(duì)任務(wù)進(jìn)行模型結(jié)構(gòu)的設(shè)計(jì)與改良。但有了深度學(xué)習(xí)初期的發(fā)展,研究人員也期望著有朝一日能夠讓模型結(jié)構(gòu)設(shè)計(jì)的過(guò)程同樣不再過(guò)分依賴人工設(shè)計(jì),能夠采用同特征選擇類似的方式自動(dòng)進(jìn)行學(xué)習(xí),因此在深度學(xué)習(xí)方法的基礎(chǔ)上,人們開(kāi)始嘗試網(wǎng)絡(luò)結(jié)構(gòu)搜索的方式來(lái)自動(dòng)得到模型結(jié)構(gòu)。

實(shí)際上網(wǎng)絡(luò)結(jié)構(gòu)搜索的任務(wù)并非起源于近些年,早在上世紀(jì)80年代,斯坦福大學(xué)的Miller, Geoffrey F.等人在Designing Neural Networks using Genetic Algorithms【10】論文中就提出使用進(jìn)化算法對(duì)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行學(xué)習(xí)的方式,在此之后也有很多研究人員沿著該思路進(jìn)行了相關(guān)的探索(如Representation and evolution of neural networks【11】一文對(duì)進(jìn)化算法的編碼格式進(jìn)行改良,J. R. Koza等人在Genetic generation of both the weights and architecture for a neural network【12】中提出要同時(shí)對(duì)網(wǎng)絡(luò)中的結(jié)構(gòu)和參數(shù)進(jìn)行學(xué)習(xí)等)。

但受限于當(dāng)時(shí)計(jì)算資源,針對(duì)神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)搜索的應(yīng)用場(chǎng)景較少,因此這方面的工作并沒(méi)有受到很多研究者的關(guān)注。而隨著近些年來(lái)神經(jīng)網(wǎng)絡(luò)以及深度學(xué)習(xí)的技術(shù)的廣泛應(yīng)用,對(duì)于網(wǎng)絡(luò)結(jié)構(gòu)自學(xué)習(xí)的需求也越來(lái)越大,與此同時(shí)發(fā)展迅猛的半導(dǎo)體技術(shù)也使得設(shè)備的算力、存儲(chǔ)能力大大提升,為網(wǎng)絡(luò)結(jié)構(gòu)搜索任務(wù)提供了必要的支持。

縱觀整個(gè)機(jī)器學(xué)習(xí)算法的發(fā)展過(guò)程,網(wǎng)絡(luò)結(jié)構(gòu)搜索任務(wù)的出現(xiàn)可以看作是歷史的必然。無(wú)論是數(shù)據(jù)資源的累積還是計(jì)算能力的提升,無(wú)一不在催生著數(shù)據(jù)驅(qū)動(dòng)下的網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)。雖然目前的網(wǎng)絡(luò)結(jié)構(gòu)搜索技術(shù)尚且處于比較初級(jí)的階段,其高資源消耗、模型結(jié)構(gòu)不穩(wěn)定等問(wèn)題始終困擾著研究人員,但是其發(fā)展勢(shì)頭迅猛,在圖像、自然語(yǔ)言處理等領(lǐng)域均開(kāi)始嶄露頭角。

可以預(yù)見(jiàn)的是,深度學(xué)習(xí)&網(wǎng)絡(luò)結(jié)構(gòu)搜索的組合將是把研究人員從模型工程的泥淖中救起的稻草,我們也相信網(wǎng)絡(luò)結(jié)構(gòu)搜索技術(shù)會(huì)終將為機(jī)器學(xué)習(xí)完成這場(chǎng)從“人工”到“自動(dòng)”的終局突圍。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4773瀏覽量

100877 -

機(jī)器翻譯

+關(guān)注

關(guān)注

0文章

139瀏覽量

14910 -

自然語(yǔ)言處理

+關(guān)注

關(guān)注

1文章

619瀏覽量

13579

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】2.具身智能機(jī)器人的基礎(chǔ)模塊

一文說(shuō)清楚什么是AI大模型

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】2.具身智能機(jī)器人大模型

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】1.全書(shū)概覽與第一章學(xué)習(xí)

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

【「時(shí)間序列與機(jī)器學(xué)習(xí)」閱讀體驗(yàn)】全書(shū)概覽與時(shí)間序列概述

【《大語(yǔ)言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)篇

【《大語(yǔ)言模型應(yīng)用指南》閱讀體驗(yàn)】+ 俯瞰全書(shū)

多層感知機(jī)模型結(jié)構(gòu)

Al大模型機(jī)器人

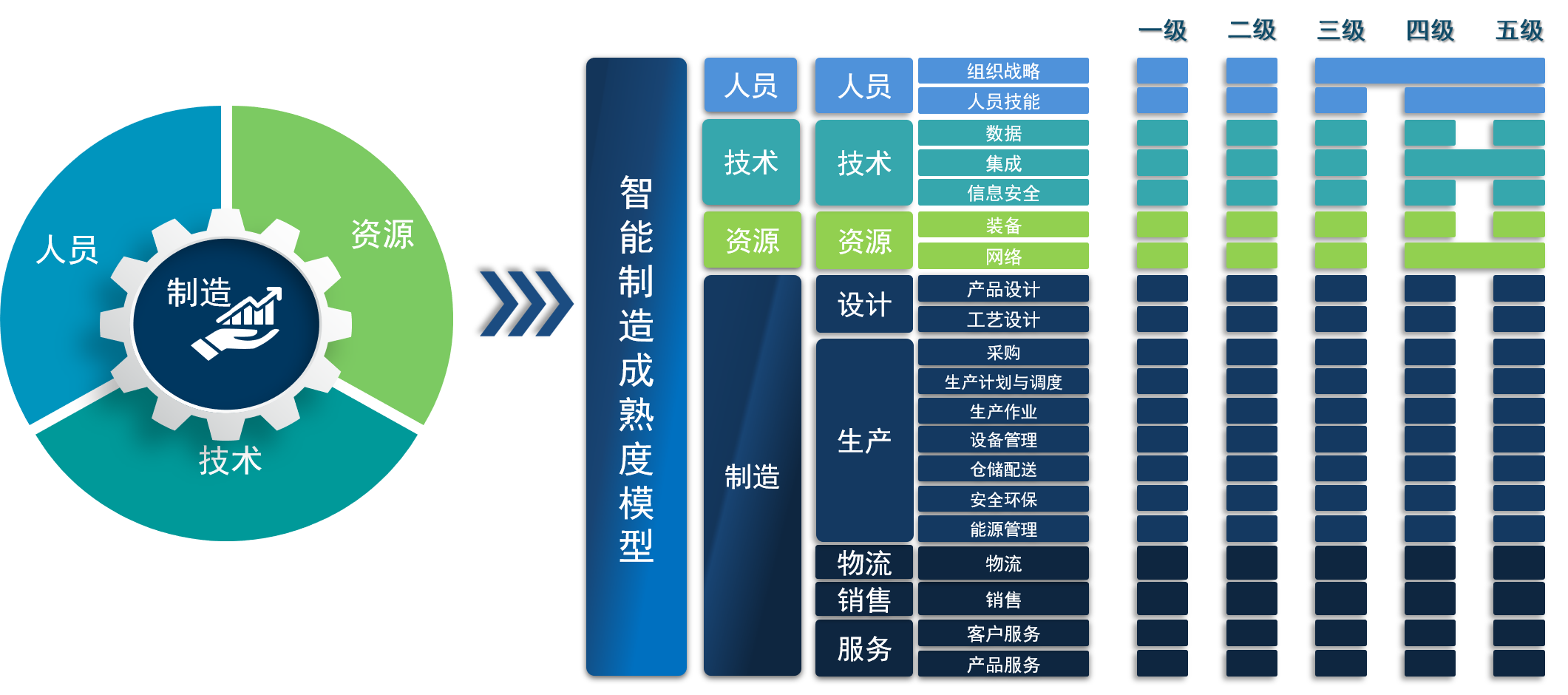

智能制造能力成熟度模型是什么?

賦予機(jī)器自主設(shè)計(jì)模型“能力”,一文概覽結(jié)構(gòu)搜索的起源

賦予機(jī)器自主設(shè)計(jì)模型“能力”,一文概覽結(jié)構(gòu)搜索的起源

評(píng)論