芯片按月甚至年計算的設計周期與AI算法按周甚至按天迭代的周期之前的矛盾越來越明顯,為了能夠保證設計出的芯片能夠更好地滿足快速迭代的算法,Gooogle團隊將AI強化學習方法應用于芯片設計中復雜的“布局”工作當中,獲得了顯著的效果提升。而兩大EDA巨頭Synopsys和Cadence也推出了具有AI功能的工具。看來,AI應用于AI芯片的趨勢已經顯現。

如今許多人在大量的資金支持下通過大量的工作來開發新的AI芯片,這些芯片的目的是更快和更高效地執行AI算法。但問題在于,芯片的設計通常需要花費一兩年甚至三五年時間,并且機器學習(ML)算法的發展速度非常快,這么長的芯片設計周期難以滿足算法更新的需求。

理想情況下,你設計出的芯片是能夠很好地滿足當今AI算法的需求,而不是兩到五年前的AI算法。而Google的解決方案是——讓AI設計AI芯片。

Arxiv網站上的一篇論文的作者寫道:“我們相信,AI將能夠縮短芯片的設計周期,在硬件與AI算法之間建立共生關系,并進一步推動彼此的進步。”。

“我們已經看到,有些算法或神經網絡架構在現有的AI加速器上效果不佳,因為加速器設計類似于兩年前,而那時這些神經網絡架構和算法并不存在。” Google的高級研究科學家Azalia Mirhoseini表示,“如果縮短設計周期,我們可以縮小差距。”

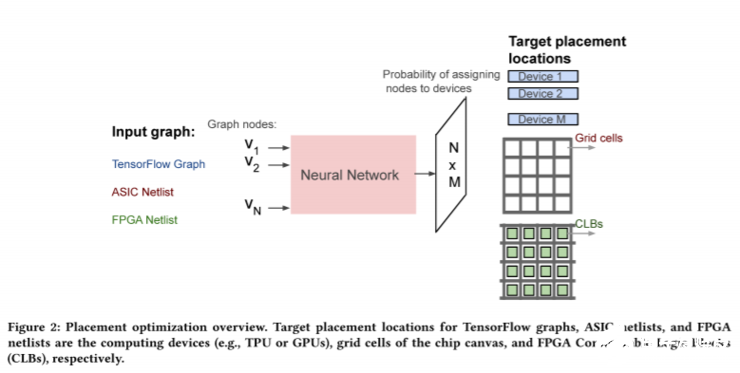

Mirhoseini和高級軟件工程師Anna Goldie提出了一個神經網絡,可以學習并設計一些需要耗費大量時間的部分,這個工作被稱作“布局”。在對芯片設計進行了足夠長時間的學習之后,它可以在不到24小時的時間內為Google Tensor處理單元完成設計,在功耗、性能、面積(PPA)都超過了人類專家數周的設計成果。

布局之所以如此復雜且耗時,是因為它涉及到布局邏輯和內存塊,或這些塊的群集(也稱為宏),要達到芯片功耗和性能最大化,而芯片面積最小。這當中面臨的挑戰是,必須在遵守互連密度規則的同時進行所有這些工作。

Goldie和Mirhoseini的目標之所以在芯片的布局,是因為即使使用當今的先進的設計工具,也需要人類專家花費數周的時間迭代才能得出可接受的設計。

Goldie和Mirhoseini將芯片布局建模為強化學習問題。與典型的深度學習不同,強化學習系統不會使用大量標記的數據進行訓練。相反,他們會邊做邊學,并在成功時根據有效信號調整網絡中的參數。在這種情況下,有效是降低功率、改善性能和減少面積組合的替代指標。

結果就是,布局機器人執行的設計越多,其效果就會越好。

該團隊希望像他們一樣的AI系統能引領,在相同時間內設計更多的芯片,并且運行速度更快、功耗更低、制造成本更低、芯片的面積更小的設計。

除了谷歌,兩大EDA巨頭也開始在其芯片設計工具中加入AI。Synopsys推出的是用于芯片設計的自主AI應用程序——DSO.ai(Design Space Optimization AI)。DSO.ai通過獲取由芯片設計工具生成的大數據流,并用其來探索搜索空間、觀察設計隨時間的演變情況,同時調整設計選擇、技術參數和工作流程,以指導探索過程向多維優化的目標發展。

Cadence也推出了新版Cadence數字全流程,這一新版的流程采用了支持機器學習(ML)功能的統一布局布線和物理優化引擎等多項業界首創技術,吞吐量最高提升3倍,PPA最高提升20%。

總的來說,兩大EDA公司加入AI的芯片設計工具可以縮短芯片的設計時間高達10倍,芯片PPA提升20%。

-

谷歌

+關注

關注

27文章

6161瀏覽量

105300 -

AI

+關注

關注

87文章

30728瀏覽量

268886

發布評論請先 登錄

相關推薦

AI開發平臺可以干什么

AI數據中心的能源危機,需要更高效的PSU

Google AI技術助力中國品牌出海增長

谷歌Vertex AI助力企業生成式AI應用

risc-v多核芯片在AI方面的應用

搭載星火認知大模型的AI鼠標:一鍵呼出AI助手,辦公更高效

NanoEdge AI的技術原理、應用場景及優勢

Google讓AI設計AI芯片更快更高效

Google讓AI設計AI芯片更快更高效

評論