我們研究視頻到視頻的合成問題,其目的是學習從輸入源視頻(例如,一系列語義分割掩碼)到精確描述源視頻內容的輸出真實感視頻的映射功能。

雖然它的圖像對應物(圖像到圖像合成問題)是一個受歡迎的話題,但是視頻到視頻合成問題在文獻中很少探討。在不了解時間動態的情況下,將現有的圖像合成方法直接應用于輸入視頻通常會導致視覺質量低下的時間不連貫視頻。

在本文中,我們提出了一種在生成對抗性學習框架下的新穎的視頻合成方法。通過精心設計的生成器和鑒別器架構以及時空對抗目標,我們可以通過多種輸入格式(包括分割蒙版,草圖和姿勢)獲得高分辨率,逼真的,時間上連貫的視頻結果。在多個基準上進行的實驗表明,與強基準相比,我們的方法具有優勢。

尤其是,我們的模型能夠合成長達30秒的街道場景的2K分辨率視頻,從而大大提高了視頻合成的最新水平。最后,我們將我們的方法應用于未來的視頻預測,其性能超過了幾個最先進的競爭系統。

我們的模型能夠合成長達30秒的街道場景的2K分辨率視頻,從而大大提高了視頻合成的最新水平。最后,我們將我們的方法應用于未來的視頻預測,其性能超過了幾個最先進的競爭系統。

我們的模型能夠合成長達30秒的街道場景的2K分辨率視頻,從而大大提高了視頻合成的最新水平。最后,我們將我們的方法應用于未來的視頻預測,其性能超過了幾個最先進的競爭系統。

-

視頻

+關注

關注

6文章

1942瀏覽量

72887 -

圖像

+關注

關注

2文章

1084瀏覽量

40451 -

鑒別器

+關注

關注

0文章

8瀏覽量

8758

發布評論請先 登錄

相關推薦

PWM信號生成方法 PWM調制原理講解

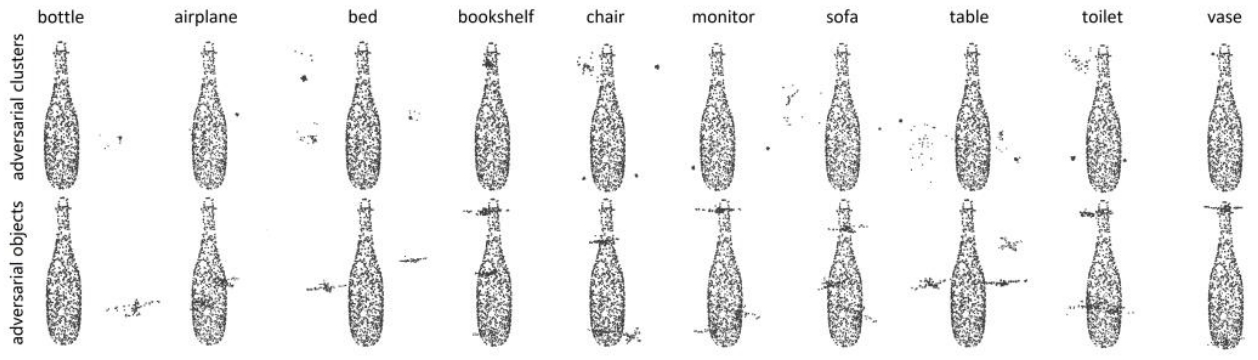

鑒源實驗室·如何通過雷達攻擊自動駕駛汽車-針對點云識別模型的對抗性攻擊的科普

視頻時鐘合成芯片怎么用

altium designer原理圖生成方法

微液滴生成方法及發展趨勢

生成對抗網絡(GANs)的原理與應用案例

深度學習中的無監督學習方法綜述

如何用C++創建簡單的生成式AI模型

ESP32-S3-KROVO2如何在ADF框架下實現wifi連接?

阿里云視頻生成技術創新!視頻生成使用了哪些AI技術和算法

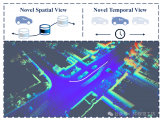

LiDAR4D:基于時空新穎的LiDAR視角合成框架

檢索增強生成(RAG)如何助力企業為各種企業用例創建高質量的內容?

深度學習生成對抗網絡(GAN)全解析

一種在生成對抗性學習框架下的新穎的視頻合成方法

一種在生成對抗性學習框架下的新穎的視頻合成方法

評論