通過與弗吉尼亞大學的研究人員合作,Salesforce 提出了有助于減輕 AI 性別偏見的新方法。 通常情況下,研究人員需要為 AI 模型投喂許多單次來展開訓練,但其中不可避免地會摻雜一些或隱性、或顯性的性別偏見。 然后在執行語言翻譯或其它預測任務的時候,這些 AI 也會沾染上一些不良習性。

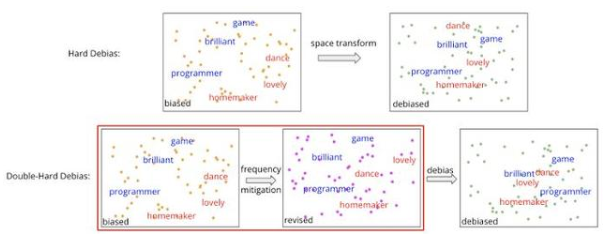

雙硬去偏器示意

有鑒于此,研究團隊嘗試糾正某些規律性,比如大數據集中的單詞頻率,以使 AI 在推理前對嵌入的內容進行“純化”,拋棄那些帶有性別歧視的詞匯。

這套方案可以捕獲單詞的語義、句法、以及同其它單詞的關系,此前已被許多自然語言處理(NLP)方案所采用,但因不可避免的性別偏見而遭到批評。

先前補救方案是在后處理過程中引入幾個步驟,以剔除與性別歧視相關的成分,但有效性受到了較大的限制,比如在去偏見操作后又被復原了。

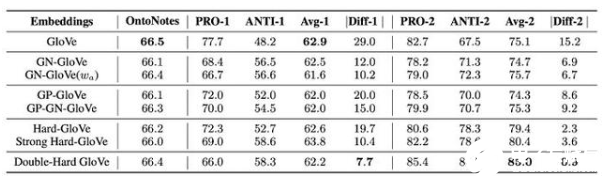

雙硬去偏器基準測試成績

為此,Salesforce 提出了名叫“雙硬去偏”(Double-Hard Debias)的新方案,以將嵌入空間轉換為表面上無性別的子空間。

然后在執行另一次消除偏見的操作之前,它會沿著這個維度去“投射”性別成分,以獲取修改后的嵌入內容。為評估效果,研究人員針對 WinoBias 數據集開展了測試。

該數據集由贊成性別定型和反對性別定型的句子組成,性能差距反映了算法系統是如何在兩個句子組上執行、并導致“性別偏見”的得分。

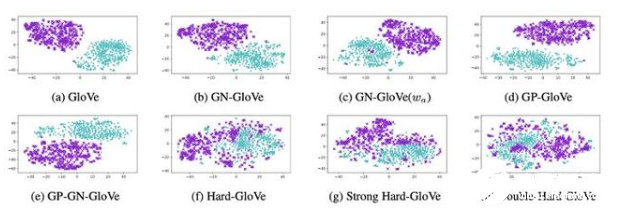

tSNE 嵌入投影

結果顯示,在保留語義信息的同時,雙硬去偏方案將使用 GloVe 算法獲得的嵌入偏差得分,從 15 分砍半到了 7.7 分。此外在對嵌入進行建模的可視化(tSNE 投影)上,它也較其它方案的混合更加均勻。

即便如此,一些專家仍認為無法從詞嵌入中完全消除偏見。比如慕尼黑工業大學的最近一項研究,就表明“沒有天然中性的文本”。因為單詞的語義內容,是始終與社會環境聯系在一起的。

-

AI

+關注

關注

87文章

31097瀏覽量

269432 -

模型

+關注

關注

1文章

3261瀏覽量

48914 -

大數據

+關注

關注

64文章

8896瀏覽量

137517

發布評論請先 登錄

相關推薦

Salesforce解決方案

AI大模型的倫理與社會影響

AI產業革命的演進路徑與未來展望

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創新》第二章AI for Science的技術支撐學習心得

《AI for Science:人工智能驅動科學創新》第一章人工智能驅動的科學創新學習心得

當前主流的大模型對于底層推理芯片提出了哪些挑戰

人工智能ai4s試讀申請

平衡創新與倫理:AI時代的隱私保護和算法公平

通過增強一致性訓練,有效緩解CoT中的偏見問題

AI可能帶有性別偏見?Salesforce提出了減輕AI性別偏見的方法

AI可能帶有性別偏見?Salesforce提出了減輕AI性別偏見的方法

評論