什么是神經(jīng)網(wǎng)絡(luò)激活函數(shù)?

激活函數(shù)有助于決定我們是否需要激活神經(jīng)元。如果我們需要發(fā)射一個(gè)神經(jīng)元那么信號(hào)的強(qiáng)度是多少。

激活函數(shù)是神經(jīng)元通過(guò)神經(jīng)網(wǎng)絡(luò)處理和傳遞信息的機(jī)制

為什么在神經(jīng)網(wǎng)絡(luò)中需要一個(gè)激活函數(shù)?

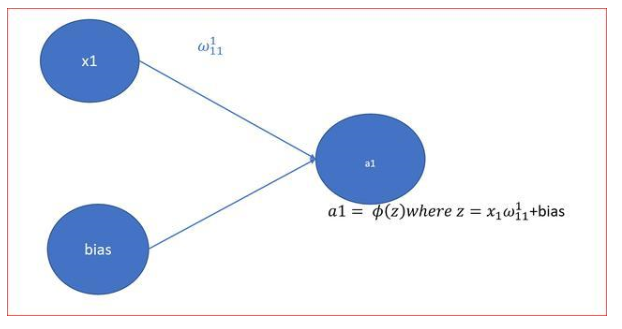

在神經(jīng)網(wǎng)絡(luò)中,z是輸入節(jié)點(diǎn)與節(jié)點(diǎn)權(quán)值加上偏差的乘積。z的方程與線性方程非常相似,取值范圍從+∞到-∞

如果神經(jīng)元的值可以從負(fù)無(wú)窮到正無(wú)窮變化,那么我們就無(wú)法決定是否需要激活神經(jīng)元。這就是激活函數(shù)幫助我們解決問(wèn)題的地方。

如果z是線性的,那么我們就不能解決復(fù)雜的問(wèn)題。這是我們使用激活函數(shù)的另一個(gè)原因。

有以下不同類型的激活函數(shù)

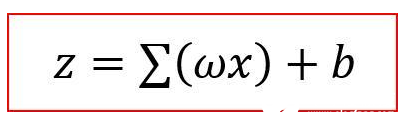

閥值函數(shù)或階梯激活函數(shù)

Sigmoid

Softmax

Tanh或雙曲正切

ReLU

Leaky ReLU

為什么我們需要這么多不同的激活函數(shù),我怎么決定用哪一個(gè)呢?

讓我們回顧一下每一個(gè)激活函數(shù),并了解它們的最佳使用位置和原因。這將幫助我們決定在不同的場(chǎng)景中使用哪個(gè)激活函數(shù)。

閥值函數(shù)或階梯激活函數(shù)

這是最簡(jiǎn)單的函數(shù)

如果z值高于閾值,則激活設(shè)置為1或yes,神經(jīng)元將被激活。

如果z值低于閾值,則激活設(shè)置為0或no,神經(jīng)元不會(huì)被激活。

它們對(duì)二分類很有用。】

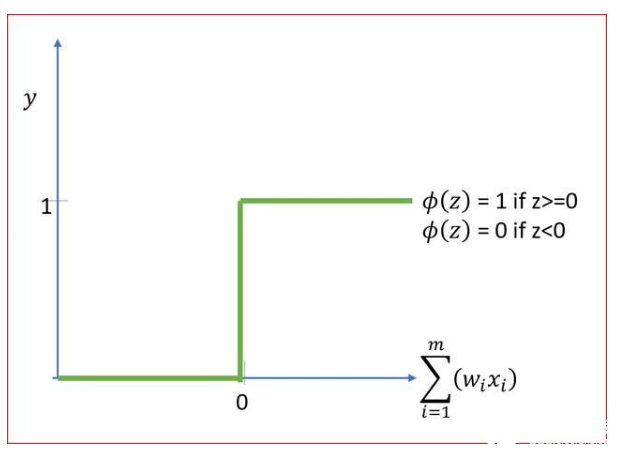

Sigmoid激活函數(shù)

Sigmoid函數(shù)是一種光滑的非線性函數(shù),無(wú)扭結(jié),形狀類似于S形。

它預(yù)測(cè)輸出的概率,因此被用于神經(jīng)網(wǎng)絡(luò)和邏輯回歸的輸出層。

由于概率范圍在0到1之間,所以sigmoid函數(shù)值存在于0到1之間。

但是如果我們想分類更多的是或不是呢?如果我想預(yù)測(cè)多個(gè)類,比如預(yù)測(cè)晴天、雨天或陰天,該怎么辦?

Softmax激活有助于多類分類

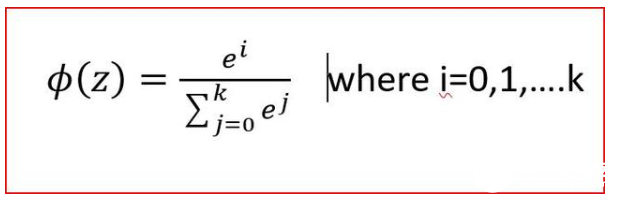

Softmax激活函數(shù)

Sigmoid激活函數(shù)用于兩類或二類分類,而softmax用于多類分類,是對(duì)Sigmoid函數(shù)的一種推廣。

在softmax中,我們得到了每個(gè)類的概率,它們的和應(yīng)該等于1。當(dāng)一個(gè)類的概率增大時(shí),其他類的概率減小,因此概率最大的類是輸出類。

例如:在預(yù)測(cè)天氣時(shí),我們可以得到輸出概率,晴天為0.68,陰天為0.22,雨天為0.20。在這種情況下,我們以最大概率的輸出作為最終的輸出。在這種情況下我們預(yù)測(cè)明天將是晴天。

Softmax計(jì)算每個(gè)目標(biāo)類的概率除以所有可能的目標(biāo)類的概率。

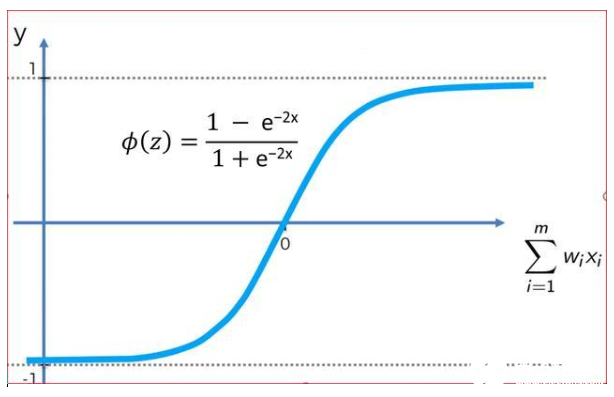

雙曲正切或Tanh激活函數(shù)

對(duì)于雙曲tanh函數(shù),輸出以0為中心,輸出范圍在-1和+1之間。

看起來(lái)很像Sigmoid。實(shí)際上雙曲tanh是縮放的s形函數(shù)。與Sigmoid相比,tanh的梯度下降作用更強(qiáng),因此比Sigmoid更受歡迎。

tanh的優(yōu)點(diǎn)是,負(fù)輸入將被映射為強(qiáng)負(fù),零輸入將被映射為接近零,這在sigmoid中是不會(huì)發(fā)生的,因?yàn)閟igmoid的范圍在0到1之間

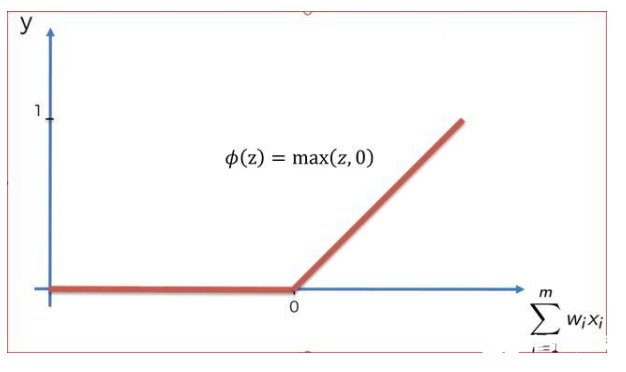

ReLU

ReLU本質(zhì)上是非線性的,這意味著它的斜率不是常數(shù)。Relu在0附近是非線性的,但斜率不是0就是1,因此具有有限的非線性。

范圍是從0到∞

當(dāng)z為正時(shí),ReLU的輸出與輸入相同。當(dāng)z為0或小于0時(shí),輸出為0。因此,當(dāng)輸入為0或低于0時(shí),ReLU會(huì)關(guān)閉神經(jīng)元。

所有的深度學(xué)習(xí)模型都使用Relu,但由于Relu的稀疏性,只能用于隱含層。稀疏性指的是空值或“NA”值的數(shù)量。

當(dāng)隱層暴露于一定范圍的輸入值時(shí),RELU函數(shù)將導(dǎo)致更多的零,從而導(dǎo)致更少的神經(jīng)元被激活,這將意味著更少的神經(jīng)網(wǎng)絡(luò)交互作用。

ReLU比sigmoid或tanh更積極地打開(kāi)或關(guān)閉神經(jīng)元

Relu的挑戰(zhàn)在于,負(fù)值變?yōu)榱憬档土四P驼_訓(xùn)練數(shù)據(jù)的能力。為了解決這個(gè)問(wèn)題,我們有Leaky ReLU

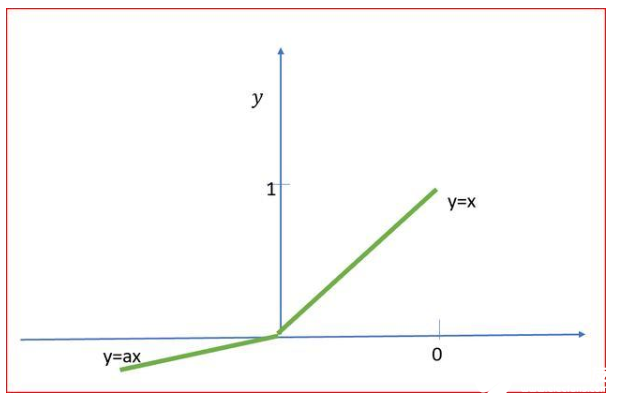

Leaky ReLU

a的值通常是0.01

在Leaky ReLU中,我們引入了一個(gè)小的負(fù)斜率,所以它的斜率不是0。這有助于加快訓(xùn)練。

Leaky ReLU的范圍從-∞到+∞

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4789瀏覽量

101598 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4353瀏覽量

63296 -

神經(jīng)元

+關(guān)注

關(guān)注

1文章

368瀏覽量

18560

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

圖文詳解:神經(jīng)網(wǎng)絡(luò)的激活函數(shù)

圖文詳解:神經(jīng)網(wǎng)絡(luò)的激活函數(shù)

評(píng)論