SoC設計與應用技術領導廠商Socionext Inc.(以下“Socionext”,或“公司”)宣布,聯合大阪大學數據能力科學研究所長原教授研究小組共同開發新型深度學習算法,該算法無需制作龐大的數據集,只需通過融合多個模型便可在極度弱光的條件下進行精準檢測物體及圖像識別。Socionext笹川幸宏先生和大阪大學長原教授在8月23日至28日(英國夏令時間)舉辦的歐洲計算機視覺國際會議(ECCV 2020)上報告了這一研究成果。

近年來盡管計算機視覺技術取得了飛速發展,但在低照度環境下車載攝像頭、安防系統等獲取的圖像質量仍不理想,圖像辨識性能較差。不斷提升低照度環境下圖像識別性能依舊是目前計算機視覺技術面臨的主要課題之一。CVPR2018中一篇名為《Learning to See in the Dark》[1]的論文曾介紹過利用圖像傳感器的RAW圖像數據的深度學習算法,但這種算法需要制作超過200,000張圖像和150多萬個批注 [2]數據集才能進行端到端學習,既費時又費錢,難以實現商業化落地(如下圖1)。

圖1:《Learning to See in the Dark》及RAW 圖像識別課題

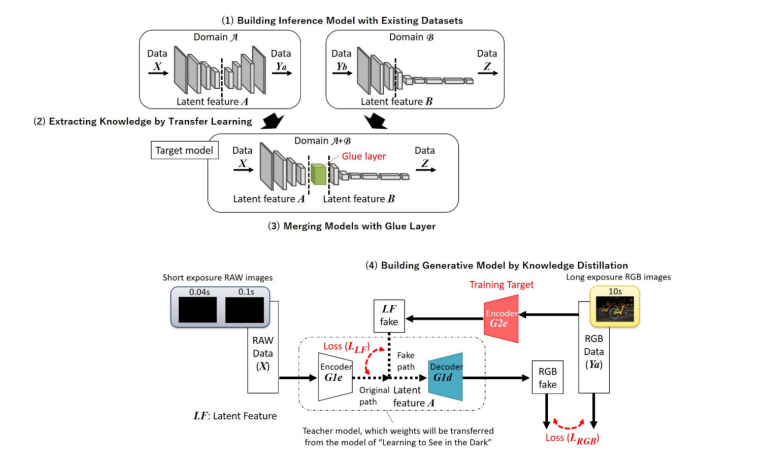

為解決上述課題,Socionext與大阪大學聯合研究團隊通過遷移學習(Transfer Learning)和知識蒸餾(Knowledge Distillation)等機器學習方法,提出采用領域自適應(Domain Adaptation)的學習方法,即利用現有數據集來提升目標域模型的性能,具體內容如下(如圖2):

(1)使用現有數據集構建推理模型;

(2)通過遷移學習從上述推理模型中提取知識;

(3)利用Glue layer合并模型;

(4)通過知識蒸餾建立并生成模型。

圖2:本次開發的領域適應方法(Domain Adaptation Method)

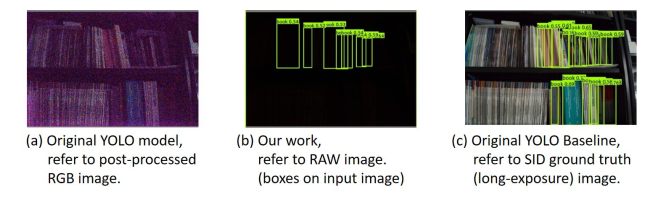

此外,結合領域自適應方法和物體檢測YOLO模型[3],并利用在極端弱光條件下拍攝的RAW圖像還可構建“YOLO in the Dark”檢測模型。YOLO in the Dark模型可僅通過現有數據集實現對RAW圖像的對象檢測模型的學習。針對那些通過使用現有YOLO模型,校正圖像亮度后仍無法檢測到圖像的(如下圖a),則可以通過直接識別RAW圖像確認到物體被正常檢測(如下圖b)。同時測試結果發現,YOLO in the Dark模型識別處理時所需的處理量約為常規模型組合(如下圖c)的一半左右。

圖3:《YOLO in the Dark》效果圖

本次利用領域自適應法所開發的“直接識別RAW圖像”可不僅應用于極端黑暗條件下的物體檢測,還可應用于車載攝像頭、安防系統和工業等多個領域。未來,Socionext還計劃將該技術整合到公司自主研發的圖像信號處理器(ISP)中開發下一代SoC,并基于此類SoC開發全新攝像系統,進一步提升公司產品性能,助力產業再升級。

歐洲計算機視覺國際會議(ECCV 2020)

日期:8月23~28日(英國夏令時間)

地點:線上會議

演講主題:YOLO in the Dark - Domain Adaptation Method for Merging Multiple Models -

演講人:Socionext Inc. 笹川幸宏先生

大阪大學 長原教授

鏈接:https://eccv2020.eu/

注釋:

[1]“Learning to See in the Dark” : CVPR2018, Chen et al.

[2] MS COCO dataset as an example (https://cocodataset.org/)

[3] YOLO (You Only Look Once): One of the deep learning object detection methods

關于Socionext

Socionext Inc.是一家全球性創新型企業,其業務內容涉及片上系統(System-on-chip)的設計、研發和銷售。公司專注于以消費、汽車和工業領域為核心的世界先進技術,不斷推動當今多樣化應用發展。Socionext集世界一流的專業知識、經驗和豐富的IP產品組合,致力于為客戶提供高效益的解決方案和客戶體驗。公司成立于2015年,總部設在日本橫濱,并在日本、亞洲、美國和歐洲設有辦事處,領導其產品開發和銷售。

-

深度學習

+關注

關注

73文章

5557瀏覽量

122550 -

Socionext

+關注

關注

2文章

75瀏覽量

16885

發布評論請先 登錄

摩爾線程與當虹科技達成深度合作

瑞芯微電子與BlackBerry QNX合作開發汽車數字座艙平臺

NPU在深度學習中的應用

一種基于深度學習的二維拉曼光譜算法

評論