前言

基于Redis使用分布式鎖在當今已經不是什么新鮮事了。本篇文章主要是基于我們實際項目中因為redis分布式鎖造成的事故分析及解決方案。

背景:我們項目中的搶購訂單采用的是分布式鎖來解決的。有一次,運營做了一個飛天茅臺的搶購活動,庫存100瓶,但是卻超賣了!要知道,這個地球上飛天茅臺的稀缺性啊!!!事故定為P0級重大事故...只能坦然接受。整個項目組被扣績效了~~事故發生后,CTO指名點姓讓我帶頭沖鋒來處理,好吧,沖~

事故現場

經過一番了解后,得知這個搶購活動接口以前從來沒有出現過這種情況,但是這次為什么會超賣呢?

原因在于:之前的搶購商品都不是什么稀缺性商品,而這次活動居然是飛天茅臺,通過埋點數據分析,各項數據基本都是成倍增長,活動熱烈程度可想而知!話不多說,直接上核心代碼,機密部分做了偽代碼處理。。。

publicSeckillActivityRequestVOseckillHandle(SeckillActivityRequestVOrequest){ SeckillActivityRequestVOresponse; Stringkey="key:"+request.getSeckillId; try{ BooleanlockFlag=redisTemplate.opsForValue().setIfAbsent(key,"val",10,TimeUnit.SECONDS); if(lockFlag){ //HTTP請求用戶服務進行用戶相關的校驗 //用戶活動校驗 //庫存校驗 Objectstock=redisTemplate.opsForHash().get(key+":info","stock"); assertstock!=null; if(Integer.parseInt(stock.toString())<=?0)?{ ????????????????//?業務異常 ????????????}?else?{ ????????????????redisTemplate.opsForHash().increment(key+":info",?"stock",?-1); ????????????????//?生成訂單 ????????????????//?發布訂單創建成功事件 ????????????????//?構建響應VO ????????????} ????????} ????}?finally?{ ????????//?釋放鎖 ????????stringRedisTemplate.delete("key"); ????????//?構建響應VO ????} ????return?response; }

以上代碼,通過分布式鎖過期時間有效期10s來保障業務邏輯有足夠的執行時間;采用try-finally語句塊保證鎖一定會及時釋放。業務代碼內部也對庫存進行了校驗。看起來很安全啊~ 別急,繼續分析。。。

事故原因

飛天茅臺搶購活動吸引了大量新用戶下載注冊我們的APP,其中,不乏很多羊毛黨,采用專業的手段來注冊新用戶來薅羊毛和刷單。

當然我們的用戶系統提前做好了防備,接入阿里云人機驗證、三要素認證以及自研的風控系統等各種十八般武藝,擋住了大量的非法用戶。此處不禁點個贊~

「但也正因如此,讓用戶服務一直處于較高的運行負載中。」

搶購活動開始的一瞬間,大量的用戶校驗請求打到了用戶服務。導致用戶服務網關出現了短暫的響應延遲,有些請求的響應時長超過了10s,但由于HTTP請求的響應超時我們設置的是30s,這就導致接口一直阻塞在用戶校驗那里,10s后,分布式鎖已經失效了,此時有新的請求進來是可以拿到鎖的,也就是說鎖被覆蓋了。

這些阻塞的接口執行完之后,又會執行釋放鎖的邏輯,這就把其他線程的鎖釋放了,導致新的請求也可以競爭到鎖~這真是一個極其惡劣的循環。

這個時候只能依賴庫存校驗,但是偏偏庫存校驗不是非原子性的,采用的是get and compare的方式,超賣的悲劇就這樣發生了~~~

事故分析

仔細分析下來,可以發現,這個搶購接口在高并發場景下,是有嚴重的安全隱患的,主要集中在三個地方:

「沒有其他系統風險容錯處理」由于用戶服務吃緊,網關響應延遲,但沒有任何應對方式,這是超賣的導火索。

「看似安全的分布式鎖其實一點都不安全」雖然采用了set key value [EX seconds] [PX milliseconds] [NX|XX]的方式,但是如果線程A執行的時間較長沒有來得及釋放,鎖就過期了,此時線程B是可以獲取到鎖的。當線程A執行完成之后,釋放鎖,實際上就把線程B的鎖釋放掉了。這個時候,線程C又是可以獲取到鎖的,而此時如果線程B執行完釋放鎖實際上就是釋放的線程C設置的鎖。這是超賣的直接原因。

「非原子性的庫存校驗」非原子性的庫存校驗導致在并發場景下,庫存校驗的結果不準確。這是超賣的根本原因。

通過以上分析,問題的根本原因在于庫存校驗嚴重依賴了分布式鎖。因為在分布式鎖正常set、del的情況下,庫存校驗是沒有問題的。但是,當分布式鎖不安全可靠的時候,庫存校驗就沒有用了。

解決方案

知道了原因之后,我們就可以對癥下藥了。

實現相對安全的分布式鎖

相對安全的定義:set、del是一一映射的,不會出現把其他現成的鎖del的情況。從實際情況的角度來看,即使能做到set、del一一映射,也無法保障業務的絕對安全。

因為鎖的過期時間始終是有界的,除非不設置過期時間或者把過期時間設置的很長,但這樣做也會帶來其他問題。故沒有意義。

要想實現相對安全的分布式鎖,必須依賴key的value值。在釋放鎖的時候,通過value值的唯一性來保證不會勿刪。我們基于LUA腳本實現原子性的get and compare,如下:

publicvoidsafedUnLock(Stringkey,Stringval){ StringluaScript="localin=ARGV[1]localcurr=redis.call('get',KEYS[1])ifin==currthenredis.call('del',KEYS[1])endreturn'OK'""; RedisScript

我們通過LUA腳本來實現安全地解鎖。

實現安全的庫存校驗

如果我們對于并發有比較深入的了解的話,會發現想 get and compare/ read and save 等操作,都是非原子性的。

如果要實現原子性,我們也可以借助LUA腳本來實現。但就我們這個例子中,由于搶購活動一單只能下1瓶,因此可以不用基于LUA腳本實現而是基于redis本身的原子性。原因在于:

//redis會返回操作之后的結果,這個過程是原子性的 LongcurrStock=redisTemplate.opsForHash().increment("key","stock",-1);

發現沒有,代碼中的庫存校驗完全是“畫蛇添足”。

改進之后的代碼

經過以上的分析之后,我們決定新建一個DistributedLocker類專門用于處理分布式鎖。

publicSeckillActivityRequestVOseckillHandle(SeckillActivityRequestVOrequest){ SeckillActivityRequestVOresponse; Stringkey="key:"+request.getSeckillId(); Stringval=UUID.randomUUID().toString(); try{ BooleanlockFlag=distributedLocker.lock(key,val,10,TimeUnit.SECONDS); if(!lockFlag){ //業務異常 } //用戶活動校驗 //庫存校驗,基于redis本身的原子性來保證 LongcurrStock=stringRedisTemplate.opsForHash().increment(key+":info","stock",-1); if(currStock

深度思考

分布式鎖有必要么

改進之后,其實可以發現,我們借助于redis本身的原子性扣減庫存,也是可以保證不會超賣的。對的。但是如果沒有這一層鎖的話,那么所有請求進來都會走一遍業務邏輯,由于依賴了其他系統,此時就會造成對其他系統的壓力增大。這會增加的性能損耗和服務不穩定性,得不償失。基于分布式鎖可以在一定程度上攔截一些流量。

分布式鎖的選型

有人提出用RedLock來實現分布式鎖。RedLock的可靠性更高,但其代價是犧牲一定的性能。在本場景,這點可靠性的提升遠不如性能的提升帶來的性價比高。如果對于可靠性極高要求的場景,則可以采用RedLock來實現。

再次思考分布式鎖有必要么

由于bug需要緊急修復上線,因此我們將其優化并在測試環境進行了壓測之后,就立馬熱部署上線了。實際證明,這個優化是成功的,性能方面略微提升了一些,并在分布式鎖失效的情況下,沒有出現超賣的情況。

然而,還有沒有優化空間呢?有的!

由于服務是集群部署,我們可以將庫存均攤到集群中的每個服務器上,通過廣播通知到集群的各個服務器。網關層基于用戶ID做hash算法來決定請求到哪一臺服務器。這樣就可以基于應用緩存來實現庫存的扣減和判斷。性能又進一步提升了!

//通過消息提前初始化好,借助ConcurrentHashMap實現高效線程安全 privatestaticConcurrentHashMap

通過以上的改造,我們就完全不需要依賴redis了。性能和安全性兩方面都能進一步得到提升!

當然,此方案沒有考慮到機器的動態擴容、縮容等復雜場景,如果還要考慮這些話,則不如直接考慮分布式鎖的解決方案。

總結

稀缺商品超賣絕對是重大事故。如果超賣數量多的話,甚至會給平臺帶來非常嚴重的經營影響和社會影響。經過本次事故,讓我意識到對于項目中的任何一行代碼都不能掉以輕心,否則在某些場景下,這些正常工作的代碼就會變成致命殺手!對于一個開發者而言,則設計開發方案時,一定要將方案考慮周全。怎樣才能將方案考慮周全?唯有持續不斷地學習!

-

代碼

+關注

關注

30文章

4813瀏覽量

68844 -

線程

+關注

關注

0文章

505瀏覽量

19716 -

Redis

+關注

關注

0文章

376瀏覽量

10902

原文標題:一次由 Redis 分布式鎖造成的重大事故

文章出處:【微信號:DBDevs,微信公眾號:數據分析與開發】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

分布式云化數據庫有哪些類型

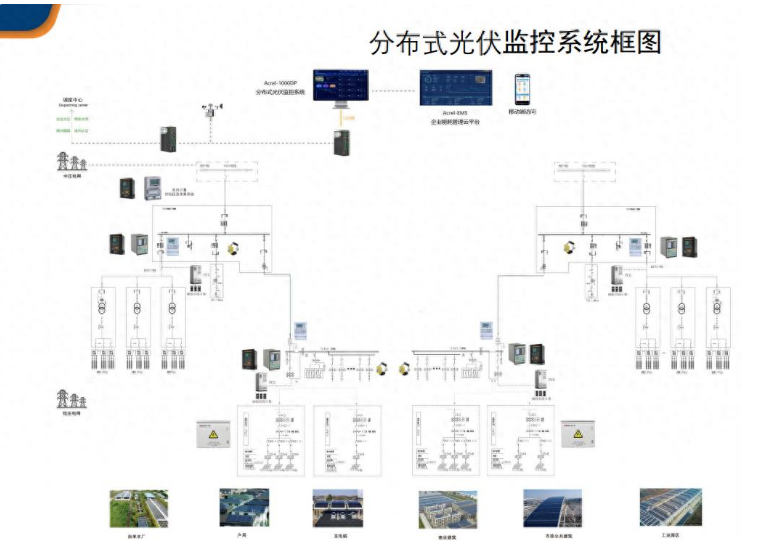

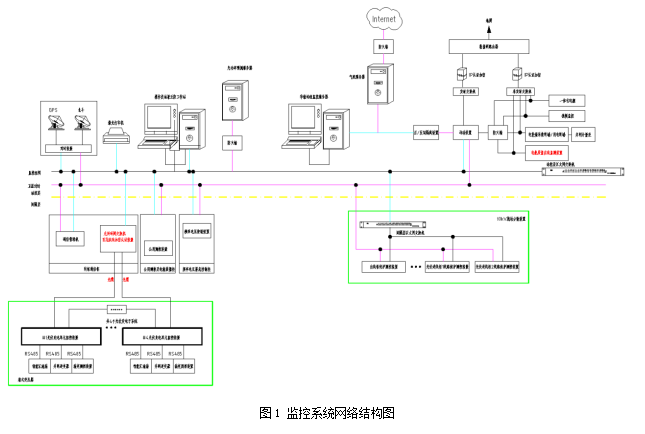

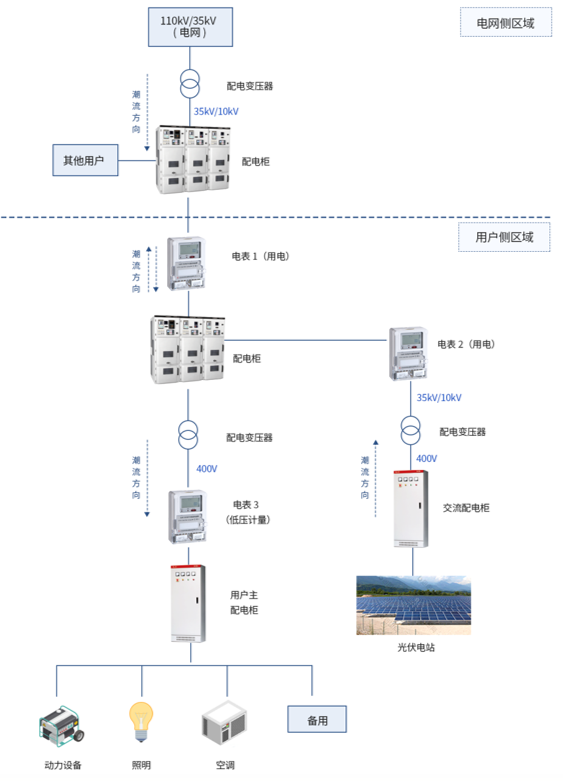

分布式光伏監控系統在能源領域中的重要性

昊衡科技推出分布式光纖傳感教學解決方案——OFDR技術首次走進課堂,實現領域創新

華為分布式存儲連續三年榮膺2024年Gartner“客戶之選”

分布式光伏監控系統解決方案

分布式智慧終端在水利工程建設中的實時監控解決方案

分布式光伏電力監控系統解決方案

分布式存儲與計算:大數據時代的解決方案

Redis實現分布式多規則限流的方式介紹

redis分布式鎖造成的事故分析及解決方案

redis分布式鎖造成的事故分析及解決方案

評論