不知道大家在平時使用時有沒有發(fā)現,BERT的上下文嵌入非常『昂貴』,并且可能無法在所有情況下帶來價值。分享一篇ACL2020的論文,介紹了一些思路。

論文:Contextual Embeddings: When Are They Worth It?

代碼:https://github.com/HazyResearch/random_embedding

寫在前面

諸如BERT或其改進后代之類的SOTA模型,使用起來十分"昂貴"。僅僅是預訓練的『BERT-base』模型(用今天的標準幾乎可以認為是很小的模型),也需要在16個TPU芯片上花費了超過4天的時間,而這需要花費數千美元。這甚至都沒有考慮對模型進行進一步的微調或最終使用,這兩者都只會增加最終的總成本。

與其嘗試找出創(chuàng)建更小的Transformer模型的方法(如何修剪BERT達到加速目的?理論與實現),不如退后一步去問:「基于Transformer模型的上下文嵌入何時真正值得使用?」在什么情況下,使用GloVe或甚至是隨機嵌入等計算成本較低的非上下文嵌入(non-contextual embeddings ),可能達到類似的性能?

這些是Arora等人提出的一些問題,而答案就在他們的研究中:Contextual Embeddings: When Are They Worth It[1]?本文將概述他們的研究并重點介紹他們的主要發(fā)現。

研究內容

該研究分為兩個部分,首先檢查訓練數據量的影響,然后檢查這些數據集的語言特性。

訓練數據大小

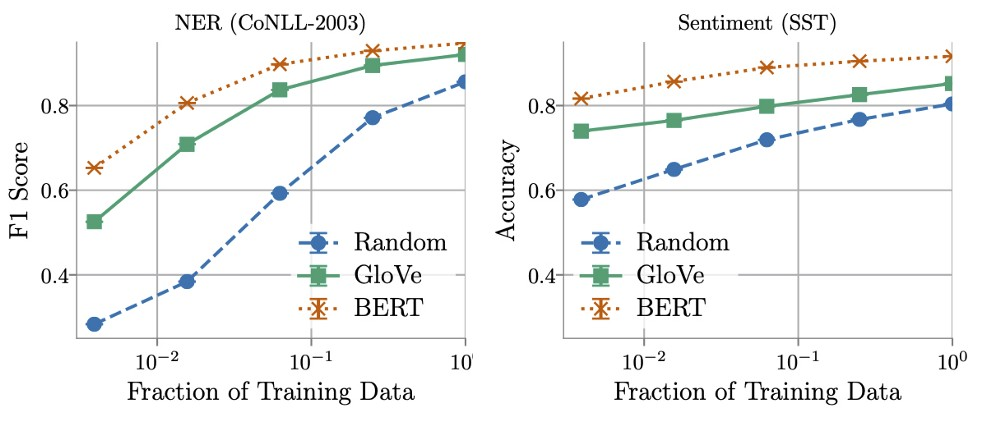

作者發(fā)現,在決定BERT-embedding和Glove-embedding的效果性能方面,訓練數據量起著關鍵作用。通過使用更多的訓練數據,非上下文嵌入很快得到了改善,并且在使用所有可用數據時,通常能夠在BERT模型用時的5-10%之內完成。

另一方面,作者發(fā)現在某些情況下,可以用少于16倍的數據來訓練上下文化嵌入,同時仍然與非上下文化嵌入所獲得的最佳性能相當。這就需要在推理(計算和內存)和標記數據的成本之間進行了權衡,或者如Arora等人所說:

ML practitioners may find that for certain real-world tasks the large gains in efficiency [when using non-contextual embeddings] are well worth the cost of labelling more data. ——— Arora et al

數據集的語言特性

對訓練數據量的研究表明,在某些任務中,上下文嵌入比非上下文嵌入的表現要好得多,而在其他情況下,這些差異要小得多。這些結果激發(fā)了作者們的思考,是否有可能找到并量化語言特性,以表明這種情況何時發(fā)生。

為此,他們定義了三個度量標準,用于量化每個數據集的特征。根據設計,這些度量沒有給出一個單一的定義,而是用來編碼哪些特征影響模型性能的直覺。這使得我們可以對它們進行解釋,然后對它們進行嚴格的定義,以用于我們研究的任務。因此,下面以命名實體識別數據集舉例作者提出的指標:

文本結構的復雜性:表示一個句子中詞與詞之間的依賴性。在NER中表現為每個實體跨越的token數量,如“George Washington”橫跨兩個token。

詞義模糊:每個token在訓練數據集中分配的不同標簽的數量,如“Washington”可以指定人員、地點和組織,這需要考慮到它的背景。

未出現詞的流行度:表示在訓練過程出現從未見過詞的概率。在NER中定義為token出現次數的倒數。

這些指標被用來給數據集中的每一項打分,以便我們將它們分成“困難”和“容易”。這使得我們能夠比較來自同一數據集的這兩個分區(qū)的嵌入性能。

如果這些指標是非信息性的,那么這兩個分區(qū)的性能差異將是相等的。幸運的是,作者們發(fā)現并非如此。相反,他們觀察到,在42個案例中,有30個案例,上下文嵌入和非上下文嵌入之間的差異在困難分區(qū)?上高于簡單分區(qū)。

這意味著,這些指標可以作為一個代理,來自BERT之類模型的上下文嵌入將優(yōu)于非上下文嵌入!然而,從另一個角度來看,它可能更有用——用于指示來自glove的非上下文嵌入何時足以達到最先進的性能。

結論

在研究Contextual Embeddings: When Are They Worth It? 中,Arora等人強調了數據集的關鍵特征,這些特征指示上下文嵌入何時值得使用。首先,訓練數據集大小決定了非上下文化嵌入的潛在有用性,即越多越好。其次,數據集的特征也起著重要作用。作者定義了三個指標,即文本結構的復雜性,詞匯使用的模糊性,以及未出現詞的流行度,這有助于我們理解使用上下文嵌入可能帶來的潛在好處。

-

模型

+關注

關注

1文章

3226瀏覽量

48809 -

數據集

+關注

關注

4文章

1208瀏覽量

24689 -

文本

+關注

關注

0文章

118瀏覽量

17082 -

Transformer

+關注

關注

0文章

143瀏覽量

5995

原文標題:ACL2020 | 什么時候值得用BERT上下文嵌入

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

為什么transformer性能這么好?Transformer的上下文學習能力是哪來的?

基于Transformer模型的上下文嵌入何時真正值得使用?

基于Transformer模型的上下文嵌入何時真正值得使用?

評論