一、背景與意義

當(dāng)前隨著人工智能理論和技術(shù)的日益成熟,應(yīng)用范圍不斷擴(kuò)大,目前已廣泛應(yīng)用于計算機(jī)科學(xué)、金融貿(mào)易、醫(yī)藥、診斷、重工業(yè)、運(yùn)輸、遠(yuǎn)程通訊、在線和電話服務(wù)、法律、科學(xué)發(fā)現(xiàn)、玩具和游戲、音樂等諸多方面。

算力作為承載人工智能應(yīng)用的平臺和基礎(chǔ),其發(fā)展推動了整個人工智能系統(tǒng)的進(jìn)步和快速演進(jìn),是人工智能最核心的要素之一。以人工智能應(yīng)用為主要任務(wù)的,面向智能計算的處理器的相關(guān)設(shè)計方法與技術(shù)已成為國內(nèi)外工業(yè)界和學(xué)術(shù)界共同角逐的熱點(diǎn),國內(nèi)外企業(yè)紛紛布局AI芯片。

AI芯片的應(yīng)用場景不再局限于云端,部署于智能手機(jī)、安防攝像頭、及自動駕駛汽車等終端的各項(xiàng)產(chǎn)品日趨豐富。除了追求性能提升外,AI芯片也逐漸專注于特殊場景的優(yōu)化。

為了進(jìn)一步促進(jìn)供需對接,為AI芯片供應(yīng)商和需求商提供交流的平臺,中國人工智能產(chǎn)業(yè)發(fā)展聯(lián)盟(以下簡稱“AIIA”或聯(lián)盟)計算架構(gòu)與芯片推進(jìn)組啟動“AI芯片技術(shù)選型目錄”(以下簡稱“選型目錄”)的工作,希望為AI芯片的可持續(xù)發(fā)展,服務(wù)和促進(jìn)相關(guān)產(chǎn)業(yè)發(fā)展壯大貢獻(xiàn)一份力量。

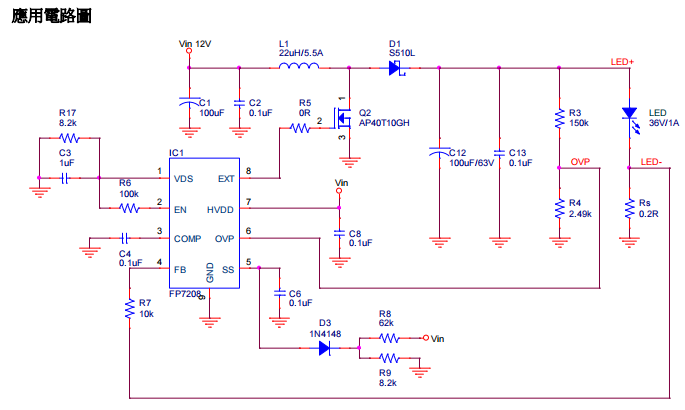

人工智能芯片按照目前的應(yīng)用場景來看,主要分為訓(xùn)練和推斷兩類場景,按部署位置又可分為云端、邊緣和終端。AIIA“AI芯片技術(shù)選型目錄”具體根據(jù)應(yīng)用場景與部署位置,包含云端訓(xùn)練、基于云端、邊緣和終端推斷的四大產(chǎn)品形態(tài)。又依據(jù)行業(yè)應(yīng)用,AI芯片技術(shù)選型目錄根據(jù)垂直應(yīng)用場景如圖3所示給出。

AI芯片根據(jù)行業(yè)應(yīng)用分類圖

二、云端訓(xùn)練

技術(shù)概述

百度昆侖1芯片面向AI通用計算,基于百度XPU架構(gòu),既可以用于訓(xùn)練,也可以用于推理,能全面支持語音,圖像,自然語言處理等應(yīng)用。

技術(shù)指標(biāo)百度昆侖1芯片基于百度XPU架構(gòu),采用三星14nm工藝,HBM2和PCIE4.0等技術(shù),給用戶提供高性能、高帶寬、低功耗、高靈活性、高度可編程等優(yōu)勢。

產(chǎn)品信息

應(yīng)用案例

百度ERNIE模型,應(yīng)用于翻譯、搜索排序等場景。百度網(wǎng)盤里的圖像模型;百度云主機(jī);百度云的工業(yè)質(zhì)檢客戶。

產(chǎn)品特征/技術(shù)特點(diǎn)

1.高性能,峰值256Tops;

2.高帶寬,片外內(nèi)存帶寬512GB/s;

3.高度可編程性,能提供C/C++的編程,用戶可以自由開發(fā)自己的算子。

技術(shù)概述

邃思芯片集成神經(jīng)元處理器架構(gòu)和數(shù)據(jù)處理引擎,通過可編程的通用張量/向量運(yùn)算核心,支持各類數(shù)據(jù)精度的主流深度學(xué)習(xí)訓(xùn)練負(fù)載。

技術(shù)指標(biāo)

邃思芯片采用12nmFinFET工藝,2.5D封裝,總計141億個晶體管。其宣稱單芯片提供20TFLOPS@FP32及80TFLOPS@BF16/FP16的算力,最大功耗190W。

邃思芯片主要技術(shù)特點(diǎn)包括:自主指令集的神經(jīng)元處理器(SIP),可編程的通用張量/向量運(yùn)算核心,支持張量/向量/標(biāo)量計算;神經(jīng)元處理集群(SIC),由8個神經(jīng)元處理器構(gòu)成,4MB共享集群緩存;自主研發(fā)2.5D封裝,集成16GBHBM存儲,提供512GB/s帶寬;自主ESL(燧原智能互聯(lián),Enflame SmartLink)片間互聯(lián)引擎,每通道雙向50GB/s,4通道總共200GB/s接口帶寬,通道延時小于1μs;系統(tǒng)穩(wěn)定性控制,支持服務(wù)器級別RAS需求。支持CNN、RNN、LSTM、BERT等網(wǎng)絡(luò)模型

產(chǎn)品信息

產(chǎn)品特征/技術(shù)特點(diǎn)

云燧T10是基于邃思芯片打造的人工智能訓(xùn)練加速卡,20TFLOPS@FP32,最大功耗225W,支持FP32/FP16/BF16/INT8/INT16/INT32等多種數(shù)據(jù)類型;支持PCIe4.0接口,提供64GB帶寬以及200GB/s片間互聯(lián)帶寬;

計算和編程平臺主要包含分布式調(diào)度、軟件開發(fā)包(SDK)和設(shè)備驅(qū)動層,用戶可以將已有訓(xùn)練系統(tǒng),無縫遷移至邃思平臺上運(yùn)行,無需二次開發(fā)或者模型轉(zhuǎn)換工作。

云燧T10人工智能訓(xùn)練加速卡面向云端數(shù)據(jù)中心,可廣泛應(yīng)用于互聯(lián)網(wǎng)、金融、教育、醫(yī)療、工業(yè)及政務(wù)等人工智能訓(xùn)練場景。

NVIDIA-NVIDIAA100/V100/T4Tensor Core GPUs

技術(shù)概述

為數(shù)據(jù)中心GPU,可加快AI、高性能計算(HPC)和圖形技術(shù)的發(fā)展。

技術(shù)指標(biāo)

NVIDIA Ampere GPU架構(gòu)配備540億個晶體管,為7納米芯片架構(gòu),集訓(xùn)練和推理于一身,具有多實(shí)例GPU、TF32、結(jié)構(gòu)化稀疏等特性。

NVIDIAVolta GPU架構(gòu)配備640個Tensor內(nèi)核,可提供每秒超過100萬億次(TFLOPS)的深度學(xué)習(xí)性能,是上一代NVIDIA Pascal架構(gòu)的5倍以上。NVIDIA Turing GPU架構(gòu)支持實(shí)時光線追蹤、AI、模擬和光柵化技術(shù)。

應(yīng)用案例

利用NVIDIAA100/V100/T4GPU可以更快速地處理要求最嚴(yán)格的高性能計算(HPC)和超大規(guī)模數(shù)據(jù)中心工作負(fù)載。現(xiàn)在,數(shù)據(jù)科學(xué)家和研究人員可以在能源勘探和深度學(xué)習(xí)等應(yīng)用場合中解析PB級的數(shù)據(jù),速度比使用傳統(tǒng)CPU快幾個數(shù)量級。NVIDIA A100/V100/T4加速器可以超快速度運(yùn)行更大型的模擬。此外,NVIDIA GPU還能為虛擬桌面、應(yīng)用程序和工作站提供超高性能和用戶密度。

產(chǎn)品特征/技術(shù)特點(diǎn)

NVIDIA A100采用了NVIDIA Ampere架構(gòu)的突破性設(shè)計,集AI訓(xùn)練和推理于一身,宣稱其性能相比于前代產(chǎn)品提升了20倍。作為一款通用型工作負(fù)載加速器,A100還被設(shè)計用于數(shù)據(jù)分析、科學(xué)計算和云圖形。NVIDIAT4GPU推理加速器搭載NVIDIATuringTensorCore,提供多精度推理性能,以加速人工智能的各種應(yīng)用。

產(chǎn)品信息

賽靈思–Alveo

技術(shù)概述

賽靈思AlveoTM數(shù)據(jù)中心加速器卡專為現(xiàn)代數(shù)據(jù)中心多樣的應(yīng)用需求而設(shè)計。Alveo加速器卡可通過對加速資源的重新配置,適應(yīng)持續(xù)算法優(yōu)化,在降低總成本的同時,靈活支持各類工作負(fù)載。

賽靈思推出的Vitis統(tǒng)一軟件平臺為各類軟件和AI推理應(yīng)用開發(fā)提供統(tǒng)一編程模型,幫助用戶加速實(shí)現(xiàn)從C/C++、Python、Caffe、Tensor flow到差異化應(yīng)用落地的開發(fā)過程。

技術(shù)指標(biāo)

賽靈思Alveo數(shù)據(jù)中心加速器卡基于Xilinx 16nm Ultra Scale架構(gòu),使用賽靈思堆疊硅片互聯(lián)(SSI)技術(shù)來實(shí)現(xiàn)FPGA容量、帶寬和功耗效率,通過結(jié)合多個超邏輯區(qū)域(SLR)來增大密度。

Alveo加速卡旨在加速服務(wù)器或工作站中的機(jī)器學(xué)習(xí)、數(shù)據(jù)分析和視頻處理等計算密集型應(yīng)用。Alveo U50卡采用XCU50 FPGA包括2個SLR,配備PCIe Gen4和8G HBM2,每秒100G網(wǎng)絡(luò)連接,以高效能75瓦、小尺寸形式為金融計算、機(jī)器學(xué)習(xí)、計算存儲以及數(shù)據(jù)搜索與分析工作負(fù)載提供優(yōu)化加速。

AlveoU200卡采用XCU200FPGA包括3個SLR,AlveoU250卡使用XCU250FPGA包括4個SLR。二者均可連接到PCIExpress的16個通道,最高運(yùn)行速度8GT/s(Gen3),也可以連接到4根DDR4 16GB 2400MT/s64位含糾錯碼(ECC)的DIMM,總計64GB的DDR4。

AlveoU200卡采用XCU200FPGA包括3個SLR,AlveoU250卡使用XCU250FPGA包括4個SLR。二者均可連接到PCIExpress的16個通道,最高運(yùn)行速度8GT/s(Gen3),也可以連接到4根DDR4 16GB 2400MT/s64位含糾錯碼(ECC)的DIMM,總計64GB的DDR4。

應(yīng)用案例

Alveo加速卡已經(jīng)開發(fā)和認(rèn)證的關(guān)鍵應(yīng)用涵蓋AI/ML、視頻轉(zhuǎn)碼、數(shù)據(jù)分析、金融風(fēng)險建模、安全和基因組學(xué)等。Algo-Logic SystemsInc、Bigstream、Black LynxInc.、CTAccel、Falcon Computing、Maxeler Technologies、Mipsology、NGCodec、Skreens、Sum Up Analytics、Titan IC、Vitesse Data、VYUsync和Xelera Technologies等合作伙伴開發(fā)完成的應(yīng)用已經(jīng)投入部署。此外,DellEMC、Fujitsu Limited和IBM等頂級OEM廠商也在同賽靈思合作,認(rèn)證采用Alveo加速器卡的多個服務(wù)器SKU。

Alveo-Mipsology,Zebra搭載Alveo

U50數(shù)據(jù)中心加速卡用于神經(jīng)網(wǎng)絡(luò)推理,板卡功耗75W,關(guān)鍵功能:快速卷積神經(jīng)網(wǎng)絡(luò)(CNN)推理——Zebra設(shè)立了新的性能標(biāo)準(zhǔn);支持所有神經(jīng)網(wǎng)絡(luò)——Zebra可加速任何CNN的所有層級;易于使用——Zebra是“即插即用”的解決方案,無需對神經(jīng)網(wǎng)絡(luò)進(jìn)行修改或再訓(xùn)練;不改變軟件環(huán)境——無新語言、框架或工具。Zebra在TensorFlow、PyTorch、ONNX、Caffe和MXNet模型內(nèi)運(yùn)行;可擴(kuò)展性、靈活性和適應(yīng)性——Zebra可替代GPU或在任何位置補(bǔ)充CPU。

Alveo-SK電訊基于人工智能的實(shí)時物理入侵和盜竊檢測服務(wù),基于賽靈思Alveo U250加速器卡,可提供充足的吞吐量與精準(zhǔn)度

產(chǎn)品特征/技術(shù)特點(diǎn)

AlveoU50數(shù)據(jù)中心加速器卡采用賽靈思UltraScale+架構(gòu),使用半高半長的外形尺寸和低于75瓦的低包絡(luò)功耗。該卡支持第四代PCIe及高帶寬存儲器(HBM2),每秒100G網(wǎng)絡(luò)連接,面向各種類型的服務(wù)器部署。

AlveoU50加速器卡產(chǎn)品詳細(xì)介紹:

通過PCIe3.3V電源供電線提供的HBM2功耗僅限為10W。使用HBM2可實(shí)現(xiàn)的性能受限于此功耗限制,并且因設(shè)計而異。HBM2的額定帶寬為201GB/s。在不兼容PCIe的規(guī)格中,針對A-U50DD-P00G-ES3-G和A-U50-P00G-PQ-G卡測得的HBM2帶寬峰值為316GB/s。

AlveoU200和U250數(shù)據(jù)中心加速器卡采用PCIeGen3x16,設(shè)計用于加速高計算強(qiáng)度應(yīng)用,如機(jī)器學(xué)習(xí)、數(shù)據(jù)分析和視頻處理。

AlveoU280數(shù)據(jù)中心加速器卡專為計算和存儲工作負(fù)載而設(shè)計,擁有8GBHBM2+32GB DDR4內(nèi)存、1.1MLUT、8.5kDSP片、每秒100G雙網(wǎng)絡(luò)連接,并支持第四代PCIe和CCIX互聯(lián)標(biāo)準(zhǔn)。

AlveoU280加速器卡產(chǎn)品詳細(xì)介紹:

產(chǎn)品信息

科寒武紀(jì)科技股份有限公司-寒武紀(jì)思元100

技術(shù)概述

為云端推理提供運(yùn)算能力支撐

技術(shù)指標(biāo)

INT8算力32TOPS,內(nèi)置硬件編解碼引擎

應(yīng)用案例

產(chǎn)品信息

產(chǎn)品特征/技術(shù)特點(diǎn)

1.通用智能,支持計算機(jī)視覺、語音識別、自然語言處理等多模態(tài)智能處理;

2.針對深度學(xué)習(xí)定制的指令集和處理器架構(gòu),具有更優(yōu)的能效比;

3.完善軟件開發(fā)環(huán)境NeuWare,包括應(yīng)用開發(fā)、功能調(diào)試、性能調(diào)優(yōu)等。

中科寒武紀(jì)科技股份有限公司-寒武紀(jì)思元270

為高能效比AI推理設(shè)計的數(shù)據(jù)中心級PCIe智能加速卡。

技術(shù)指標(biāo)

支持多種精度,比上一代加速芯片計算能力提高4倍,INT8算力128TOPS。

應(yīng)用案例

廣泛支持視覺、語音、自然語言處理以及傳統(tǒng)機(jī)器學(xué)習(xí)等高度多樣化的人工智能應(yīng)用,幫助AI推理平臺實(shí)現(xiàn)高能效比。

產(chǎn)品特征/技術(shù)特點(diǎn)

1.支持INT16、INT8、INT4、FP32、FP16多種精度;2.內(nèi)置視頻和圖片編解碼器,有效降低CPU前處理負(fù)載和PCIe帶寬占用;3.計算彈性,支持多類神經(jīng)網(wǎng)絡(luò),寒武紀(jì)Neuware軟件棧部署推理環(huán)境;4.可編程,基于Bang語言編程環(huán)境可對計算資源定制,滿足多樣化需求。

產(chǎn)品信息

北京比特大陸科技有限公司-比特大陸算豐TPU芯片BM1684

技術(shù)概述

BM1684是比特大陸面向深度學(xué)習(xí)領(lǐng)域自主研發(fā)的第三代張量處理器(TPU),是聚焦視頻圖像分析的云端及邊緣的人工智能推理芯片。

技術(shù)指標(biāo)

芯片:BM1684聚焦視頻圖像分析,是云端及邊緣的人工智能推理芯片;AI算力:17.6TOPSINT8,Winograd卷積加速下最高可達(dá)35.2TOPS,實(shí)測推理性能較上一代提升約5倍以上;AI架構(gòu):本芯片基于自主研發(fā)的TPU架構(gòu);典型功耗:16W;視頻解碼:支持H264/H265解碼,最大分辨率8192x8192,支持4K/8K。H264和H265解碼都支持32路高清30FPS@1080P,可處理數(shù)十路視頻智能分析全流程;

應(yīng)用案例

北京海淀城市大腦中的AI計算推理,百度大腦Paddle TPU計算集群,處理千路級別的高清視頻結(jié)構(gòu)化。福州長樂區(qū)的AI算力中心TPU計算集群,處理上千路的高清視頻結(jié)構(gòu)化、人臉識別等。福州城市大腦的AI計算推理TPU計算集群,處理千路級別的高清視頻結(jié)構(gòu)化。

優(yōu)必達(dá)(Ubitus)的互聯(lián)網(wǎng)云端游戲AI加速TPU加速游戲中的圖像特征提取,畫面增強(qiáng),超分辨率等。

產(chǎn)品特征/技術(shù)特點(diǎn)

BM1684芯片技術(shù)特點(diǎn)是:

1)TPU芯片架構(gòu)自主研發(fā),相關(guān)專利申請達(dá)到270項(xiàng)以上;

2)性能功耗比高,在16W情況下,最高可達(dá)到35.2T性能(Winograd加速);

3)視頻解碼路數(shù)多,支持32路H264和H265高清30FPS@1080P硬解碼;

4)視頻全流程處理能力強(qiáng),可達(dá)到16~32路典型視頻結(jié)構(gòu)化/人臉分析路數(shù);

5)AI工具鏈完備,Caffe,Tensorflow,PyTorch,MXNet,PaddlePaddle都支持;

6)部署場景靈活,云端和邊緣均可部署;

7)使用靈活,可工作于PCIE從設(shè)備模式或者SOC主設(shè)備模式;

板卡產(chǎn)品特色:

1)75W半高半長PCIE小卡,峰值算力105.6T,無需外接供電;

2)宣稱其性能趕上并部分超越英偉達(dá)推理GPUT4;

3)視頻解碼路數(shù)多,96路高清視頻30FPS解碼;

模組產(chǎn)品特色:

1)AI邊緣計算模組,17.6T/35.2T;

2)視頻解碼支持32路H264和H265高清30FPS@1080P硬解碼;

3)視頻全流程處理可達(dá)到16~32路典型視頻結(jié)構(gòu)化/人臉分析;

盒子產(chǎn)品特色:

1)AI邊緣計算盒子,17.6T/35.2T;

2)視頻全流程處理能力可達(dá)到16~32路典型視頻結(jié)構(gòu)化/人臉分析;

3)可室外部署,無風(fēng)扇散熱,-20℃至

+60℃寬溫;

232等;

產(chǎn)品信息

深圳鯤云信息科技有限公司-星空x3加速卡

技術(shù)概述

星空X3加速卡為鯤云推出的面向邊緣端和數(shù)據(jù)中心進(jìn)行深度學(xué)習(xí)推斷的AI計算加速卡,搭載鯤云自研的定制數(shù)據(jù)流CAISA芯片,采用無指令集的架構(gòu)方式,為支持深度學(xué)習(xí)的邊緣和數(shù)據(jù)中心服務(wù)器提供計算加速方案。

技術(shù)指標(biāo)

支持ResNet、VGG、YOLO等多個主流

CNN算法模型提供Rain Builder編譯工具鏈,支持端到端算法開發(fā)和部署支持Tensor Flow、Caffe、PyTorch及ONNX(MXNet)等主流深度學(xué)習(xí)框架開發(fā)的算法模型其宣稱芯片利用率可達(dá)95.4%

應(yīng)用案例

工業(yè)領(lǐng)域:鯤云與合作方針對某電容上激光刻蝕字符推出基于深度學(xué)習(xí)的OCR識別方案,識別算法采用了深度學(xué)習(xí)方法,可識別字母、數(shù)字以及數(shù)十種特殊字符,字符識別精度可達(dá)到99.99%。采用搭載鯤云CAISA芯片的星空加速卡,識別延遲可以降低到50ms,識別速度可達(dá)到20pcs/s。

電力領(lǐng)域

鯤云與合作方通過研究適用于電力無人機(jī)巡檢的目標(biāo)檢測深度學(xué)習(xí)算法,實(shí)現(xiàn)基于人工智能技術(shù)的電力無人機(jī)智能巡檢、數(shù)據(jù)采集,并在服務(wù)器端進(jìn)行高質(zhì)量的圖片數(shù)據(jù)分析,提高巡檢效率,降低巡檢工作量。

產(chǎn)品特征/技術(shù)特點(diǎn)

其宣稱芯片利用率可達(dá)95.4%;時延:3ms分類延時支持分類、目標(biāo)檢測以及語義分割類深度學(xué)習(xí)算法;Batchsize不敏感;溫度范圍:-20℃~70℃

實(shí)測Benchmark

產(chǎn)品信息

華為技術(shù)有限公司-昇騰310AI處理器

技術(shù)概述

昇騰AI處理器的主要架構(gòu)組成:芯片系統(tǒng)控制CPU(Control CPU)

AI計算引擎(包括AICore和AI CPU)多層級的片上系統(tǒng)緩存(Cache)或緩沖區(qū)(Buffer)數(shù)字視覺預(yù)處理模塊(Digital VisionPre-Processing,DVPP)等。

技術(shù)指標(biāo)

應(yīng)用案例

華為針對其昇騰AI芯片的計算架構(gòu)專門構(gòu)建了完整的軟件棧,兼容各個深度學(xué)習(xí)框架并能夠高效運(yùn)行在昇騰AI芯片上,讓開發(fā)者能夠快速開發(fā)推理應(yīng)用,為開發(fā)者提供便利的解決方案。當(dāng)前主流的深度學(xué)習(xí)應(yīng)用,包括圖像分類、人臉識別、目標(biāo)檢測、光學(xué)字符識別、視頻處理和自然語言處理領(lǐng)域的各個模型,均可以在昇騰310處理器上得到很好的技術(shù)支持。

產(chǎn)品特征/技術(shù)特點(diǎn)

達(dá)芬奇架構(gòu)主要由計算單元、存儲系統(tǒng)和控制單元三部分構(gòu)成。其中計算單元又分為:矩陣計算單元、向量計算單元、標(biāo)量計算單元,分別對應(yīng)矩陣、向量和標(biāo)量三種常見的計算模式。

矩陣計算單元(CubeUnit):矩陣計算單元和累加器主要完成矩陣相關(guān)運(yùn)算。一拍完成一個FP16的16x16與16x16矩陣乘(4096);如果是INT8輸入,則一拍完成16*32與32*16矩陣乘(8192);

向量計算單元(VectorUnit):實(shí)現(xiàn)向量和標(biāo)量,或雙向量之間的計算,功能覆蓋各種基本的計算類型和許多定制的計算類型,主要包括FP16/FP32/INT32/INT8等數(shù)據(jù)類型的計算;

標(biāo)量計算單元(ScalarUnit):相當(dāng)于一個微型CPU,控制整個AICore的運(yùn)行,完成整個程序的循環(huán)控制、分支判斷,可以為Cube/Vector提供數(shù)據(jù)地址和相關(guān)參數(shù)的計算,以及基本的算術(shù)運(yùn)算。

產(chǎn)品信息

如需下載完整報告,請?jiān)诤笈_回復(fù)“報告”。

-

人工智能

+關(guān)注

關(guān)注

1792文章

47442瀏覽量

239000 -

AI芯片

+關(guān)注

關(guān)注

17文章

1894瀏覽量

35103

原文標(biāo)題:AI芯片技術(shù)選型目錄

文章出處:【微信號:elecfanscom,微信公眾號:核芯產(chǎn)業(yè)觀察】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

《AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第二章AI for Science的技術(shù)支撐學(xué)習(xí)心得

通用CAN芯片選型指南

燃?xì)庥嬃坑贸暡〒Q能器選型應(yīng)用說明

AI網(wǎng)絡(luò)物理層底座: 大算力芯片先進(jìn)封裝技術(shù)

芯片選型及應(yīng)用超詳細(xì)攻略

MOS管和驅(qū)動芯片的選型

risc-v多核芯片在AI方面的應(yīng)用

NanoEdge AI的技術(shù)原理、應(yīng)用場景及優(yōu)勢

AI芯片技術(shù)的選型說明

AI芯片技術(shù)的選型說明

評論