既能問答、翻譯、寫文章,也能寫代碼、算公式、畫圖標。..。..OpenAI 2020 年 5 月推出的 GPT-3,因其神奇的通用性而走紅 AI 領域。

GPT-3 是用英文語料做預訓練的,主要應用于英文相關場景,而中文業界和學術界已經出現了期待中文版 GPT-3 的聲音。

“GPT-3 與出門問問的技術基礎緊密相關。雖然現階段 GPT 模型還并非完美,但它是目前我們能看到,通往更加通用的語言智能的重要路徑之一。”從事中文語音交互的 AI 公司出門問問創始人兼 CEO 李志飛告訴品玩。

出門問問一直對更加通用的語言智能很感興趣。團隊正深入理解 GPT-3 的相關論文,推進相關實驗,嘗試提升訓練效率等工作。

如何打造中文版 GPT-3?

那么,如果要打造一個中文版的 GPT-3,該怎么操作?

“與英文相比,中文版 GPT-3 的誕生將經歷一個從零到一的過程,可以借鑒英文 GPT-3 技術迭代的相關經驗。”李志飛對品玩表示。GPT-3 的技術迭代之路,是一個不斷增大訓練數據量和模型參數規模的過程。

本質上,GPT-3 是一個大規模預訓練 NLP(自然語言處理) 模型。大規模預訓練是指,先用大量沒有標注的語料做無監督學習,得到一套模型參數,然后再用少量標注語料精調,最后應用于具體的下游 NLP 任務。這種模式已經誕生了不少成功的 NLP 模型,如 Google 2018 年推出的 Bert,但其通用性上依然不足。直到 GPT-3 推出,讓這類預訓練模型的通用性上了一個臺階。

從 GPT 第一代到 GPT-3,其模型層面一直都是基于 Transformer(一種領先的提取語義特征方法)做預訓練,沒有什么改變,但訓練數據量和模型規模十倍、千倍地增長。

2018 年 6 月發布的 GPT 第一代,預訓練數據量僅為 5GB。GPT-2 增長為 40GB,GPT-3 更是猛增到 45TB(等于 45000GB)。而模型規模方面,從 GPT 第一代的 1.17 億參數量,指數增長為 1750 億。

隨著數據量和模型規模的增大,GPT 逐漸舍棄了用少數標注語料精調這一步,完全基于預訓練得出的參數,去做下游任務,精確度依然有一定保證。

GPT 所需算力也越來越夸張,初代 GPT 在 8 個 GPU 上訓練一個月就行,而 GPT-2 需要在 256 個 Google Cloud TPU v3 上訓練(256 美元每小時),訓練時長未知。到 GPT-3,預估訓練一個模型的費用超過 460 萬美元。

相應地,參與到 GPT 論文的作者從初代的 4 位,增加到第三代的 31 位。并且,31 位作者分工明確,有人負責訓練模型,有人負責收集和過濾數據,有人負責實施具體的自然語言任務,有人負責開發更快的 GPU 內核。

借鑒 GPT-3 的迭代經驗,李志飛認為開展中文 GPT-3 模型訓練比較合理的路徑是:“從中小規模的模型入手,開展研究及實驗,達到一定效果后再推廣到大模型上進行驗證”。

至于人力方面的配置,他表示 GPT 是一個非常綜合的大系統工程,涉及到學術、工程、商業等團隊之間的大規模協同。一般需要搭建幾十人的團隊,其中包括科學家、工程師、項目經理等角色。

雖然可以借鑒英文 GPT-3 技術迭代的相關經驗,但是在創建中文版 GPT-3 的過程中,也需要解決很多獨特的問題,如中文訓練數據、算力等。

“一方面,我們需要將更多的時間精力,投入在高質量、多樣性的訓練文本的獲取上。”李志飛說,“另一方面,計算的效率問題,也是目前大規模深度學習模型訓練所面臨的共同挑戰。”

從總體規模、數據質量及多樣性上看,目前能夠從互聯網上獲取到的高質量中文數據,相比英文數據要少一些,這可能會影響到中文模型的訓練效果。不過,從已有的研究分析結果來看,數據并非越多越好。

“我們可以結合數據優化、數據生成等方式來提高訓練語料的有效性。初步來看,具體訓練語料,主要包括百科問答、新聞資訊、博客電子書類數據及其它泛爬數據,經過數據處理后其規模在 500GB 左右。”李志飛說。

GPT-3 模型參數到達 1750 億,其背后訓練資源的開銷非常龐大,預估訓練一個模型的費用超過 460 萬美元。不過,隨著國內外各項研究的推進,預訓練模型的訓練效率將會不斷提升。

“我們可以借鑒其他預訓練語言模型的優化經驗,在訓練語料、網絡結構、模型壓縮等方面多做工作,預計將模型的單次訓練成本降低一個數量級。”李志飛說。

看上去,構建中文 GPT-3 是一件很費勁的事情,但這項工作帶來的回報也非常可觀。李志飛對品玩表示,GPT-3 展現出的通用能力,可以將其視為下一代搜索引擎和 AI 助理,所以這項技術本身的商業應用場景可以很廣闊。

其次,構建 GPT 模型的過程中,將涉及到超算中心和AI算法平臺的建設,這些算力和算法平臺可以為企業、科研機構、政府提供底層服務,通過開放平臺為產業賦能,如智能車載、智慧城市、科技金融等領域。

另外,雖然 GPT 本質是一個關于語言的時序模型,但語言之外的其它時序問題,如經濟、股票、交通等行為預測,也有可能成為潛在應用場景。

GPT-4 可能如何演化?

GPT-3 目前的表現雖然令人震驚,但它本身還存在著很多問題,比如它并不能真正理解文本的含義,只是對詞語進行排列組合。而且,研究員也并未完全了解它的工作機制。李志飛預測,下一個版本 GPT-4 將會在模型規模、小樣本學習、多模態、學習反饋機制和與任務執行結合方面進行改進。

毫無疑問,GPT-4 模型會更加暴力。李志飛說:“下一代 GPT 模型必然在數據規模、模型參數、算力等方面都會有很大提升。另外,下一代的 GPT 模型可能不局限于英文,將能處理更多跨語言層面的任務。”

目前的 GPT-3 模型還嚴重依賴小樣本學習機制。雖然 GPT-3 不需要精調,但是在完成具體的 NLP 任務時,還是會把少量和任務相關的實例給模型。在零樣本和單樣本的任務上,GPT-3 退化比較明顯,事實上后面兩個任務才是更普遍遇到的問題。

“下一代 GPT 模型需要加強在理論上的泛化能力,以便更好地處理零樣本和單樣本的任務。”李志飛表示。

下一代的 GPT 模型極有可能是一個多模態的模型。OpenAI 認為,純文本的自回歸預訓練模型達到當下的規模,已經快接近極限了,需要往多模態模型方向發展,把文本、語音、圖像這些內容結合起來進行學習。李志飛認為,多模態模型,一方面可以引入語言之外的更多維度的信息,另外一方面可以促使模型學習完成更通用化的表示,以此加強模型的泛化能力。

另外一個重要的進化,是引入學習反饋機制。目前GPT模型只是能夠在完全無監督的條件下,讀取海量互聯網文本數據進行學習,但是人類的學習過程是跟物理世界有交互的,只有這樣才能建立更多物理世界的“常識”,比如說杯子應該在桌子上面而不是下面。如果要到達更加通用的狀態,除了多模態外,還要在學習過程中引入物理世界的反饋機制。

“當然,這個反饋也是通過數據來實現的,而不是讓GPT真正像人一樣去探索物理世界。”李志飛說道,“另外,鑒于 GPT 希望實現完全無監督學習的初衷,這個反饋更多是隱式的和延遲的,而不是顯式的和及時的。為了做到這些,需要引入強化學習(re-inforcement learning)之類的機制。”

李志飛還認為,GPT-4 可能引入任務執行能力。現在的 GPT 主要是一個預測和生成的引擎,而不是一個任務的執行器。

比如,你跟GPT說“幫我訂一下明天下午三點左右北京去上海的經濟艙的機票”,目前GPT也許能理解這句話的意思,但還沒有能力自動調取訂票網站的 API(應用程序接口)去執行任務。如果不具備這種執行能力,GPT的通用性就很有限,因為每一個任務都需要額外增加代碼用以執行理解后的任務。所以,GPT 必須學習怎么直接執行任務。

總體而言,李志飛對 GPT 的未來發展非常樂觀:“未來互聯網上的很多內容或知識,都會是由類 GPT 模型產生或加工過的。所以某種程度上,GPT的發展代表著語言主權的演進,且它將有潛力成為一種生態系統。”

責編AJX

-

人機交互

+關注

關注

12文章

1206瀏覽量

55384 -

AI

+關注

關注

87文章

30747瀏覽量

268900 -

應用程序

+關注

關注

37文章

3266瀏覽量

57679

發布評論請先 登錄

相關推薦

Llama 3 與 GPT-4 比較

Jim Fan展望:機器人領域即將迎來GPT-3式突破

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯

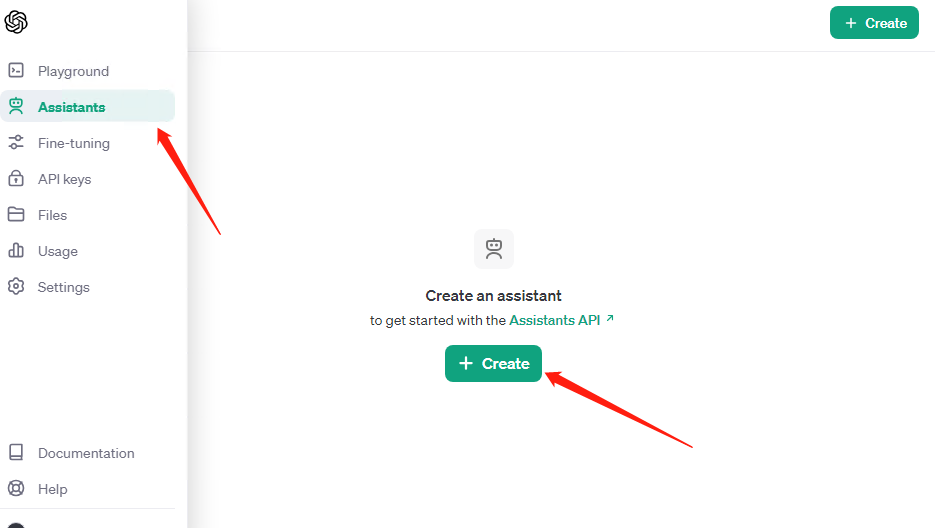

OpenAI API Key獲取:開發人員申請GPT-4 API Key教程

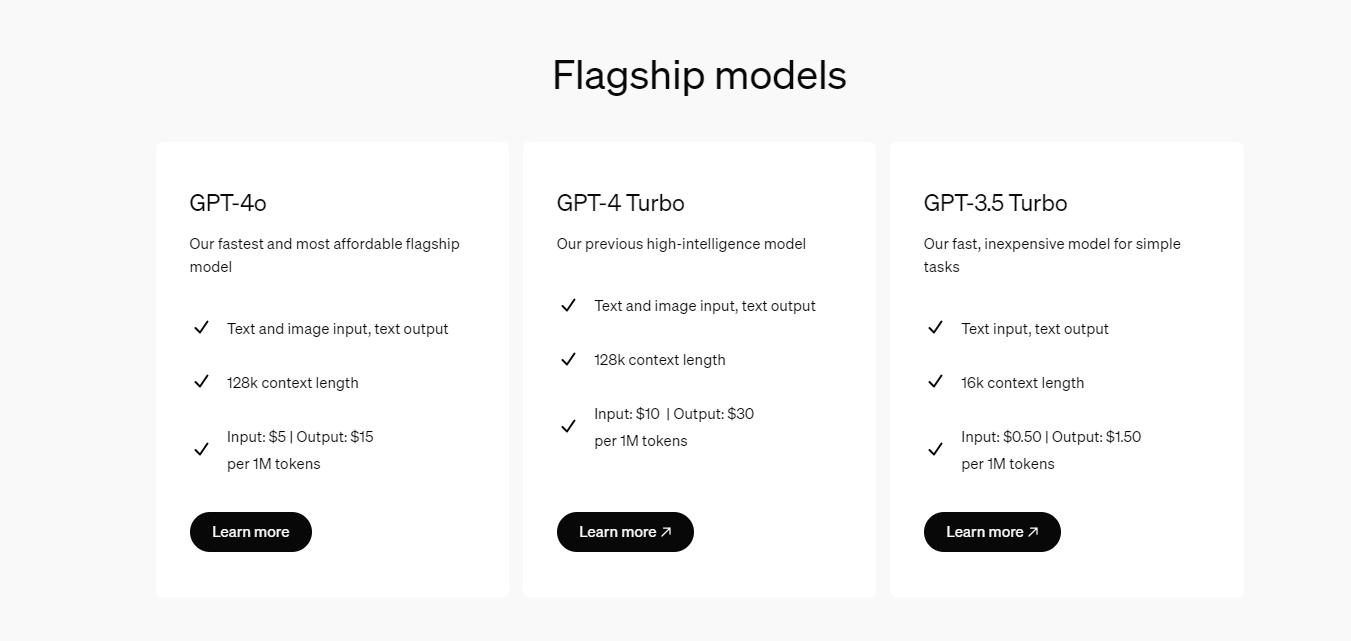

開發者如何調用OpenAI的GPT-4o API以及價格詳情指南

GPT-4人工智能模型預測公司未來盈利勝過人類分析師

OpenAI全新GPT-4o能力炸場!速度快/成本低,能讀懂人類情緒

阿里云正式發布通義千問2.5,中文性能全面趕超GPT-4 Turbo

OpenAI計劃宣布ChatGPT和GPT-4更新

阿里云發布通義千問2.5大模型,多項能力超越GPT-4

微軟Copilot全面更新為OpenAI的GPT-4 Turbo模型

新火種AI|秒殺GPT-4,狙殺GPT-5,橫空出世的Claude 3振奮人心!

如何打造中文版 GPT-3?GPT-4 可能如何演化?

如何打造中文版 GPT-3?GPT-4 可能如何演化?

評論