讓算法像人一樣寫作,是人工智能研究實驗室OpenAI多年來一直追尋的夢想。其最新研究成果是語言生成算法模型GPT-3,現已被用于生成讓人難以分辨的偽文章,其所寫博客騙過了黑客新聞(Hacker News)的發布者,甚至成為網站熱門文章。

那個帖子是這樣的:“要想把事情做好,也許我們根本不需要想太多。這似乎有悖常理,但我相信有時想得多了反而會阻礙我們的創造力。”

OpenAI之所以可以實現如此高效的算法,是因為它能夠訪問巨額計算量和數據,且此算法本身的容量遠大于已有的所有算法:最大版本的GPT-3有1750億個參數,這種方程式能幫算法做出更精準預測。GPT-2只有15億個參數。

雖然OpenAI曾公布過它的算法,但這次它選擇讓GPT-3保持神秘。該公司表示,對大多數操作者來說,GPT-3實在是太大了,對其收費,就能讓OpenAI從中獲利。

在過去的一年里,OpenAI變革公司結構,使其更能吸引投資者。它放棄了“限制利潤”模式的非盈利定位,這樣如果OpenAI獲利,投資者就能獲得回報。它還與微軟達成了10億美元的合作協議,開啟了兩家公司之間的合作,該協議還允許OpenAI優先訪問微軟的云計算平臺。

研究人員說,他們對OpenAI不公布算法表示質疑,稱這違背了基本科學原則,且對該公司聲明的核實變得愈發困難。

Facebook人工智能研究(FAIR)的聯合董事暨Facebook蒙特利爾人工智能研究實驗室負責人喬埃爾?皮諾(Joelle Pineau)在一封電子郵件中說到:“我對目前為止對諸如GPT-2/GPT-3和AlphaGo這類代碼不共享的所有爭論持懷疑態度。在人工智能領域,有很多類似情況。”

GPT-3的核心是個非常強大的英語寫作工具。GPT-3最重要的是它的規模,它通過分析45萬億字節的數據學會了寫作。報道稱這個訓練過程在云計算上花費了數百萬美元,它見證了人類數以億計的書寫組合。

這是OpenAI長期戰略的關鍵部分。多年來,該公司一直表示,深度學習算法的規模越大越好。數據越多,計算能力越強,算法的能力就越強。OpenAI就是因為具備同時在數百個GPU上訓練算法的能力,才在《刀塔2》中擊敗了職業電子競技玩家。

OpenAI的領導曾表示,OpenAI的政策主管杰克·克拉克(Jack Clark)認為算法越大,則“越有條理,越有創造力,也越可靠”。在談到《刀塔2》機器人需要的訓練量時,首席技術官格雷格·布羅克曼表示:“等運氣耗盡,我們期待一場棋逢對手的比賽。”

GPT-3采用了類似方法。OpenAI認為,算法更大意味著參數更多,就能進行更普遍的操作。例如,GPT-3最基本的功能是自動補全,給它一個詞或句子,它就會逐字逐句地生成它認為接下來該出現的詞句。不必對算法進行任何修改,它也能回答問題,甚至進行翻譯。這與只能處理一項任務的專項微調算法不同。

有人認為,這向人工智能的圣杯——通用智能邁出了一步,它意味著算法可以像人類一樣學習和適應;而另一些人則表示,算法仍不能真正理解它生成的話語。

OpenAI發布了一篇詳細的研究報告,解釋了該算法的架構和它所取得的結果,而當涉及到GPT-3的功能研究時,其他人工智能研究人員只能選擇相信OpenAI。這家研究公司最近不再以非盈利為定位,開始籌集資金開發商業產品,它不再像過去一樣公布算法。

2019年2月,OpenAI宣稱,前一最大版本GPT-2算法有可能生成錯誤信息或虛假新聞,太過危險不便發布,這一聲明引來了很多質疑。公司先行發布了簡易版的GPT-2,并未發現濫用跡象,才最終發布了最大版本算法。現在,與其說GPT-3太危險,不如說它似乎太有利可圖而不能發行。

GPT-3只能通過OpenAI運行的API訪問,這與亞馬遜、谷歌和微軟等公司的算法變現方式相類似。開發者可以編寫程序向GPT-3發送特定指令,GPT-3在OpenAI的云端中生成響應并回傳結果。雖然API在內測期間免費,但OpenAI正在考慮長期定價。這意味著研究人員只能向算法發送特定命令,而OpenAI可以隨時取消訪問權限。

OpenAI將這種做法歸結于對安全和規模的考慮。如果該公司發現有人濫用API做了諸如支持假新聞網站的事情,那么它可以取消該開發者的訪問權限。

該公司還表示,這些算法規模龐大,運行成本高昂,更別提開始訓練后的花銷。“這使得任何除大公司以外的使用者都很難從底層技術中獲益。我們希望API能讓小型企業和組織更容易地使用強勁的人工智能系統。”

由于云計算的計價方式,OpenAI訓練和操作算法的確切成本很難核算。租賃GPU的成本根據特定服務器區域的地理鄰近程度,以及基于項目規模的協議費率等因素的不同,差別很大。由于OpenAI為完成任務將其中部分資金用于建造自己的超級計算機,它可能從與微軟的10億美元合作中受益。

但是這些限制,即規模和缺乏透明度,使得其他科學家很難復制和驗證該算法的有效性。

盡管涉及風險投資和企業利益,人工智能仍然是研究計算機科學的一個途徑,且這種科學方法仍然適用。最好的科學實驗,比如建立一個算法來成功完成一項任務并證明一個假設,是可以復制的。

皮諾是可復制計算機科學的熱心支持者,她認為像GPT-3和AlphaGo這樣尚未公布的算法是“科學文物”。她在電子郵件中說到:“這有點像挖出的恐龍骨頭,它為你提供了支持某些理論的證據,但與實際進行實驗是不一樣的。”皮諾表示,這些“文物”有助于提出未來的研究假設,但它們仍然不能替代確鑿的知識。

很多人擔心,通過限制對代碼和受訓算法的訪問,人工智能的“民主化”,即任何人都可使用人工智能,會受OpenAI威脅。“使用人工智能”這一用語是多層面的,意思是使用計算能力、數據集以及算法本身。諸如谷歌的TensorFlow和臉書的PyTorch這類開源框架使得算法易于構建和共享,還存在其他很多開源數據集。

然而,計算能力來自硬件,是一種有限的物理資源,大公司和像OpenAI這樣資金充足的研究機構更容易獲得該資源。

如果OpenAI的實驗被證明是人工智能的發展方向,同時算法的擴大轉化為性能的提高,那么消費不起先進人工智能的人就無法使用它了。這還會允許擁有資源的大公司制定規則,決定誰有權使用某些人工智能算法。例如,他們可以利用API進行設置,并對訪問和使用算法進行收費。

喬治亞理工學院(Georgia Institute of Technology)研究自然語言處理的人工智能教授馬克·瑞德爾(Mark Riedl)表示:“如果確信實現更好人工智能的方法實際上是實現更大規模,那么誰能擁有更優人工智能就由OpenAI決定了。”

瑞德爾對OpenAI是否會監視其新API的所有使用情況,以確定是否被用于惡意目的表示質疑,OpenAI曾花了大量精力來思考它的算法會如何被濫用。“OpenAI是否會查看輸出,以判斷他們的技術是否得到恰當使用?鑒于其宗旨,以及這與他們新盈利模式相沖突,這似乎很關鍵。他們能做到大規模監控嗎?”

并非所有人都認同OpenAI“越大越好”的方法是人工智能的發展方向。例如,自然語言處理研究人員梅拉妮·米歇爾(Melanie Mitchell)就對GPT-3進行了“模仿”測試,要求算法識別特定字母序列的變化模式。如果“abc”變為“abd”,那么“efg”會變成什么?

上世紀80年代,米歇爾開發了一種算法來解決這類人類一直以來所進行類比的微型模擬測試。要正確地進行類比,必須理解所有組件之間的關系。在字母表的例子中,算法必須了解字母表的順序和每個字母的位置。雖然該算法在眾多測試中表現良好,但米歇爾發現,它也無法掌握其他算法數十年前已掌握的一些簡單概念。

米歇爾說:“在研究方面,我個人認為,在一個問題上投入過多的計算和參數可能會把人工智能逼進死胡同。如果我們的目標是制造強大、具有普遍智能的機器,我認為這無法取得真正的進展。”

她承認,在制造需要深度學習的人工智能產品時,龐大的計算能力讓科技巨頭獲得優勢,但反之并不是所有現代問題都需要高能耗的深度學習算法,不是解決每個問題都需要達到GTP-3的規模。

米切爾在測試該算法時寫道:“GPT-3的性能令人驚嘆,但它也和當今最先進的人工智能系統中的很多情況類似:似乎很智能的性能中夾雜著一些非人類錯誤,而且我們搞不清楚它表現好或犯錯誤的原因。”

責編AJX

-

算法

+關注

關注

23文章

4607瀏覽量

92841 -

AI

+關注

關注

87文章

30747瀏覽量

268900 -

GPT

+關注

關注

0文章

353瀏覽量

15344

發布評論請先 登錄

相關推薦

葡萄酒俱樂部計劃部署RFID技術以提高供應鏈的透明度

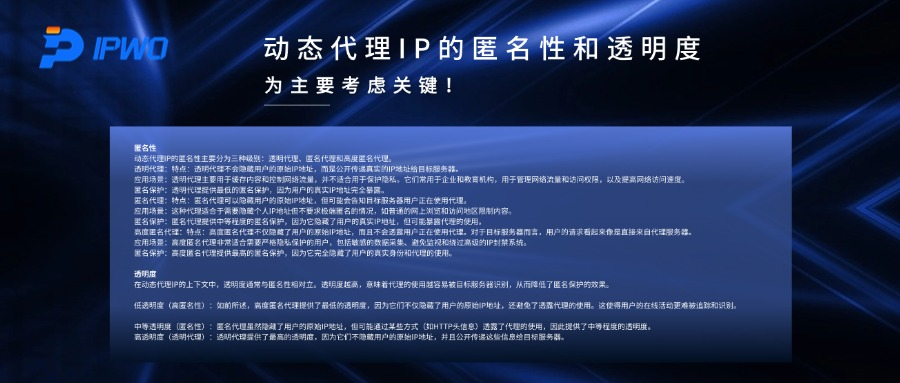

動態代理IP的匿名性和透明度,為主要考慮關鍵!

Jim Fan展望:機器人領域即將迎來GPT-3式突破

Arm Kleidi加速AI發展

加州立法推動AI透明度,生成式人工智能迎來數據披露新紀元

開源 KiCad/AD 查看器 + AI Copilot?

LED透鏡的顏色與透明度基本概念

平衡創新與倫理:AI時代的隱私保護和算法公平

Alpha半透明圖形疊加算法Matlab+Verilog的設計實現

AI專家:GPT-3的性能令人驚嘆,但存在規模和缺乏透明度等問題

AI專家:GPT-3的性能令人驚嘆,但存在規模和缺乏透明度等問題

評論