AWS全球基礎設施和客戶支持高級副總裁Peter DeSantis在AWS Re:Invent年度用戶活動上發表主旨演講時表示,與CPU巨頭AMD和Intel提供的處理器相比AWS的處理器和芯片設計在云應用程序性能方面具有優越性,而且AWS的圖形處理器性能超過了Nvidia為機器學習(ML)提供的GPU。他指的是AWS Graviton2處理器,由AWS使用64位Arm Neoverse定制。

隨著AWS上以及Azure和Google Cloud Platform(GCP)上可用選擇的爆炸式增長,客戶可能會越來越仔細地考慮應用程序性能和服務提供的成本/性能比。這樣,底層芯片和服務器基礎設施將成為決定云原生應用程序性能、功耗以及成本的關鍵因素。

因此,AWS希望旗艦64位基于ARM的Gravion2和其他內部設計的處理器的強大功能發揮重要作用,以幫助客戶提高其應用程序的性能。

DeSantis說:“對AWS硅技術的深度投資真正令人興奮和帶來變革的是能夠跨定制硬件和軟件工作,以提供獨特的功能。通過在整個堆棧中工作,我們能夠比以往任何時候更快地實現這些改進。”

發力芯片

Graviton2有望通過多種方式進一步提高應用程序性能。DeSantis作出了大膽的聲明,AWS Graviton2提供了優于傳統設計的性能、節能優勢和安全性。AWS還公開表示,為Amazon EC2 T4g、M6g、C6g和R6g實例以及基于本地NVMe的SSD存儲的“變體”提供動力的Graviton2“為各種工作負載”提供了比基于x86的實例高出40%的性價比

DeSantis說,在基于Graviton的Amazon EC2 A1實例中引入Graviton的目的是讓AWS“與客戶和ISV合作伙伴合作,了解他們在現代64位ARM處理器上運行工作負載需要什么”。

DeSantis解釋說,如今用戶需要的是將處理器設計與在云環境中運行的高度分布式微服務應用程序相匹配的能力。今天的開發者也基本上不再用C++編寫云原生應用程序,而是用GO和Ruat,并且“完全改變了高性能多線程應用程序的開發”。

“對我來說,最令人興奮的趨勢之一是轉向基于服務的架構,從大型單體應用程序向小型專門構建的獨立應用程序發展。這正是容器和Lambda支持的計算類型。雖然橫向擴展計算已經發展到利用更高核心處理器,但處理器設計師從未真正拋棄舊世界。他們試圖做到這兩個方面,既滿足傳統應用程序的需要,又滿足現代擴展應用程序的需要。”

DeSantis在重申Graviton2的設計者“專注于確保每個核心都能為現代云工作負載提供最真實的性能”的同時,還暗指傳統的CPU性能基準(如用于衡量PC和服務器性能的基準)不再適用。“我們利用運行實際橫向擴展應用程序的經驗,確定需要在哪些方面添加功能以確保最佳性能。”

DeSantis還表示,Graviton2的設計旨在節省每個芯片的硅表面,同時通過減少內核數量來降低功耗——這是衡量處理器性能的傳統方法。

“我們設計Graviton的目的是有盡可能多的獨立核心,而盡管獨立,Graviton兩個核心的設計是一致的。”

Snap的工程高級副總裁Jerry Hunter表示,Snap使用Graviron2有助于降低AWS DynamoDB和S3的成本和能耗。除了用AWS的DynamoDB和S3進行存儲外,他還看到了Graviton2“在不消耗大量能源的情況下為客戶降低成本并創造更好的性能”。

Hunter說,Snap向Graviton2的轉變“非常簡單”,API“與以前使用的非常相似”,因此“不需要花太多時間來遷移代碼以進行測試。我們節省了20%的成本,這是非常棒的,因為我們能夠切換此負載,并立即獲得成本節約和更高的性能。”

芯片上的機器學習

雖然沒有透露具體的基準測試,DeSantis還表示AWS優于Nvidia。總的來說,與用于支持ML的大規模推理基礎設施的GPU相比,AWS Inferentia提供了“以一半的成本實現了最高的吞吐量(每次推理)”。具體到Nvidia,DeSantis說Amazon Alexa最近將其推理工作負載從基于Nvidia GPU的硬件轉移到了基于Inferentia的EC2實例,成本降低了30%,延遲降低了25%。

對于ML開發人員,AWS的Neuron團隊提供了TensorFlow、PyTorch和Apache MXNet等框架來設計運行在Inferntia上的應用程序。DeSantis說:“開發人員可以利用Inferntia的成本節約和性能,而不需要對ML代碼進行很多更改或根本不做任何更改,并保持對其他ML處理器的支持。”

在沒有透露具體細節的情況下,DeSantis說,AWS為ML設計的下一款硅芯片將包括明年推出的AWS Trainium。

“我們在機器學習芯片上的投資才剛剛開始。正如Inferentia所做的那樣,Trainium將提供最低成本和最高性能的方式來運行訓練工作負載。”

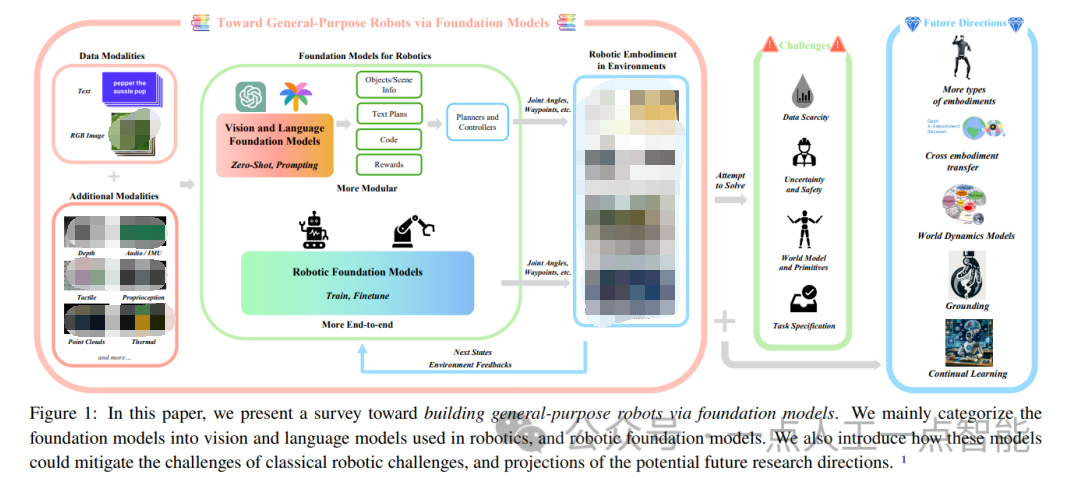

對于ML開發團隊,AWS還通過機器學習擴展運維,并將AWS的數據庫服務(包括S3和Dynamo)與AWS SageMaker及其ML基礎設施集成在一起。有了正確的硅基礎設施和開發工具,目的是提供一個機器學習平臺可以滿足DevOps團隊的需求,因為他們可以在不改變基礎設施和工具集的情況下,從10或100個ML項目模型擴展到1000個。

“這是一種變革性的技術。我認為,開始機器學習并開始進行概念驗證非常重要,而AWS提供的工具使其變得更加容易,”AWS ML的副總裁Bratin Saha表示。“所以,我認為讓客戶明白機器學習是現在的關鍵,而不是未來,這一點非常重要。”

編輯:hfy

-

cpu

+關注

關注

68文章

10872瀏覽量

211999 -

NVIDIA

+關注

關注

14文章

4994瀏覽量

103159 -

機器學習

+關注

關注

66文章

8422瀏覽量

132714 -

AWS

+關注

關注

0文章

432瀏覽量

24391

發布評論請先 登錄

相關推薦

檢測鋁礬土硅鋁鈦的設備 測試鋁土礦的機器

【「具身智能機器人系統」閱讀體驗】1.全書概覽與第一章學習

什么是機器學習?通過機器學習方法能解決哪些問題?

魯棒性在機器學習中的重要性

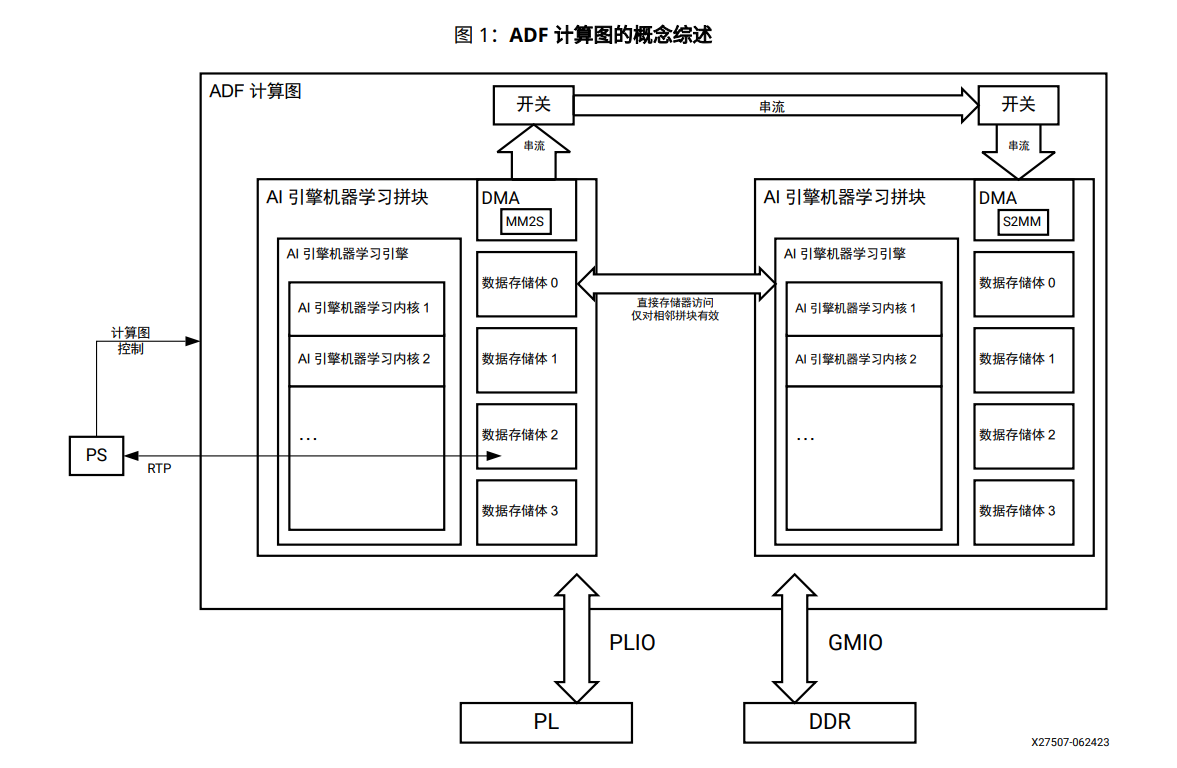

AI引擎機器學習陣列指南

【「時間序列與機器學習」閱讀體驗】+ 簡單建議

深度學習與傳統機器學習的對比

名單公布!【書籍評測活動NO.35】如何用「時間序列與機器學習」解鎖未來?

深入探討機器學習的可視化技術

變革性技術機器學習把硅戰爭帶到云端

變革性技術機器學習把硅戰爭帶到云端

評論