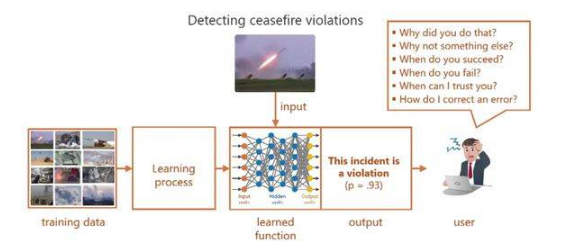

XAI 主要解決以下問題:對于使用者而言某些機器學習模型如同黑盒一般,給它一個輸入,決策出一個結果。比如大部分深度學習的模型,沒人能確切知道它決策的依據以及決策是否可靠。如圖 1 的 output 所示,為一般網絡給出的決策,缺乏可解釋性的結果讓使用者感到困惑,嚴重限制了其在現實任務中的廣泛應用。

圖 1 如今的深度學習 [1]

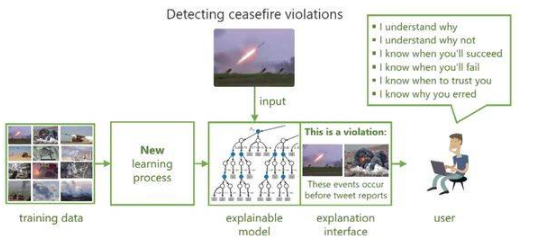

所以為了提高機器學習模型的可解釋性和透明性,使用戶和決策模型之間建立信任關系,近年來學術界進行了廣泛和深入的研究并提出了可解釋的機器學習模型。如圖 2,模型在決策的同時給出相應的解釋,以獲得用戶的信任和理解。

圖 2 可解釋的機器學習 [1]

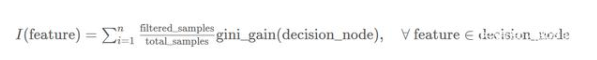

對于機器學習模型來說,我們常常會提到2個概念:模型準確性(accuracy)和模型復雜度(complexity)。模型的復雜度與準確性相關,又與模型的可解釋性相對立。因此我們希望找到一種模型如圖 3 所示,具有可解釋性的同時盡可能保證模型的準確性和復雜度。

編輯:hfy

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

機器學習

+關注

關注

66文章

8408瀏覽量

132575 -

深度學習

+關注

關注

73文章

5500瀏覽量

121117

發布評論請先 登錄

相關推薦

機器學習模型可解釋性的結果分析

模型的可解釋性是機器學習領域的一個重要分支,隨著 AI 應用范圍的不斷擴大,人們越來越不滿足于模型的黑盒特性,與此同時,金融、自動駕駛等領域

發表于 09-28 10:17

?996次閱讀

什么是“可解釋的”? 可解釋性AI不能解釋什么

通過建立既可解釋又準確的模型來改良這種錯誤的二分法。關鍵是將神經網絡與決策樹相結合,在使用神經網絡進行低級決策時保留高級的可解釋性。

發表于 05-31 10:51

?8521次閱讀

機器學習模型的“可解釋性”的概念及其重要意義

如果考察某些類型的“事后可解釋性”(post-hoc interpretable),深度神經網絡具有明顯的優勢。深度神經網絡能夠學習豐富的表示,這些表示能夠可視化、用語言表達或用于聚類。如果考慮對可解釋性的需求,似乎線性

Explainable AI旨在提高機器學習模型的可解釋性

Google Cloud AI戰略總監Tracy Frey在 今天的博客中解釋說,Explainable AI旨在提高機器學習模型的可解釋性

機器學習模型可解釋性的介紹

模型可解釋性方面的研究,在近兩年的科研會議上成為關注熱點,因為大家不僅僅滿足于模型的效果,更對模型效果的原因產生更多的思考,這...

人工智能可解釋性規制面臨的問題分析

在實踐中,人工智能的規模化應用推廣,在很大程度上依賴于用戶能否充分理解、合理信任并且有效管理人工智能這一新型伙伴。為此,確保人工智能產品、服務和系統具有透明性(Transparency)與可解釋性(Explainability)是至關重要的。

淺談機器學習模型的可解釋性和透明性

淺談機器學習模型的可解釋性和透明性

評論