隨著物聯網時代的到來,海量的數據蜂擁而至。特別是各種應用終端和邊緣側需要處理的數據越來越多,而且對處理器的穩定性,以及功耗提出了越來越高的要求,這樣,傳統的計算體系和架構的短板就顯得愈加突出,未來,具有更高效率和更低功耗的計算系統一定會大行其道。

在這樣的背景下,存算一體(Computing In Memory,內存內計算)AI芯片應運而生。目前,不少國際上的領先企業和研究機構正在致力于各種新型存儲器的研究,其中一個很大的驅動力就是希望能夠實現具有更高效率的存算一體系統,而在這其中,AI的融入也是一大趨勢。這些使得計算+存儲+AI的融合發展成為了一大方向。

不僅是在國際上,最近幾年,我國本土的一些企業和科研院所也在致力于這方面的研究工作。就在上周,合肥恒爍半導體科技公司與中國科大團隊歷時兩年共同研發的基于NOR閃存架構的存算一體AI芯片系統演示順利完成。這是國際領先的超低功耗存算一體的人工智能芯片。據悉,該芯片是一款具有邊緣計算和推理能力的AI芯片,能實時檢測通過攝像頭拍攝的人臉頭像并給出計算概率,可廣泛應用于森林防火中的人臉識別與救援、心電圖的實時監測、人工智能在人臉識別上的硬件解決方案等。

這也是我國本土企業在基于NOR閃存架構的存算一體AI芯片領域的又一次突破,實際上,在該領域,恒爍半導體并不是唯一一家,還有其它一些企業也在進行著基于NOR閃存架構的低功耗AI芯片的研究工作。那么,作為一種傳統的、非前沿的存儲技術,NOR閃存架構有怎樣的特點和優勢,能夠使得這些企業對其投入資源和人力,進行相應的低功耗AI芯片和系統研發呢?

存算一體的優勢

在談基于NOR閃存架構AI芯片的特點和優勢之前,先來看一下存算一體芯片的優勢及其能夠解決的主要問題。

目前來看,不論是PC還是超算,處理器和存儲芯片都是分離的,這就是馮諾依曼50多年前確立的計算架構。隨著技術的發展,存儲計算分離的架構瓶頸越來越明顯。

一般芯片的設計思路是增加大量的并行計算單元,比如上千個AI卷積單元,這樣,需要調用的存儲資源也在增大,然而,在傳統的計算架構當中,存儲一直是有限且稀缺的資源,隨著運算單元的增加,每個單元能夠使用的存儲器的帶寬和大小將逐漸減小,而隨著人工智能時代的到來,這種矛盾顯得愈加突出,特別是對于物聯網來說,網絡的每一層,現有權重和每個AI訓練示例的元素都被加載到處理器的寄存器中,然后相乘,并將結果寫回到存儲器中。這樣,性能瓶頸就不是在計算一側了,而是處理器和存儲器陣列之間的帶寬。存儲器和處理器之間的這種分離是馮·諾依曼架構的定義特征之一,并且存在于幾乎所有現代計算系統中。

這種“存儲墻”的高起正在阻礙著AI產業的發展,可以說,存儲器是AI芯片發展的最大瓶頸。

在很多AI推理運算中,90%以上的運算資源都消耗在數據搬運的過程中。芯片內部到外部的帶寬,以及片上緩存空間限制了運算的效率。因此,在業界和學術界,越來越多的人認為存算一體化是未來的趨勢,可以很好地解決“存儲墻”問題。

如果能夠讓計算和內存更緊密地結合在一起,甚至是在內存內進行計算,就可以大幅提升數據的傳輸效率,同時節省更多的電能,因為在內存和計算之間不再需要往返太多次數,一切處理過程都再同一芯片內完成了。

分類

為了應對物聯網以及存算一體的應用需求,各種新型的、傳統的存儲技術和器件紛紛登場,想在這些新興應用方面盡量地施展出自己的才華。

過去50年中,SRAM、DRAM和Flash已經成為存儲器的主力,這些存儲結構在往更小的幾何結構微縮的過程中都存在問題,很重要的原因在于它們都是平面結構,而新的存儲技術,如基于電阻開關的存儲技術是金屬層結構,消除了許多制造問題。然而,由于DRAM和Flash技術已經非常成熟,成本又很低。所以,它們在存算一體方面依然有獨到的優勢,也正在被一些企業所采用

目前來看,新型的存儲技術主要包括相變存儲器(PCM)、鐵電存儲器(FeRAM)、磁阻RAM(MRAM)、電阻RAM(RRAM或 ReRAM)、自旋轉移力矩RAM(STT-RAM)、導電橋RAM(CBRAM),以及氧化物電阻存儲器(OxRAM)等。基于這些的存算一體研究或多或少地都在進行著,相應的成果也經常見諸于報端。以上這些都是新技術,目前來看,它們的主要問題就是成本,以及生態系統的完整度,還需要一些發展時間才能成氣候。

而從存儲與計算的結合方式來看,存算一體又可以分為兩大類:一是在DRAM中植入邏輯計算單元,被稱為內存內處理或者近數據計算,這種方式非常適合云端的大數據和神經網絡訓練等應用;二是存儲和計算完全結合在一起,存儲器件也即計算單元,如采用基于NOR閃存架構的存算一體AI芯片,其主要特點是能耗低、運算效率高、速度快且成本低,這種形式比較適合邊緣側的神經網絡推理等應用。

NOR閃存架構的優勢

基于NOR閃存架構的存算一體AI芯片,利用NOR Flash的模擬特性,可直接在存儲單元內進行全精度矩陣卷積運算(乘加運算)。規避了數據在ALU和存儲器之間來回傳輸的瓶頸,從而使功耗大幅降低、提高了運算效率。

其Flash存儲單元可以存儲神經網絡的權重參數,同時還可以完成和此權重相關的乘加法運算,從而將乘加法運算和存儲融合到了一個Flash單元里面。例如,100萬個Flash單元可以存儲100萬個權重參數,同時還可以并行完成100萬次乘加法運算。

在這樣的芯片里面,深度學習網絡可以被映射到多個Flash陣列,這些Flash陣列不僅可以存儲數據,其深度學習網絡同時還能完成AI推理,注意,這個過程是不需要額外邏輯計算電路的,一切處理都在這一塊芯片內完成。相比于傳統的馮諾依曼架構深度學習芯片,這種的運算效率非常高,而且成本低廉,因為省去了DRAM、SRAM以及片上并行計算單元,從而簡化了系統設計。

目前來看,這種基于NOR閃存架構的存算一體AI芯片,其主要應用領域就是對成本和運算效率(特別是功耗)敏感的應用,如邊緣側的低功耗、低成本語音識別等。而隨著人工智能和物聯網的發展,它還可以拓展更多的應用場景。

結語

無論是新型存儲技術,還是以NOR閃存為代表的老牌技術,在發展存算一體AI芯片方面,都需要不斷完善生態系統建設,才能使整個產業發展起來。

因此,除了存儲和計算技術本身之外,行業相關的接口標準跟進特別重要,特別是對于以存儲為基礎的新型應用來說,更加重要。另外,由于芯片內部集中了越來越多的功能塊,片內總線和片內網絡系統成為了一個新的課題,目前,這方面的研究和新技術越來越受到業界的重視,新的技術和IP也陸續推出。

責任編輯:tzh

-

處理器

+關注

關注

68文章

19348瀏覽量

230268 -

芯片

+關注

關注

456文章

50951瀏覽量

424763 -

存儲器

+關注

關注

38文章

7514瀏覽量

164002 -

物聯網

+關注

關注

2910文章

44752瀏覽量

374605

發布評論請先 登錄

相關推薦

ESD二極管特點優勢有哪些?

Agv小車有哪些車型?特點和優勢是什么?適用哪些場景?

就服務器而言,ARM架構與X86架構有什么區別?各自的優勢在哪里?

交流負載箱的特點和優勢有哪些?

RISC--V架構的目標和特點

硅谷物理服務器有哪些關鍵優勢和特點

NAND閃存和NOR閃存有什么區別

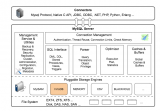

MySQL的整體邏輯架構

NAND存儲種類和優勢

NOR閃存架構有怎樣的特點和優勢?

NOR閃存架構有怎樣的特點和優勢?

評論