學大數據需要具備什么基礎?學大數據應具備編程開發經驗,今天主要介紹學大數據應具備的基礎,學員從java基礎開始,學習大數據開發過程中的離線數據分析、實時數據分析和內存數據計算等重要內容;涵蓋大數據體系中核心技術;Linux、Zookeeper、Hadoop、Redis、HDFS、MapReduce、Hive、Impala等知識點。

學大數據基礎包含涵蓋大數據體系中的技術點,包括但不限于Linux、Zookeeper、Hadoop、Yam、Redis、HDFS、MapReduce、Hive、lmpala、Hue、Oozie、Storm、Kafka、Spark、Soark RDD、Spark SQL、Soark Streaming、Sqoop、Flume、CDH、Scala、Hbase、Flink、機器學習等,將離線數據分析、實時數據分析和內存數據計算中的技術點全面覆蓋。

學大數據需要具備的基礎:

1、Linux

大數據相關軟件都在Linux上運行,學好Linux快速掌握大數據相關技術會有很大的幫助,更好理解hadoop、hive、hbase、spark等大數據軟件的運行環境和網絡環境配置,少踩坑,學會shell就能看懂腳本這樣能更容易理解和配置大數據集群。

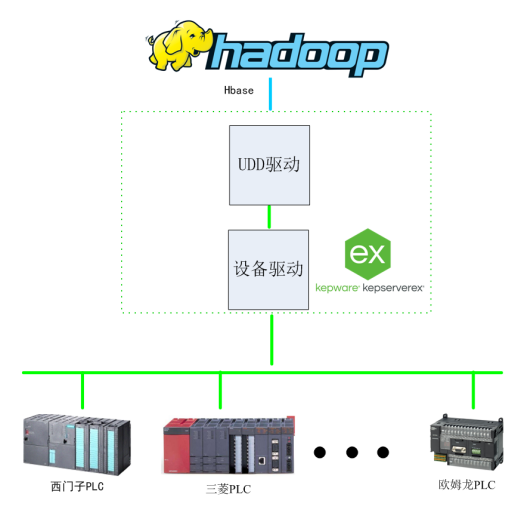

2、Hadoop

大數據代名詞,Hadoop包括幾個組件HDFS、MapReduce和YARN,HDFS是存儲數據的地方就像我們電腦的硬盤一樣文件都存儲在這個上面,MapReduce是對數據進行處理計算的,有個特點就是不管多大的數據只要給時間就能把數據跑完,但時間可能不是很快所以叫數據的批處理。

3、Zookeeper

安裝Hadoop的HA的時候就會用,Hbase也會用到。用來存放一些相互協作的信息,這些信息比較小一般不會超過1M,都是使用的軟件對有依賴,對于我們個人來講只需要把安裝正確,讓正常的run起來就可以了。

4、Mysql

學習完大數據的處理,接下來學習學習小數據的處理工具mysql數據庫,因為一會裝hive的時候要用到,mysql需要掌握到什么層度那?你能在Linux上把安裝好,運行起來,會配置簡單的權限,修改root的密碼,創建數據庫。

5、Sqoop

把Mysql里的數據導入到Hadoop里。直接把Mysql數據表導出成文件再放到HDFS上也是一樣的,當然生產環境中使用要注意Mysql的壓力。

6、Hive

這個東西對于會SQL語法的來說就是神器,能讓你處理大數據變的很簡單,不會再費勁的編寫MapReduce程序。有的人說Pig那?和Pig差不多掌握一個就可以了。

7、Oozie

管理Hive或者MapReduce、Spark腳本,還能檢查程序是否執行正確,出錯了給你發報警并能幫你重試程序,最重要的是還能幫你配置任務的依賴關系。

學生學習大數據的需求,包含java常見技術以及大數據流行的框架。以案例驅動教學的方式,帶領學習者層層深入到大數據體系的內核當中,通過系統學習使學員能夠快速系統的熟悉大數據的應用場景、理解大數據技術原理、以及掌握大數據應用的技術方法,讓學員能夠游刃有余的從事大數據相關工作

責編AJX

-

Linux

+關注

關注

87文章

11373瀏覽量

211298 -

編程

+關注

關注

88文章

3649瀏覽量

94346 -

大數據

+關注

關注

64文章

8929瀏覽量

138273

發布評論請先 登錄

相關推薦

大數據云計算都需要考什么證書?

緩存對大數據處理的影響分析

ADS1675最大數據吞吐率是是多少?

raid 在大數據分析中的應用

智慧城市與大數據的關系

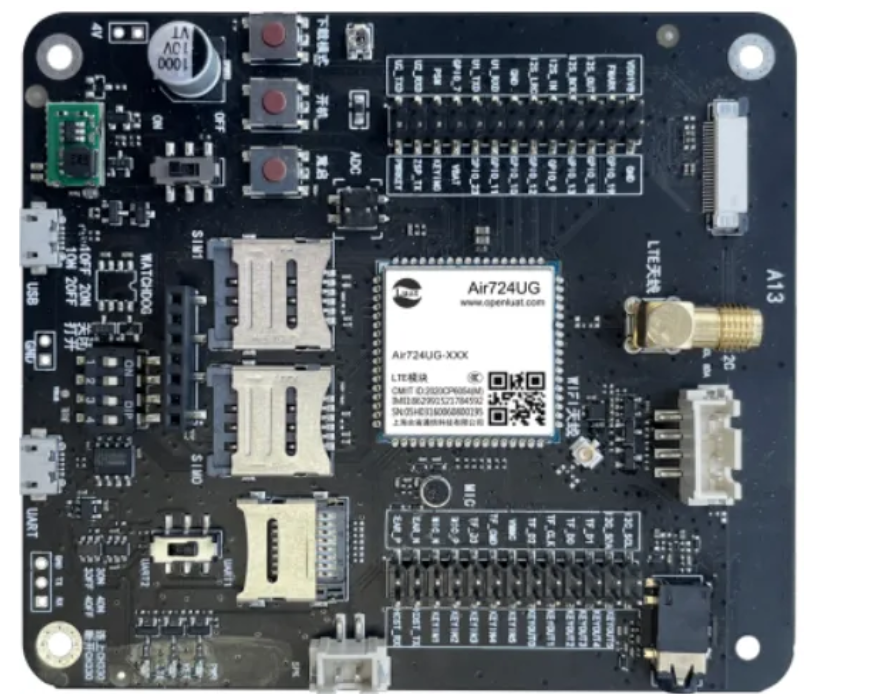

基于Kepware的Hadoop大數據應用構建-提升數據價值利用效能

基于大數據與深度學習的穿戴式運動心率算法

萌新學習大數據前需要具備什么編程基礎?

萌新學習大數據前需要具備什么編程基礎?

評論