本期的關注焦點是NLP的6篇論文。

NLP

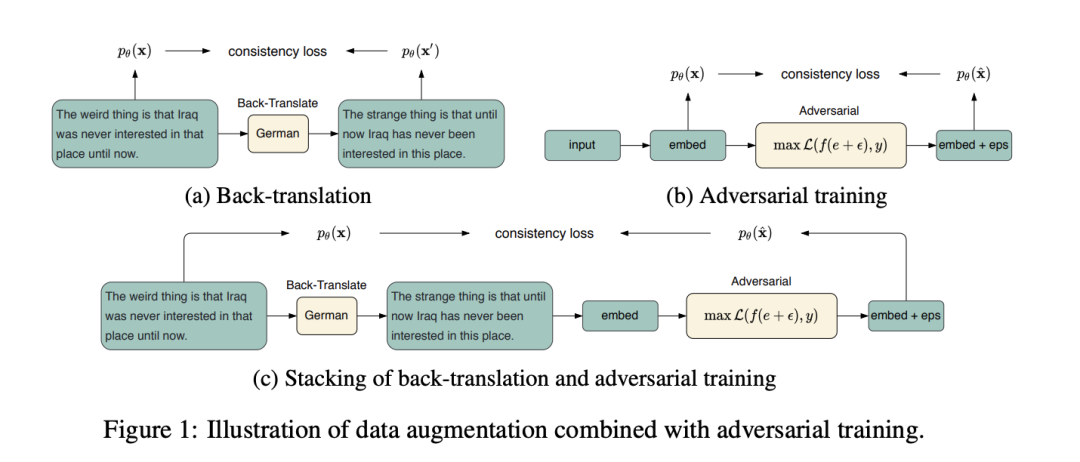

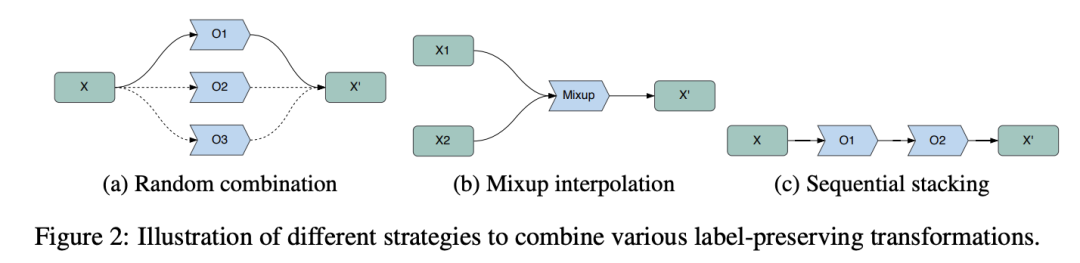

CoDA: Contrast-enhanced and Diversity-promoting Data Augmentation for Natural Language Understanding

本文設計了提出對當前在NLP領域下針對數據增廣場景下如何生成更多高質量和更多樣的數據及如何提升模型效果提出統一的模型,首先提出利用統一的組合策略對已有生成策略融合,另一方面借用對比思想,將生成的數據與訓練中全局的數據做對比以更好提升訓練質量。

論文鏈接:https://openreview.net/forum?id=Ozk9MrX1hvA

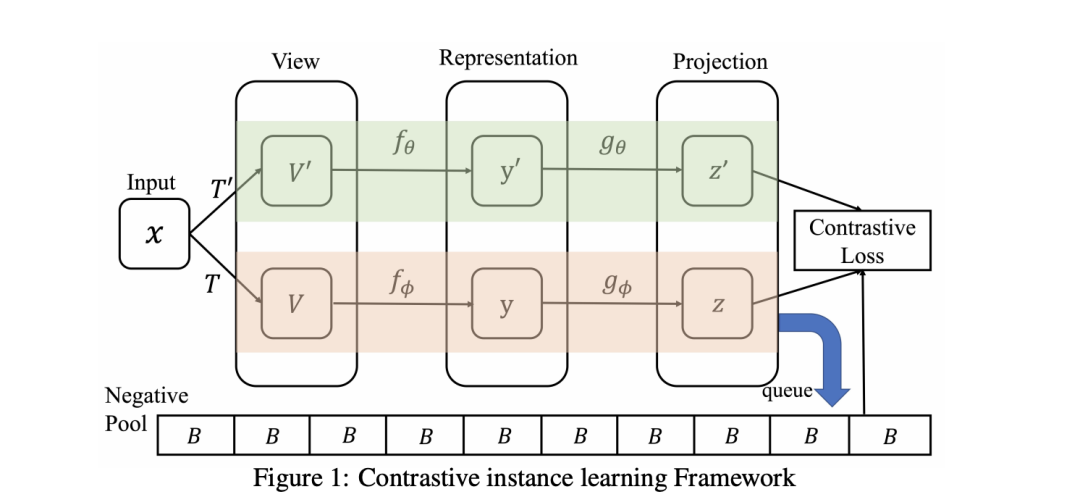

Contrastive Learning with Stronger Augmentations

文章指出現有的對比學習方法中,一些數據增強的操作可能會導致變換后的圖像與原圖的差異過大,強行讓網絡提取出相似的特征反而會減弱自監督學習的效果。作者在文中提出的解決方法是,將數據的增廣操作劃分為兩大類,一類是不會顯著改變圖像視覺效果,叫做Weaker Augmentations;另一類是可能使圖像發生非常大的變化的,叫做Strongerer Augmentations。在訓練網絡的時候,增加了一個新的損失函數,不是直接限制變換圖像與原圖的特征,而是通過優化原圖與弱變換圖像、弱變換圖像與強變換圖像之間的分布,達到特征學習的目的,消除上述的影響。

論文鏈接:https://openreview.net/forum?id=KJSC_AsN14

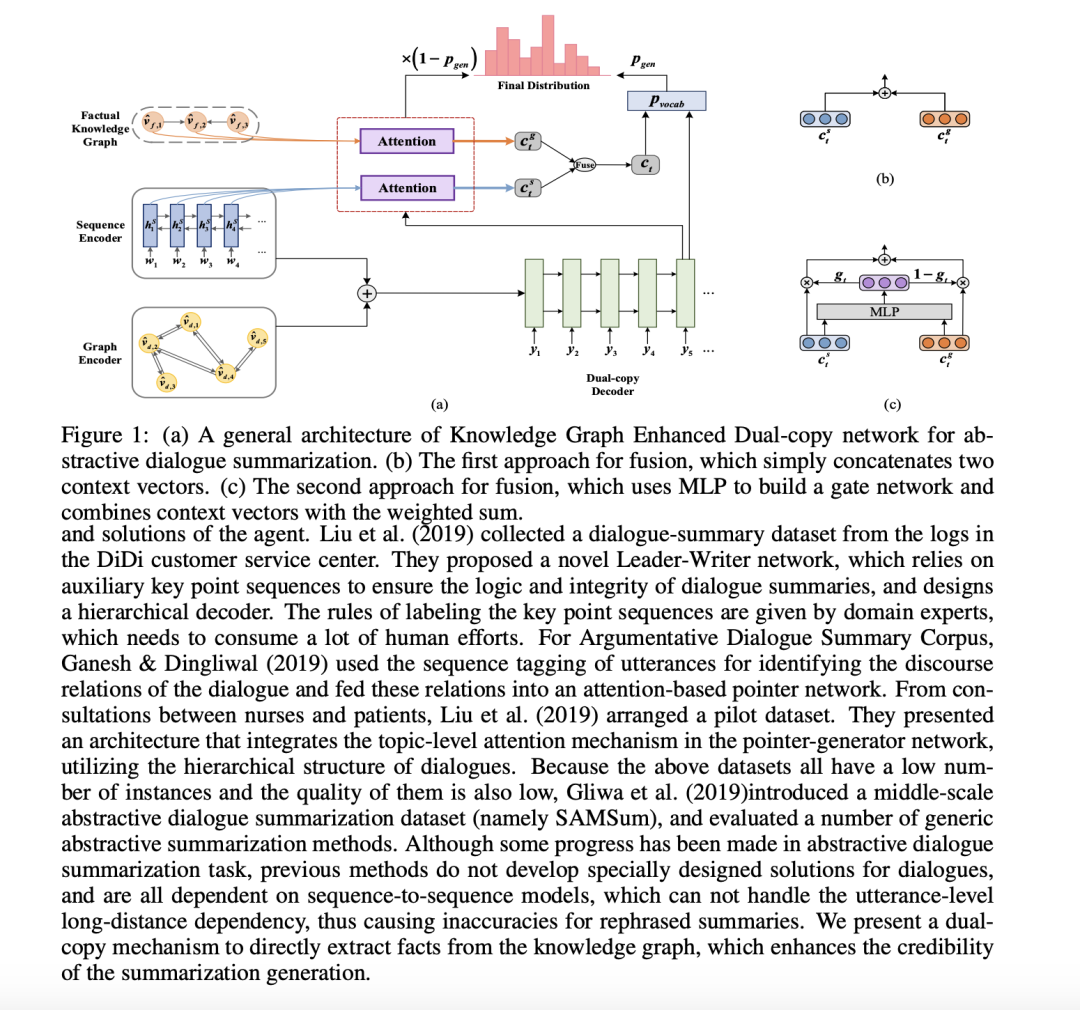

Improving Abstractive Dialogue Summarization with Conversational Structure and Factual Knowledge

在對話抽象摘要任務中,對長距離跨句關系進行捕獲是必要的。此外,生成的摘要會受到虛假事實的影響。本文提出了一種知識圖增強的雙拷貝網絡(KGEDC),它是一種基于會話結構和事實知識的抽象對話和化框架。采用序列編碼器提取局部特征,用圖編碼器通過稀疏關系圖自注意網絡整合全局特征,相互補充。此外,在解碼過程中還設計了一種雙重復制機制,從原文本和事實中共同生成摘要。

論文鏈接:https://openreview.net/forum?id=uFk038O5wZ

CorDial: Coarse-to-fine Abstractive Dialogue Summarization with Controllable Granularity

本文提出一種由coarse-to-fine的對話抽象摘要生成策略,首先生成摘要草稿,然后生成最終摘要。本文也提出了控制最終摘要粒度的簡單策略,可以通過預測和突出顯示源文本中不同的文本跨度來自動控制給定對話生成的摘要語句的數量。

論文鏈接:https://openreview.net/forum?id=Uf_WNt41tUA

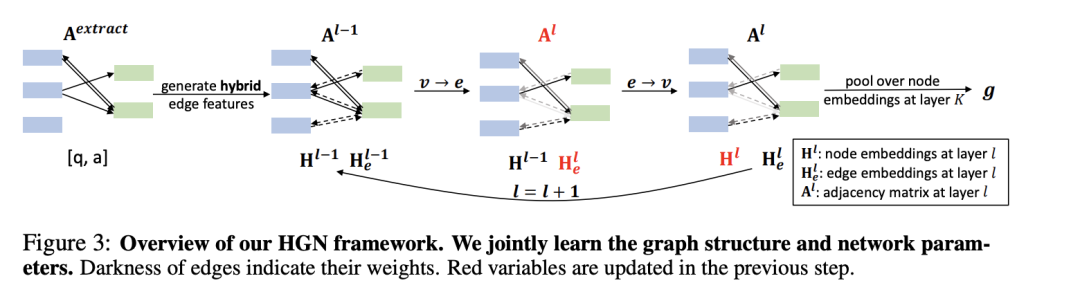

Learning Contextualized Knowledge Graph Structures for Commonsense Reasoning

為了解決外部知識圖中缺少 facts 和上下文知識圖中存在冗余 facts 的問題,本文提出了一種常識推理的神經符號框架 HGN。HGN 可以聯合生成新邊的特征,優化圖結構,并學習圖網絡的參數,實現動態圖推理。實驗結果和用戶研究證明了該模型的有效性。

論文鏈接:https://openreview.net/forum?id=lJuOUWlAC8i

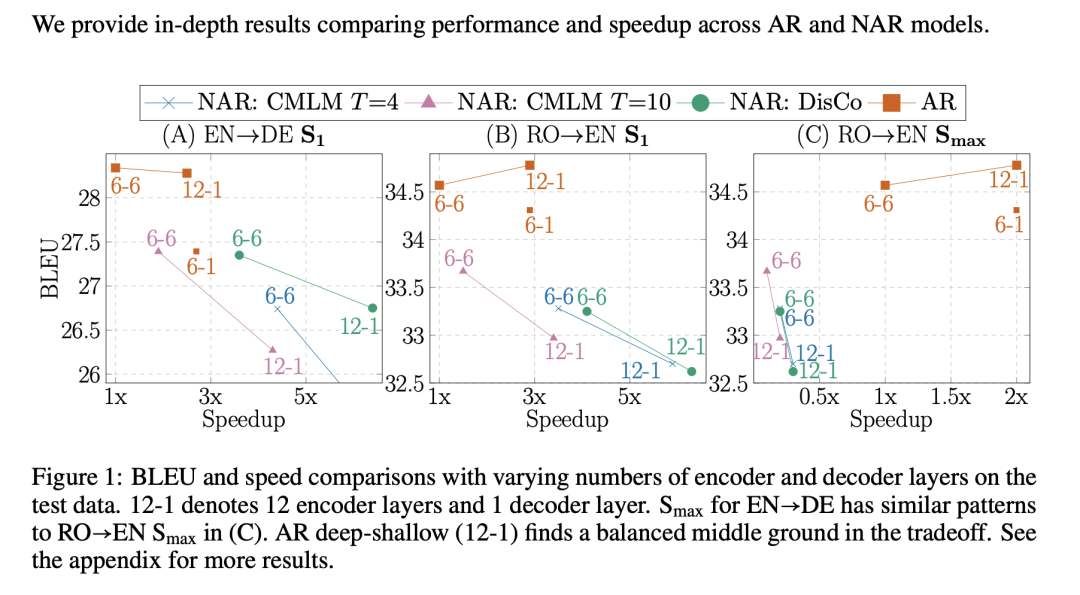

Deep Encoder, Shallow Decoder: Reevaluating Non-autoregressive Machine Translation

本文通過理論研究和實驗證明,通過簡單的層分配策略(深層編碼器-淺層解碼器)可以大大加快自回歸神經機器翻譯的速度。與強非自回歸模型相比,深-淺自回歸模型以近似的速度實現了翻譯質量的顯著提高。另外,深層編碼器-淺層解碼器的模型可以用于任何序列到序列任務,包括大規模預訓練。

論文鏈接:https://openreview.net/forum?id=KpfasTaLUpq

責任編輯:xj

原文標題:【NLP】近期必讀ICLR 2021相關論文

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

數據

+關注

關注

8文章

7067瀏覽量

89109 -

深度學習

+關注

關注

73文章

5504瀏覽量

121222 -

nlp

+關注

關注

1文章

489瀏覽量

22049

原文標題:【NLP】近期必讀ICLR 2021相關論文

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

MGMF552L1H6M-MINAS A6BU 系列 技術資料 -基本功能規格篇- 松下

MGMF552L1H6M-MINAS A6BU 系列 技術資料 -EtherCAT 通信規格篇- 松下

MGMF552L1H6M-MINAS A6B 系列 (EtherCAT) 技術資料 -基本功能規格篇- 松下

MGMF552L1H6M-MINAS A6N系列通用型使用說明書 (綜合篇) 松下

MGMF552L1H6-MINAS A6BN 系列 技術資料 -EtherCAT 通信規格篇- 松下

MGMF552L1H6-MINAS A6BL (EtherCAT) 系列 技術資料 -基本功能規格篇- 松下

MGMF552L1H6-MINAS A6B 系列 (EtherCAT) 技術資料 -基本功能規格篇- 松下

MGMF552L1H6-MINAS A6N系列 (RTEX) 技術資料 -RTEX通信規格篇- 松下

MGMF552L1H6-MINAS A6S 系列 技術資料 -Modbus通信規格?Block 動作功能篇- 松下

MGMF552L1H6-MINAS A6系列通用型使用說明書 (綜合篇) 松下

雙通道(6相+1相)或(5相+2相)D-CAP+?降壓多相控制器TPS53679 數據表

近期必讀的6篇ICLR 2021相關論文

近期必讀的6篇ICLR 2021相關論文

評論