CEVA 是無線連接和智能傳感技術的領先授權商。我們的產品可幫助原始設備制造商 (OEM) 為移動設備、消費者、汽車、機器人、工業和物聯網等多種終端市場,設計節能、智能和聯網的設備。

CEVA

https://www.ceva-dsp.com/

在本文中,我們將說明如何使用適用于微控制器的 TensorFlow Lite (TensorFlow Lite for Microcontrollers, TFLM),在基于 CEVA-BX DSP 內核的裸機開發板上部署名為 WhisPro 的語音識別引擎及前端。WhisPro 可在設備端有效識別隨時出現的喚醒詞和語音命令。

適用于微控制器的 TensorFlow Lite

https://tensorflow.google.cn/lite/microcontrollers

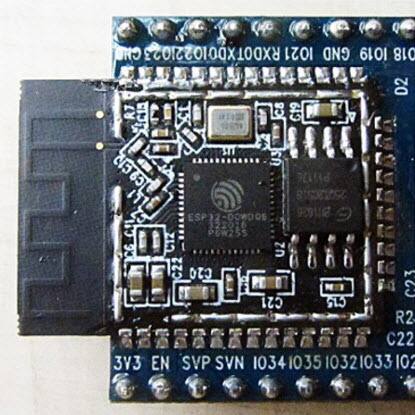

圖 1 CEVA 多麥克風 DSP 開發板

WhisPro 簡介

WhisPro 是語音識別引擎及前端,主要在低功耗、資源受限的邊緣設備上運行,包含負責音頻樣本處理到檢測的整個數據流。

WhisPro 支持兩種邊緣設備用例:

始終開啟的喚醒詞檢測引擎。在此用例中,WhisPro 用于在檢測到預定義的短語時喚醒處于睡眠模式下的設備。

語音指令。在此用例中,WhisPro 用于啟用基于語音的接口。用戶可以使用自己的聲音來控制設備。常用指令有:調高音量、調低音量、播放、停止等。

WhisPro 可在集成了 CEVA BX DSP 內核的任何 SoC 上啟用語音接口,從而為希望參與語音接口變革的 OEM 和原始設計制造商 (ODM) 降低了準入門檻。

我們的動機

最初,WhisPro 是使用名為 CEVA NN Lib 的內部神經網絡庫實現的。盡管該實現具有出色的性能,但是開發過程相當復雜。我們意識到,我們可以通過移植 TFLM 運行庫,并針對目標硬件對其進行優化的方式,讓整個模型移植過程將變得透明且更加可靠(大幅減少需要編寫、修改和維護的代碼量)。

為 CEVA-BX DSP 系列構建 TFLM

首先,我們需要弄清楚如何將 TFLM 移植到我們的平臺上。我們發現,遵循《指南:移植到新平臺》會非常有用。

指南:移植到新平臺

https://github.com/tensorflow/tensorflow/blob/master/tensorflow/lite/micro/docs/new_platform_support.md

在指南的指導下,我們執行了以下操作:

驗證我們的平臺支持 DebugLog() 實現。

在 CEVA 基于 Eclipse 的 IDE 中創建 TFLM 運行庫項目:

在 CEVA 的 IDE 中創建新的 CEVA-BX 項目

將所有必需的源文件添加到項目中

為 CEVA-BX 內核構建 TFLM 運行庫。

這需要對路徑(并非所有必需文件都在“micro”目錄下)、鏈接器腳本文件等編譯器標記進行常規的調整。

DebugLog()

https://github.com/tensorflow/tensorflow/blob/master/tensorflow/lite/micro/debug_log.cc

模型移植過程

我們將從模型中的 Keras 實現開始演示。以下是我們在裸機目標硬件上部署模型所采取的步驟:

使用 TF 內置轉換器將 TensorFlow 模型轉換為 TensorFlow Lite 模型:

$ python3 -m tensorflow_docs.tools.nbfmt [options] notebook.ipynbconverter = tf.lite.TFLiteConverter.from_keras_model(keras_model) converter.experimental_new_converter = True tflite_model = converter.convert() open("converted_to_tflite_model.tflite", "wb").write(tflite_model)

執行量化操作:

$ python3 -m tensorflow_docs.tools.nbfmt [options] notebook.ipynbconverter.optimizations = [tf.lite.Optimize.OPTIMIZE_FOR_SIZE] converter.target_spec.supported_ops = [tf.lite.OpsSet.TFLITE_BUILTINS_INT8] converter.representative_dataset = representative_data_gen

使用 xxd 將 TensorFlow Lite 模型轉換為 TFLM 模型:

$ python3 -m tensorflow_docs.tools.nbfmt [options] notebook.ipynb$> xxd –I model.tflite > model.cc

TF 內置轉換器

https://tensorflow.google.cn/lite/convert

量化

https://tensorflow.google.cn/lite/performance/model_optimization#quantization

xxd

https://linux.die.net/man/1/xxd

這里,我們發現TFLM(在當時)未能很好地支持模型的某些層(如GRU)。我們期待,隨著 TFLM 的繼續完善,以及 Google 和 TFLM 社區的持續投入,類似問題將大幅減少。

在我們的案例中,我們選擇了相對容易的方式:在完全連接層方面重新實現GRU層。

集成

接下來是將 TFLM 運行庫和轉換后的模型集成到我們現有的嵌入式 C 前端。該前端將處理音頻預處理和特征提取操作。

即使我們的前端在編寫時并未考慮 TFLM,但因其有較高的模塊化程度,可通過實現單個簡單的封裝容器函數來輕松完成集成,具體步驟如下:

將 TFLM 運行庫鏈接到我們的嵌入式 C 應用(WhisPro 前端)

實現 wrapper-over-setup 函數,用于將模型映射到可用的數據結構中,以分配解釋器和張量

實現 wrapper-over-execute 函數,用于將 WhisPro 前端傳遞的數據映射到實際執行函數使用的 tflite 張量

將對原始模型執行函數的調用替換為對 TFLM 實現的調用

過程可視化

模型的移植過程將由以下兩者執行:

微控制器供應商(在本例中為 CEVA),負責為自身硬件架構優化 TFLM。

微控制器用戶(在本例中為 CEVA WhisPro 開發者),負責使用優化的 TFLM 運行庫在目標微控制器上部署基于神經網絡的模型。

未來計劃

此項研究已證實 TFLM 平臺對我們非常重要。此外,通過支持 TFLM,我們可以在邊緣設備上輕松部署神經網絡模型,從而為我們的客戶和合作伙伴帶來更多的價值。我們致力于通過以下方式在 CEVA-BX DSP 系列上深化對 TFLM 的支持:

積極開發 TFLM 項目,以便提高層覆蓋率和平臺總體的成熟度。

對于在 CEVA-BX 內核上執行的 TFLM 運算符,加大對其的優化力度,以實現完整覆蓋。

最終想法

盡管移植過程中遇到了一些困難,但我們最終還是取得了巨大的成功,整個項目耗時約 4 至 5 天。除此之外,從頭開始用 C 語言實現模型,以及手動編寫從 Python 到 C 的模型轉換腳本還需要耗費 2 至 3 周的時間,并進行大量的調試工作。

責任編輯:lq

-

微控制器

+關注

關注

48文章

7549瀏覽量

151378 -

語音識別

+關注

關注

38文章

1739瀏覽量

112649 -

智能傳感

+關注

關注

1文章

107瀏覽量

16553 -

TensorFlow Lite

+關注

關注

0文章

26瀏覽量

621

原文標題:案例分享 | CEVA 使用 TensorFlow Lite 在邊緣設備部署語音識別引擎及前端

文章出處:【微信號:tensorflowers,微信公眾號:Tensorflowers】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

FPGA 與微控制器優缺點比較

ESP32 微控制器系列指南

MCX N系列微控制器適用于安全、智能的電機控制和機器學習應用

適用于5V輸入系統的高效DSP電源控制器TPS56100數據表

貿澤電子開售適用于智能電機控制和機器學習應用的 NXP Semiconductors MCX微控制器

適用于安全相關應用中微控制器的TPS653853A-Q1andTPS653854A-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653851A-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653850-Q1多軌電源數據表

適用于3.3VSRAM 電源監控和開關控制器bq2205LY數據表

東芝推出適用于電機控制的Arm Cortex-M4微控制器

適用于安全相關應用中微控制器的TPS653853-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653853A-Q1andTPS653854A-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653850A-Q1andTPS653852A-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653851A-Q1多軌電源數據表

適用于安全相關應用中微控制器的TPS653850-Q1多軌電源數據表

如何使用適用于微控制器的TensorFlow Lite

如何使用適用于微控制器的TensorFlow Lite

評論