當臨床醫生將AI應用于女性患者時,主要接受男性X射線訓練的AI將表現不佳。如果患者皮膚黝黑并且大多數訓練圖像來自皮膚白皙的患者,則用于皮膚病學照片診斷皮膚癌的算法將使這項工作陷入困境。等等。這種偏見的例子在醫療保健AI的裝甲中積蓄了不可忽視的缺點。

當然,即使可行,也很難從各種各樣的患者群體中收集適合AI的培訓數據。但是,如果醫療保健中的AI無法幫助某些最脆弱的患者人群,那么它如何幫助改善美國在人口水平上的健康的事業呢?

11月17日發表在《科學美國人》上的一篇觀點文章中,三位斯坦福大學的醫學博士/博士對該主題提出了最好的想法。

“人工智能的偏見是一個復雜的問題;僅提供各種培訓數據并不能保證消除偏見。” Kaushal,Altman和Langlotz寫道。“還提出了其他一些問題,例如,人工智能工具的開發商和出資者之間缺乏多樣性;從多數群體的角度看待問題的框架;關于數據的隱含偏見假設;以及使用AI工具的輸出來無意或無意地使偏差永久化。”

他們指出,研究人員正在嘗試通過構建可從有限輸入中推斷出廣泛輸出的算法來解決數據不一致的問題。

作者寫道:“通過這些創新,可能會出現減少AI對海量數據集需求的新方法。”“但是目前,確保用于訓練算法的數據的多樣性對于我們理解和緩解AI偏差的能力至關重要。”

為此,他們呼吁建立所需的技術,法規,經濟和隱私基礎架構,以收集不僅大而且足夠多樣化的數據,以培訓醫學AI,使世界各地的所有患者受益。

責任編輯:lq

-

醫療保健

+關注

關注

4文章

315瀏覽量

30714 -

AI

+關注

關注

87文章

30807瀏覽量

268954 -

人工智能

+關注

關注

1791文章

47229瀏覽量

238345

發布評論請先 登錄

相關推薦

在AC off時, DRV632輸出耳機會有爆音一聲,如何改善?

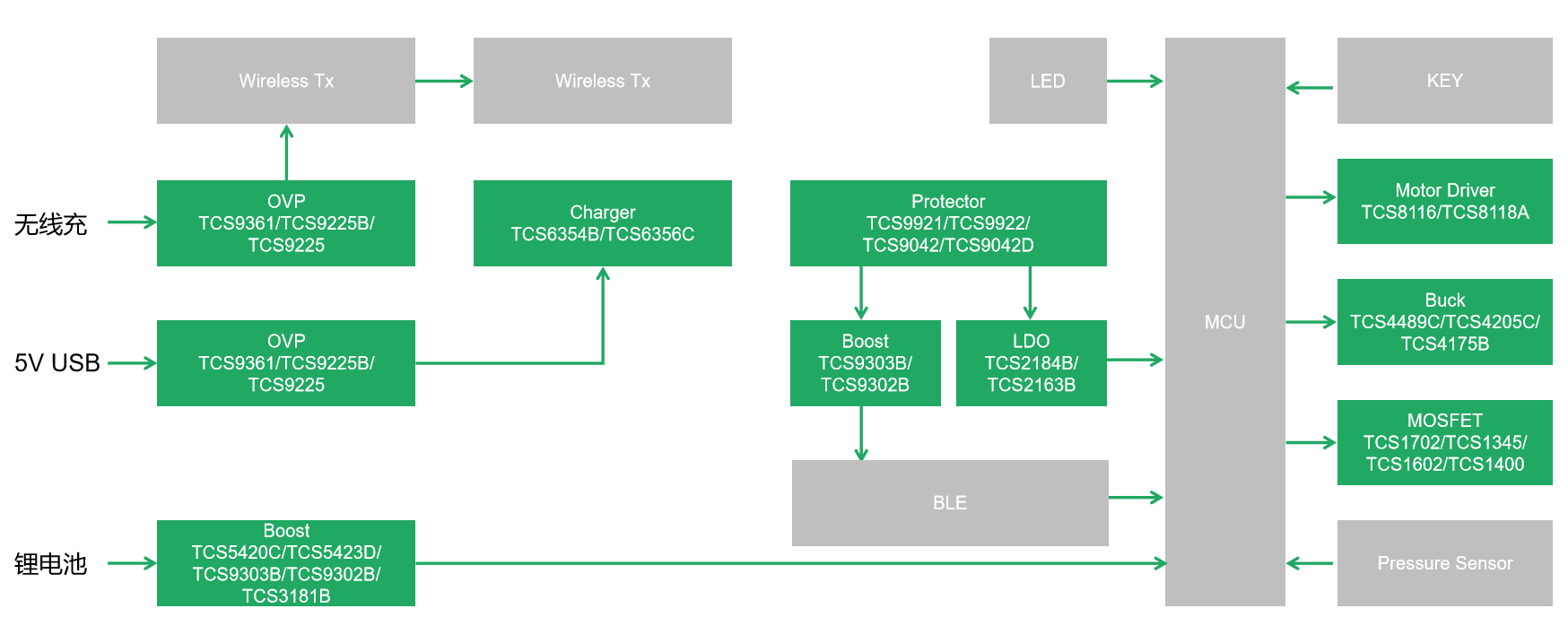

湯誠科技電動牙刷芯片解決方案,口腔健康新選擇

TAS6424的開關頻率2.MHz 在EMC CE電壓法測試中出現超標情況,請問如何改善?

怎么樣提高verilog代碼編寫水平?

LMH7322怎樣去改善輸出波形呢 ?

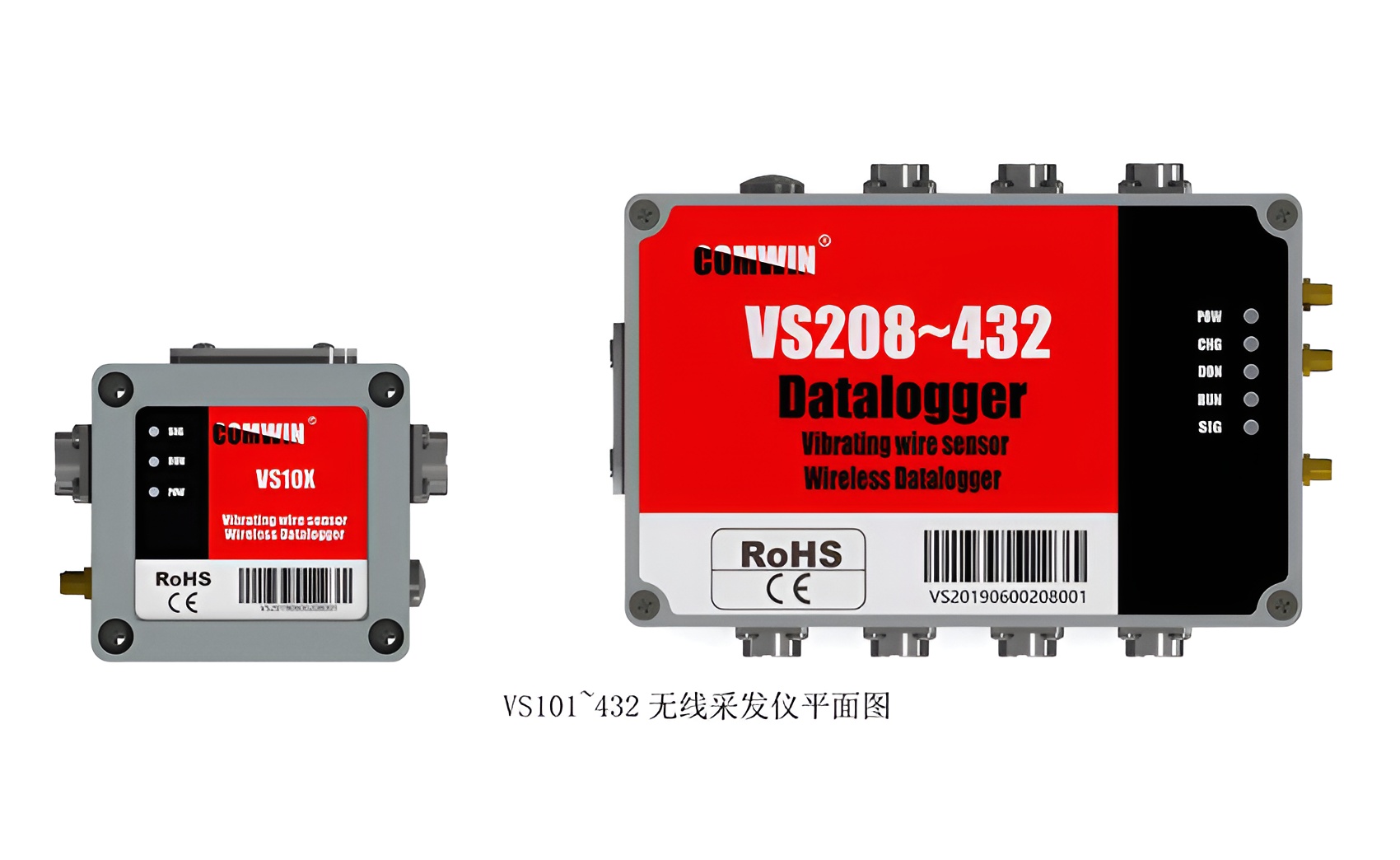

振弦采集儀:幫助工程師準確評估結構健康狀況的利器

藍牙模塊在健康醫療領域的創新應用

微軟與可汗學院攜手,提供人工智能工具免費課程給美國教師?

在選擇美國硅谷站群服務器時需要特別注意什么?

輻射RE整改:科學應對輻射環境,建設健康未來?|深圳比創達電子EMC a

簡述MinewSemi的GNSS模塊引領體育與健康科技革新

振弦采集儀在橋梁健康監測中的應用與分析

如何幫助改善美國在人口水平上的健康的事業呢?

如何幫助改善美國在人口水平上的健康的事業呢?

評論