導(dǎo)讀:在NeurIPS 2020上,商湯新加坡團(tuán)隊提出的Balanced-Meta Softmax (BALMS), 針對真實世界中常見的長尾數(shù)據(jù)分布提出了新的視覺識別方案。在優(yōu)化目標(biāo)方面,BALMS 提出一種新的損失函數(shù),Balanced Softmax,來修正長尾設(shè)定下因訓(xùn)練與測試標(biāo)簽分布不同而導(dǎo)致的偏差。在優(yōu)化過程方面,BALMS提出 Meta Sampler來自動學(xué)習(xí)最優(yōu)采樣率以配合Balanced Softmax,避免過平衡問題。BALMS在長尾圖像分類與長尾實例分割的共四個數(shù)據(jù)集上取得SOTA表現(xiàn)。這項研究也被收錄為ECCV LVIS workshop的spotlight。

論文名稱: Balanced Meta-Softmax for Long-Tailed Visual Recognition

問題和挑戰(zhàn)

真實世界中的數(shù)據(jù)分布大多符合長尾分布:常見類比占據(jù)了數(shù)據(jù)集中的主要樣本,而大量的罕見類別只在數(shù)據(jù)集中少量出現(xiàn)。例如一個動物圖片數(shù)據(jù)集中,寵物貓的圖片數(shù)量可能遠(yuǎn)遠(yuǎn)超過熊貓的圖片數(shù)量。

由于長尾現(xiàn)象對算法落地造成了很大的挑戰(zhàn),視覺社區(qū)對這一問題的關(guān)注日漸增加,近年陸續(xù)推出了一些長尾數(shù)據(jù)集,例如大規(guī)模實例分割數(shù)據(jù)集LVIS。我們發(fā)現(xiàn)長尾問題的難點主要存在于以下兩個方面:

1)優(yōu)化目標(biāo)。根據(jù)長尾問題的設(shè)定,訓(xùn)練集是類別不均衡的。然而主流的指標(biāo),如mean AP (mAP),衡量全部類別上的平均精度,因此鼓勵算法在類別平衡的測試集上取得較好的表現(xiàn)。這導(dǎo)致了訓(xùn)練與測試時標(biāo)簽分布不同的問題,我們稱之為標(biāo)簽分布遷移。

2)優(yōu)化過程。罕見類別在模型訓(xùn)練過程中很少出現(xiàn),因此無法在優(yōu)化過程中提供足夠的梯度。這使得即使我們有了一個較好的優(yōu)化目標(biāo),也很難使模型收斂到對應(yīng)的全局最優(yōu)。

方法介紹

1. Balanced Softmax

Softmax函數(shù)常常被用來將模型輸出轉(zhuǎn)化為物體屬于每個類別的條件概率。

應(yīng)用貝葉斯定理可以發(fā)現(xiàn)常規(guī)的Softmax回歸會受到標(biāo)簽分布遷移的影響,并作出帶偏差的估計。這個偏差導(dǎo)致Softmax回歸出的分類器更傾向于認(rèn)為樣本屬于常見類別。

舉一個簡單的例子,考慮這樣一個任務(wù):通過性別來分類貓和狗。這個任務(wù)看起來是無法完成的,因為我們知道性別在貓和狗上是均勻分布的。無論貓還是狗,都有50%的可能性是雌性和50%的可能性是雄性,因此只靠性別我們無法區(qū)別貓和狗。

有趣的是,當(dāng)我們的訓(xùn)練數(shù)據(jù)是類別不平衡的時,比如有90%的貓和10%的狗,我們的估計就會出現(xiàn)偏差:這時無論是雄性還是雌性,我們都會傾向于認(rèn)為它是一只貓。在這樣的訓(xùn)練數(shù)據(jù)上學(xué)習(xí)到的分類器就會天然帶有對常見類別的偏愛。

為了避免這個偏差,我們從多項分布的Exponential Family形式出發(fā)重新對Softmax進(jìn)行了推導(dǎo)并顯式考慮了標(biāo)簽分布遷移,得到了適合長尾問題的Balanced Softmax。同時,我們發(fā)現(xiàn)Balanced Softmax可以近似地最小化長尾設(shè)定下的泛化錯誤上界。

為了分析Balanced Softmax的效果,我們將模型在測試集上預(yù)測的分?jǐn)?shù)在每個類別上累加,用來計算模型預(yù)測的標(biāo)簽分布。理想情況下,模型在測試集上預(yù)測出的標(biāo)簽分布應(yīng)該是平衡的。在下圖中我們對不同模型的預(yù)測類別進(jìn)行了可視化,類別按照出現(xiàn)頻率降序排列,第0類為出現(xiàn)次數(shù)最多的類。我們發(fā)現(xiàn)藍(lán)色線代表的常規(guī)Softmax明顯地偏向于常見類別,橙色線代表的Equalization Loss [1] 通過去除某閾值以下罕見類別的負(fù)樣本梯度緩解了這一問題,而紅色線代表的Balanced Softmax則進(jìn)一步達(dá)到了最平衡的預(yù)測類別分布。

2. 元采樣器Meta Sampler

雖然我們得到了一個適合長尾問題的理想的優(yōu)化目標(biāo),優(yōu)化過程本身依然充滿挑戰(zhàn):罕見類別只能在訓(xùn)練中出現(xiàn)極少次數(shù),因此無法很好地貢獻(xiàn)到訓(xùn)練梯度。解決這一問題的最常見的方法是類別均衡采樣 (CBS)[2],也就是對每個類別采樣同樣數(shù)量的樣本來組成訓(xùn)練批次。然而,實驗表明直接將Balanced Softmax與CBS一起使用會導(dǎo)致模型表現(xiàn)下降,于是我們對兩者一起使用時的梯度進(jìn)行了分析。在假設(shè)接近收斂時,我們有:

理想情況下每個類別的梯度的權(quán)重應(yīng)和類別內(nèi)樣本數(shù)量成反比,但上式中的權(quán)重為和類別內(nèi)樣本數(shù)量成平方反比。我們將這個現(xiàn)象稱為過平衡問題。

下圖展示了一個對過平衡問題的可視化。這是一個類別不平衡的二維數(shù)據(jù)三分類問題,三個類別分別為紅、黃、藍(lán),樣本數(shù)量分別為10000、100和1。可以發(fā)現(xiàn)Balanced Softmax和CBS一起使用時,優(yōu)化過程會被藍(lán)色的罕見類別主導(dǎo)。

為了解決過平衡問題,我們提出了Meta Sampler(元采樣器),一種可學(xué)習(xí)版本的CBS。Meta Sampler使用元學(xué)習(xí)的方法,顯式地學(xué)習(xí)當(dāng)前最佳的采樣率,從而更好地配合Balanced Softmax的使用。

下圖展示了我們對不同模型預(yù)測的標(biāo)簽分布進(jìn)行的可視化。其中,紫色線代表的Balanced Softmax與CBS的組合由于過平衡問題,明顯地偏向于尾部類別。而紅色線代表的Balanced Softmax與Meta Sampler的組合則很好地解決了這一問題,最終取得了最為均衡的標(biāo)簽分布。

實驗結(jié)果

我們在圖像分類(CIFAR-10/100-LT,ImageNet-LT,Places-LT)與實例分割(LVIS-v0.5)兩個任務(wù)上分別進(jìn)行了實驗驗證。實驗結(jié)果顯示了Balanced Softmax和Meta Sampler對模型表現(xiàn)都有明顯的貢獻(xiàn)。兩者的組合,Balanced Meta-Softmax (BALMS),在這兩個任務(wù)上都達(dá)到或超過了SOTA結(jié)果,尤其在最具挑戰(zhàn)性的LVIS數(shù)據(jù)集上大幅超過了之前的SOTA結(jié)果。

這項研究也被收錄為ECCV LVIS workshop的Spotlight,關(guān)于LVSI-v1.0的相關(guān)實驗結(jié)果可以在LVSI workshop主頁上找到(Team Innova)。

結(jié)語

BALMS對長尾問題下的概率建模以及采樣策略進(jìn)行了探討。我們發(fā)現(xiàn)常用的Softmax回歸在存在標(biāo)簽分布遷移時會出現(xiàn)估計偏差,并提出了Balanced Softmax來避免這個偏差。另一方面,我們發(fā)現(xiàn)類別均衡采樣器在與Balanced Softmax一起使用時會導(dǎo)致過平衡問題,于是提出元采樣器來顯式學(xué)習(xí)最優(yōu)采樣策略。我們的解決方案在長尾圖像分類與長尾實例分割任務(wù)上均得到了驗證。歡迎關(guān)注我們的開源代碼庫,希望BALMS可以成為未來長尾學(xué)習(xí)的良好基線。

責(zé)任編輯:xj

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7006瀏覽量

88949 -

視覺識別

+關(guān)注

關(guān)注

3文章

89瀏覽量

16726

發(fā)布評論請先 登錄

相關(guān)推薦

開源項目 ! 利用邊緣計算打造便攜式視覺識別系統(tǒng)

金蝶新加坡數(shù)據(jù)中心盛大開業(yè)

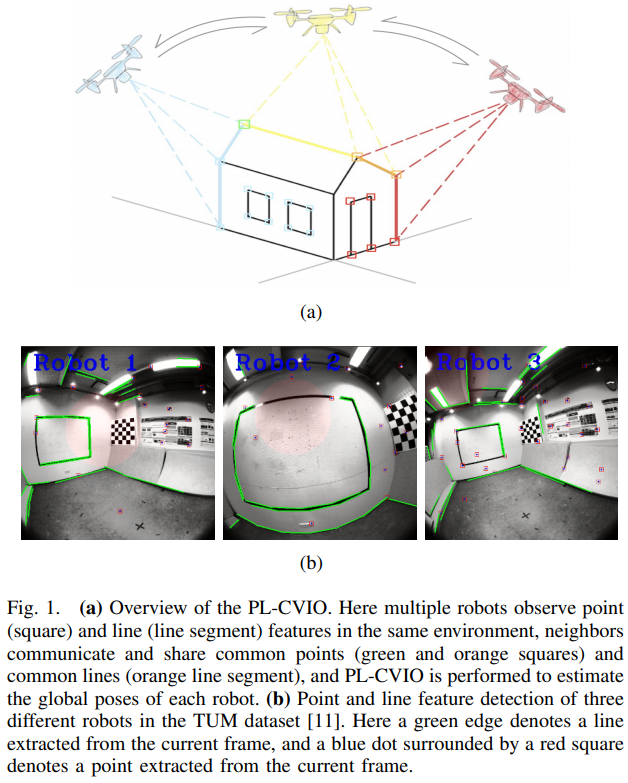

一種完全分布式的點線協(xié)同視覺慣性導(dǎo)航系統(tǒng)

瑞薩針對顯示應(yīng)用的MCU和方案介紹

新加坡智慧停車迎來革新,AMD攜手恒星系統(tǒng)打造新型AI解決方案

格芯斬獲新加坡員工體驗大獎(EX Awards)八項殊榮

基于FPGA EtherCAT的六自由度機(jī)器人視覺伺服控制設(shè)計

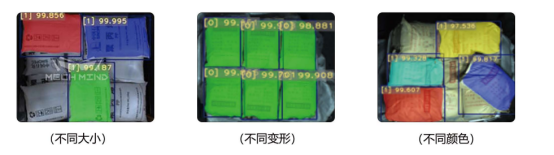

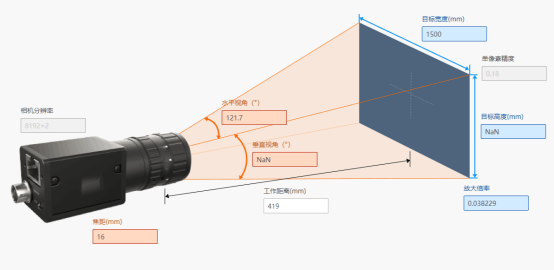

解決方案|3D視覺引導(dǎo)多SKU紙箱混拆

解決方案|基于3D視覺技術(shù)的鋁合金板件刷油烘干自動化上下料

蘋果公司巨資2.5億美元擴(kuò)建新加坡園區(qū)

分布式存儲與計算:大數(shù)據(jù)時代的解決方案

機(jī)器視覺的圖像目標(biāo)識別方法綜述

計算機(jī)視覺:AI如何識別與理解圖像

湯新加坡團(tuán)隊 針對長尾數(shù)據(jù)分布提出了視覺識別方案

湯新加坡團(tuán)隊 針對長尾數(shù)據(jù)分布提出了視覺識別方案

評論