機器學習模型在實驗室中調整和調整到近乎完美的性能,但在現實環境中往往會失敗,這已經不是什么秘密了。這通常被歸結為人工智能接受訓練和測試的數據與它在現實中遇到的數據不匹配,這個問題被稱為數據轉移。例如,經過訓練,能夠在高質量的醫學圖像中發現疾病跡象的人工智能,將難以識別繁忙的診所中廉價相機捕捉到的模糊或裁剪的圖像。

現在,谷歌的7個不同團隊的40名研究人員發現了機器學習模型常見失敗的另一個主要原因。這被稱為“不規范”,它可能是一個比數據轉移更大的問題。領導這項研究的Alex D‘amour說:“我們對機器學習模型的要求比我們目前的方法所能保證的要多。”

D’amour最初的調查如同滾雪球般滾來滾去,數十名谷歌研究人員最終著眼于一系列不同的人工智能應用,從圖像識別到自然語言處理(NLP)再到疾病預測。他們發現,不規范的要求是所有這些項目表現不佳的原因。問題在于機器學習模型的訓練和測試方式,沒有簡單的解決辦法。

粗略地說,建立一個機器學習模型需要在大量的例子上訓練它,然后在一堆它還沒有見過的類似的例子上測試它。當模型通過測試時,就完成了。

谷歌的研究人員指出,這個標準太低了。訓練過程可以產生許多不同的全部通過測試的模型,但是這些模型會有一些小差異,取決于諸如在培訓開始之前隨機值的神經網絡中的節點、訓練數據、被選中或者代表的方式、培訓運行的數量等等。如果這些微小的、隨機的差異不影響模型在測試中的表現,它們通常會被忽視。但事實證明,在現實世界中,它們會導致巨大的表現差異。

換句話說,如今用來構建大多數機器學習模型的過程無法區分哪些模型在現實世界中可行,哪些模型不可行。

為了解決這一問題,一種選擇是在培訓和測試過程中設計一個額外的階段,在這個階段中可以同時生產多個模型,而不是只生產一個。然后,這些相互競爭的模型可以在具體的現實任務中再次進行測試,以選擇最適合這項工作的模型。

那需要做很多工作。蘇黎世聯邦理工學院的機器學習研究員Yannic Kilcher說,但是對于像谷歌這樣建造和部署大型模型的公司來說,這樣做是值得的。谷歌可以提供50種不同版本的NLP模型,應用程序開發人員可以選擇最適合他們的一個,他說。

D ‘Amour和他的同事們還沒有解決這個問題,但正在探索改進培訓過程的方法。他表示:“我們需要更好地明確我們對模型的要求。”“因為最終的結果往往是,我們只是在模型在實際應用中失敗之后才發現這些要求。”

如果人工智能想要在實驗室之外產生和在實驗室內部一樣大的影響,那么進行修復是至關重要的。在谷歌從事醫療人工智能領域工作的合著者凱瑟琳海勒(Katherine Heller)表示,當人工智能在現實世界中表現不佳時,人們就不太愿意使用它了:“在殺手級應用方面,我們已經失去了很多信任,這是我們希望重新獲得的重要信任。”

責任編輯:xj

-

谷歌

+關注

關注

27文章

6164瀏覽量

105311 -

AI

+關注

關注

87文章

30761瀏覽量

268904 -

機器學習

+關注

關注

66文章

8408瀏覽量

132572 -

nlp

+關注

關注

1文章

488瀏覽量

22033

發布評論請先 登錄

相關推薦

【書籍評測活動NO.51】具身智能機器人系統 | 了解AI的下一個浪潮!

【「時間序列與機器學習」閱讀體驗】+ 簡單建議

【《大語言模型應用指南》閱讀體驗】+ 俯瞰全書

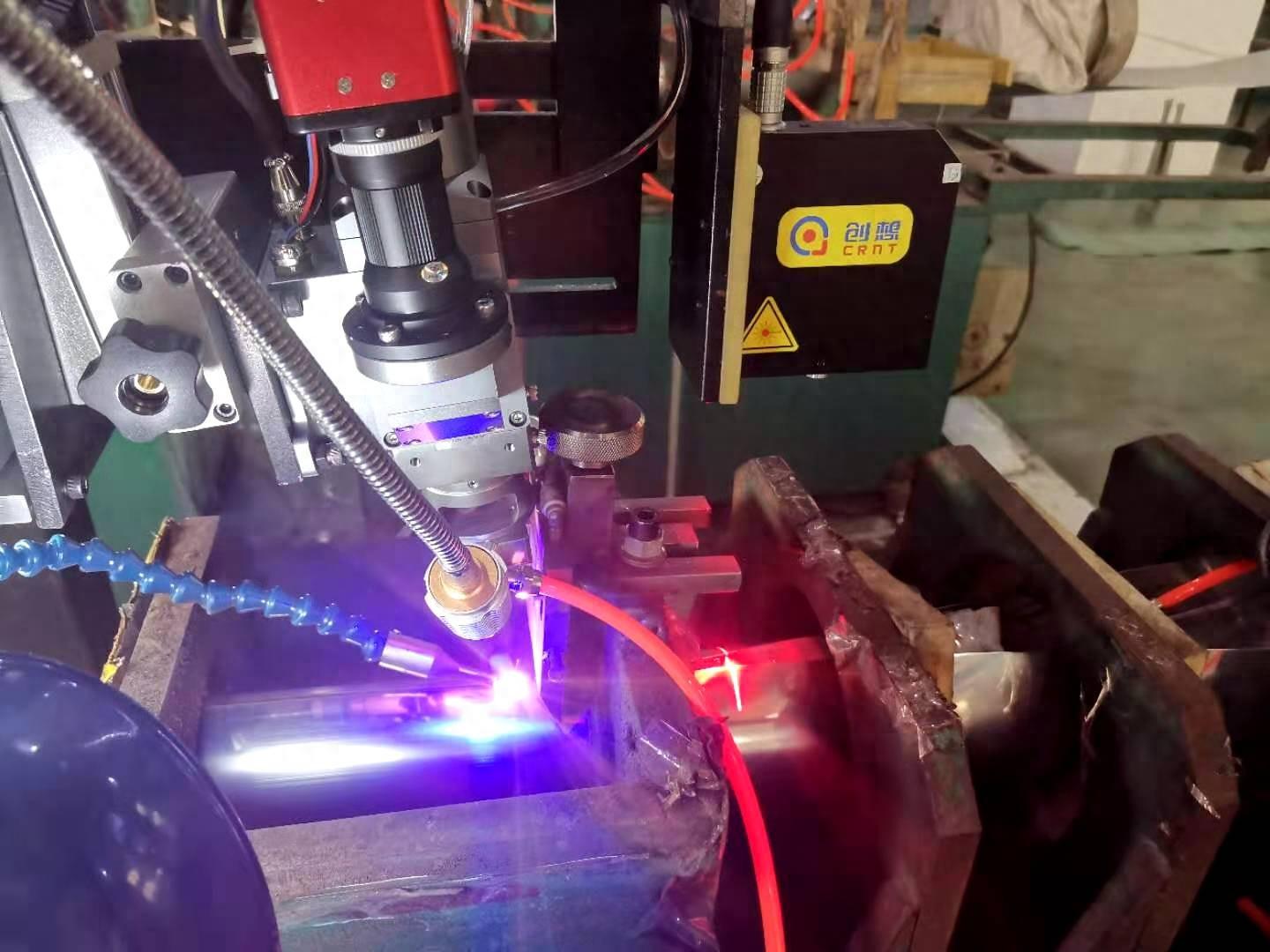

焊接質量缺陷產生的主要原因

谷歌研究人員發現了機器學習模型常見失敗的一個主要原因

谷歌研究人員發現了機器學習模型常見失敗的一個主要原因

評論