端到端關系抽取涉及兩個子任務:命名實體識別和關系抽取。近期研究多采用 joint 方式建模兩個子任務,而陳丹琦等人新研究提出一種簡單高效的 pipeline 方法,在多個基準上獲得了新的 SOTA 結果。

端到端關系抽取旨在識別命名實體,同時抽取其關系。近期研究大多采取 joint 方式建模這兩項子任務,要么將二者統一在一個結構化預測網絡中,要么通過共享表示進行多任務學習。 而近期來自普林斯頓大學的 Zexuan Zhong、陳丹琦介紹了一種非常簡單的方法,并在標準基準(ACE04、ACE05 和 SciERC)上取得了新的 SOTA 成績。該方法基于兩個獨立的預訓練編碼器構建而成,只使用實體模型為關系模型提供輸入特征。通過一系列精心檢驗,該研究驗證了學習不同的語境表示對實體和關系的重要性,即在關系模型的輸入層融合實體信息,并集成全局語境信息。 此外,該研究還提出了這一方法的高效近似方法,只需要在推斷時對兩個編碼器各執行一次,即可獲得 8-16 倍的加速,同時準確率僅小幅下降。

論文鏈接:https://arxiv.org/pdf/2010.12812.pdf pipeline 方法重回巔峰? 從非結構化文本中抽取實體及其關系是信息抽取中的基本問題。這個問題可以分解為兩個子任務:命名實體識別和關系抽取。 早期研究采用 pipeline 方法:訓練一個模型來抽取實體,另一個模型對實體之間的關系進行分類。而近期,端到端關系抽取任務已經成為聯合建模子任務系統的天下。大家普遍認為,這種 joint 模型可以更好地捕獲實體與關系之間的交互,并有助于緩解誤差傳播問題。 然而,這一局面似乎被一項新研究打破。近期,普林斯頓大學 Zexuan Zhong 和陳丹琦提出了一種非常簡單的方法,該方法可以學習基于深度預訓練語言模型構建的兩個編碼器,這兩個模型分別被稱為實體模型和關系模型。它們是獨立訓練的,并且關系模型僅依賴實體模型作為輸入特征。實體模型基于 span-level 表示而構建,關系模型則建立在給定 span 對的特定語境表示之上。 雖然簡單,但這一 pipeline 模型非常有效:在 3 個標準基準(ACE04、ACE05、SciERC)上,使用相同的預訓練編碼器,該模型優于此前所有的 joint 模型。 為什么 pipeline 模型能實現如此優秀的性能呢?研究者進行了一系列分析,發現:

實體模型和關系模型的語境表示本質上捕獲了不同的信息,因此共享其表示會損害性能;

在關系模型的輸入層融合實體信息(邊界和類型)至關重要;

在兩個子任務中利用跨句(cross-sentence)信息是有效的;

更強大的預訓練語言模型能夠帶來更多的性能收益。

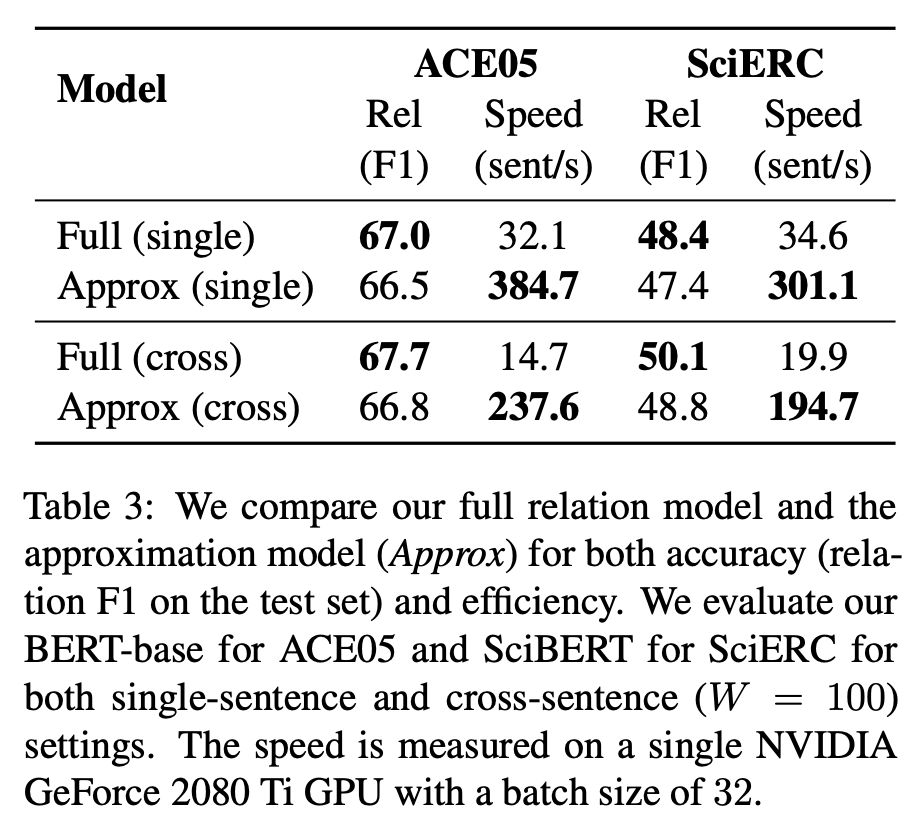

研究人員希望,這一模型能夠引發人們重新思考聯合訓練在端到端關系抽取中的價值。 不過,該方法存在一個缺陷:需要為每個實體對運行一次關系模型。為了緩解該問題,研究者提出一種新的有效替代方法,在推斷時近似和批量處理不同組實體對的計算。該近似方法可以實現 8-16 倍的加速,而準確率的下降卻很小(例如在 ACE05 上 F1 分數下降了 0.5-0.9%)。這使得該模型可以在實踐中快速準確地應用。 研究貢獻 該研究的主要貢獻有:

提出了一種非常簡單有效的端到端關系抽取方法,該方法學習兩個獨立編碼器,分別用于實體識別和關系抽取的。該模型在三個標準基準上達到了新 SOTA,并在使用相同的預訓練模型的時,性能超越了此前所有 joint 模型。

該研究經過分析得出結論:對于實體和關系而言,相比于聯合學習,學習不同的語境表示更加有效。

為了加快模型推斷速度,該研究提出了一種新穎而有效的近似方法,該方法可實現 8-16 倍的推斷加速,而準確率只有很小的降低。

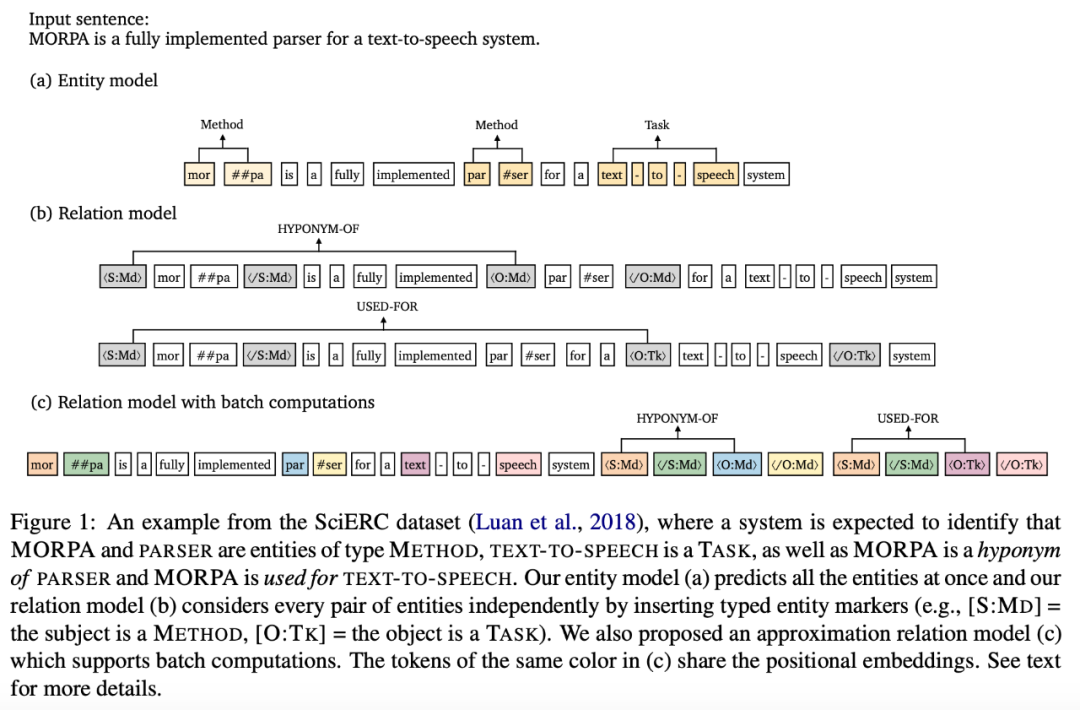

方法 該研究提出的模型包括一個實體模型和一個關系模型。如下圖所示,首先將輸入句子饋入實體模型,該模型為每一個 span 預測實體類型;然后通過嵌入額外的 marker token 在關系模型中獨立處理每對候選實體,以突出顯示主語、賓語及其類型。

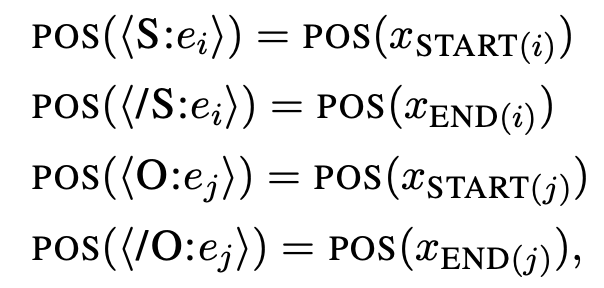

此外,研究者還介紹了該方法與 DYGIE++ 的區別(DYGIE++ 與該方法很接近,并且是最強的基線方法)。 1. 該研究提出的方法對實體模型和關系模型使用不同的編碼器,未使用多任務學習;預測得到的實體標簽直接作為關系模型的輸入特征。 2. 關系模型中的語境表示特定于每個 span 對。 3. 該方法用額外的語境擴展輸入,從而納入跨句信息。 4. 該方法未使用束搜索或圖傳播層,因此,該模型要簡單得多。 有效的近似方法 該研究提出的方法較為簡潔有效,但是它的缺點是需要對每一個實體對運行一次關系模型。為此,研究者提出一種新型高效的替代性關系模型。核心問題在于,如何對同一個句子中的不同 span 對重用計算,在該研究提出的原始模型中這是不可能實現的,因為必須為每個 span 對分別嵌入特定的實體標記。因此,研究者提出了一種近似模型,該模型對原始模型做了兩個重要更改。 首先,該近似方法沒有選擇直接將實體標記嵌入原始句子,而是將標記的位置嵌入與對應 span 的開始和結束 token 聯系起來:

其次,近似方法為注意力層添加了約束:使文本 token 只注意文本 token 不注意標記 token,實體標記 token 則可以注意所有文本 token,4 個標記 token 全部與同一個 span 對關聯。 這兩項更改允許模型對所有文本 token 重用計算,因為文本 token 獨立于實體標記 token。因而,該方法可以在運行一次關系模型時批量處理來自同一個句子的多個 span 對。 實驗 研究人員在三個端到端關系抽取數據集 ACE04、ACE054 和 SciERC 上進行方法評估,使用 F1 分數作為評估度量指標。 下表 2 展示了不同方法的對比結果:

從圖中可以看出,該研究提出的 single-sentence 模型實現了強大的性能,而納入跨句語境后,性能結果得到了一致提升。該研究使用的 BERT-base(或 SciBERT)模型獲得了與之前工作類似或更好的結果,包括那些基于更大型預訓練語言模型構建的模型,使用較大編碼器 ALBERT 后性能得到進一步提升。 近似方法的性能 下表展示了完全關系模型和近似模型的 F1 分數與推斷速度。在兩個數據集上,近似模型的推斷速度顯著提升。

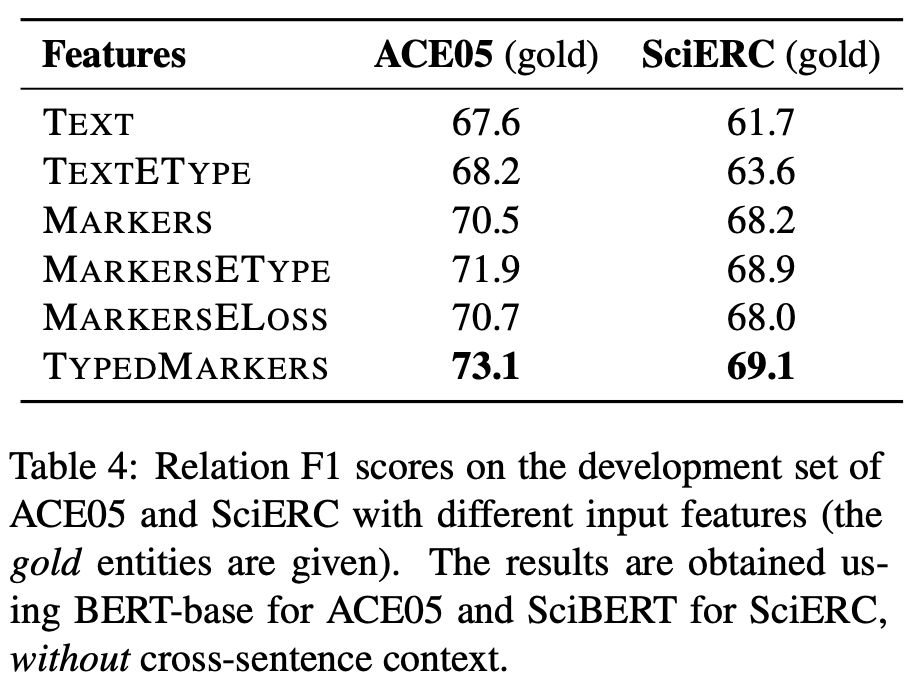

這個 pipeline 模型為什么超過了 joint 模型? 除了展示方法和性能以外,該研究還深入分析了這一 pipeline 模型取得如此優秀性能的原因。 鍵入文本標記(typed text marker)的重要性 該研究認為,為不同 span 對構建不同語境表示非常重要,早期融合實體類型信息可以進一步提升性能。 為了驗證鍵入文本標記的作用,研究者使用其不同變體在 ACE05 和 SciERC 數據集上進行實驗,包括 TEXT、TEXTETYPE、MARKERS、MARKERSETYPE、MARKERSELOSS、TYPEDMARKERS 六種。 下表 4 展示了這些變體的性能,從中可以看出不同的輸入表示確實對關系抽取的準確率產生影響。

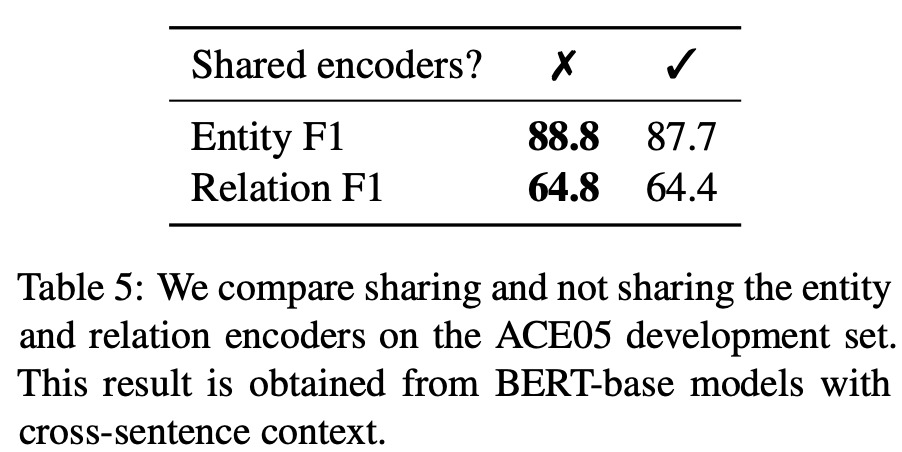

實體和關系如何交互 人們對 joint 模型的主要認知是,對兩個子任務之間交互的建模對彼此有所幫助。但這項研究并未采取這種方式,而是使用了兩個獨立的編碼器。 研究人員首先研究了共享兩個表示編碼器能否提升性能。如下表 5 所示,簡單地共享編碼器對實體 F1 和關系 F1 分數均有所損害。研究人員認為,其原因在于兩個任務具備不同的輸入格式,需要不同的特征來預測實體類型和關系,因此使用單獨的編碼器可以學得更好的任務特定特征。

該研究的分析結果顯示: 實體信息有助于預測關系,但實驗未表明關系信息可以大幅提升實體性能。 僅共享編碼器對該研究提出的方法無益。 如何緩解 pipeline 方式中的誤差傳播問題 pipeline 訓練的一個主要缺陷是誤差傳播問題。使用 gold 實體(及其類型)進行關系模型訓練,使用預測實體進行推斷,可能會導致訓練和測試之間存在差異。 為此,研究人員首先探究在訓練階段使用預測實體(而非 gold 實體)能否緩解這一問題。該研究采用 10-way jackknifing 方法,結果發現這一策略竟然降低了最終的關系性能。研究人員假設其原因在于訓練階段引入了額外的噪聲。 在目前的 pipeline 方法中,如果在推斷階段 gold 實體沒有被實體模型識別出來,則關系模型無法預測與該實體相關的任何關系。于是,研究人員考慮在訓練和測試階段,對關系模型使用更多 span 對。實驗結果表明,這無法帶來性能提升。 這些常識未能顯著提升性能,而該研究提出的簡單 pipeline 方法卻驚人的有效。研究者認為誤差傳播問題并非不存在或無法被解決,我們需要探索更好的解決方案。

責任編輯:lq

-

編碼器

+關注

關注

45文章

3815瀏覽量

138263 -

模型

+關注

關注

1文章

3527瀏覽量

50508 -

Pipeline

+關注

關注

0文章

29瀏覽量

9704

原文標題:陳丹琦新作:關系抽取新SOTA,用pipeline方式挫敗joint模型

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Matter 智能家居的通用語言

永磁同步電機二階迭代學習控制

AMD獲得一項玻璃基板技術專利

Python中dict支持多個key的方法

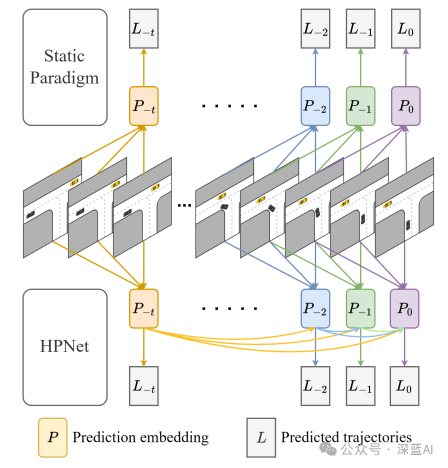

一種創新的動態軌跡預測方法

評論