相比于電子計算,光計算具有高速、高帶寬、低功耗的優勢,但目前光計算還不夠成熟,只在某些特定領域得到了非常有限的應用。近日,Nature 上一篇 Perspective 文章剖析了深度光學和深度光子學的人工智能推理應用,展示了該領域(尤其是光 - 電混合系統)的發展潛力。

為了高速且低功耗地執行各種應用中的人工智能任務,我們需要加速器。光計算系統也許能夠滿足這些領域特定的需求,但即便已經歷半個世紀的研究,通用型光計算系統仍還未發展成一項成熟的實用技術。但是,人工智能推理(尤其是用于視覺計算應用的推理)也許能為基于光學和光子學系統的推理提供機會。

本文將回顧用于人工智能的光學計算的近期研究成果并探討其潛力和挑戰。

計算系統的能力正與它們試圖理解的飛速增長的視覺數據進行軍備競賽。在自動駕駛、機器人視覺、智能家居、遙感、顯微技術、監控、國防和物聯網等多種應用中,計算成像系統都會記錄和處理前所未有的巨量數據。對這些數據的解讀不可能由人類完成,而是要使用基于人工智能(AI)構建的算法。

在這些應用之中,深度神經網絡(DNN)正快速發展成為視覺數據處理的標準算法方法。這主要是因為 DNN 在許多基準上都取得了當前最佳的結果,而且往往超出其它方法一大截。深度學習近來的這些突破性進展主要得益于現代圖形處理單元(GPU)的強大處理能力和并行計算能力以及大規模視覺數據集的可用性,這些進展讓 DNN 可以高效地使用監督式機器學習策略執行訓練。

但是,高端 GPU 和其它運行日趨復雜的神經網絡的加速器的功耗和帶寬需求非常高,它們需要大量處理時間而且具有尺寸龐大的外形。這些限制讓人難以在邊緣設備中使用 DNN,比如相機、自動化載具、機器人或物聯網外圍設備。以自動汽車中的視覺系統為例,其必須要能使用有限的計算資源實時地做出穩定可靠的決策。當汽車在高速行駛時,瞬間的決策關乎人的生死。事實上,如果計算成像系統能做到更精簡,那么幾乎所有邊緣設備都能從中受益,這能帶來更低的延遲以及尺寸、重量和功耗方面的改進。

DNN 一般都包含訓練和推理兩個階段,這兩個階段的計算需求差異很大。在訓練階段,會向 DNN 輸入大量有標注的樣本,然后針對某個特定任務,使用迭代方法優化該 DNN 的參數。訓練完成后,可使用該 DNN 來執行推理:以前向通過的方式向該網絡輸入一個數據(比如一張圖像),經過該網絡處理后計算得到所需結果。雖然某些應用也會使用 GPU 來執行推理,但對許多邊緣設備而言,由于前述原因,使用 GPU 并不現實。

盡管電子 AI 加速器很靈活,但光神經網絡(ONN)和光子回路可能為該應用與其它機器學習應用帶來一次范式轉換。光計算系統有望實現大規模的并行計算,同時設備尺寸還更小,而且在某些實現中的功耗非常低。事實上,在計算系統中使用光來實現通信的光互連(optical interconnect)技術已經在現如今的數據中心中得到了廣泛應用,而且在計算系統更深處越來越多地使用光互連可能是持續擴展的關鍵。

不同于電互連技術,隨著光學、光電和電子設備的更深度整合,光互連有望為通信的帶寬密度和單位比特的能量消耗帶來幾個數量級的提升和改善。這種改進過的互連技術能實現電 - 光混合 DNN,而且這種低功耗、高并行的集成技術還可用作模擬光處理器的部件。

盡管光計算機潛力巨大而且也已歷經約半個世紀的研究,但通用型光計算仍還不是一項成熟的實用技術。但是,推理任務(尤其是用于視覺計算應用的推理任務)已可使用全光學或光 - 電混合系統來很好地實現。舉個例子,線性光學元件可以近乎「免費」地計算卷積、傅立葉變換、隨機投影和許多其它運算,因為這些運算可作為光與物質交互或光傳播的副產物。這些運算是 DNN 架構的基本構建模塊,驅動著大多數現代視覺計算算法。我們有望以光速執行這些運算,同時功耗需求很低乃至沒有。本文認為這具有變革性的潛力。

回顧光計算的歷史

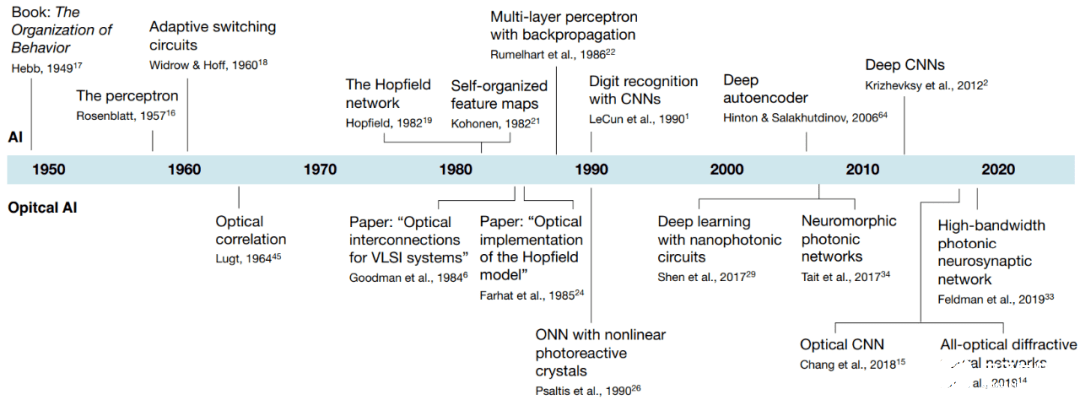

下圖 1 展示了人工智能及相關光學和光子學實現的時間軸。其中展示了一些經過挑選的里程碑和論文,并重點關注了近期進展。

以具體年份計則如下所示:

1949 年,Donald O. Hebb 發表《行為的組織(The Organization of Behavior)》一書

1957 年,Frank Rosenblatt 提出感知器

1960 年,Widrow & Hoff 提出自適應開關電路

1964 年,Lugt 提出光學相關性(Optical correlation)

1982 年,John Hopfield 提出 Hopfield 網絡;Kohonen 提出自組織特征圖

1984 年,Goodman et al. 發表論文《用于超大規模集成電路系統的光互連(Optical interconnections for VLSI systems)》

1985 年,Farhat et al. 發表論文《Hopfield 模型的光學實現(Optical implementation of the Hopfield model)》

1986 年,Rumelhart et al. 提出使用反向傳播的多層感知器

2006 年,Hinton & Salakhutdinov 提出深度自編碼器

2012 年,Krizhevksy et al. 提出深度 CNN

2017 年,Shen et al. 提出使用納米光子電路的深度學習;Tait et al. 提出神經形態光子網絡

2018 年,Chang et al. 提出光 CNN;Lin et al. 提出全光衍射神經網絡

2019 年,Feldman et al. 提出高帶寬光子神經突觸網絡

用于人工智能的光子回路

現代 DNN 架構是級聯的線性層后面跟著非線性激活函數,而且這會重復很多次。最一般形式的線性層是全連接層。在這種情況下,每個輸出神經元都是所有輸入神經元的加權和。從數學上看,這可以表示成一種矩陣 - 向量乘法,從而可以有效地使用光學技術實現。也就是說我們可以使用光子回路來執行人工智能的相關計算。不過相關技術還面臨著可編程性等有待解決的問題。

使用自由空間、透鏡和復雜介質進行計算

還有一種可替代光子回路的選擇:在自由空間或某種介質中傳播的光場上直接構建計算能力。(見下圖 2)從數學上講,在自由空間中傳播的波可用基爾霍夫衍射積分(Kirchhoff’s diffraction integral)來描述,這相當于讓該場與一個固定的核(kernel)執行卷積。該運算又是卷積神經網絡(CNN)的一大基本構建模塊,而 CNN 又是最常用的視覺計算框架。

圖 2:光波傳播概況。如圖所示,上面一行展示了波在自由空間和不同介質中的傳播,下面一行是相應的線性矩陣運算。其中 a 是波穿過自由空間的情況,其在數學上被描述成波場與一個復值核的卷積。b-g 則使用了不同的介質,它們也因此有各自不同的矩陣。

使用深度計算光學和成像來執行推理

計算成像領域研究的是光學和圖像處理的聯合設計,這可用于增強計算式相機(computational camera)能力等應用。將相機解釋成編碼器 - 解碼器系統會很有幫助。因此,我們可以從整體角度將相機設計問題看作是光學和成像處理的端到端優化問題。因此可以針對經由損失函數和訓練數據集定義的特定任務對物理透鏡和深度神經網絡進行聯合優化。(見下圖 3)

圖 3:光學編碼器 - 電子解碼器系統示意圖。其中傳感器充當瓶頸,在角度、波長譜、曝光時間、相位和其它入射光指標上進行積分。自由曲面透鏡或定制傳感器電子設備能以離線方式針對特定任務進行優化,然后經過生產加工后用于從光學和電子方面記錄圖像編碼。然后可以使用神經網絡或其它可微分的圖像處理算法來從觀測結果提取所需的信息。這些編碼器和解碼器一起可共同組成一個混合式的光 - 電神經網絡。

我們也可以將光學操作的原理解讀為一種形式的計算,即與處理數據記錄的電子平臺一起工作的預處理器或協處理器。基于這一解讀,我們可以讓光學組件做盡可能多的工作,進而優化計算成像系統的延遲和功耗需求。

顯微鏡應用

光學顯微鏡也是深度學習方法已經取得重大影響的一個領域,其涵蓋多種模態,包括相干成像以及明視野顯微鏡和熒光顯微鏡。解決顯微圖像重建和增強的反向問題已經是一項持續數十年的熱門研究課題,之前方法的一大關鍵是建立成像系統的前向模型。基于深度學習的數據驅動方法是解決光學顯微鏡反向問題的另一條途徑。

圖 4:深度光學和光子學應用示例 I。a. 光學圖像分類;b. 混合光電圖像分類;c. 使用偽隨機投影的圖像分類;d. 虛擬染色;e. 虛擬重新聚焦。

圖 5:深度光學和光子學應用示例 I。a. 單像素相機;b. 用于視頻超分辨率的神經傳感器;c. 納米光子回路;d. 光子集成電路;e. 光學干涉儀;f. 逆向設計的非均勻介質。

展望未來

文章認為,混合光 - 電計算系統是這一領域最有發展前景的方向。混合系統既具備光計算的帶寬和速度優勢,又具備電計算的靈活性,而且還能利用模擬和數字光學 / 光電 / 電子系統的高能效技術基礎。混合光 - 電推理機器能將 AI 推理用于計算機視覺、機器人學、顯微和其它視覺計算任務,進而實現光學計算機早該具有的變革性能力。

責任編輯:PSY

-

光學

+關注

關注

3文章

754瀏覽量

36303 -

低功耗

+關注

關注

10文章

2408瀏覽量

103777 -

人工智能

+關注

關注

1792文章

47417瀏覽量

238932

發布評論請先 登錄

相關推薦

如何在低功耗MCU上實現人工智能和機器學習

嵌入式和人工智能究竟是什么關系?

《AI for Science:人工智能驅動科學創新》第6章人AI與能源科學讀后感

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創新》第二章AI for Science的技術支撐學習心得

《AI for Science:人工智能驅動科學創新》第一章人工智能驅動的科學創新學習心得

risc-v在人工智能圖像處理應用前景分析

人工智能ai4s試讀申請

名單公布!【書籍評測活動NO.44】AI for Science:人工智能驅動科學創新

報名開啟!深圳(國際)通用人工智能大會將啟幕,國內外大咖齊聚話AI

FPGA在人工智能中的應用有哪些?

如何基于OrangePi?AIpro開發AI推理應用

深度光學和人工智能推理應用,實現高速高帶寬低功耗AI計算

深度光學和人工智能推理應用,實現高速高帶寬低功耗AI計算

評論