大佬說選擇移植Tengine Python API這個任務,一方面是因為他之前做過涉及Python和C++/C交互的開源項目工作,如 MXNet 中DLPack的Python API和他自己的開源項目 MobulaOP,這些工作讓他踩了不少的坑;另一方面是因為他認為,了解一個框架需要先把例子跑起來, 就像學習一門新的編程語言要先跑通它的Hello World程序。通過這次任務,可以了解基于Tengine Lite的圖像分類實現,對TengineLite有一個初始的、直觀的感受。

以下為大佬第一人稱自述/~

初探源碼

這個任務的工作可以用一句話來概括: 在Tengine跑起Python例子, 再在Tengine Lite跑起同樣的例子。

第一步需要找到Tengine Python API的例子。但Tengine沒有的Python例子, 也沒有Python API的文檔。想從單元測試入手,但也沒有Python API的單元測試,難怪移植Python API的任務難度比移植C++ API的任務難度高。還有什么方法可以了解Python API的用法呢? 閱讀源碼。Tengine的Python API放在pytengine文件夾, 里面有八個模塊,分別是:base、context、device、 graph、libinfo、node、tengine和tensor,可以重點關注base, graph和tensor。

從base.py源碼中可以看出Tengine使用ctypes的形式進行Python和C++/C的交互,把動態鏈接庫libtengine.so讀取后保存到變量/_LIB中,通過/_LIB.可以調用Tengine的C API. graph.py實現計算圖部分的API,tensor.py實現了作為輸入和輸出的張量API。

編譯和導入模塊

找到Python API代碼的位置后,編譯Tengine,并嘗試在Python中導入tengine模塊。從libinfo.py中可以了解到,Tengine Python API會在Python API目錄和環境變量LD/_LIBRARY/_PATH所指向的目錄中,查找動態鏈接庫libtengine.so.這時遇到了第一個Bug,我用的操作系統沒有定義LD/_LIBRARY/_PATH這個環境變量,而API里直接用下標訪問的形式取這個環境變量的值,出現了KeyError的錯誤。改成os.environ.get('LD/_LIBRARY/_PATH', '')即可。設置好動態鏈接庫的路徑后,可以成功導入pytengine模塊了。

編寫Python分類示例

Tengine提供C++/C的分類示例代碼,在examples目錄下,可以作為編寫Python例子時的參考。其中,classification.cpp用了Tengine的C++ API,比C API多了Net類的封裝,Net類封裝了對于計算圖Graph的操作。而classification/_old/_api.cpp用的是Tengine的C API. 由于Tengine Python API調用的是Tengine C API,因此可以拿classification/_old/_api.cpp作為參考。Tengine Python API封裝得很簡潔,很容易能找到每個Python函數調用的C函數。C++分類示例代碼和Python API的代碼互相對照,就可以寫出Python分類示例的代碼。寫完后就可以嘗試運行了。

運行Python分類示例

運行Python分類示例并不順利,一開始就在構建計算圖上出錯了。定位到Python API的源碼后, 發現是在以下兩行出錯。

# pytengine/tengine/graph.py:L24-L25 params = [ c_str(item) for item in kwarg] self.graph = _LIB.create_graph(ctypes.c_void_p(context), c_str(model), *params)

create/_graph有三個參數: 第一個參數context是模型執行的上下文,第二個參數是模型的格式,第三個參數是模型的文件名。這兩行代碼看起來沒什么毛病,和C++例子里的調用方式是一模一樣的。但出錯的原因就在給變量params賦值的這一行,里面的item是一個臨時變量,當這條語句結束時,item離開了作用域就被釋放了。而c/_str(item)是指向原來item的位置,變成了一個野指針。為了解決這個問題,可以把該行改為params = [ c/_str(kwarg[i]) for i in range(len(kwarg)) ],此時c/_str(kwarg[i])指向的是變量kwargs中存儲的值,變量kwargs在調用函數create/_graph時仍在作用域內。

另外遇到的一個復雜的問題和Tensor類有關, pytengine的Tensor類還不完善,無法取出Tensor里的數據.。對照C語言寫的例子修改Tensor的buf函數,得到數據內存地址,占用的內存大小,類型,尺寸后,轉換為NumPy數組。 需要注意一下Tengine Lite前端的執行步驟:

# 建立計算圖并讀取模型文件 tm_file graph = tg.Graph(None, 'tengine', tm_file) # 取出輸入 Tensor input_tensor = graph.getInputTensor(0, 0) # 設置輸入Tensor的尺寸 dims = [1, 3, img_h, img_w] input_tensor.shape = dims # 預先運行以分配資源, 必須加上 graph.preRun() # 設置輸入數據的內存地址, 這里的data是尺寸為(3, img_h, img_w)的NumPy數組. 注意: 這里不會檢查shape input_tensor.buf = data # 以同步方式讓網絡進行推斷(前向傳播), 其中1表示使用同步的方式 graph.run(1) # 1 is blocking # 取出輸出的Tensor output_tensor = graph.getOutputTensor(0, 0) # 將Tensor轉為NumPy數組 output = np.array(output_tensor.buf)

把這些問題解決后,就能在Tengine上運行Python示例了。

需要注意的是,Tengine Lite和Tengine在做推斷前,都需要調用preRun()函數對資源進行分配,這是必須要調用的。 雖然現在的Python API用起來有點復雜,但相信之后會封裝得更好的。

從Tengine到Tengine Lite

在Tengine上成功運行Python示例后,移植就變得方便了。直接把pytengine文件夾下的所有代碼, 以及Python分類示例復制粘貼到Tengine Lite中,將動態庫名稱從libtengine.so改為libtengine-lite.so, 然后運行Python分類示例。不出意料,出錯了。 原因是Tengine Lite在設置輸入Tensor的數據內存地址時,也會檢查數據的大小,而之前的Python API的數據大小的計算是錯誤的。 修復Bug后, 成功在Tengine Lite上運行圖像分類示例。移植完成。不得不夸一下Tengine Lite的C API兼容性做得真好!

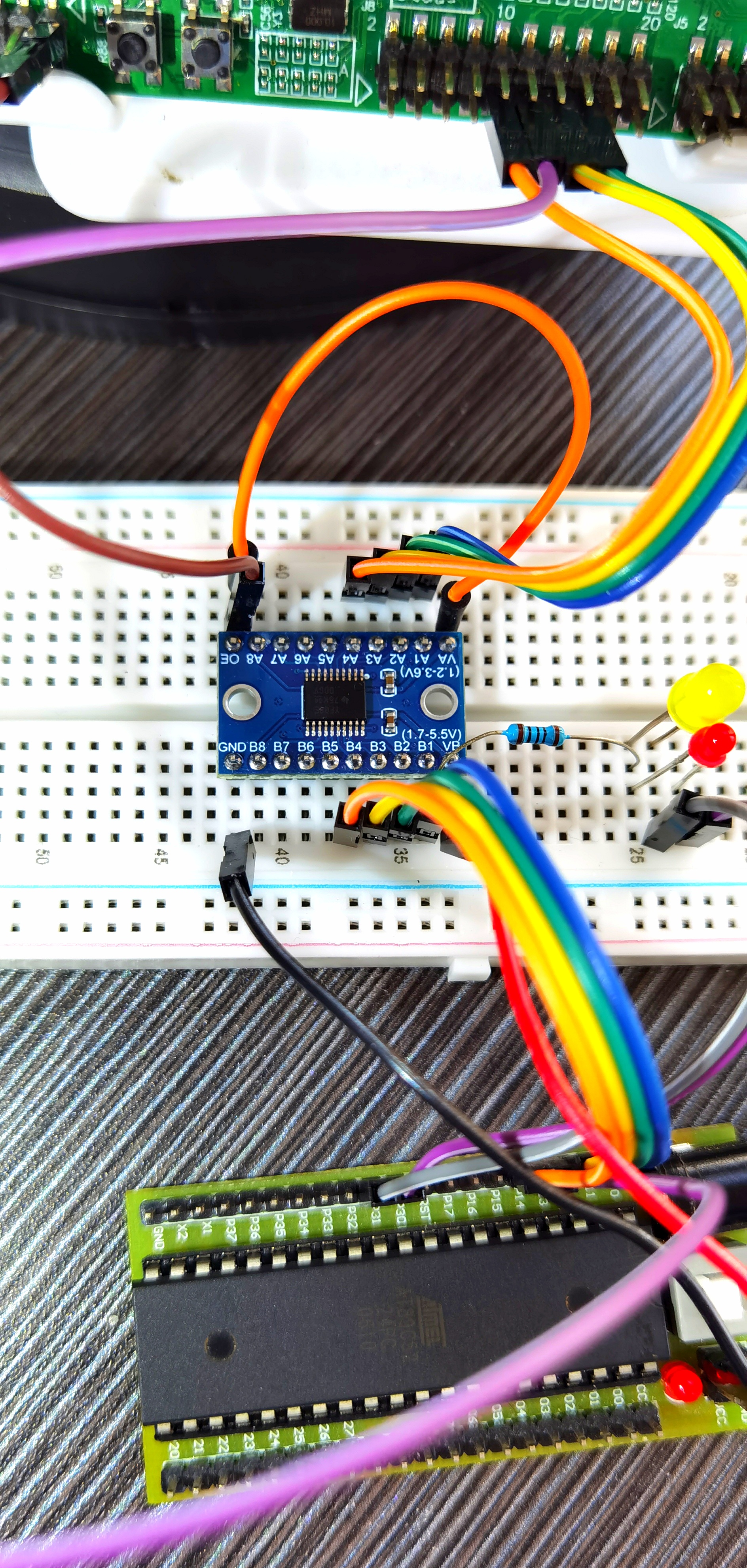

在EAIDK-310上運行Tengine Lite的Python圖像分類示例

之前參加OPEN AI LAB的活動,得到了一塊EAIDK-310開發板, 剛好可以在上面進行測試。

這里使用可愛的虎貓(Tiger Cat)作為測試圖片,模型采用MobileNet。 圖片和模型都可以在Tengine項目的頁面中找到鏈接 (Tengine快速上手指南)。

下載代碼

[openailab@localhost proj]$ git clone https://github.com/OAID/Tengine # 進入Tengine的目錄 cd Tengine [openailab@localhost Tengine]$ git branch * tengine-lite

當前Tengine的默認分支是Tengine Lite。

2. 編譯Tengine Lite

mkdir build cd build cmake .. make -j2

注意不要把編譯線程數設太大,因為在最后編譯MobileNet SSD例子時消耗顯存比較多。六分鐘多可以編譯完。

3. 配置Tengine Lite的Python API編輯/home/openailab/.bashrc,再最后一行后面加入:

export TENGINE_LITE_PATH=/home/openailab/proj/Tengine export PYTHONPATH=$PYTHONPATH:$TENGINE_LITE_PATH/pytengine export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:$TENGINE_LITE_PATH/build/src/

環境變量TENGINE_LITE_PATH設置為Tengine Lite的根目錄路徑, 設置好后重新打開終端。 打開Python, 能成功導入tengine。

[openailab@localhost examples]$ python Python 3.6.5 (default, Mar 29 2018, 17:45:40) [GCC 8.0.1 20180317 (Red Hat 8.0.1-0.19)] on linux Type "help", "copyright", "credits" or "license" for more information. >>> import tengine

4. 將三個文件cat.jpg/, mobilenet.tmfile/, synset/_words.txt放在examples的目錄下, 文件結構如下所示:

[openailab@localhost examples]$ pwd /home/openailab/proj/Tengine/examples [openailab@localhost examples]$ tree . ├── cat.jpg ├── classification.py ├── mobilenet.tmfile ├── synset_words.txt

5. 運行examples文件夾下的圖像分類示例classification.py

[openailab@localhost examples]$ python classification.py n02123159 tiger cat 8.5975923538208 n02119022 red fox, Vulpes vulpes 7.954988956451416 n02119789 kit fox, Vulpes macrotis 7.867891311645508 n02113023 Pembroke, Pembroke Welsh corgi 7.427407264709473 n02123045 tabby, tabby cat 6.364651679992676

由此,就能夠在Tengine Lite上正確預測出虎貓啦 : )

下一步工作

對于Tengine Lite Python API,我覺得在API設計方面可以進一步改進。比如把數據預處理, 計算圖構建等操作隱藏起來,比如:

image = cv2.imread('./cat.jpg') model = tg.Model(tm_file) pred = model(image)

這樣可以減少出錯概率, 一些錯誤比如忘記對數據做預處理,使用的數據內存分布(NCHW還是NHWC)不正確,忘記調用prerun。

本次Tengine Python API移植任務,大佬做的工作是編寫一個Python的圖像分類示例,在Tengine上跑通代碼,再將pytengine移植(復制)到Tengine Lite上, 再在Tengine Lite上跑通代碼,其中還修復了pytengine中的一些bug。

更多Tengine相關內容請關注Tengine-邊緣AI推理框架專欄。

審核編輯 黃昊宇

-

python

+關注

關注

56文章

4798瀏覽量

84801 -

Tengine

+關注

關注

1文章

47瀏覽量

2861

發布評論請先 登錄

相關推薦

將基于PC的MP3播放器軟件移植到ADSP-21262 SHARC處理器上

在設備上利用AI Edge Torch生成式API部署自定義大語言模型

如何把Tengine Python API移植到Tengine Lite上

如何把Tengine Python API移植到Tengine Lite上

評論