哈工大訊飛聯合實驗室發布的中文ELECTRA系列預訓練模型再迎新成員。我們基于大規模法律文本訓練出中文法律領域ELECTRA系列模型,并且在法律領域自然語言處理任務中獲得了顯著性能提升。歡迎各位讀者下載試用相關模型。

項目地址:http://electra.hfl-rc.com

中文法律領域ELECTRA

我們在20G版(原版)中文ELECTRA的基礎上加入了高質量2000萬裁判文書數據進行了二次預訓練,在不丟失大規模通用數據上學習到的語義信息,同時使模型對法律文本更加適配。本次發布以下三個模型:

legal-ELECTRA-large, Chinese:24-layer,1024-hidden, 16-heads, 324M parameters

legal-ELECTRA-base, Chinese:12-layer,768-hidden, 12-heads, 102M parameters

legal-ELECTRA-small, Chinese: 12-layer, 256-hidden, 4-heads, 12M parameters

快速加載

哈工大訊飛聯合實驗室發布的所有中文預訓練語言模型均可通過huggingface transformers庫進行快速加載訪問,請登錄我們的共享頁面獲取更多信息。

https://huggingface.co/HFL

模型鍵值如下:

hfl/chinese-legal-electra-large-discriminator

hfl/chinese-legal-electra-large-generator

hfl/chinese-legal-electra-base-discriminator

hfl/chinese-legal-electra-base-generator

hfl/chinese-legal-electra-small-discriminator

hfl/chinese-legal-electra-small-generator

效果評測

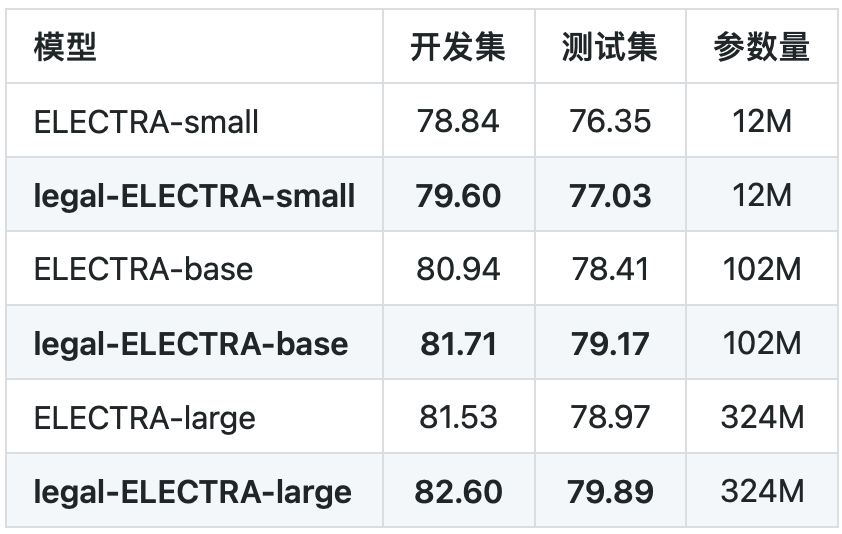

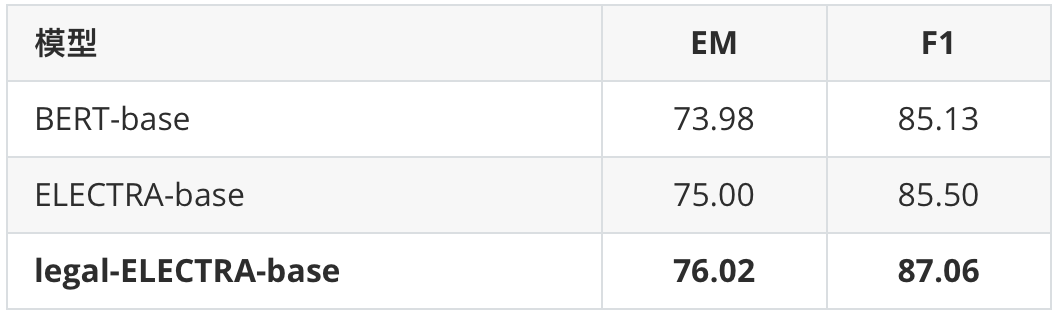

我們在罪名預測以及要素抽取任務上進行了基線測試。其中罪名預測任務使用的是CAIL 2018數據,要素抽取任務為in-house實際應用。可以看到本次發布的法律領域ELECTRA模型均相比通用ELECTRA模型獲得了顯著性能提升。

表1罪名預測任務

表2要素抽取任務

其他相關資源

TextBrewer知識蒸餾工具

http://textbrewer.hfl-rc.com

中文BERT、RoBERTa、RBT系列模型

http://bert.hfl-rc.com

中文XLNet系列模型

http://xlnet.hfl-rc.com

中文MacBERT模型

http://macbert.hfl-rc.com

責任編輯:xj

原文標題:哈工大訊飛聯合實驗室發布法律領域ELECTRA預訓練模型

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

算法

+關注

關注

23文章

4625瀏覽量

93131 -

深度學習

+關注

關注

73文章

5511瀏覽量

121356 -

訓練模型

+關注

關注

1文章

36瀏覽量

3876

原文標題:哈工大訊飛聯合實驗室發布法律領域ELECTRA預訓練模型

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

哈工大訊飛聯合實驗室發布的中文ELECTRA系列預訓練模型再迎新成員

哈工大訊飛聯合實驗室發布的中文ELECTRA系列預訓練模型再迎新成員

評論