谷歌正式發布了 TensorFlow 2.4,帶來了多項新特性和功能改進。

TensorFlow 2.4 的更新包括對于分布式訓練和混合精度的新功能支持,對 NumPy API 子集的試驗性支持以及一些用于監測性能瓶頸的新工具。 根據 TensorFlow 官方博客,本次更新的主要內容整理如下:

tf.distribute 中的新功能

參數服務器策略 在 TensorFlow 2.4 中,tf.distribute 模塊引入了對使用 ParameterServerStrategy 和自定義訓練循環進行模型異步訓練的試驗性支持。和 MultiWorkerMirroredStrategy 類似,ParameterServerStrategy 是一種多工作器(multi-worker)數據并行策略,但梯度更新是異步的。 參數服務器訓練集群由工作服務器和參數服務器組成。變量在參數服務器上創建,然后在每個步驟中由工作器讀取和更新。

變量的讀取和更新在工作器之間是獨立進行的,不存在任何同步。由于工作器彼此不依賴,因此該策略具有工作器容錯的優勢,如果使用可搶占 VM,該策略將很有用。 多工作器鏡像策略 MultiWorkerMirroredStrategy 已經脫離試驗階段,成為穩定的 API。像單工作器的 MirroredStrategy 一樣,MultiWorkerMirroredStrategy 通過同步數據并行實現分布式訓練,顧名思義,借助 MultiWorkerMirroredStrategy 可以在多臺機器上進行訓練,每臺機器都可能具有多個 GPU。

Keras 更新

混合精度 在 TensorFlow 2.4 中,Keras 混合精度 API 已經脫離試驗階段,成為穩定的 API。大多數 TensorFlow 模型使用 float32 dtype,但現在有些低精度數據類型占用的內存更少,比如 float16。混合精度指的是在同一模型中使用 16 位和 32 位浮點數以進行更快的訓練。這一 API 可將模型性能在 GPU 上提高到 3 倍,在 TPU 上提高 60%。

要使用混合精度 API,必須使用 Keras 層和優化器,但不一定需要使用其他 Keras 類。 優化器 本次更新包括重構 tf.keras.optimizers.Optimizer 類,讓 model.fit 的用戶和自定義訓練循環的用戶能夠編寫可與任何優化器一起使用的訓練代碼。所有內置 tf.keras.optimizer.Optimizer 子類都可接受 gradient_transformers 和 gradient_aggregator 參數,輕松定義自定義梯度變換。 重構之后,使用者可以在編寫自定義訓練循環時直接將損失張量傳遞給 Optimizer.minimize:

這些更新的目標是讓 Model.fit 和自定義訓練循環與優化器細節更加不相關,從而讓使用者無需修改即可編寫出與任何優化器共同使用的訓練代碼。 最后,TensorFlow 2.4 的更新還包括 Keras Functional API 內部的重構,改善了函數式模型構造所產生的內存消耗并簡化了觸發邏輯。這種重構可以保證 TensorFlowOpLayers 的行為可預測,并且可以使用 CompositeTensor 類型簽名(type signature)。

tf.experimental.numpy

TensorFlow 2.4 引入了對 NumPy API 子集的試驗性支持。該模塊可以運行由 TensorFlow 加速的 NumPy 代碼,由于這一 API 是基于 TensorFlow 構建的,因此可與 TensorFlow 無縫銜接,允許訪問所有 TensorFlow API 并通過編譯和自動矢量化提供優化后的運行。 例如,TensorFlow ND 數組可以與 NumPy 函數互通,類似地,TensorFlow NumPy 函數可以接受包括 tf.Tensor 和 np.ndarray 在內的不同類型輸入。

新的性能分析工具

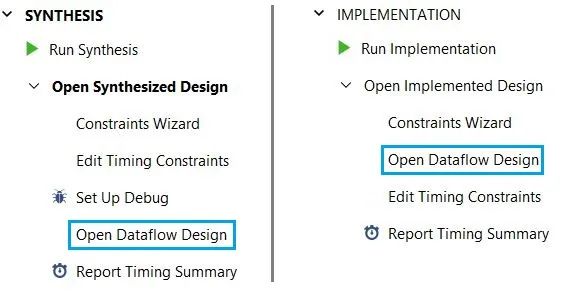

TensorFlow Profiler 是度量 TensorFlow 模型的訓練性能和資源消耗情況的工具,用來診斷性能瓶頸,最終加快訓練速度。 此前,TensorFlow Profiler 支持多 GPU 單主機訓練。到了 2.4 版本,使用者可以測試 MultiWorkerMirroredStrategy 的訓練工作了,比如使用采樣模式 API 按需配置,并連接到 MultiWorkerMirroredStrategy 工作器正在使用的同一服務器。

另外,你可以通過向捕獲配置文件工具提供工作器地址來使用 TensorBoard 配置文件插件。配置之后,你可以使用新的 Pod Viewer tool 來選擇訓練步驟,并查看所有工作器上該步驟的 step-time 的細分。 TFLite Profiler TFLite Profiler 則支持在 Android 中跟蹤 TFLite 內部信息,以識別性能瓶頸。

GPU 支持

TensorFlow 2.4 與 CUDA 11 和 cuDNN 8 配合運行,支持最新發布的英偉達安培架構 GPU,對于 CUDA 11 的新特性,可以參考英偉達開發者博客: https://developer.nvidia.com/blog/cuda-11-features-revealed/ 在新版本中,默認情況下會啟用安培 GPU 的新特性——對 TensorFloat-32 的支持。TensorFloat-32 又簡稱為 TF32,是英偉達 Ampere GPU 的一種數學精度模式,可導致某些 float32 運算(如矩陣乘法和卷積)在安培架構 GPU 上運行得更快,但精度略有降低。 若想更深入了解,可參閱文檔: https://www.tensorflow.org/api_docs/python/tf/config/experimental/enable_tensor_float_32_execution

責任編輯:xj

原文標題:TensorFlow 2.4來了:上線對分布式訓練和混合精度的新功能支持

文章出處:【微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

-

數據集

+關注

關注

4文章

1224瀏覽量

25483 -

tensorflow

+關注

關注

13文章

330瀏覽量

61208

原文標題:TensorFlow 2.4來了:上線對分布式訓練和混合精度的新功能支持

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

軟件更新 | 你期待的新功能來了!TSMaster 202502 新版本亮點搶先看!

為什么無法使用OpenVINO?模型優化器轉換TensorFlow 2.4模型?

新思科技LucidShape 2024.09新增功能

$1999 的 RTX 5090 來了

評論