01

—

研究動機

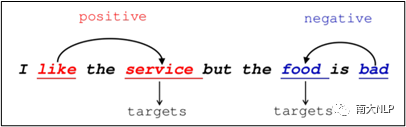

方面級情感分類(英文叫Aspect-level Sentiment Classification,簡稱ASC)旨在檢測句子中給定意見目標的情感極性。意見目標(也稱為方面術語)是指評論中描述實體方面的單詞或短語。如圖1所示,"服務很好,但食物卻很糟糕"這句話包含兩個意見目標,即"食物"和"服務"。用戶對目標"服務"的看法是正面的,而對目標"食物"的看法卻是負面的。

圖1: 包含多個意見目標的句子示例

從上面的例子中我們可以看到,一個句子有時會包含多個意見目標,并且它們可能表達不同的情感極性,因此ASC的一個主要挑戰是如何為不同的意見目標獲取到不同的情感上下文。為此,大多數方法運用注意力機制(Bahdanau et al., 2014)來捕獲與給定目標相關的情感詞,然后將其匯總以進行情感預測。盡管注意力機制是有效的,但我們認為由于ASC標注數據是有限的,因此它未能充分發揮注意力機制的潛力。眾所周知,深度學習的結果很大程度上取決于訓練數據的多少。但是,在實際情況中,ASC數據的注釋費時且昂貴,因為注釋者不僅需要識別句子中所有的意見目標,而且還需要判斷其相應的情感極性。注釋困難導致現有公開的數據集都相對較小,這嚴重限制了注意力機制的潛力。

盡管缺少ASC數據,但是在線評論網站(例如Amazon和Yelp)可以提供大量的文檔級情感分類(DSC)標記數據。這些評論中包含了大量的情感知識和語義模式。因此,一個有意義但具有挑戰性的研究問題是如何利用資源豐富的DSC數據來提升低資源任務ASC。為此,He et al. (2018) 設計了PRET + MULT框架,通過共享淺層的embedding嵌入和LSTM層將情感知識從DSC數據傳遞到ASC任務。受膠囊網絡的啟發(Sabour et al., 2017),Chen and Qian (2019)提出TransCap模型,它共享底部的三個膠囊層,然后僅在最后一個ClassCap層中分離了兩個任務。從根本上說,PRET + MULT和Transcap通過共享參數和多任務學習來提升ASC,但是它們不能準確地控制和解釋要傳輸的知識。

為了解決上述提到的兩個問題,在這項工作中,我們提出了一種新穎的框架,即注意力轉移網絡(ATN),它從DSC任務中顯式的轉移注意力知識,以提高ASC任務中意見目標的注意力能力。與PRET + MULT和Transcap相比,我們的模型獲得了更好的結果并保留了良好的可解釋性。

02

—

解決方案

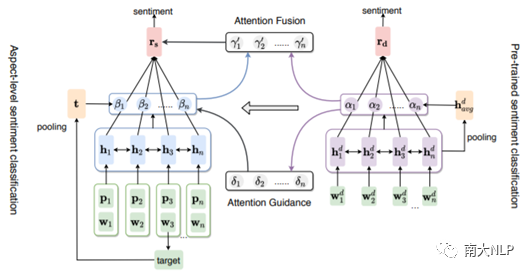

圖1顯示了注意轉移網絡(ATN)的總體組織結構。在ATN框架中,我們分別采用了兩個基于注意力的BiLSTM網絡作為DSC和ASC的基礎模塊,并提出了兩種將DSC中的注意力知識遷移到ASC的新方法。

圖2: 注意力遷移網絡(ATN)的整體架構

第一種遷移方法稱為注意力引導。具體來說,我們首先在大規模的DSC數據集上預訓練一個基于注意力的BiLSTM網絡,然后利用DSC模塊中的注意力權重作為學習信號來引導ASC模塊更準確地捕捉情感線索,從而取得很好的結果。注意力引導通過輔助監督信號學習DSC模塊的注意力能力,但是,它不能在測試階段利用DSC模塊的注意力權重,并且浪費了預先訓練的知識。為了充分利用額外的注意能力,我們進一步提出了注意力融合方法來直接將它們合并。

這兩種方法雖然工作方式不同,但是都有各自的優點。注意力引導的目的是學習DSC模塊的注意力能力,由于在測試階段不使用DSC的外部注意力,因此具有更快的推理速度,而注意力融合可以利用DSC模塊在測試階段的注意力知識,做出更全面的預測。

03

—

實驗

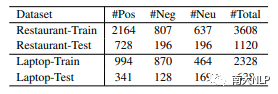

我們在SemEval 2014 Task 44 (Pontiki et al., 2014)的兩個ASC基準數據集上評估了模型的性能。 它們分別包含來自laptop和restaurant領域的商品評論。我們在所有數據集中刪除了極性沖突的樣本。ASC數據集的統計數據如表1所示:

表1:ASC數據集的統計信息

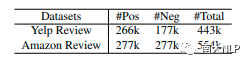

為了對DSC模塊進行預訓練,我們使用了兩個DSC數據集,分別是YelpReview和AmazonReview(Li et al., 2018a)。DSC數據集Yelp Review包含的注意力知識遷移到ASC數據集Restaurant。而laptop的注意力知識來自AmazonReview。表2顯示了它們的統計信息。在這項工作中,我們采用Accuracy和Macro-F1作為評估ASC任務中不同方法的性能指標。

表2:DSC數據集的統計信息

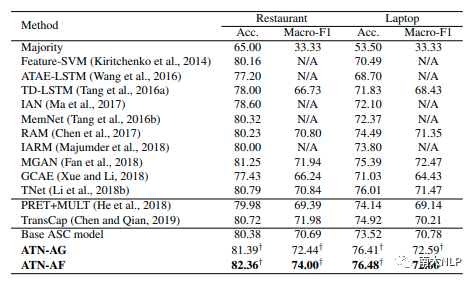

主要結果如表3所示。我們將結果分為三類:第一類列出了ASC任務的經典方法,第二類給出了兩種基于遷移的現有方法,最后一類是我們的基礎ASC模型和兩個增強版本。我們分別使用ATN-AG和ATN-AF來表示使用了注意力引導和注意力融合的ATN。

表3:主實驗結果(%)

我們的基礎ASC模型-基于注意力的BiLSTM通過位置嵌入得到了增強,其性能優于某些基于注意力的模型(如ATAE-LSTM和IAN)。這個結果表明位置嵌入對于在ASC任務中建模目標信息是有益的。在此基礎上,我們的注意力轉移模型ATN-AG和ATN-AF在restaurant數據集上的Accuracy分別提高了約1%和2%,在laptop數據集上提高了2.8%。此外,它們超過了兩種使用了轉移知識的現有方法,即PRET + MULT和Transcap。

這些結果證明了我們提出的將注意力知識從資源豐富的DSC數據轉移到ASC任務的有效性。與ATN-AG相比,ATN-AF在restaurant數據集上具有更好的性能。這是合理的,因為在測試階段,ATN-AG無法利用DSC模塊的注意力權重。盡管如此,ATN-AG仍在laptop數據集上獲得了有競爭力的結果,并且推理速度比ATN-AF快。

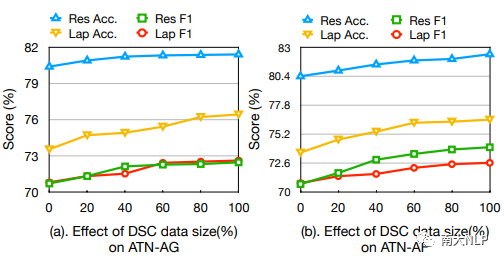

為了研究DSC數據集大小對我們方法的影響,我們將DSC數據的百分比從0%更改為100%,以報告ATN-AG和ATN-AF的結果。臨界值0%和100%分別表示無DSC數據和使用完整的DSC數據集。結果如圖2所示:

圖3: 在不同百分比的DSC數據下ATN-AG和ATN-AF的性能

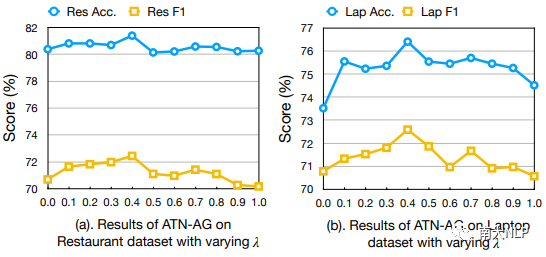

為了分析超參數λ對ATN-AG的影響,我們在[0,1]中對其進行調整以進行實驗,步長為0.1。 圖3顯示了restaurant和laptop數據集上具有不同λ的ATN-AG的性能:

圖4: 超參數λ對ATN-AG的影響

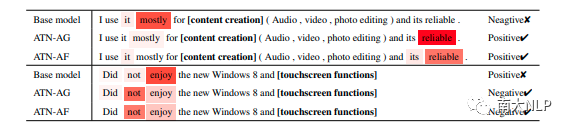

在ATN模型中,我們提出了注意力指導和注意力融合的方法,以幫助ASC模塊更準確地捕獲情感線索。為了驗證這一點,我們分析了數十個測試集中的示例。與基礎ASC模型相比,我們發現注意力轉移方法可以處理低頻情感詞和諸如否定之類的復雜情感模式。表4顯示了兩個示例的注意力可視化結果以及在模型ATN-AG和ATN-AF下的相應情感預測。

圖5: ATN-AG和ATN-AF的注意力可視化結果,較深的顏色表示較高的注意力權重

04

—

總結

標注數據不足會限制基于注意力的模型對ASC任務的有效性。 本文提出了一種新穎的注意力轉移框架,其中設計了兩種不同的注意力轉移方法,以利用資源豐富的文檔級情感分類語料庫中的注意力知識來增強資源貧乏的方面級情感分類的注意力過程,最終達到改善ASC性能的目標。 實驗結果表明,我們的方法優于最新技術。 進一步的分析驗證了從DSC數據轉移注意力知識到ASC任務的有效性和好處。

責任編輯:xj

原文標題:【COLING2020】面向方面級情感分類的注意力轉移網絡

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

情感識別

+關注

關注

1文章

10瀏覽量

7558 -

自然語言

+關注

關注

1文章

288瀏覽量

13355 -

nlp

+關注

關注

1文章

489瀏覽量

22049

原文標題:【COLING2020】面向方面級情感分類的注意力轉移網絡

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于LSTM神經網絡的情感分析方法

一種基于因果路徑的層次圖卷積注意力網絡

BP神經網絡在語言特征信號分類中的應用

nlp神經語言和NLP自然語言的區別和聯系

nlp自然語言處理基本概念及關鍵技術

nlp自然語言處理的主要任務及技術方法

llm模型有哪些格式

NLP模型中RNN與CNN的選擇

卷積神經網絡在文本分類領域的應用

【大規模語言模型:從理論到實踐】- 閱讀體驗

基于神經網絡的呼吸音分類算法

工業級路由器的使用技巧和注意事項

紐約時報回應“黑客入侵”說:OpenAI試圖轉移公眾注意力

Transformers的功能概述

NLP:面向方面級情感分類的注意力轉移網絡

NLP:面向方面級情感分類的注意力轉移網絡

評論