麻省理工學院的研究人員已經匯編了一個數據集,該數據集捕獲了物理上推動數百個不同對象的機器人系統的詳細行為。研究人員可以使用數據集(同類中規模最大,種類最多的)訓練機器人,以“學習”推動動力學,這對于許多復雜的對象操縱任務都是至關重要的,包括重新定向和檢查對象以及整潔的場景。

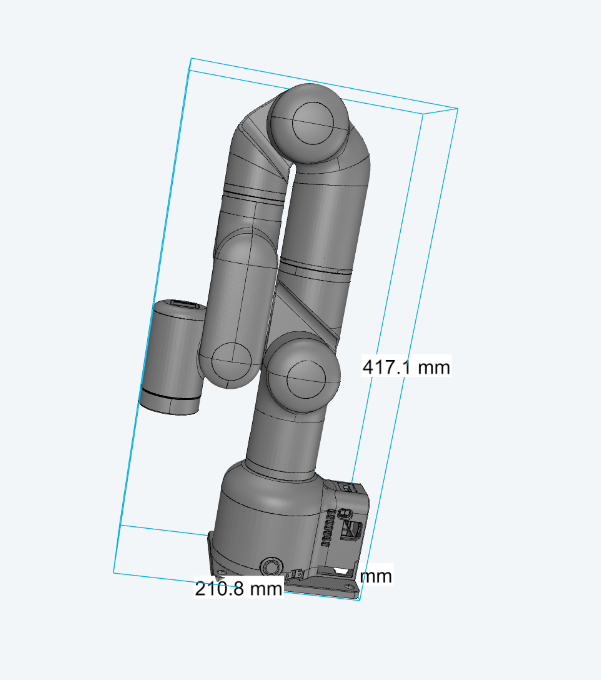

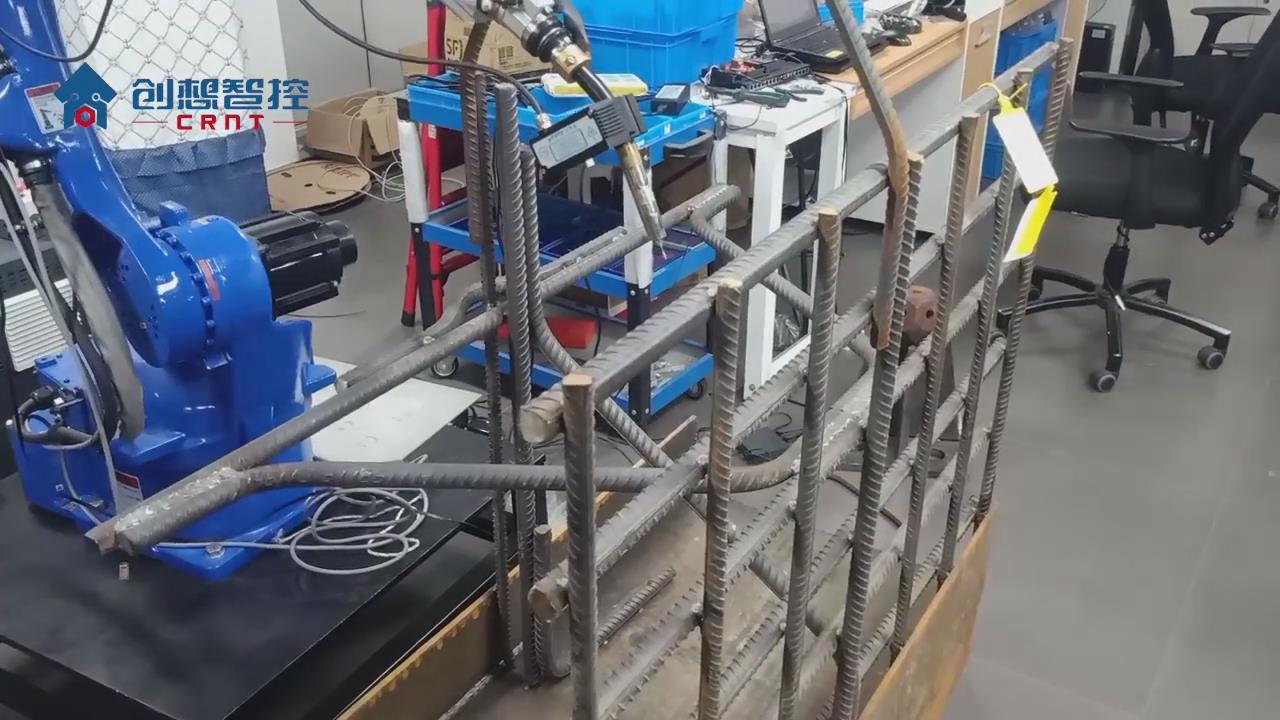

為了捕獲數據,研究人員設計了一個自動化系統,該系統包括具有精確控制的工業機械手,3D運動跟蹤系統,深度和傳統相機以及將所有東西縫合在一起的軟件。手臂推著模塊化的物體,可以調整它們的重量,形狀和質量分布。對于每次推動,系統都會捕獲這些特征如何影響機器人的推動。

名為“ Omnipush”的數據集包含250個對象的250個不同的推送,總計大約62,500次唯一推送。例如,研究人員已經在使用它來構建模型,以幫助機器人預測物體在被推動時會降落在何處。

這一篇描述Omnipush的論文的作者,機械工程系(MechE)的研究生Maria Bauza說:“我們需要大量豐富的數據來確保我們的機器人能夠學習。” 智能機器人和系統。“在這里,我們正在從真實的機器人系統中收集數據,并且對象足夠多以捕獲豐富的推動現象。這對于幫助機器人理解推動的工作原理并將該信息轉換為其他類似現實世界中物體的信息非常重要。”

加入Bauza的論文包括:計算機科學與人工智能實驗室和電氣工程與計算機科學系(EECS)的研究生Ferran Alet和Lin Yen-Chen Lin;工程學院卓越教學教授Tomas Lozano-Perez;Leslie P. Kaelbling,松下計算機科學與工程系教授;EECS助理教授Phillip Isola;以及MechE副教授Alberto Rodriguez。

多樣化的數據

為什么要專注于推動行為?Rodriguez解釋說,建模涉及物體和表面之間摩擦的推動動力學,對于更高級別的機器人任務至關重要。考慮一下可以玩Jenga的視覺和技術上令人印象深刻的機器人,這是Rodriguez最近合作設計的。羅德里格斯說:“機器人正在執行一項復雜的任務,但驅動該任務機制的核心仍然是推動受例如塊之間的摩擦影響的物體。”

Omnipush建立在Rodriguez,Bauza和其他研究人員在操縱與機制實驗室(MCube)中建立的類似數據集的基礎上,該數據集僅捕獲了10個對象上的推入數據。在2016年將數據集公開后,他們收集了研究人員的反饋。其中一個抱怨是認為缺乏對象多樣性:在數據集上受過訓練的機器人努力地將信息推廣到新的對象上,而且也沒有視頻記錄,圖像對于計算機視覺,視頻預測和其他任務很重要。

因此如今,對于他們的新數據集,研究人員利用工業機器人手臂精確控制推進器(基本上是垂直鋼棒)的速度和位置。當手臂推動物體時,他們用已在電影,虛擬現實以及研究中使用的“ Vicon”運動跟蹤系統跟隨物體,還有一個RGB-D攝像機,可將深度信息添加到捕獲的視頻中。

研究的關鍵是構建模塊化對象。由鋁制成的均勻的中央部件看起來像四角星,重約100克,每個中心部分的中心和點都包含標記,因此Vicon系統可以在1毫米內檢測到其姿勢。

四個形狀(凹形,三角形,矩形和圓形)的較小塊可以磁連接到中心塊的任何一側。每塊重量在31到94克之間,但是額外的重量(從60到150克不等)可以掉入這些塊的小孔中。所有類似拼圖的物體在水平和垂直方向都對齊,這有助于模擬形狀和質量分布相同的單個物體的摩擦。不同側面,重量和質量分布的所有組合增加了250個唯一對象。

每次推動時,手臂會自動移動到距對象幾厘米的隨機位置。然后,它選擇一個隨機方向并將對象推一秒鐘。從停止的地方開始,然后選擇另一個隨機方向,并重復該過程250次。每次推送都會記錄對象和RGB-D視頻的姿勢,這些姿勢可用于各種視頻預測目的。每天花費12個小時來收集數據,耗時兩個星期,總計超過150個小時。僅在手動重新配置對象時才需要人工干預。

這些對象并沒有專門模仿任何現實生活中的物品。取而代之的是,它們旨在捕獲現實世界對象的“運動學”和“質量非對稱性”的多樣性,從而對現實世界對象的運動進行建模。然后,機器人可以將質量分布不均勻的Omnipush對象的物理模型外推到重量分布不均相似的任何現實世界對象。

“想象一下用四只腿推動桌子,其中最大的重量超過了一只腿。當您推動桌子時,您會看到它在沉重的腿上旋轉,必須重新調整。了解這種質量分布及其對結果的影響推動力是機器人可以用這組對象學習的東西。” Rodriguez說。

推動新研究

在一個實驗中,研究人員使用Omnipush訓練了一個模型,以預測被推物體的最終姿勢,只給出推入的初始姿勢和描述。他們在150個Omnipush物體上訓練了模型,并在物體伸出的部分上對其進行了測試。結果表明,經Omnipush訓練的模型的準確度是在一些相似數據集上訓練的模型的兩倍。在他們的論文中,研究人員還記錄了其他研究人員可以用來比較的準確性基準。

由于Omnipush會捕獲推送的視頻,因此一種潛在的應用是視頻預測。例如,一個合作者現在正在使用數據集來訓練機器人以實質上“想象”在兩點之間的推動物體。在Omnipush上進行訓練后,將為機器人提供兩個視頻幀作為輸入,以顯示其開始位置和結束位置的對象。機器人使用起始位置來預測所有未來的視頻幀,以確保對象到達其結束位置。然后,它以與每個預測視頻幀匹配的方式推動對象,直到到達具有結束位置的幀。

“機器人會根據實際情況問,“如果我執行此操作,對象將在此幀中的什么位置?”然后,它選擇的操作將最大化使對象到達所需位置的可能性,”鮑薩說。“它通過首先想象圖像在按下后如何改變像素來決定如何移動對象。”

卡內基梅隆大學計算機科學與機器人學教授Matthew T. Mason表示:“ Omnipush包括對象運動的精確測量以及視覺數據,用于機器人與對象之間的重要相互作用。” “機器人研究人員可以使用這些數據來開發和測試新的機器人學習方法……這將推動機器人操縱技術的不斷發展。”

編輯:lyn

-

機器人

+關注

關注

211文章

28501瀏覽量

207473 -

人工智能

+關注

關注

1792文章

47409瀏覽量

238924 -

自動化系統

+關注

關注

3文章

257瀏覽量

29671

發布評論請先 登錄

相關推薦

自動化新寵打開人機協同的未來,底層芯片如何賦能協作機器人發展?

【「具身智能機器人系統」閱讀體驗】2.具身智能機器人的基礎模塊

【「具身智能機器人系統」閱讀體驗】2.具身智能機器人大模型

【書籍評測活動NO.51】具身智能機器人系統 | 了解AI的下一個浪潮!

工業機器人、PLC與自動化之間的關系

機器人自動化焊接工作站的優點,技術特點及應用

晶泰科技攜手ABB機器人打造柔性智能自動化的實驗室

自動化革命:大象機器人的Mercury A1機械臂

關于MIT研發出一個自動化系統在機器人上的運用淺析

關于MIT研發出一個自動化系統在機器人上的運用淺析

評論