作者:Chu-Tak Li

編譯:ronghuaiyang

在網絡結構中使用多種感受野,并對損失函數進行了改進。

今天我們要講的另一種修復論文叫做Image inpainting via Generative Multi-column CNNs (GMCNN)。本文使用的網絡架構類似于我們之前介紹的那些論文。本文的主要貢獻是對損失函數進行了若干修正。

回顧

正如我在以前的文章中提到的,如何利用圖像中其他像素所提供的信息,對提高圖像修復效果至關重要。圖像修復的一個非常直觀的意義是直接復制圖像本身中找到的最相似的圖像patch,并粘貼在缺失的區域。有趣的是,我們應該意識到,在實踐中,對于缺失的區域沒有“正確”的答案。在現實中,給定一個損壞的/mask的圖像,你不可能知道原始圖像(ground truth)來進行比較。所以,我們有這么多的答案來解決缺失的區域。

介紹和動機

從以往的圖像修復論文中,我們了解到感受野野對圖像修復的重要性。對于3×3內核,我們可以調整膨脹率來控制它的感受野。如果擴張率為1,我們的感受野為3×3。如果膨脹率是2,通過跳過一個相鄰像素,我們有一個5×5感受野,以此類推。這里,如果我們使用帶有膨脹卷積的3×3、5×5和7×7內核會怎么樣?這在本文中被定義為一個多列結構

在之前的文章中,尋找和缺失區域最相似的圖像patch的過程是嵌入到生成網絡中的,在這個工作中,該過程只是用來設計一個新的損失項用于訓練。

由于缺少的區域沒有“正確”的答案,像素級重建精度損失項(即L1損失)似乎不適用于圖像修復。作者提出了基于缺失像素的空間位置,對L1損失項進行加權。靠近有效像素的空間位置對于L1的損失應該有更高的權值,因為它們對重構有更合理的參考,反之亦然。

方案和貢獻

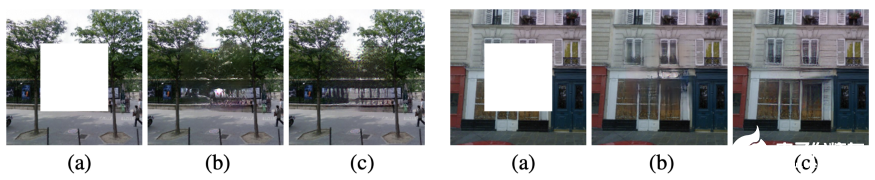

圖1,給出了用該方法進行修復的一些結果

在我看來,本文遵循了我們之前提到的圖像修復的趨勢。首先,作者采用了擴展卷積的多分支CNN,而不是單一分支。三個不同的kernel大小被用于三個不同的分支,以實現不同的感受野和提取不同分辨率的特征。

其次,引入兩個新的損失項來訓練網絡,分別是置信度驅動的重建損失和隱多樣化馬爾可夫隨機場(ID-MRF)損失。置信度驅動的重建損失是一個加權的L1損失,而ID-MRF損失與預訓練的VGG網絡計算的特征patch比較有關。

圖1顯示了本文方法的一些修復結果。你可以放大以更好地查看這些高質量的結果。

方法

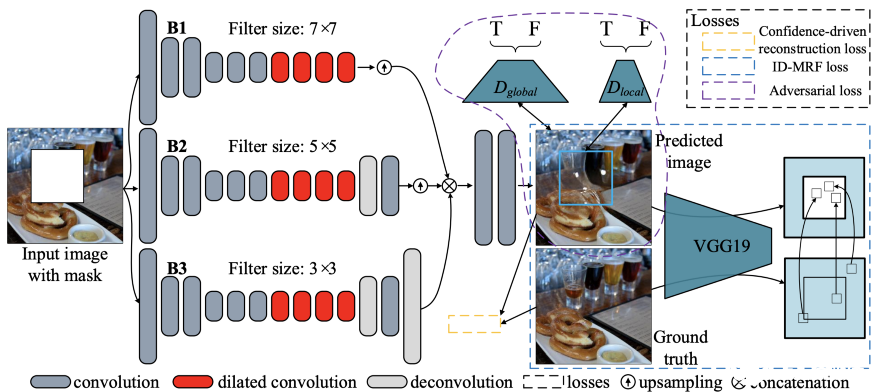

圖2,提出的網絡架構

圖2顯示了本文提出的生成式多列卷積神經網絡(GMCNN)的網絡結構。如你所見,有一個多列生成器網絡、兩個鑒別器(全局和局部)和一個用于計算ID-MRF損失的預訓練VGG19。

生成網絡中有三列,每一列使用三種不同大小的過濾器,即3×3、5×5和7×7。、注意,這三列的輸出被連接到其他兩個卷積層以獲得完整的圖像。

ID-MRF正則化

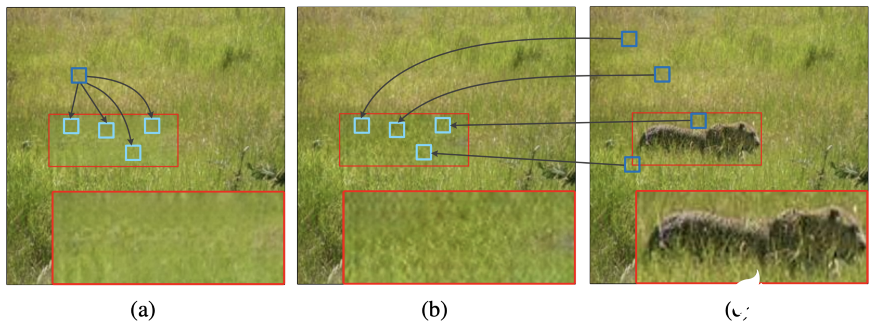

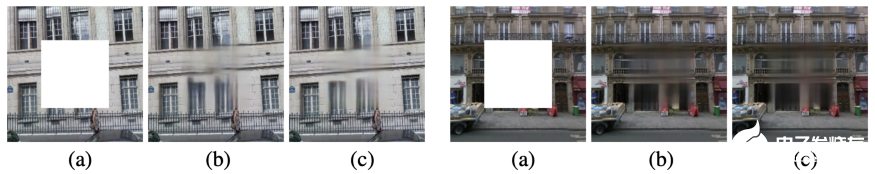

圖3,使用不同的相似性度量來搜索修復結果的最近鄰居。(a)余弦相似度的修復結果(b)提出的相對相似度的修復結果(c) Ground truth圖像(紅色矩形突出填充區域)

簡單地說,對于MRF目標,我們希望最小化生成的特征與通過預先訓練的網絡計算出的ground truth中的最近鄰居特征之間的差異。在大多數以前的工作,余弦相似性測量被用來尋找最近的鄰居。然而,這種相似性度量通常對不同生成的特征塊給出相同的最近鄰,導致修復結果模糊,如圖3(a)所示。

為了避免使用余弦相似度度量可能導致完成圖像模糊,我們采用了相對距離度量,修復結果如圖3(b)所示。你可以看到,完成的圖像有更好的局部精細紋理。

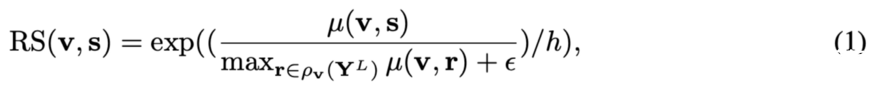

我們來談談它們是如何進行相對距離測量的。Y(hat)_g為缺失區域生成的內容,Y(hat)^L_g 和 Y^L 為預訓練網絡的第L層特征。對分別從Y(hat)^L_g 和 Y^L中提取的v和s特征塊,計算v與s的相對相似度:

mu(. , .)是余弦相似度。r屬于Y^L, v除外。h和 epsilon是正的常數。顯然,如果v比其他特性patch更類似于s,那么RS(v, s)就會很大。你也可以考慮,如果v有兩個類似的patchs和r,那么RS(v, s)就會很小。我們鼓勵在缺失區域之外尋找類似的patches。

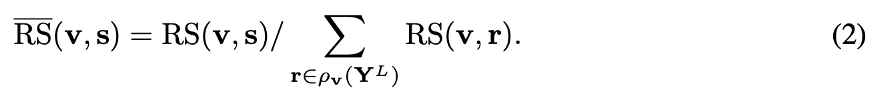

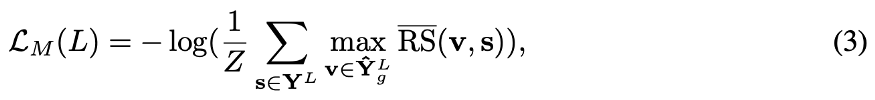

最后,計算了在Y(hat)^L_g 和 Y^L 之間的ID-MRF損耗。

其中參數max RS(bar)(v, s)表示s是v最近的鄰居,Z是一個歸一化因子。如果考慮所有生成的特征patch都接近于某一特征patch s的極端情況,則max RS(bar) (v, r)較小,因此ID-MRF損失較大。

另一方面,如果Y^L 中的每個r都有自己的最近鄰居Y(hat)^L_g,則max RS(bar) (v, r)很大,因而ID-MRF損失較小。這里,主要思想是強制/引導生成的特征patch有不同的最近鄰居,從而生成的feature具有更好的局部紋理。

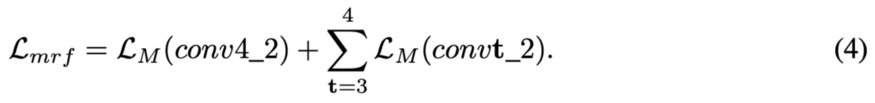

與先前的工作一樣,作者使用預先訓練的VGG19來計算ID-MRF損失。請注意,中間層conv3_2和conv4_2分別表示結構特征和語義特征。

作者聲稱這種損失與最近鄰搜索有關,并且只在訓練階段使用。這與在測試階段搜索最近鄰居的方法不同。

特征不變重建損失

所提出的空間變異重構損失實際上是一個加權的L1損失。確定權值的方法有很多種,本文利用高斯濾波器對掩模進行卷積,生成加權掩模,計算加權L1損耗。加權L1損失的主要思想是,接近有效像素的像素損失比遠離有效像素的像素損失受到更高的約束。因此,位于缺失區域中心的像素損失應該有更低的L1損失權值(即更少的約束)。

對抗損失

與先前的工作類似,作者采用了改進的WGAN損失和局部和全局鑒別器。

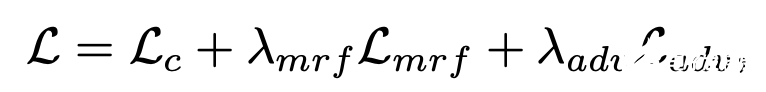

最終的損失函數

這是用于訓練所提模型的最終的損失函數。與大多數修復論文相似,加權L1損失(第一損失項)的重要性為1。Lambda_mrf和Lambda_adv是控制局部紋理mrf正則化和對抗訓練重要性的參數。

實驗

作者在5個公共數據集上評估了他們的方法,即Paris StreetView, Places2, ImageNet, CelebA和CelebA- hq數據集。在他們的訓練期間,所有的圖像都被調整為256×256,最大的中心孔的大小128×128。在GPU上測試256×256和512×512大小的圖像,每個圖像大約需要49.37 ms和146.11 ms。

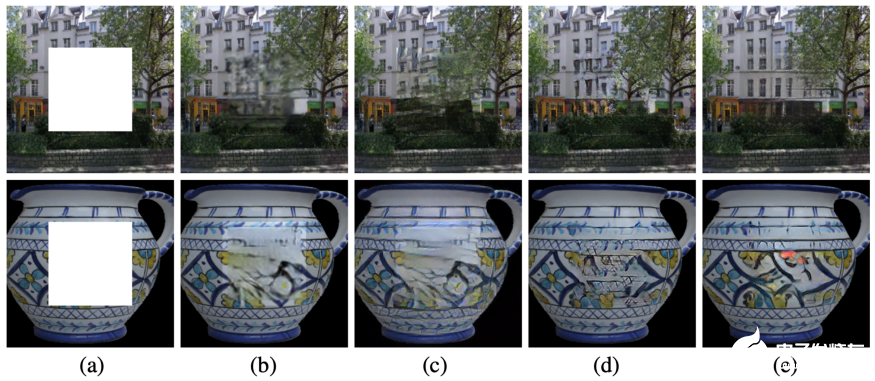

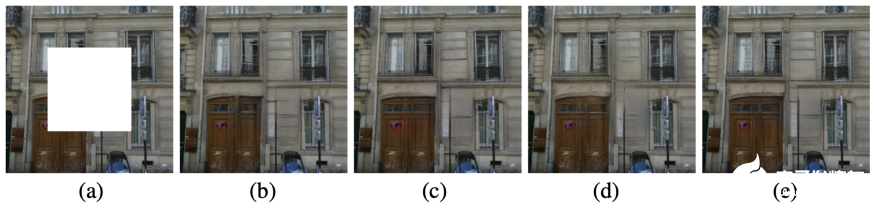

圖4,定性比較巴黎街景(上)和ImageNet(下)。(a)輸入圖像(b)上下文編碼器(c) MSNPS (d)上下文注意(e)提出的方法。

圖4顯示了Paris StreetView和ImageNet數據集的定性比較。請放大以更清楚地看到修復結果。很明顯,本文提出的方法GMCNN給出了具有最佳視覺質量的修復結果。

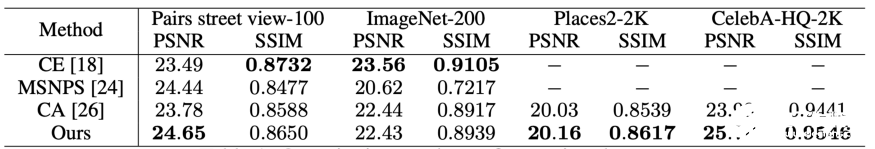

表1,五個數據集的定量結果

正如我在之前的文章和本文開頭提到的,PSNR與像素級重建精度有關,這可能不適用于評估圖像修復。研究人員仍然報告PSNR和SSIM供讀者參考,因為這些數值指標是所有圖像處理任務的基礎。如表1所示,本文提出的方法在五個數據集上獲得了相當甚至更好的PSNR和SSIM。

消融研究

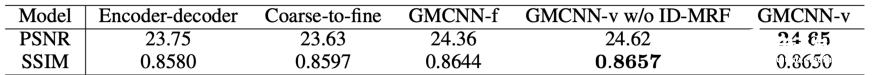

表2,巴黎街景數據集上不同網絡結構的定量結果

圖5,對巴黎街景數據集上不同網絡結構的定性比較。(a)輸入圖像(b)單個編碼器-解碼器(c)粗到細(d) 3個分支中感受野固定的GMCNN (e)感受野不同的GMCNN

對不同網絡結構在圖像修復中的性能進行了評價。在他們的實驗中,對于從粗到細的結構,沒有使用上下文注意力。對于三個分支中感受野固定的GMCNN,采用大小為5×5的過濾器。對于具有不同感受野的GMCNN,三個分支分別使用了3×3、5×5和7×7的kernel。定量和定性結果分別見表2和圖5。顯然,具有不同感受野的GMCNN提供了最好的修復效果。

除了網絡結構的選擇和多重感受野的使用,作者還研究了兩個提出的損失項的有效性,即信心驅動重建損失和ID-MRF損失。

圖6,對Paris StreetView數據集上不同重建損失的定性比較。(a)輸入圖像(b)空間折現損失(c)提出的置信驅動重建損失

圖6顯示了不同重建損失的視覺對比,即空間折現損失和提出的置信度驅動重建損失。請注意,空間折現損失根據像素的空間位置獲得權重掩碼,而提出的置信驅動重建損失通過將掩碼圖像與高斯濾波器進行多次卷積獲得權重掩碼。兩位作者聲稱,由置信度驅動的重建損失效果更好。從我自己的經驗來看,這兩種重建損失是相似的。也許你可以試一試。

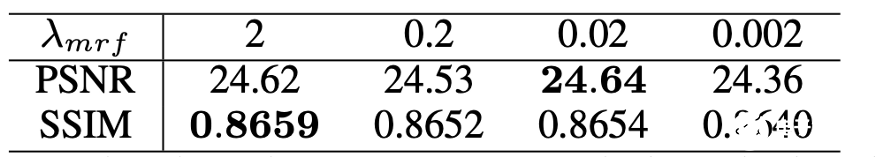

表3,在Paris StreetView數據集上使用不同的lambda_mrf的定量結果

圖7,在Paris StreetView數據集上使用ID-MRF損失與否的定性比較 (a) 輸入圖像(b)使用ID-MRF損失的修復結果(c)沒有使用ID-MRF損失的修復結果

圖8,在Paris StreetView數據集上使用ID-MRF loss與不同的lambda_mrf進行定性比較。(a) Input image (b) lambda_mrf = 2 (c) lambda_mrf = 0.2 (d) lambda_mrf = 0.02 (e) lambda_mrf = 0.002

更重要的是,ID-MRF損失項是本文最強調的。因此,作者表明了這一失項的重要性,定量結果列在表3中。圖7顯示了使用ID-MRF損失和不使用ID-MRF損失訓練的模型之間的區別。我們可以看到,使用ID-MRF可以增強生成像素的局部細節。此外,圖8顯示了使用不同的lambda_mrf來控制ID-MRF損失的重要性的效果。你可以放大以便更好地查看結果。我個人認為,修復的結果是相似的。從表3可以看出,lambda_mrf = 0.02提供了PSNR和視覺質量之間的良好平衡。

總結

綜上所述,本文的創新之處在于使用ID-MRF損失項來進一步增強生成內容的局部細節。這種損失的主要思想是引導生成的特征patch在缺失區域之外尋找最近的鄰居作為參考,并且最近的鄰居應該是多樣化的,這樣可以模擬更多的局部細節。

多重感受野(多列或多分支)的使用是由于感受野的大小對圖像修復任務很重要。由于局部相鄰像素缺失,我們必須借用遙遠空間位置的信息來填補缺失的像素。如果你看過我之前的文章,我想這個想法對你來說并不難理解。

使用加權L1損失也是由于缺少區域沒有“正確”答案的事實。對于那些更接近缺失區域邊界的缺失像素,它們相對受到接近有效像素的約束,因此需要對L1的損失賦予更高的權值。另一方面,對于位于缺失區域中心的缺失像素,它們的L1約束應該更小。

要點

參考我在上面的結論,我希望你能理解提出的ID-MRF損失的意義,因為這是本文的核心思想。對于本文的其他兩個思路,即多列結構和加權L1損失。事實上,如果你關注過我之前的文章,我認為你可以很好地理解背后的原因。我認為多重/多種感受野的概念是深層語義修復的常見做法。

對于加權的L1損失,從我個人的經驗來看,我不認為它會對修復性能帶來明顯的改善。當然,實現加權L1損失的方法有很多。如果你對此感興趣,可以試一試。

英文原文:https://towardsdatascience.com/what-if-multiple-receptive-fields-are-used-for-image-inpainting-ea44003ea7e9

編輯:jq

-

圖像

+關注

關注

2文章

1094瀏覽量

41090 -

網絡

+關注

關注

14文章

7783瀏覽量

90537 -

卷積

+關注

關注

0文章

95瀏覽量

18720 -

cnn

+關注

關注

3文章

354瀏覽量

22671

發布評論請先 登錄

高清術野攝像機助力手術過程的準確性和可視化

【每天學點AI】實戰圖像增強技術在人工智能圖像處理中的應用

評論