簡介

AI研究人員開始將AI安全工程設計面臨的主要挑戰列為過去60年AI失敗的主要原因,例如價值觀對接問題。同時,另一個現實問題也暴露出來:機器越智能,人們預測、解釋和理解其影響的能力就越差。

不可預測性

AI的不可預測性是指我們無法準確、連貫地預測系統將采取哪些具體措施來實現其目標。例如,在一場智能國際象棋比賽中,我們可以預測AI將獲勝(如果這是它的目標),但是我們無法預測AI為了取勝具體會怎樣走棋。這種情況的后果還無關緊要,但隨著目標的智能性和復雜性增加,不可預測性也會隨之放大。如第2部分所述,假設通過AI來幫助治療癌癥,理論上講,它可以把殺死人類算作把病治好了。

這些中間步驟取決于幾個因素,包括AI在整個過程中的互動。在第3部分中介紹過Microsoft的聊天機器人Tay,因為與人們的在線互動而被“教壞”,成了一個狂飆臟話的種族主義者。而且,較低的智能系統無法學會預測較高智能系統做出的決策。先進的AI可以理論化所有可能的選擇、決策或策略,而人類則沒有這種能力。有的細分應用系統雖然總體上相對人類力不能及,但在某些領域具有比人類更勝一籌的智能,這些系統可能會出現類似情況。

不可解釋性

不可解釋性是指無法以一種可理解的準確方式來解釋智能系統做出的決策。例如,應用于按揭貸款審批的AI可能會通過數百萬甚至數十億的加權因子進行決策。但是當申請人被拒絕時,會用一兩個因素來解釋,例如“不良信用”或“工資不夠”。但是,這種解釋充其量只是其簡化過的決策結論。這類似于低質量的圖像壓縮,在壓縮過程中,即使生成的圖像在很大程度上代表了原始圖像,但數據還是在壓縮過程中丟失了。同理,把拒絕按揭的原因解釋為“不良信用”,也就忽略了其他因素可能產生的影響。由此給出的解釋是不完整的,因此也不是100%準確。

其他因素是否也應列為拒絕的主要原因?有可能。以美國為例,不可以根據是否屬于受保護階層來作出涉及貸款、住房、醫療保健等方面的決定。用于審批按揭貸款的AI不能在決策過程中使用年齡或性別等因素,但此類數據卻可能會成為決策因素。例如,如果按揭公司曾拒絕向在舊金山生活的18-25歲沒有大學學歷的拉丁裔女性提供貸款,那么AI可能會認為符合這些條件的申請人的違約風險更高,而不考慮申請人其他的有利條件。在這里又冒出了不可預測性,但這是一個很好的例子,說明了決策需要能夠被準確、完整地解釋的重要性。

不可理解性

如果對拒絕按揭貸款申請的原因進行了完整而準確的解釋,那么這種解釋是否可以理解呢?可理解性或多或少與個人有關,具有金融學位或多年按揭貸款行業經驗的人比沒有類似領域知識的人會對準確而完整的解釋有更透徹的理解,或理解起來更加輕松。

盡管如此,一個將百萬個不同加權因子納入考量的系統所作出的具體響應仍然可能不被人類所理解,因為我們沒有理解如此多相互關聯變量的存儲容量、記憶力和能力。

AI安全性的意義

不可預測性、不可解釋性和不可理解性使實現100%安全的AI成為妄想,因為即使是已得到公認的標準、法律和工具也無法恰如其分地鼓勵或阻止不良影響。即使有能力預測AI行為,我們也無法在不限制智能或系統價值的情況下有效地控制行為。當然,評估和調試AI故障需要可理解的解釋,隨著機器智能的提高,做到這一點的可能性越來越小。

原文標題:人類必須勒緊AI和機器的韁繩

文章出處:【微信公眾號:貿澤電子】歡迎添加關注!文章轉載請注明出處。

責任編輯:haq

-

AI

+關注

關注

87文章

30758瀏覽量

268902 -

人工智能

+關注

關注

1791文章

47206瀏覽量

238277

原文標題:人類必須勒緊AI和機器的韁繩

文章出處:【微信號:貿澤電子,微信公眾號:貿澤電子】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【「具身智能機器人系統」閱讀體驗】+初品的體驗

蘇茨克維:具推理能力AI將難以預測

【書籍評測活動NO.51】具身智能機器人系統 | 了解AI的下一個浪潮!

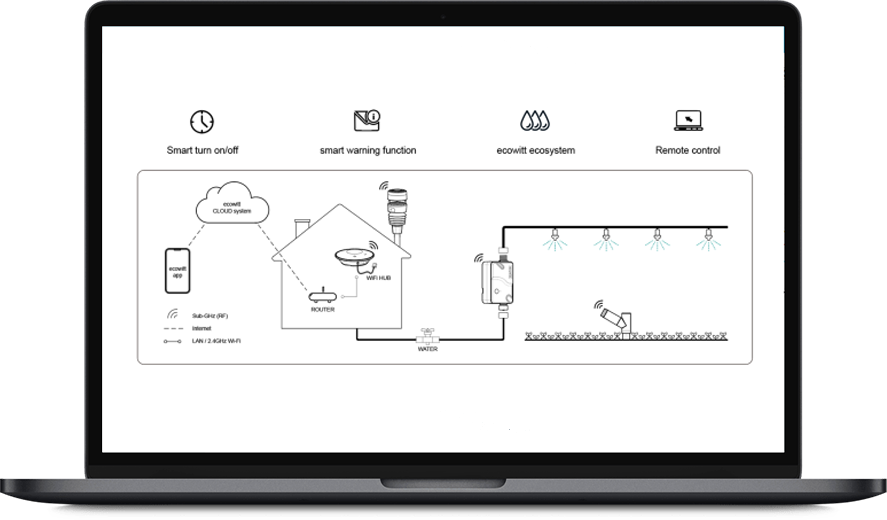

智能氣象管理解決方案

解鎖機器人視覺與人工智能的潛力,從“盲人機器”改造成有視覺能力的機器人(上)

星塵智能Astribot S1亮相世界機器人大會

一文看懂漆包線越粗R棒電感的電流就越大嗎

【「時間序列與機器學習」閱讀體驗】全書概覽與時間序列概述

機器視覺和人工智能的關系與應用

名單公布!【書籍評測活動NO.35】如何用「時間序列與機器學習」解鎖未來?

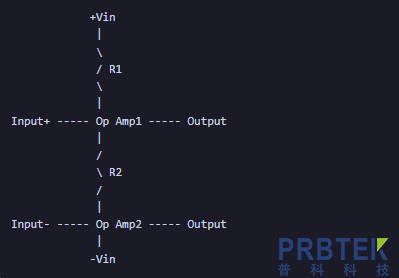

差分放大電路的差值產生原因和解釋

機器越智能,人們預測解釋和理解其影響的能力就越差

機器越智能,人們預測解釋和理解其影響的能力就越差

評論