全景分割是一個(gè)計(jì)算機(jī)視覺任務(wù),會(huì)將語義分割(為每個(gè)像素分配類標(biāo)簽)和實(shí)例分割(檢測(cè)和分割每個(gè)對(duì)象實(shí)例)合并。作為實(shí)際應(yīng)用中的核心任務(wù),全景分割通常使用多個(gè)代理 (Surrogate) 子任務(wù)(如使用邊界框檢測(cè)方法)粗略估計(jì)全景分割目標(biāo),來實(shí)現(xiàn)預(yù)測(cè)一組不相重疊的遮罩 (mask) 及其相對(duì)應(yīng)的類別標(biāo)簽(例如對(duì)象所屬的類別,如“汽車”、“交通指示燈”、“道路”等)。

在此代理樹中,每個(gè)子任務(wù)都會(huì)產(chǎn)生額外的手動(dòng)設(shè)計(jì)模塊,如錨點(diǎn)設(shè)計(jì)規(guī)則、邊界框分配規(guī)則、非極大值抑制 (NMS)、thing-stuff(thing 類物體和 stuff 類物體)合并,等等。雖然對(duì)于單個(gè)子任務(wù)和模塊,不乏一些出色的解決方案,但當(dāng)我們將這些子任務(wù)整合到一個(gè)流水線中進(jìn)行全景分割時(shí),就會(huì)產(chǎn)生不需要的構(gòu)件,在一些比較棘手的情況下更是如此(例如,兩個(gè)具有相似邊界框的人都觸發(fā) NMS,從而導(dǎo)致其中一個(gè)遮罩缺失)。

以往提出的 DETR 方法簡(jiǎn)化邊界框檢測(cè)子任務(wù)成端到端操作來解決其中一些問題,事實(shí)證明,這種做法的計(jì)算效率更高,產(chǎn)生的無關(guān)構(gòu)件也更少。然而,訓(xùn)練過程在很大程度上仍然依賴邊界框檢測(cè),這顯然與基于遮罩的全景分割定義不相符。另一種做法是將邊界框從管線中徹底移除,這樣做的好處是消除了整個(gè)子任務(wù)及其相關(guān)模塊和構(gòu)件。例如,Axial-DeepLab預(yù)測(cè)預(yù)定義實(shí)例中心的像素偏移量時(shí),如果圖像平面中有各種各樣的形狀,或相鄰對(duì)象的中心點(diǎn)較為接近,例如下面這張狗狗坐在椅子上的圖像,那它所使用的子任務(wù)則會(huì)遇到對(duì)象嚴(yán)重變形的挑戰(zhàn)。

當(dāng)狗狗的中心和椅子的中心接近重合時(shí),Axial-DeepLab 就會(huì)將它們合并成一個(gè)對(duì)象

在《MaX-DeepLab:利用遮罩 Transformer 實(shí)現(xiàn)端到端全景分割 (MaX-DeepLab: End-to-End Panoptic Segmentation with Mask Transformers)》(將提交給 CVPR 2021 大會(huì))一文中,我們首次為全景分割管線提出了完全的端到端方法——將 Transformer架構(gòu)擴(kuò)展到此計(jì)算機(jī)視覺任務(wù)中,直接預(yù)測(cè)具有類標(biāo)簽的遮罩。這種方法叫做 MaX-DeepLab,利用 Mask Xformer 對(duì) Axial-DeepLab 進(jìn)行擴(kuò)展。該方法采用雙路徑架構(gòu),引入了全局內(nèi)存路徑,允許與任何卷積層直接通信。MaX-DeepLab 最終在極具挑戰(zhàn)的COCO數(shù)據(jù)集上以及無邊界框的狀態(tài)下實(shí)現(xiàn)了 7.1% 的顯著全景質(zhì)量 (PQ) 增益,首次消除了有邊界框方法和無邊界框方法之間的差距。在不增加測(cè)試時(shí)長(zhǎng)的情況下,就 PQ 方面而言,MaX-DeepLab 在 COCO 測(cè)試開發(fā)集上達(dá)到了 51.3% 的水平,這已是目前的最高水準(zhǔn)。

MaX-DeepLab 是完全端到端的:直接從圖像中預(yù)測(cè)全景分割遮罩

端到端全景分割

受 DETR 啟發(fā),我們的模型使用經(jīng)過 PQ 類目標(biāo)優(yōu)化的輸出遮罩和類,直接預(yù)測(cè)一組不相重疊的遮罩及其相應(yīng)的語義標(biāo)簽。具體來說,我們受到評(píng)估指標(biāo) PQ 的定義:識(shí)別質(zhì)量(預(yù)測(cè)的類是否正確)乘以分割質(zhì)量(預(yù)測(cè)的遮罩是否正確)的啟發(fā),以一模一樣的方式在兩個(gè)具有類標(biāo)簽的遮罩之間定義了一個(gè)相似度指標(biāo)。直接通過一對(duì)一匹配,最大化實(shí)際遮罩和預(yù)測(cè)遮罩之間的這種相似度,直接對(duì)模型進(jìn)行訓(xùn)練。這種對(duì)全景分割的直接建模使端到端訓(xùn)練和推理成為可能,消除了現(xiàn)有的有邊界框方法和無邊界框方法必須手工設(shè)計(jì)先驗(yàn)的弊端。

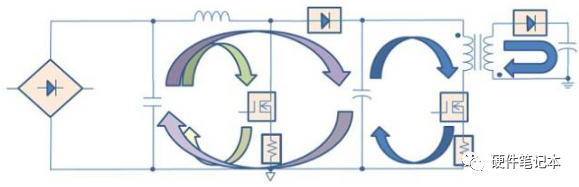

與卷積神經(jīng)網(wǎng)絡(luò) (CNN) 上堆疊傳統(tǒng) Transformer 的方案不同,我們提出了一種結(jié)合 CNN 與 Transformer 的雙路徑框架。具體而言,我們通過一個(gè)雙路徑 Transformer 元件,使 CNN 層能夠從全局內(nèi)存中讀寫數(shù)據(jù)。這里所說的這個(gè)元件采用了 CNN 路徑和內(nèi)存路徑之間的所有四種注意力 (Attention) 類型,可以插入到 CNN 中的任意位置,從而允許在任何層與全局內(nèi)存通信。MaX-DeepLab 還利用堆疊的沙漏式解碼器,可將多種尺度特征聚合成高分辨率輸出。然后系統(tǒng)會(huì)將該輸出與全局內(nèi)存特征相乘,形成遮罩組預(yù)測(cè)。至于遮罩類別,則使用另一種 Transformer 進(jìn)行預(yù)測(cè)。

雙路徑 Transformer 架構(gòu)概覽

結(jié)果

我們?cè)跇O具挑戰(zhàn)性的 COCO 全景分割數(shù)據(jù)集上,分別使用先進(jìn)的無邊界框方法 (Axial-DeepLab) 和有邊界框方法 (DetectoRS) 對(duì) MaX-DeepLab 進(jìn)行了評(píng)估。在不增加測(cè)試時(shí)長(zhǎng)的情況下,就 PQ 方面而言,MaX-DeepLab 在 COCO 測(cè)試開發(fā)集上達(dá)到了 51.3% 的水平,這已是目前的最高水準(zhǔn)。

在無邊界框狀態(tài)下,就 PQ 方面而言,這一結(jié)果比 Axial-DeepLab 高出 7.1%,比 DetectoRS 高出 1.7%,第一次消除了有邊界框方法和無邊界框方法之間的差距。為了與 DETR 進(jìn)行一致的比較,我們還評(píng)估了與 DETR 參數(shù)數(shù)量和算力均一致的輕量級(jí) MaX-DeepLab 版本。就 PQ 方面而言,此輕量級(jí) MaX-DeepLab 在 val 集上的表現(xiàn)優(yōu)于 DETR 3.3%,在測(cè)試開發(fā)集上的表現(xiàn)優(yōu)于 DETR 3.0%。此外,我們還對(duì)端到端表達(dá)式、模型伸縮、雙路徑架構(gòu)和損失函數(shù)進(jìn)行了廣泛的消融研究和分析。此外,MaX-DeepLab 也不像 DETR 一樣需要超長(zhǎng)訓(xùn)練計(jì)劃。

MaX-DeepLab 正確地分割了一只坐在椅子上的狗。Axial-DeepLab依賴于回歸對(duì)象中心偏移量的代理任務(wù)。它之所以失敗,是因?yàn)楣泛鸵巫拥闹行奶^于接近。作為代理任務(wù),DetectoRS 會(huì)將對(duì)象的邊界框而非遮罩進(jìn)行分類。由于椅子的邊界框置信度較低,所以就被濾除了。

關(guān)于 MaX-DeepLab 和先進(jìn)的無邊界框及有邊界框方法的案例研究

還有一個(gè)例子可以證明 MaX-DeepLab 可以在充滿挑戰(zhàn)的條件下正確分割圖像。

MaX-DeepLab 正確分割了相互重疊的斑馬。此例對(duì)于其他方法也非常具有挑戰(zhàn)性,因?yàn)檫@兩只斑馬的邊界框很相似,對(duì)象的中心也很接近

結(jié)論

我們首次證明了全景分割可以進(jìn)行端到端訓(xùn)練。MaX-DeepLab 使用遮罩 Transformer 直接預(yù)測(cè)遮罩和類,消除了手工設(shè)計(jì)對(duì)于經(jīng)驗(yàn)的依賴,如對(duì)象邊界框、thing-stuff(thing 類物體和 stuff 類物體)合并等。借助 PQ 式損失函數(shù)和雙路徑 Transformer,MaX-DeepLab 在極具挑戰(zhàn)性的 COCO 數(shù)據(jù)集上取得了最高水準(zhǔn)的結(jié)果,消除了有邊界框方法和無邊界框方法之間的差距。

原文標(biāo)題:MaX-DeepLab:用于端到端全景分割的雙路徑 Transformer

文章出處:【微信公眾號(hào):TensorFlow】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

責(zé)任編輯:haq

-

計(jì)算機(jī)視覺

+關(guān)注

關(guān)注

8文章

1698瀏覽量

46030 -

tensorflow

+關(guān)注

關(guān)注

13文章

329瀏覽量

60540

原文標(biāo)題:MaX-DeepLab:用于端到端全景分割的雙路徑 Transformer

文章出處:【微信號(hào):tensorflowers,微信公眾號(hào):Tensorflowers】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

transformer專用ASIC芯片Sohu說明

英偉達(dá)推出歸一化Transformer,革命性提升LLM訓(xùn)練速度

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構(gòu)分析」閱讀體驗(yàn)】--全書概覽

Transformer能代替圖神經(jīng)網(wǎng)絡(luò)嗎

Transformer語言模型簡(jiǎn)介與實(shí)現(xiàn)過程

Transformer架構(gòu)在自然語言處理中的應(yīng)用

使用PyTorch搭建Transformer模型

Transformer 能代替圖神經(jīng)網(wǎng)絡(luò)嗎?

基于xLSTM和Transformer的模型評(píng)估:xLSTM在“語言能力”的表現(xiàn)

基于Transformer模型的壓縮方法

PSoC雙核架構(gòu)中雙核都可以訪問全部外設(shè)嗎?

基于Transformer的多模態(tài)BEV融合方案

電源路徑的基本概念

MaX-DeepLab:雙路徑Transformer架構(gòu)概覽

MaX-DeepLab:雙路徑Transformer架構(gòu)概覽

評(píng)論