引言

命名實(shí)體識(shí)別(Named Entity Recognition,NER)是自然語言處理領(lǐng)域的一個(gè)基礎(chǔ)任務(wù),是信息抽取等許多任務(wù)的子任務(wù),旨在識(shí)別非結(jié)構(gòu)化文本中屬于預(yù)先定義的類別的命名實(shí)體,例如人名、組織、地點(diǎn)等。命名實(shí)體識(shí)別通常被視為一個(gè)序列標(biāo)注任務(wù)。

在 ACL-IJCNLP 2021 收錄的論文中,共有30余篇論文與命名實(shí)體識(shí)別相關(guān),其中4篇論文關(guān)注中文命名實(shí)體識(shí)別。本次推送將分享 ACL-IJCNLP 2021 中與中文命名實(shí)體識(shí)別相關(guān)的3篇論文。

文章概覽

增強(qiáng)實(shí)體邊界檢測以提升中文命名實(shí)體識(shí)別

Enhancing Entity Boundary Detection for Better Chinese Named Entity Recognition

論文地址:https://aclanthology.org/2021.acl-short.4/

這篇文章研究了中文命名實(shí)體識(shí)別中的邊界檢測增強(qiáng)方法,探索從兩個(gè)方面來增強(qiáng)實(shí)體邊界信息:一是增加一個(gè)圖注意力網(wǎng)絡(luò)層來捕捉句子中詞之間的依賴關(guān)系;二是將實(shí)體首尾詞匯的預(yù)測看作是兩個(gè)獨(dú)立的二分類問題,作為輔助任務(wù)加入訓(xùn)練。實(shí)驗(yàn)證明,文章所提出的邊界增強(qiáng)模型對(duì)于實(shí)體邊界和實(shí)體類型的識(shí)別有提升,并且在書面與非書面文本上都有效果,在OntoNotes4、OntoNotes5等數(shù)據(jù)集上達(dá)到了SOTA效果。

帶有語音線索的大規(guī)模中文多模態(tài)NER數(shù)據(jù)集

A Large-Scale Chinese Multimodal NER Dataset with Speech Clues

論文地址:https://aclanthology.org/2021.acl-long.218/

這篇文章對(duì)于融合文本和語音多模態(tài)的中文命名實(shí)體識(shí)別進(jìn)行了探索。文章首先構(gòu)建了一個(gè)大規(guī)模的中文多模態(tài)嵌套命名實(shí)體識(shí)別數(shù)據(jù)集CNERTA,并提出了一個(gè)多模態(tài)多任務(wù)的模型,通過引入一個(gè)speech-to-text對(duì)齊的輔助任務(wù)來利用語音模態(tài)中蘊(yùn)含的停頓信息進(jìn)而有助于分詞。實(shí)驗(yàn)顯示論文提出的模型在CNERTA上達(dá)到了SOTA效果。

提高模型泛化能力:中文命名實(shí)體識(shí)別案例研究

Improving Model Generalization: A Chinese Named Entity Recognition Case Study

論文地址:https://aclanthology.org/2021.acl-short.125/

這篇論文主要研究了數(shù)據(jù)集中的數(shù)據(jù)偏差對(duì)于模型泛化能力的影響。文章通過分析五個(gè)基準(zhǔn)中文NER數(shù)據(jù)集,確定了兩種可能影響模型泛化能力的數(shù)據(jù)偏差,并提出一種實(shí)體重新平衡法來改進(jìn)訓(xùn)練集,從而提升模型泛化能力。

論文細(xì)節(jié)

1

論文動(dòng)機(jī)

命名實(shí)體識(shí)別需要對(duì)實(shí)體在句子中的邊界和實(shí)體類別進(jìn)行識(shí)別。與英文相比,中文沒有顯性的詞邊界、實(shí)體邊界以及時(shí)態(tài)信息,因此中文命名實(shí)體識(shí)別更具挑戰(zhàn)性。目前中文命名實(shí)體識(shí)別的SOTA性能與英文差了將近10%的F1值。

這篇文章試圖從增強(qiáng)實(shí)體邊界的識(shí)別的角度來更好地進(jìn)行中文命名實(shí)體識(shí)別。考慮到Star-Transformer獨(dú)特的星形拓?fù)浣Y(jié)構(gòu)能夠減少冗余連接,同時(shí)保留近似模擬長程依賴關(guān)系的能力,因此使用Star-Transformer來構(gòu)建一個(gè)輕量級(jí)的命名實(shí)體識(shí)別基線系統(tǒng)。

在這個(gè)基線系統(tǒng)的基礎(chǔ)上,文章從兩個(gè)角度來增強(qiáng)實(shí)體的邊界信息:一是添加了一個(gè)圖注意力網(wǎng)絡(luò)層來捕捉句子、短語、實(shí)體內(nèi)部的依賴,從而隱式地區(qū)分邊界;二是將實(shí)體首尾的預(yù)測作為輔助任務(wù),從而顯式地區(qū)分邊界。

方法

這篇文章提出的模型將命名實(shí)體識(shí)別視作一個(gè)序列標(biāo)注任務(wù),模型整體架構(gòu)如下圖所示,包括Token embedding layer,Encoder和Decoder三個(gè)部分。模型Decoder為條件隨機(jī)場。

1. Token embedding layer

模型以中文詞匯作為token單位。考慮到缺少明確的詞邊界信息,為了防止分詞錯(cuò)誤的傳播,將詞的表示與字符表示相結(jié)合。從預(yù)訓(xùn)練詞向量中獲得詞匯和漢字的向量,然后將漢字向量的序列通過一個(gè)雙向GRU層,獲取雙向GRU的輸出作為漢字的表示。

最終token的表示由詞向量、字向量經(jīng)過雙向GRU的輸出以及詞性標(biāo)注拼接而成。

2. Encoder

模型的Encoder主要由三個(gè)部分構(gòu)成:作為基線的Star-Transformer、圖注意力網(wǎng)絡(luò)和基于兩個(gè)GRU的實(shí)體首尾表示層。

Star-Transformer

文章認(rèn)為對(duì)于命名實(shí)體識(shí)別任務(wù)而言,實(shí)體是稀疏的,因此沒必要總是關(guān)注所有token之間的關(guān)系。經(jīng)典的Transformer的token之間實(shí)際上是全連接的,Star-Transformer通過引入一個(gè)中繼節(jié)點(diǎn),減少潛在的冗余連接,同時(shí)保留了近似模擬長程依賴關(guān)系的能力。

Star-Transformer的拓?fù)浣Y(jié)構(gòu)由一個(gè)中繼節(jié)點(diǎn)和多個(gè)衛(wèi)星節(jié)點(diǎn)構(gòu)成,第i個(gè)衛(wèi)星節(jié)點(diǎn)的狀態(tài)表示句子中第i個(gè)token,中繼節(jié)點(diǎn)充當(dāng)一個(gè)虛擬樞紐從所有的衛(wèi)星節(jié)點(diǎn)收集信息并分發(fā)信息。對(duì)于NER這種序列標(biāo)注任務(wù),取衛(wèi)星節(jié)點(diǎn)的狀態(tài)作為Star-Transformer的序列輸出。初始化時(shí),每個(gè)衛(wèi)星節(jié)點(diǎn)的狀態(tài)都由對(duì)應(yīng)token的表示初始化,中繼節(jié)點(diǎn)被初始化為所有token的均值。各節(jié)點(diǎn)更新過程如下式所示。

在更新的過程中,每個(gè)衛(wèi)星節(jié)點(diǎn)狀態(tài)的更新只與其有共邊的節(jié)點(diǎn)的上輪狀態(tài)以及該位置對(duì)應(yīng)token的表示有關(guān)。中繼節(jié)點(diǎn)的更新則取決于這一輪更新后的所有衛(wèi)星節(jié)點(diǎn)狀態(tài),以及上一輪自身的狀態(tài)。

文章在衛(wèi)星節(jié)點(diǎn)的更新過程中還加入了一個(gè)Highway Network,通過門控機(jī)制來緩解潛在的梯度問題,從而減輕star-transformer的深度和復(fù)雜性。

此處 相當(dāng)于一個(gè)門,對(duì)于衛(wèi)星節(jié)點(diǎn)的上輪狀態(tài)一部分進(jìn)行仿射變換,剩余部分直接通過,再與star-transformer的多頭注意力結(jié)果相加,作為衛(wèi)星節(jié)點(diǎn)的最終更新結(jié)果。

圖注意力網(wǎng)絡(luò)

文章用于增強(qiáng)實(shí)體邊界的第一個(gè)做法是使用圖注意力網(wǎng)絡(luò)來建模詞之間的依賴關(guān)系,從而將句子、短語的結(jié)構(gòu)信息納入到表示中,也有助于捕捉實(shí)體內(nèi)部詞語之間的依賴關(guān)系,從而隱式地增強(qiáng)實(shí)體的邊界信息。圖注意力網(wǎng)絡(luò)利用注意力計(jì)算,來為與某個(gè)節(jié)點(diǎn)有關(guān)聯(lián)的所有節(jié)點(diǎn)分配不同的重要性。具體的多頭圖注意力網(wǎng)絡(luò)計(jì)算過程如下式。

基于GRU的實(shí)體首尾表示層

文章用于增強(qiáng)實(shí)體邊界的第二個(gè)做法是將實(shí)體邊界的檢測看作兩個(gè)二分類任務(wù),亦即詞匯是否為實(shí)體之首、是否為實(shí)體之尾。使用兩個(gè)獨(dú)立的GRU層進(jìn)行這兩個(gè)輔助的二分類任務(wù)的預(yù)測,從而清晰、顯式地直接提供實(shí)體的邊界信息。

模型的Encoder輸出如下式。

而損失函數(shù)便是多任務(wù)的損失之和,包括實(shí)體標(biāo)簽序列分類預(yù)測的交叉熵?fù)p失和兩個(gè)實(shí)體首尾分類預(yù)測的交叉熵?fù)p失。

實(shí)驗(yàn)

實(shí)驗(yàn)語料庫包括三個(gè)常見的中文NER數(shù)據(jù)集:OntoNotes4、OntoNotes5和Weibo。對(duì)于兩個(gè)增強(qiáng)邊界信息的方法進(jìn)行了消融實(shí)驗(yàn),并將實(shí)體識(shí)別的錯(cuò)誤分成了類型錯(cuò)誤、未識(shí)別錯(cuò)誤和邊界錯(cuò)誤這三類。

對(duì)于配合了Highway Network的Star-Transformer,它在較小的社交媒體Weibo數(shù)據(jù)集上較為有效,優(yōu)于前面所有現(xiàn)有模型。

考慮到OntoNotes的結(jié)構(gòu)特性,它的實(shí)體都具有相似的組成,利用圖注意力網(wǎng)絡(luò)來建模實(shí)體內(nèi)部的依賴將OntoNotes的Precision分別提高了3.93%和1.62%。而引入實(shí)體首尾預(yù)測的二分類輔助任務(wù)顯著減少了OntoNotes上的邊界錯(cuò)誤數(shù)量。同時(shí)考慮兩個(gè)增強(qiáng)方法的模型在OntoNotes的各種評(píng)價(jià)指標(biāo)上基本都達(dá)到了最好的效果,也進(jìn)一步減少了邊界錯(cuò)誤的數(shù)量。因此,所提出的邊界增強(qiáng)模型對(duì)于實(shí)體邊界和實(shí)體類型的識(shí)別都有所提升。

對(duì)于Weibo的標(biāo)準(zhǔn)Named Entity數(shù)據(jù)集,也有與OnteNotes相似的表現(xiàn)。說明這個(gè)邊界增強(qiáng)模型對(duì)于書面與非書面文本都有效果。

2

論文動(dòng)機(jī)

大多數(shù)關(guān)于命名實(shí)體識(shí)別的研究只依靠文本來推斷標(biāo)簽,當(dāng)文本噪聲多或是較短時(shí),僅憑文本信息不足以準(zhǔn)確定位和分類命名實(shí)體,因此可以考慮引入其他模態(tài)作為文本模態(tài)的補(bǔ)充。而目前已有的多模態(tài)命名實(shí)體識(shí)別多是在融合文本模態(tài)與視覺模態(tài),且研究大多局限于英語。目前的中文命名實(shí)體識(shí)別研究都完全忽略了有價(jià)值的多模態(tài)信息。

文章認(rèn)為語音模態(tài)在中文命名實(shí)體識(shí)別中能夠起到獨(dú)特作用,特別是能提供精確的分詞信息。因?yàn)檎Z音模態(tài)所包含的線索有相鄰詞匯之間的停頓,從而可以幫助模型確定詞邊界。例如在“南京市長江大橋”這個(gè)句子中,傳統(tǒng)中文NER模型可能打出地點(diǎn)“南京市”和地點(diǎn)“長江大橋”的標(biāo)簽,也可能打出地點(diǎn)“南京”和人名“江大橋”的標(biāo)簽;

而這兩種標(biāo)簽所對(duì)應(yīng)的句子發(fā)音與停頓實(shí)際上是大有不同的,如果有對(duì)應(yīng)的語音信息的輔助,模型便能夠更好地確定分詞信息,繼而更好地確定實(shí)體邊界。文章試圖在訓(xùn)練過程中將文本和對(duì)應(yīng)的語音進(jìn)行對(duì)齊,找到每個(gè)漢字在語音中的位置,從而利用語音中的停頓等信息來輔助詞邊界的確定。

方法

中文多模態(tài)NER數(shù)據(jù)集構(gòu)建

由于以往沒有融合語音信息的NER研究,也沒有中文多模態(tài)NER研究,文章首先構(gòu)建了一個(gè)大規(guī)模的中文語音多模態(tài)NER數(shù)據(jù)集CNERTA。CNERTA包含文本及其命名實(shí)體標(biāo)注,以及文本對(duì)應(yīng)的語音。CNERTA中標(biāo)注了人名、地點(diǎn)和組織這三類命名實(shí)體,也對(duì)所有嵌套實(shí)體進(jìn)行了標(biāo)注。

基線系統(tǒng)

文章選取了三類基線系統(tǒng):

基于字符的模型:BiLSTM-CRF、BERT-CRF、MacBERT-CRF

詞匯增強(qiáng)模型:Lattice-LSTM、ZEN

多模態(tài)模型:Cross-Modal Attention Module (CMA)、Multimodal Interaction Module (MMI)

多模態(tài)多任務(wù)NER模型M3T

在語音嵌入方面,首先將語音信號(hào)進(jìn)行特定的處理,包括預(yù)加重、分幀加窗、短時(shí)傅立葉變換STFT等,并計(jì)算filter banks等特征。然后經(jīng)過兩個(gè)在時(shí)間和頻率上的卷積對(duì)語音特征進(jìn)行下采樣,并通過一個(gè)Transformer的Encoder來建模依賴,最后得到語音的特征序列。

M3T使用了一個(gè)CMA模塊(Cross-Modal Attention Module)來融合文本與語音的信息。將文本特征序列作為query,語音特征序列作為key和value計(jì)算多頭注意力,從而得到經(jīng)過語音特征增強(qiáng)的新的文本表示。具體計(jì)算如下式。

其中LN為層歸一化,F(xiàn)FN為全連接的前饋神經(jīng)網(wǎng)絡(luò),由兩個(gè)帶有ReLU激活的線性變換組成。CMA的輸出即可送入條件隨機(jī)場進(jìn)行解碼推斷NER標(biāo)簽。

CMA雖然能夠融合文本和語音模態(tài),但并沒有對(duì)文本和語音進(jìn)行對(duì)齊。因此論文還引入了一個(gè)CTC(Connectionist Temporal Classification)層作為輔助任務(wù),來幫助進(jìn)行文本和語音的對(duì)齊,找到每個(gè)漢字在語音中的位置。

在CTC層中,每一幀的語音先被映射到字典+空格的空間上,然后經(jīng)過一個(gè)logit函數(shù)得到一個(gè)(|V|+1)*t維的矩陣G,其中|V|是字典規(guī)模,t為語音幀數(shù),并將對(duì)應(yīng)文本中沒有出現(xiàn)過的字進(jìn)行mask。

CTC的解碼過程取每幀上概率最大的字作為該幀上預(yù)測的輸出,可能是漢字、標(biāo)點(diǎn)也可能是空格。然后CTC將沒有被空格隔開的相同的字合并,最后將空格移除得到預(yù)測的漢字序列,最終實(shí)現(xiàn)從語音到文本的對(duì)齊,進(jìn)而納入語音中的停頓等信息。

這個(gè)masked G可以計(jì)算出CTC loss。整個(gè)模型使用的混合損失便由條件隨機(jī)場損失和CTC損失組成,如下式,其中為超參數(shù)。

實(shí)驗(yàn)

引入語音模態(tài)可以顯著提高基于字符的模型的性能,即使是使用簡單的CMA也能在所有Flat NER和嵌套NER中帶來超過1.6%的F1提升,而使用M3T則能夠帶來超過3%的提升;

引入語音模態(tài)也可以提高詞匯增強(qiáng)模型的性能,例如對(duì)于ZEN。使用CMA能夠在Flat NER和嵌套NER中帶來1.38%和1.73%的F1提升,而M3T模型能讓它們的性能提升2.93%和3.19%。雖然提升沒有基于字符的模型那么顯著,但仍證明了語音模態(tài)可以提供一些大規(guī)模詞典中未包含的信息;

論文所提出的M3T模型能夠在CNERTA數(shù)據(jù)集中實(shí)現(xiàn)SOTA效果,論文推測這些改進(jìn)來源于CTC捕捉到的語音模態(tài)與文本模態(tài)之間的單調(diào)對(duì)齊關(guān)系,有了對(duì)齊信息,模型就可以利用語音中包含的顯性詞邊界信息。

文章也進(jìn)一步分析了命名實(shí)體識(shí)別的錯(cuò)誤來源,將錯(cuò)誤分為類型錯(cuò)誤和邊界錯(cuò)誤,類型錯(cuò)誤指邊界正確但預(yù)測類型錯(cuò)誤,其余情況都被歸為邊界錯(cuò)誤。

可見通過論文的M3T模型來融合語音模態(tài)可以有效地減少邊界錯(cuò)誤的數(shù)量。

3

論文動(dòng)機(jī)

通過分析五個(gè)常用的中文NER數(shù)據(jù)集,文章提出在中文NER數(shù)據(jù)集中廣泛存在著兩類數(shù)據(jù)偏差問題:

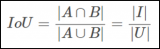

中文NER驗(yàn)證集/測試集中50-70%的實(shí)體都在訓(xùn)練集中出現(xiàn)過,因而驗(yàn)證集/測試集實(shí)際上難以評(píng)估模型的真實(shí)泛化能力。論文定義了一個(gè)稱為實(shí)體覆蓋率的度量來量化驗(yàn)證集/測試集中可見實(shí)體的程度,

其中是一個(gè)獲取實(shí)體列表的函數(shù)。五個(gè)中文NER數(shù)據(jù)集中實(shí)體覆蓋率情況如表所示,可見實(shí)體占了很大的比例。

大多數(shù)NER數(shù)據(jù)集都由少數(shù)fat-head實(shí)體主導(dǎo),即出現(xiàn)頻率異常高的實(shí)體。例如在Cluener的組織類別中,曼聯(lián)出現(xiàn)了59次,而法蘭克福只出現(xiàn)了1次。這樣可能鼓勵(lì)模型單純記住這些出現(xiàn)頻率高的實(shí)體,而不是在訓(xùn)練過程中利用上下文學(xué)習(xí)該實(shí)體類別的模式。

論文提到這是因?yàn)樵诮o定相同實(shí)體和不同上下文的情況下,模型收斂最簡單的方式是記住實(shí)體,而非從不同的上下文中提取模式。論文使用實(shí)體出現(xiàn)頻率的峰度度量數(shù)據(jù)集的fat-head程度,如下表所示。數(shù)據(jù)集中絕大部分類別的峰度超過3,部分類別峰度極高乃至超過1000。總體來說,頻率最高的前1%的實(shí)體貢獻(xiàn)了21%的出現(xiàn)次數(shù)。fat-head實(shí)體的現(xiàn)象在中文NER數(shù)據(jù)集中很嚴(yán)重。

方法

文章首先通過從驗(yàn)證集和測試集中排除所有可見實(shí)體來改進(jìn)驗(yàn)證集與測試集。然后提出了一種實(shí)體重新平衡方法,使同一類別內(nèi)的實(shí)體均勻分布,從而避免該類別的實(shí)體模式被fat-head實(shí)體主導(dǎo)。

論文提出實(shí)體重新平衡法主要是出于認(rèn)為多數(shù)情況下同一類別內(nèi)的不同實(shí)體在語義上可互換,使得實(shí)體均勻分布后將鼓勵(lì)模型利用上下文信息,因?yàn)椴辉儆衼碜苑植疾痪鶆虻暮唵我?guī)律可利用。

在實(shí)體重新平衡法中,首先對(duì)需要平衡的類別構(gòu)建一個(gè)實(shí)體counter,然后將其轉(zhuǎn)化為一個(gè)balanced counter,使得出現(xiàn)次數(shù)最多和最少的實(shí)體次數(shù)之間最大差值僅為1。隨機(jī)替換fat-head實(shí)體,將該類別的原始實(shí)體分布轉(zhuǎn)化為balanced counter中的均勻分布。具體步驟見下方偽代碼。

實(shí)驗(yàn)

實(shí)驗(yàn)使用的統(tǒng)一模型架構(gòu)為BERT+CRF。實(shí)驗(yàn)結(jié)果見下表,其中Baseline列使用原始訓(xùn)練數(shù)據(jù),Proposed列使用實(shí)體重新平衡后的訓(xùn)練數(shù)據(jù),它們都在排除所有可見實(shí)體的驗(yàn)證集和測試集上進(jìn)行調(diào)參與測試。

在五個(gè)數(shù)據(jù)集的大部分類別中,文章提出的實(shí)體平衡算法都能夠提高模型識(shí)別不可見實(shí)體的能力。但也有例外,例如Cluener中的address,論文給出的解釋是address類別可能包含特定的地緣政治實(shí)體,它們?cè)谡Z義上不可互換,因此算法會(huì)失效;在Resume數(shù)據(jù)集上效果也不佳,論文給出的解釋是簡歷的結(jié)構(gòu)串聯(lián)性不強(qiáng),可利用的上下文知識(shí)很少。

因此,論文也總結(jié)了提出的實(shí)體平衡算法有效的條件:首先,同一類別的實(shí)體需要在語義上可以互換;其次,實(shí)體應(yīng)當(dāng)依賴上下文信息。

來自:復(fù)旦DISC

作者:石靄青

編輯:jq

-

語音

+關(guān)注

關(guān)注

3文章

385瀏覽量

38028 -

Gru

+關(guān)注

關(guān)注

0文章

12瀏覽量

7477 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24689

原文標(biāo)題:【ACL2021】基于邊界檢測增強(qiáng)的中文命名實(shí)體識(shí)別

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

如何使用ar增強(qiáng)現(xiàn)實(shí)體驗(yàn)

級(jí)聯(lián)4個(gè)AIC10,但是在硬件識(shí)別檢測時(shí),每次檢測到的AIC10Num不是4,這是為什么?

越界智能監(jiān)測攝像機(jī)

目標(biāo)檢測與圖像識(shí)別的區(qū)別在哪

目標(biāo)檢測與識(shí)別技術(shù)有哪些

目標(biāo)檢測與識(shí)別技術(shù)的關(guān)系是什么

圖像識(shí)別算法都有哪些方法

人臉檢測與識(shí)別的方法有哪些

圖像檢測與識(shí)別技術(shù)的關(guān)系

河道水面漂浮物識(shí)別檢測 YOLO算法

蘋果ReALM模型在實(shí)體識(shí)別測試中超越OpenAI GPT-4.0

如何識(shí)別與檢測集成芯片

助力移動(dòng)機(jī)器人下游任務(wù)!Mobile-Seed用于聯(lián)合語義分割和邊界檢測

對(duì)象檢測邊界框損失函數(shù)–從IOU到ProbIOU介紹

關(guān)于邊界檢測增強(qiáng)的中文命名實(shí)體識(shí)別

關(guān)于邊界檢測增強(qiáng)的中文命名實(shí)體識(shí)別

評(píng)論