多模式視覺語言模型依賴大量數(shù)據(jù)集來對圖像和文本之間的關(guān)系進(jìn)行建模。一般來說,這些數(shù)據(jù)集有兩種創(chuàng)建方法:手動為圖像添加文字說明,或抓取網(wǎng)頁并提取替代文本 (alt-text)作為文字說明。雖然前一種方法更利于產(chǎn)生更高質(zhì)量的數(shù)據(jù),但高強(qiáng)度的人工注釋過程限制了可創(chuàng)建的數(shù)據(jù)量。另一方面,雖然自動提取方法可以產(chǎn)生更大的數(shù)據(jù)集,但卻需要通過啟發(fā)式算法以及仔細(xì)過濾來確保數(shù)據(jù)質(zhì)量,或者擴(kuò)展模型來保證強(qiáng)大性能。現(xiàn)有數(shù)據(jù)集的另一個缺點(diǎn)是極少涉及非英語語言。這不禁讓我們產(chǎn)生疑問:我們能否突破這些限制,創(chuàng)建包含各種內(nèi)容的高質(zhì)量、大規(guī)模、多語言數(shù)據(jù)集?

圖像和文本之間的關(guān)系

https://ai.googleblog.com/2014/11/a-picture-is-worth-thousand-coherent.html

確保數(shù)據(jù)質(zhì)量

https://ai.googleblog.com/2018/09/conceptual-captions-new-dataset-and.html

對此,我們推出了基于維基百科的圖像文本 (WIT) 數(shù)據(jù)集。這是一個大型多模式數(shù)據(jù)集,通過從維基百科文章和 Wikimedia 圖像鏈接中提取與圖像相關(guān)的多種不同文本選擇集創(chuàng)建而成。在創(chuàng)建過程中會執(zhí)行嚴(yán)格的過濾環(huán)節(jié),以便僅保留高質(zhì)量的圖像文本集。

基于維基百科的圖像文本 (WIT) 數(shù)據(jù)集

https://github.com/google-research-datasets/wit

如我們在 SIGIR 2021 上發(fā)布的“WIT:適用于多模式、多語言機(jī)器學(xué)習(xí)的基于維基百科的圖像文本數(shù)據(jù)集 (WIT: Wikipedia-based Image Text Dataset for Multimodal Multilingual Machine Learning)”中詳細(xì)說明的那樣,該過程產(chǎn)生一個包含 3750 萬個實(shí)體豐富的圖像文本示例精選集,其中涵蓋 1150 萬張獨(dú)特的圖像,跨越 108 種語言。大家可憑知識共享許可下載并使用 WIT 數(shù)據(jù)集。此外,我們也很高興地宣布,我們將與 Wikimedia Research 以及其他外部協(xié)作者攜手在 Kaggle 舉辦 WIT 數(shù)據(jù)集的競賽。

| 數(shù)據(jù)集 |

圖像 數(shù)量 |

文本 |

上下文 文本 |

語言數(shù)量 |

| Flickr30K | 32K | 158K | - | < 8 |

| SBU Captions | 1M | 1M | - | 1 |

| MS-COCO | 330K | 1.5M | - |

< 4;7 (僅限測試) |

| CC-3M | 3.3M | 3.3M | - | 1 |

| CC-12M | 12M | 12M | - | 1 |

| WIT | 11.5M | 37.5M | ~119M | 108 |

相比以往數(shù)據(jù)集,WIT 的語言更多,規(guī)模更大

WIT 數(shù)據(jù)集的獨(dú)特優(yōu)勢包括:

1. 大規(guī)模:WIT 是公開提供的最大的圖像文本示例多模式數(shù)據(jù)集。

2.多語言:WIT 擁有 108 種語言,是其他數(shù)據(jù)集的十倍或以上。

3.上下文信息:與典型的多模式數(shù)據(jù)集(每個圖像只有一個文字說明)不同,WIT 包含許多頁面級和部分級上下文信息。

4.現(xiàn)實(shí)世界實(shí)體:維基百科是一個覆蓋廣泛的知識庫,其豐富的現(xiàn)實(shí)世界實(shí)體可以在 WIT 中得以體現(xiàn)。

5.具有挑戰(zhàn)性的測試集:在我們最近獲得 EMNLP 接受的研究中,所有最先進(jìn)的模型在 WIT 上表現(xiàn)出的性能都明顯低于傳統(tǒng)評估集,例如平均召回率 (recall)下降約 30 點(diǎn)。

最近獲得 EMNLP 接受的研究

https://arxiv.org/abs/2109.05125

數(shù)據(jù)集的創(chuàng)建過程

WIT 的主要目標(biāo)是在不犧牲質(zhì)量和概念覆蓋面的情況下創(chuàng)建大型數(shù)據(jù)集。因此,我們選擇利用當(dāng)今最大的在線百科全書:維基百科。

就可用信息的深度而言,我們以維基百科上的“Half Dome”(加州約塞米蒂國家公園)頁面為例如下所示,文章為圖像提供了許多有趣的文本說明和相關(guān)的上下文信息,如頁面標(biāo)題、主要頁面描述以及其他上下文信息和元數(shù)據(jù)。

我們首先選擇包含圖像的維基百科頁面,然后提取各種圖像文本關(guān)聯(lián)內(nèi)容和周圍的上下文。為進(jìn)一步優(yōu)化數(shù)據(jù),我們執(zhí)行嚴(yán)格的過濾環(huán)節(jié)來確保數(shù)據(jù)質(zhì)量。過濾過程包含:

●

基于文本的過濾,以確保文字說明的可用性、長度和質(zhì)量(例如通過刪除通用默認(rèn)填充文本);

●

基于圖像的過濾,以確保每個圖像都具有特定的大小且擁有允許的許可;

●

基于圖像和文本實(shí)體的過濾,以確保適合研究(例如排除仇恨類言論)。

接著我們進(jìn)一步對圖像文字說明集隨機(jī)抽樣,由真人進(jìn)行校對評估,他們中絕大多數(shù)人都認(rèn)可一個結(jié)論:98% 樣本其圖像與文字說明一致。

高度語言多樣性

WIT 擁有 108 種語言的數(shù)據(jù),是首個大規(guī)模、多語言、多模式數(shù)據(jù)集。

| 圖像文本集數(shù)量 |

獨(dú)特語言 數(shù)量 |

圖像數(shù)量 |

獨(dú)特語言 數(shù)量 |

| > 1M | 9 | > 1M | 6 |

| 500K - 1M | 10 | 500K - 1M | 12 |

| 100K - 500K | 36 | 100K - 500K | 35 |

| 50K - 100K | 15 | 50K - 100K | 17 |

| 14K - 50K | 38 | 13K - 50K | 38 |

WIT:跨語言覆蓋統(tǒng)計信息

首個上下文圖像文字?jǐn)?shù)據(jù)集

大多數(shù)多模式數(shù)據(jù)集僅為給定圖像提供單個文本說明(或類似文字說明的多個版本)。WIT 是首個提供上下文信息的數(shù)據(jù)集, 可以幫助研究人員就上下文對圖像文字說明以及圖像選擇的影響進(jìn)行建模。

具體而言,可能有助于研究的 WIT 關(guān)鍵文本字段包括:

●

文本說明:WIT 提供三種不同的圖像文字說明,包括(可能受上下文影響的)“參考描述”、(可能不受上下文影響的)“屬性描述”,以及“替代文本描述”。

●

上下文信息:包括頁面標(biāo)題、頁面描述、網(wǎng)址和有關(guān)維基百科部分的局部上下文(包括部分標(biāo)題和文本)。

如下所示,WIT 在以下不同字段具有廣泛的覆蓋。

|

WIT 圖像 文字字段 |

訓(xùn)練 | Val | 測試 | 合計/獨(dú)特 |

| 行/元組 | 37.1M | 261.8K | 210.7K | 37.6M |

| 獨(dú)特的圖像 | 11.4M | 58K | 57K | 11.5M |

| 參考描述 | 16.9M | 150K | 104K | 17.2M/16.7M |

| 屬性描述 | 34.8M | 193K | 200K | 35.2M/10.9M |

| 替代文本 | 5.3M | 29K | 29K | 5.4M/5.3M |

| 上下文文本 | - | - | - | 119.8M |

WIT 的關(guān)鍵字段兼有文本說明和上下文信息

高質(zhì)量訓(xùn)練集與

具有挑戰(zhàn)性的評估基準(zhǔn)

維基百科廣泛覆蓋各種概念,這意味著 WIT 評估集作為評估基準(zhǔn)非常具有挑戰(zhàn)性,即使對于最先進(jìn)的模型而言也是如此。在圖像文本檢索方面,我們發(fā)現(xiàn)傳統(tǒng)數(shù)據(jù)集的平均召回分?jǐn)?shù) (mean recall scores)為 80 秒,而對于 WIT 測試集而言,資源豐富的語言為 40 秒,資源不足的語言為 30 秒。我們希望這可以轉(zhuǎn)而幫助研究人員構(gòu)建更強(qiáng)大、更穩(wěn)健的模型。

WIT 數(shù)據(jù)集與 Wikimedia 和

Kaggle 攜手開展競賽

此外,非常高興地宣布,我們將攜手 Wikimedia Research 以及一些外部協(xié)作者共同組織 WIT 測試集的競賽。競賽將在 Kaggle 舉辦,競賽任務(wù)為圖像文本檢索。我們將給定一組圖像和文本說明,而參賽者的任務(wù)是為每個圖像檢索適當(dāng)?shù)奈淖终f明。

為促進(jìn)該領(lǐng)域的研究,維基百科為大部分訓(xùn)練和測試數(shù)據(jù)集提供了 300 像素分辨率的圖像和基于 Resnet-50 的圖像嵌入向量。除 WIT 數(shù)據(jù)集以外,Kaggle 還將托管所有圖像數(shù)據(jù),并提供 Colab notebooks。此外,參賽者屆時可訪問 Kaggle 論壇,以便分享代碼和開展協(xié)作。任何對多模態(tài)感興趣的人都可以借此輕松開始并運(yùn)行實(shí)驗(yàn)。我們很高興并且期待各位參賽者可以在 Kaggle 平臺,通過 WIT 數(shù)據(jù)集和維基百科圖像為我們帶來精彩表現(xiàn)。

結(jié)論

我們相信 WIT 數(shù)據(jù)集將幫助研究人員構(gòu)建更好的多模態(tài)多語言模型,并識別更好的學(xué)習(xí)和表征技術(shù),最終借助視覺語言數(shù)據(jù)在現(xiàn)實(shí)世界任務(wù)中優(yōu)化機(jī)器學(xué)習(xí)模型。如有任何問題,請聯(lián)系 wit-dataset@google.com。我們非常愿意傾聽您如何使用 WIT 數(shù)據(jù)集。

責(zé)任編輯:haq

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7114瀏覽量

89315 -

模型

+關(guān)注

關(guān)注

1文章

3280瀏覽量

48989 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8430瀏覽量

132858

原文標(biāo)題:基于維基百科的圖像文本數(shù)據(jù)集 (WIT)

文章出處:【微信號:tensorflowers,微信公眾號:Tensorflowers】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

借助谷歌Gemini和Imagen模型生成高質(zhì)量圖像

ChatGPT 的多語言支持特點(diǎn)

科大訊飛發(fā)布訊飛星火4.0 Turbo大模型及星火多語言大模型

中興通訊引領(lǐng)5G-A高質(zhì)量發(fā)展新紀(jì)元

TVP5147高質(zhì)量、單芯片數(shù)字視頻解碼器數(shù)據(jù)表

TVP5146高質(zhì)量、單芯片數(shù)字視頻解碼器數(shù)據(jù)表

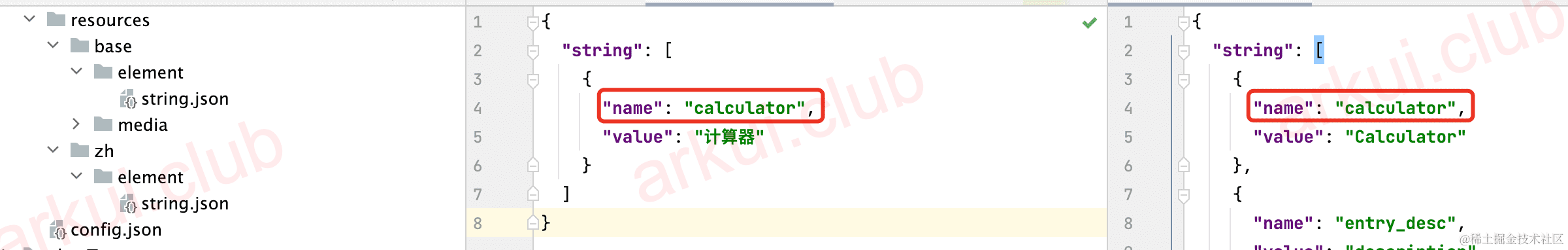

OpenHarmony開發(fā)技術(shù):【國際化】實(shí)例

云知聲入選中國信通院《數(shù)字醫(yī)療產(chǎn)品及服務(wù)高質(zhì)量發(fā)展全景圖》

北斗芯片產(chǎn)業(yè)的高質(zhì)量發(fā)展之路

名單公布!【書籍評測活動NO.30】大規(guī)模語言模型:從理論到實(shí)踐

大語言模型(LLMs)如何處理多語言輸入問題

穩(wěn)中創(chuàng)新?產(chǎn)業(yè)升級?高質(zhì)量發(fā)展 | 聯(lián)誠發(fā)高質(zhì)量發(fā)展工作推進(jìn)會議召開

捷易科技出席廣東省韶關(guān)市高質(zhì)量發(fā)展大會

為工業(yè) 4.0 工廠的大規(guī)模定制、高質(zhì)量和可持續(xù)運(yùn)營提供支持

如何創(chuàng)建高質(zhì)量、大規(guī)模、多語言的數(shù)據(jù)集

如何創(chuàng)建高質(zhì)量、大規(guī)模、多語言的數(shù)據(jù)集

評論