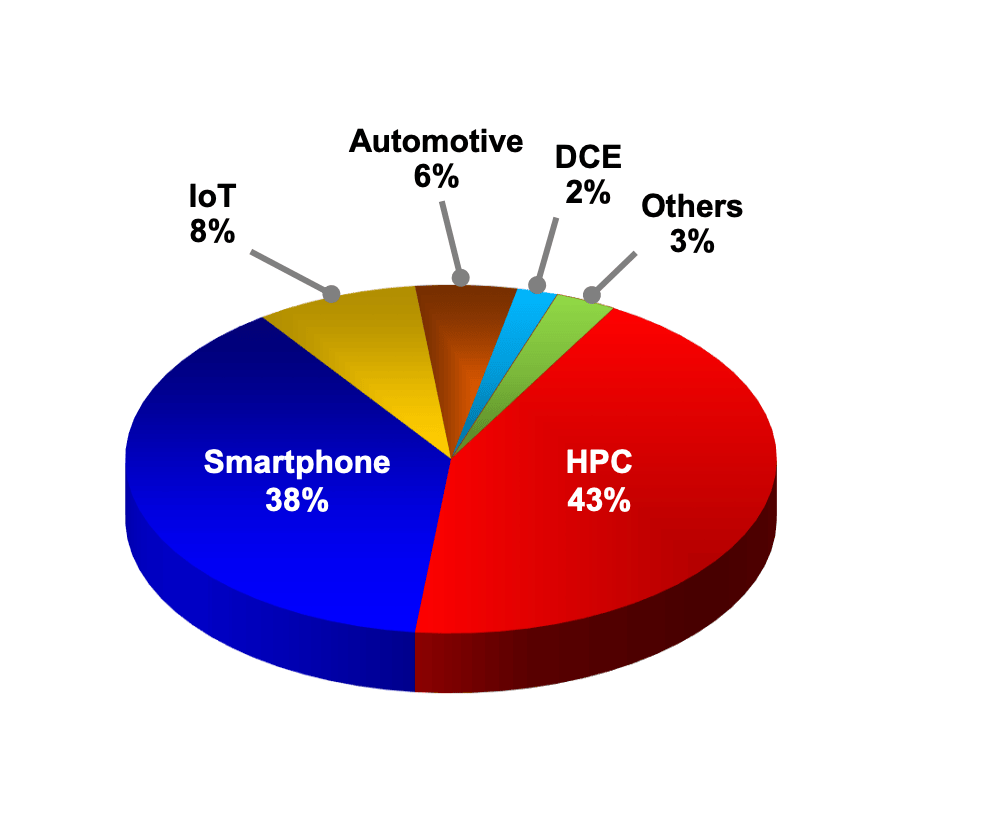

電子發燒友網報道(文/周凱揚)近兩年以來存儲市場可謂好不熱鬧,SSD帶來的急速已經體現在了下至消費電子,上至超算的性能上,然而隨著高性能計算走上了全新的道路,大吞吐量和大容量也已經不再是HPC存儲關注的唯二設計目標了。

那么當下的HPC存儲遇上了哪些挑戰呢?首先數據生成已經在被數據接入逐漸取代,大數據環境下,IOPS要求的反而是小數據的隨機存取。其次,“尋找”到真正所需的數據成了最關鍵的一環,也對元數據在統計、讀取、寫入和刪除上提出了更高的要求。加之近年來涌現的不同文件與數據形式,處理起來需要額外的注意,高性能存儲必須具備大型數據轉移的能力。

新的高性能計算場景

就以目前一些在建的智能城市項目為例,諸多傳感器和執行器散落在城市中,激光雷達、攝像頭、微流控傳感器和電機,它們將產生PB級別的原始數據,這些數據在需要經過壓縮、預處理、上傳、深度學習和推理,存儲可以說與邊緣計算和機器學習緊密聯系在一起。

另一個例子就是我們的自動駕駛,如今的自動駕駛方案都是通過數據與高性能計算實現的,像特斯拉這樣的廠商甚至自研自建芯片和超算,用于其自動駕駛技術的開發。自動駕駛測試車隊每天都要將PB級的遙測傳感數據傳輸給數據平臺,隨后經過標簽、分類、錯誤檢測和仿真,再放到大型存儲系統中,而這樣的大型存儲平臺不僅大小可能擴展至EB級,還要承受著仿真、再處理與機器學習的繁重負載。

在這些新場景給出的挑戰下,興起了一波新的技術,比如PCIe 4.0朝PCIe 5.0轉變,光模塊從200G朝400G的轉變,使用GPU直接存儲等專用協議等等。這些技術多數是對HPC存儲在吞吐量上的提升,而更重要的是對特定工作流效率的優化。

HPC系統中存儲的組成

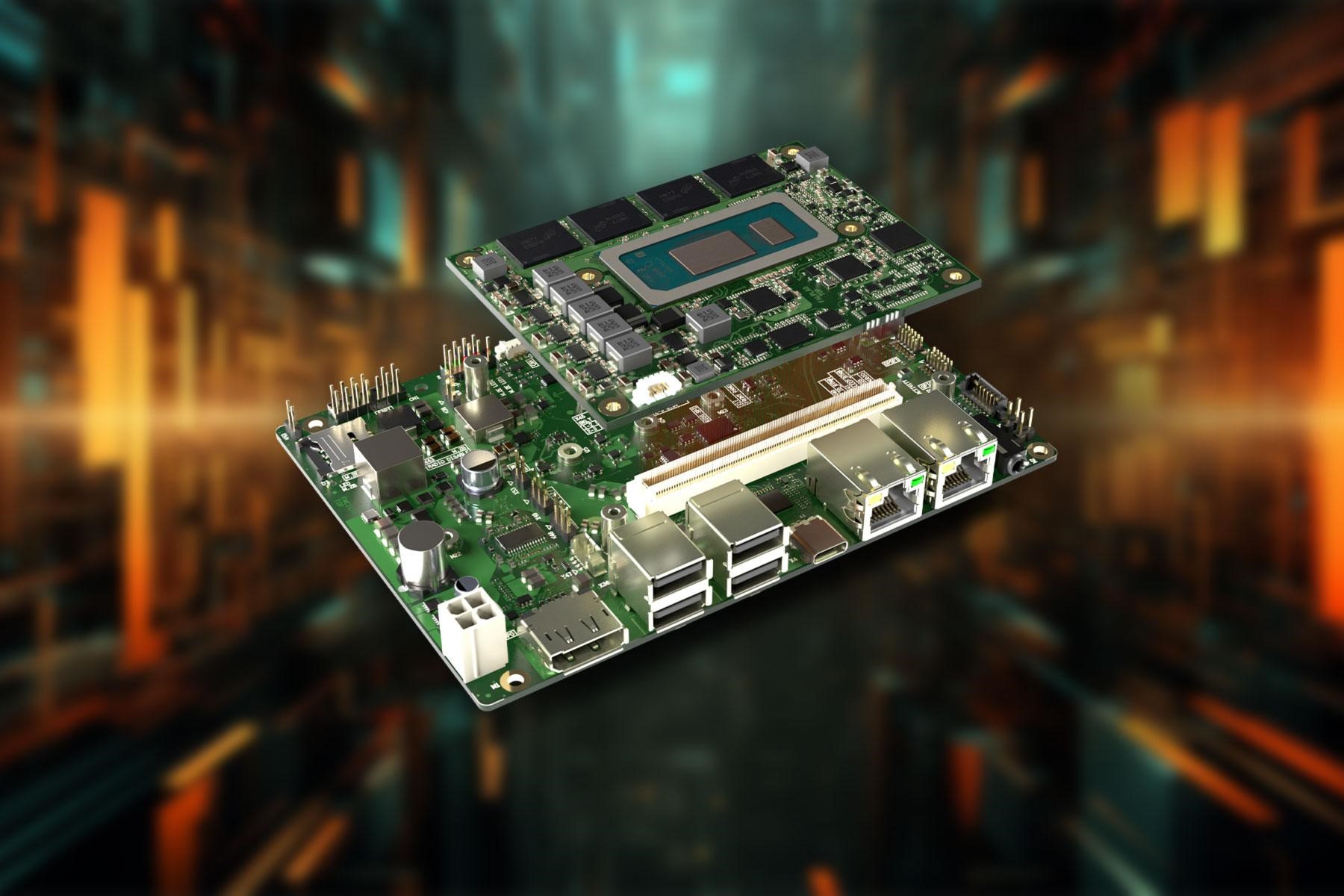

在當下的HPC場景中,無論是本地部署還是云端環境,都需要一個計算平臺,可能是CPU或是CPU+GPU/加速器的配置,這一節點可以充分利用3D Xpoint這樣的持久內存,不僅可以提供低延遲的內存數據訪問,在斷電下不丟失數據,還可以用上DAOS這樣分布式異步對象存儲的文件系統。

接著是存儲平臺,也就是并行文件系統的所在,這個系統可能是基于Lustre、Spectrum或是NVMe-oF的方案。但無論是哪種系統,考慮到需要低成本大容量,通常都會用到NVMe硬盤和HDD硬盤的混合方案,但這就提出了數據分布以及數據移動上的挑戰。不過現在已經有了PCC/LROC這樣的客戶端持久性高速緩存,在存儲或數據敏感的環境中,只需完成計算平臺和存儲平臺相關的數據移動,進一步降低了I/O開銷。

最后是數據的管理,這一部分屬于對大量數據更加長期的存儲,比如像波音這樣的航空公司,需要對每一架飛機的細致數據存儲50年以上,還要具備數據追溯的能力。這樣的存儲并不需要擁有高速的性能,但在前端的程序需要時提供即時的交互,而且為了節能考慮,要做到所謂的“零功耗存儲”。

超算是怎么做的?

隨著不少超算都已經在布局百億億級的系統,作為HPC中最頂端的應用,我們自然可以從中窺得一二,看一看當下主流的HPC存儲方案。以計劃于今年打造完成的Frontier超算為例,該超算將成為美國第一臺百億億級別的超算,算力約為1.5 exaFLOPS。

Frontier采取了AMD的全套方案,結合AMD的EPyc CPU和Radeon Instinct GPU,在AMD的緩存一致性互聯方案下,CPU上的代碼可以直接訪問GPU內存,這也就是我們在上文提到的GPU直接存儲技術。在存儲系統上,Frontier用到了679PB基于Lustre+ZFS的文件系統方案,用47700塊硬盤實現,最高速率可達5TB/s。高速存儲上,共有5400塊NVMe固態硬盤組成11PB的存儲空間,提供10TB/s的讀取速度。

而Aurora同樣作為今年推出的百億億級超算系統,則選擇了英特爾的方案,單個計算節點由兩個Xeon Sapphire Rapids、6個Xe Ponte Vecchio GPU和一個通用內存架構組成。其主要存儲方案也選擇了英特爾的DAOS文件系統,結合NVMe和傲騰持久內存,組成一套大于230PB的系統,并實現25TB/s的速度。

小結

在HPC存儲上的挑戰除了以上提到的這些外,還有近來興起的存內計算激發的計算能力挑戰,未來5年內,無論是存儲結構、文件系統乃至存儲材料都會再度迎來新的變化。這些變化會先一步解決HPC上的難題,再潛移默化地改善日常應用。

原文標題:速度和容量受制?No!高性能存儲的瓶頸不止于此

文章出處:【微信公眾號:電子發燒友網】歡迎添加關注!文章轉載請注明出處。

審核編輯:湯梓紅

-

存儲

+關注

關注

13文章

4298瀏覽量

85810 -

SSD

+關注

關注

21文章

2859瀏覽量

117376 -

HPC

+關注

關注

0文章

315瀏覽量

23756

原文標題:速度和容量受制?No!高性能存儲的瓶頸不止于此

文章出處:【微信號:elecfans,微信公眾號:電子發燒友網】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

云計算HPC軟件關鍵技術

云計算和HPC的關系

ADC的FMC接口協議支持VITA 57.1 FMC1 HPC CONNECTOR嗎?

維諦技術(Vertiv):未來HPC,你想象不到的酷炫變革!

云計算hpc的主要功能是什么

HPC云計算前景

AI是把雙刃劍,HPC面臨的全新機遇與挑戰

AWS HPC為什么不用Infiniband?有何原因?

康佳特歡迎COM-HPC載板設計指南Rev. 2.2的發布 COM-HPC Mini規范現已完善

看一下通過采用HPC方法來解決汽車行業工程挑戰的兩個具體實例

什么是HPC高性能計算

當下的HPC存儲遇上了哪些挑戰

當下的HPC存儲遇上了哪些挑戰

評論