電子發(fā)燒友網(wǎng)報(bào)道(文/周凱揚(yáng))人工智能的蓬勃發(fā)展促使產(chǎn)業(yè)對(duì)AI基礎(chǔ)設(shè)施提出了更高的性能要求,先進(jìn)計(jì)算處理單元,尤其是ASIC或GPU,為了在機(jī)器學(xué)習(xí)、HPC提供穩(wěn)定的算力表現(xiàn),傳統(tǒng)的內(nèi)存系統(tǒng)已經(jīng)不太能滿足日益增加的帶寬了。與此同時(shí),在我們報(bào)道的不少AI芯片、HPC系統(tǒng)中,HBM或類(lèi)似的高帶寬內(nèi)存越來(lái)越普遍,為數(shù)據(jù)密集型應(yīng)用提供了支持。

提及HBM,不少人都會(huì)想到成本高、良率低等缺陷,然而這并沒(méi)有影響業(yè)內(nèi)對(duì)HBM的青睞,諸如AMD的Radeon Pro 5600M、英偉達(dá)的A100 等消費(fèi)級(jí)/企業(yè)級(jí)GPU,或是思科的路由ASIC芯片Silicon One Q100、英特爾與AMD-Xilinx的FPGA,都用到了HBM內(nèi)存。就在今年1月底,JEDEC終于正式發(fā)布了HBM的第四代HBM3的標(biāo)準(zhǔn)。

HBM3性能未來(lái)可期

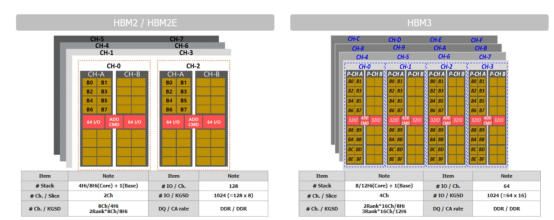

HBM2/2E與HBM3的架構(gòu)對(duì)比 / SK海力士

HBM3帶來(lái)的性能提升大家應(yīng)該都比較清楚了,傳輸速率是HBM2的兩倍,達(dá)到了6.4Gb/s,使得每個(gè)堆棧最高可達(dá)819GB/s的帶寬。可用的獨(dú)立通道也從HBM2的8個(gè)擴(kuò)充至16個(gè),加上每個(gè)通道兩個(gè)偽通道的設(shè)計(jì),HBM3可以說(shuō)支持到32通道了,提供更優(yōu)秀的時(shí)序來(lái)提升系統(tǒng)性能。

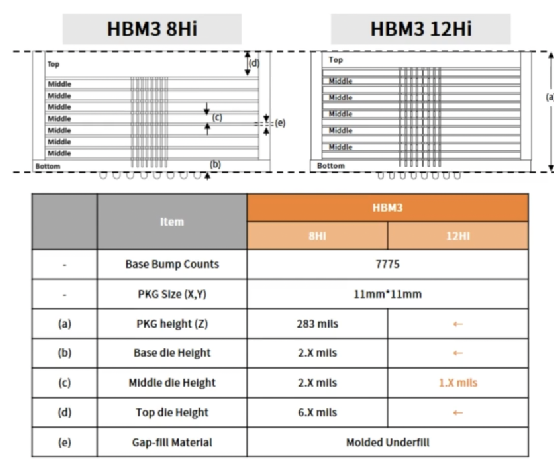

HBM3 8Hi和12Hi的機(jī)械結(jié)構(gòu)對(duì)比 / SK海力士

HBM3的TSV堆疊層數(shù)支持4-high、8-high和12-high,這倒是和HBM2e沒(méi)有什么差別。從SK海力士提供的機(jī)械結(jié)構(gòu)圖來(lái)看,無(wú)論是8Hi還是12Hi,其封裝大小和高度都是一樣的,只不過(guò)是減小了中間堆疊的裸片高度。這僅僅是第一代HBM3,未來(lái)HBM3會(huì)擴(kuò)展至16-high的TSV堆棧,單設(shè)備的內(nèi)存密度范圍也將達(dá)到4GB至64GB,不過(guò)第一代HBM3設(shè)備的話,目前用到的依然是16GB的內(nèi)存層。

此外,在散熱上,通過(guò)增加dummy bump、增加HBM3裸片大小并降低間隙高度,HBM3成功將溫度降低了25%,實(shí)現(xiàn)了更好的散熱性能。在7位ADC的支持下,HBM3的溫度傳感器也能以1℃的分辨率輸出0到127℃的溫度信息。

首個(gè)用上HBM3的平臺(tái)

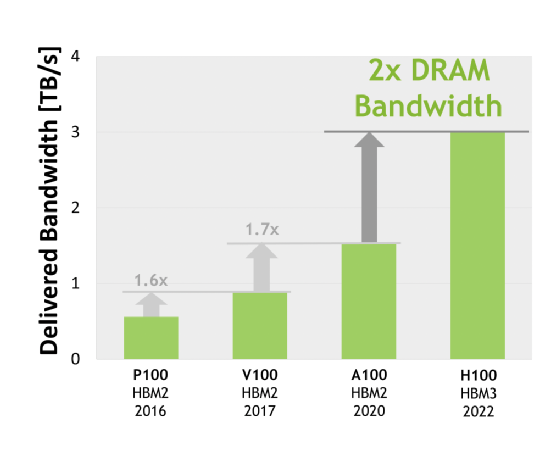

以在GTC22上亮相的H100 GPU為例,這是全球首個(gè)支持PCIe 5.0并利用HBM3的GPU,其內(nèi)存容量達(dá)到了80GB。這個(gè)容量與上一代A100一致,但帶寬卻有了質(zhì)的飛躍,與采用HBM2的A100相比,H100的內(nèi)存帶寬提升了兩倍,達(dá)到了3TB/s。

英偉達(dá)各個(gè)系列GPU加速卡的內(nèi)存帶寬 / 英偉達(dá)

你可能會(huì)感到疑惑,既然HBM3可以提供每個(gè)堆棧16GB以上的內(nèi)存,從H100的芯片圖上看來(lái)有6個(gè)HBM3,為何只有80GB呢?是不是英偉達(dá)為了成本有所閹割?

其實(shí)原因很簡(jiǎn)單,6個(gè)HBM3的其中一個(gè)為Dummy Die,所以真正可用的HBM3內(nèi)存只有5x16也就是80GB,所以英偉達(dá)在H100的白皮書(shū)也明確提到了這80GB是由5 Stacks的HBM3內(nèi)存組成。如此做的原因很可能是出于良率的考量,畢竟我們已經(jīng)提到了HBM良率低的包袱,而且上一代80GB HBM2e的A100也是如此設(shè)計(jì)的。

HBM找到了新的市場(chǎng)

根據(jù)SK海力士給出的市場(chǎng)預(yù)期,HBM市場(chǎng)正在以40%的年復(fù)合增長(zhǎng)率席卷HPC、AI和CPU等應(yīng)用,如今這其中還多出來(lái)一個(gè)特殊的應(yīng)用,那就是ADAS和自動(dòng)駕駛。如今的自動(dòng)駕駛芯片上幾乎看不到HBM的存在,即便是英偉達(dá)的Jetson AGX Orin,用的也只是256位的LPDDR5內(nèi)存,帶寬最高只有204.8GB/s。

這種情況再正常不過(guò)了,誰(shuí)叫如今的ADAS或自動(dòng)駕駛方案還用不到HBM的大帶寬。花錢(qián)去設(shè)計(jì)HBM,還不如在芯片的計(jì)算性能上多下功夫。然而到了L4或L5的自動(dòng)駕駛中,又是另外一幅光景了。低延遲和準(zhǔn)確的數(shù)據(jù)處理對(duì)于激光雷達(dá)、攝像頭等傳感器來(lái)說(shuō),可謂至關(guān)重要,這兩大自動(dòng)駕駛等級(jí)下的帶寬至少也要1TB/s。

據(jù)研究機(jī)構(gòu)的預(yù)測(cè),到了2030年,L4以上的自動(dòng)駕駛系統(tǒng)將占據(jù)20%的市場(chǎng),到了2035年,這一比例將上升至45%。為了不在突破L3時(shí)遇到帶寬的瓶頸,引入HBM可以說(shuō)是越早越好,甚至從L3就可以開(kāi)始考慮了,畢竟現(xiàn)在不少自動(dòng)駕駛芯片已經(jīng)標(biāo)榜著L3乃至L4以上的能力。

比如L3級(jí)別的自動(dòng)駕駛,帶寬要求在600GB/s到1TB/s之間,單車(chē)可以使用兩個(gè)HBM2e或者一個(gè)HBM3;而L4到L5級(jí)別的自動(dòng)駕駛,帶寬要求在1TB/s到1.5TB之間,單車(chē)可用3個(gè)HBM2e或兩個(gè)HBM3。

結(jié)語(yǔ)

雖然HBM3標(biāo)準(zhǔn)已經(jīng)發(fā)布,芯片設(shè)計(jì)公司(英偉達(dá)、AMD、英特爾)、IP公司(新思、Cadence、Rambus)、晶圓代工廠的封裝技術(shù)(臺(tái)積電Cowos-S、三星H-Cube、英特爾EMIB)以及存儲(chǔ)廠商(三星、SK海力士)都開(kāi)始了相關(guān)的部署,但HBM3的普及仍然需要時(shí)間。

預(yù)計(jì)2023年到2024年,我們可以見(jiàn)到第一代HBM3內(nèi)存在HPC上的普及,2025年到2026年第二代才會(huì)開(kāi)始放量,屆時(shí)我們也能看到下一代HBM4的性能前瞻。至于HBM上自動(dòng)駕駛芯片倒是不必急求,汽車(chē)產(chǎn)品的上市周期一向很長(zhǎng),從HBM3的推進(jìn)速度來(lái)看,估計(jì)L4和L5才能充分利用HBM3乃至HBM4的全部?jī)?yōu)勢(shì)。

原文標(biāo)題:HBM3首發(fā)GPU,又要進(jìn)軍自動(dòng)駕駛

文章出處:【微信公眾號(hào):電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

審核編輯:湯梓紅

-

gpu

+關(guān)注

關(guān)注

28文章

4743瀏覽量

128989 -

自動(dòng)駕駛

+關(guān)注

關(guān)注

784文章

13838瀏覽量

166525 -

HBM

+關(guān)注

關(guān)注

0文章

380瀏覽量

14772 -

HBM3

+關(guān)注

關(guān)注

0文章

74瀏覽量

156

原文標(biāo)題:HBM3首發(fā)GPU,又要進(jìn)軍自動(dòng)駕駛

文章出處:【微信號(hào):elecfans,微信公眾號(hào):電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

HBM格局生變!傳三星HBM3量產(chǎn)供貨英偉達(dá),國(guó)內(nèi)廠商積極布局

特斯拉欲將HBM4用于自動(dòng)駕駛,內(nèi)存大廠加速HBM4進(jìn)程

重塑線控底盤(pán)技術(shù):自動(dòng)駕駛的未來(lái)支柱

自動(dòng)駕駛演變下,汽車(chē)連接器市場(chǎng)如何擴(kuò)容?

自動(dòng)駕駛汽車(chē)安全嗎?

自動(dòng)駕駛的未來(lái)之路:智能網(wǎng)聯(lián)與單車(chē)智能的交融

HBM上車(chē)?HBM2E被用于自動(dòng)駕駛汽車(chē)

FPGA在自動(dòng)駕駛領(lǐng)域有哪些優(yōu)勢(shì)?

FPGA在自動(dòng)駕駛領(lǐng)域有哪些應(yīng)用?

中國(guó)AI芯片和HBM市場(chǎng)的未來(lái)

特斯拉在華推進(jìn)全自動(dòng)駕駛

全球L3自動(dòng)駕駛汽車(chē)銷(xiāo)量將破25000輛,中國(guó)市場(chǎng)潛力巨大

未來(lái)已來(lái),多傳感器融合感知是自動(dòng)駕駛破局的關(guān)鍵

HBM3E起飛,沖鋒戰(zhàn)鼓已然擂響

HBM、HBM2、HBM3和HBM3e技術(shù)對(duì)比

HBM3發(fā)力自動(dòng)駕駛市場(chǎng),其性能未來(lái)可期

HBM3發(fā)力自動(dòng)駕駛市場(chǎng),其性能未來(lái)可期

評(píng)論