寫在前面

能獲得企業(yè)大獎(jiǎng)其實(shí)是出乎預(yù)料的,論復(fù)雜程度我自己認(rèn)為可能也無(wú)法比的上其他學(xué)校的朋友們的(不過(guò)是因?yàn)榻衲隂](méi)有線下交流,著實(shí)無(wú)法看到大家的作品),但我覺(jué)得組委會(huì)能選擇我們組作為企業(yè)大獎(jiǎng),可能也是想通過(guò)我們來(lái)拓寬大家的思路,而并不一定是我們的作品做的是多么完美。

學(xué)習(xí)了近幾年ARM杯的作品,感覺(jué)大家都是在同一個(gè)領(lǐng)域做文章(當(dāng)然去年那組BLDC的hxd例外),那就是視覺(jué)和圖像處理方面。這方面感覺(jué)大家做的都非常好了,無(wú)論是用現(xiàn)成的算法拆分成verilog中的矩陣運(yùn)算,還是利用HLS這類高層次綜合工具,我覺(jué)得如果繼續(xù)做視覺(jué)方面的內(nèi)容我們可能再怎么努力也無(wú)法達(dá)到他人積累多年經(jīng)驗(yàn)的程度,所以我們選擇換一個(gè)角度。

人類有五種感官,嗅覺(jué)和味覺(jué)目前來(lái)說(shuō)無(wú)法做到輔助(笑,還剩下聽(tīng)覺(jué)、視覺(jué)和觸覺(jué),視覺(jué)被我們直接否定了,那么觸覺(jué)呢?目前高精度的傳感器也不是我們能企及做到的了,這和生物醫(yī)學(xué)電子有關(guān),那么我們的眼前就只有一個(gè)選擇了:聽(tīng)覺(jué)。

這也正是我們選擇做這個(gè)系統(tǒng)的原因之一,還有一個(gè)原因是我們能感覺(jué)得到現(xiàn)在的消費(fèi)電子都逐漸在向聲學(xué)方面走,例如蘋果的HomePod,華為的Sound X,還有小米最近剛推出的小米Sound,這些都是非常高端的走計(jì)算聲學(xué)方向的家居產(chǎn)品,它們的受眾非常廣,而且在這兩年疫情的影響下,更多的人會(huì)選擇在線會(huì)議,那么一個(gè)優(yōu)秀的聲學(xué)處理裝置就顯得更為重要了。

1.設(shè)計(jì)簡(jiǎn)介

1.1 總體介紹

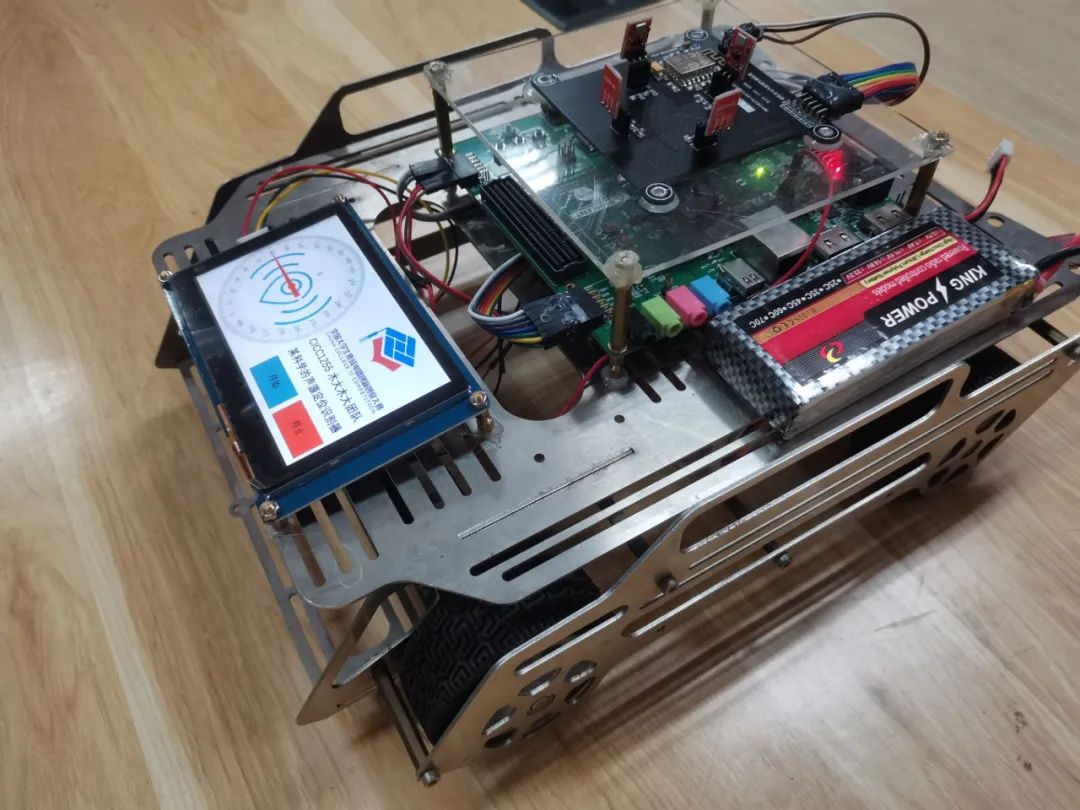

本作品是基于Coretex-M3 Design Start的語(yǔ)音識(shí)別和聲源定位識(shí)別系統(tǒng),包括Digilent NexysVideo開(kāi)發(fā)板、自制麥克風(fēng)矩陣模塊、ESP8266無(wú)線互聯(lián)模塊、LCD屏幕、載體小車以及安卓端APP組成。

本系統(tǒng)在Xilinx Artix-7中搭建ARM Cortex-M3軟核作為中央處理器,使用自制的MEMS硅片麥克風(fēng)陣列作為聲音信號(hào)采集器,利用Artix-7中自帶的XADC將麥克風(fēng)輸出的模擬量信號(hào)轉(zhuǎn)換為數(shù)字信號(hào)并通過(guò)AXI4-FULL傳輸給DDR3控制器,DDR3控制器根據(jù)用戶的控制選擇輸入和輸出,當(dāng)開(kāi)始語(yǔ)音識(shí)別后,將開(kāi)啟后1s內(nèi)的數(shù)據(jù)從DDR3中直接利用Burst讀入語(yǔ)音識(shí)別模塊,該模塊利用HLS綜合,包括語(yǔ)音的MFCC特征提取、BP神經(jīng)網(wǎng)絡(luò)的執(zhí)行等過(guò)程,將最終得出的語(yǔ)音識(shí)別結(jié)果保存在寄存器中并能使CPU通過(guò)AXI4-Lite讀取;當(dāng)開(kāi)啟聲源定位后,數(shù)據(jù)利用AXI4-Stream直接搬移到算法電路模塊,對(duì)四路麥克風(fēng)同時(shí)進(jìn)行流水線處理,經(jīng)過(guò)信號(hào)的處理和變換后得到聲源方位數(shù)據(jù)通過(guò)UART串口輸出到ESP8266,ESP8266利用局域網(wǎng)將數(shù)據(jù)傳至安卓APP。

有一點(diǎn)我們的體會(huì)可以分享給其他朋友們,如果我們?cè)谝欢螘r(shí)間內(nèi)只需要處理一段定長(zhǎng)的數(shù)據(jù),那么我們可以不利用DMA,而是僅僅利用AXI的Burst傳輸即可,例如采集1s的信號(hào)寸到DDR中一段連續(xù)區(qū)域以后,將這些的音頻信號(hào)數(shù)據(jù)整個(gè)Burst到加速器中,這樣可以充分發(fā)揮總線橋的作用,并節(jié)省一個(gè)DMA的資源,還可以減小數(shù)據(jù)搬移過(guò)來(lái)過(guò)去的時(shí)延。

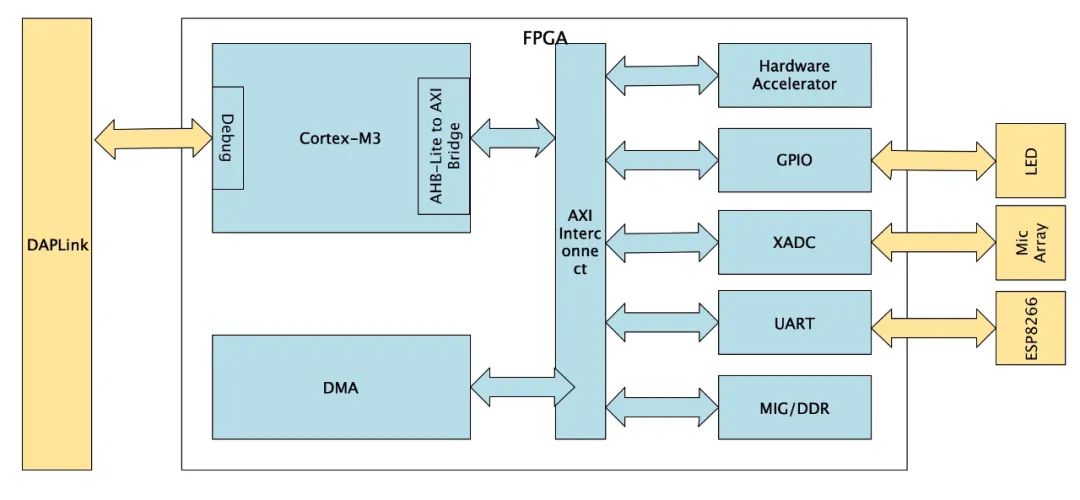

1.2 硬件架構(gòu)

在本系統(tǒng)中,由于最終制作的語(yǔ)音識(shí)別加速器和聲源定位加速器都使用AXI系列總線配置寄存器和讀寫數(shù)據(jù),同時(shí)DDR3由AXI總線接口的MIG管理,因此為了方便實(shí)用和同一總線,使整個(gè)架構(gòu)簡(jiǎn)潔,我們將除了ITCM和DTCM外的所有外設(shè)連接在由AHB轉(zhuǎn)換之后的AXI總線橋上。

1.3 語(yǔ)音識(shí)別加速器

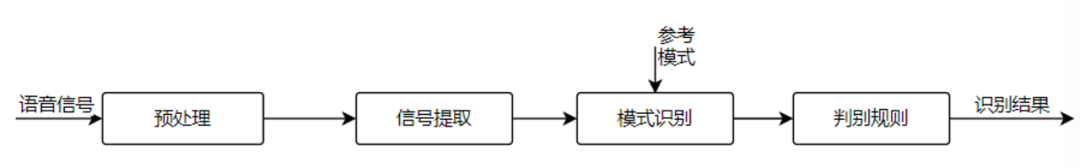

語(yǔ)音識(shí)別采用的方案是利用MFCC提取特征,之后利用BP神經(jīng)網(wǎng)絡(luò)擬合特征系數(shù)對(duì)應(yīng)的神經(jīng)網(wǎng)絡(luò)隱含層參數(shù)。首先輸入的語(yǔ)音數(shù)據(jù)從DDR經(jīng)過(guò)Burst傳輸?shù)叫盘?hào)處理模塊中,經(jīng)過(guò)預(yù)處理(去工頻噪聲、音量均衡)后提取MFCC,再利用BP網(wǎng)絡(luò)將MFCC系數(shù)與訓(xùn)練過(guò)的語(yǔ)句一一對(duì)應(yīng)輸出對(duì)應(yīng)的結(jié)果。語(yǔ)音識(shí)別的網(wǎng)絡(luò)的權(quán)重參數(shù)采用的是MATLAB離線訓(xùn)練的方法,然后把訓(xùn)練的權(quán)重?cái)?shù)據(jù)保存在coe文件中,利用HLS綜合出IP。

流程圖如下:

1.4 聲源定位加速器

聲源定位加速器融合了TDOA(Time Difference of Arrival 到達(dá)時(shí)間差)和空域波束指向性加權(quán)的方法。

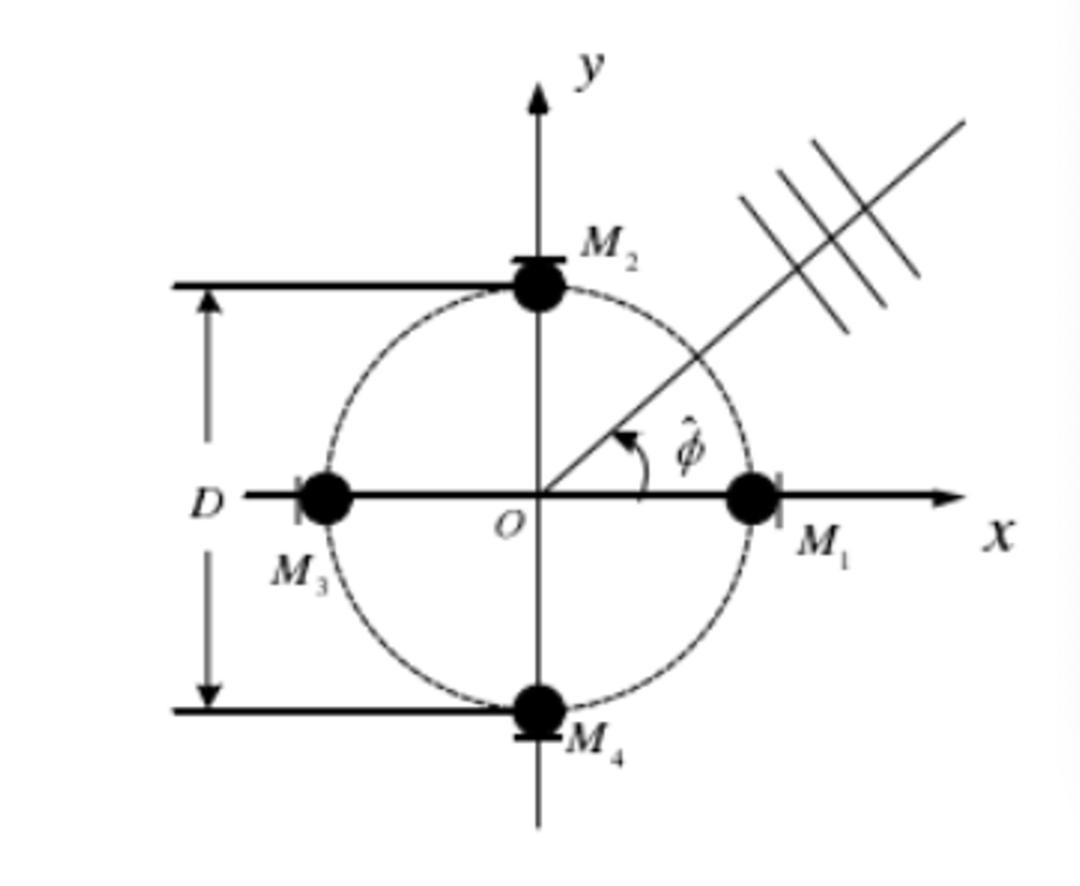

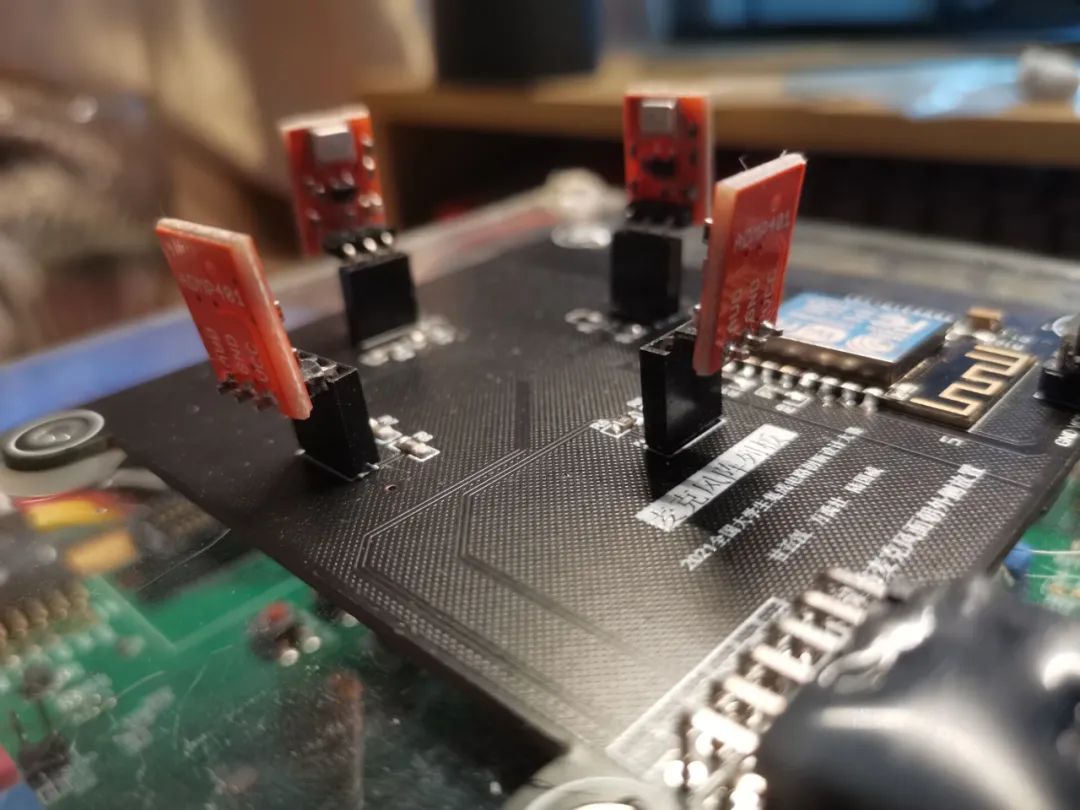

由四個(gè)全向性麥克風(fēng)M1, M2, M3, M4組成的差分麥克風(fēng)列,如圖2.10所示。四麥克風(fēng)等間隔的分布在直徑為D的圓周上。

差分麥克風(fēng)陣列的輸出信號(hào)包括原點(diǎn)處的聲壓信號(hào)和原點(diǎn)處振速的兩個(gè)正交分量,可以得到聲源在原點(diǎn)處的聲強(qiáng),進(jìn)而由聲強(qiáng)的方向得到目標(biāo)方位的估計(jì)值。需要指出的是,基于聲強(qiáng)估計(jì)的聲源定位方法通常只適用于單聲源的情況。同時(shí),對(duì)于全向麥克風(fēng)而言(不同于“心”形指向麥克風(fēng)),并沒(méi)有對(duì)特定角度的聲源信號(hào)進(jìn)行增強(qiáng)或削弱,這就使得在進(jìn)行聲源定位時(shí)往往受到其他方向的干擾。采用空域波束指向性加權(quán)的方法,可以只增強(qiáng)期望方向上的信號(hào),削弱其他方向上的干擾信號(hào),提高信干比,使得輸出結(jié)果中特定方向上的信息能量增大。

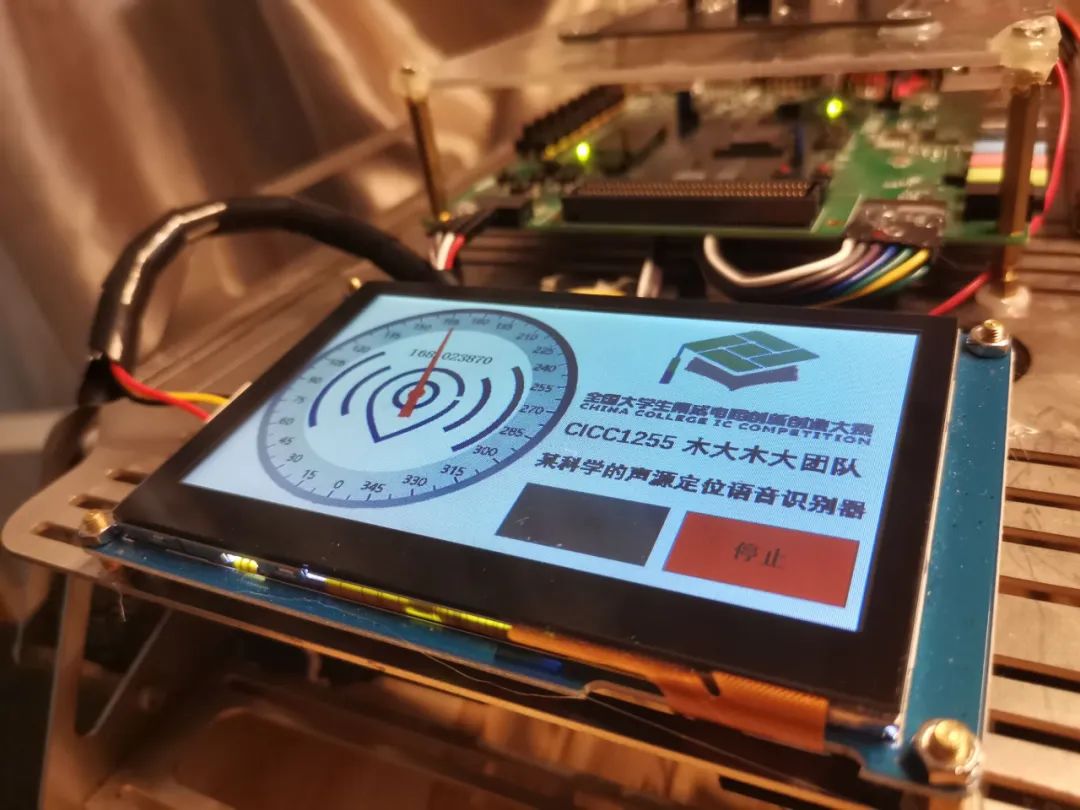

2.作品外觀和使用體驗(yàn)

作品成品外觀如下:

審核編輯 :李倩

-

語(yǔ)音識(shí)別

+關(guān)注

關(guān)注

38文章

1742瀏覽量

112697 -

識(shí)別系統(tǒng)

+關(guān)注

關(guān)注

1文章

138瀏覽量

18816 -

CORETEX

+關(guān)注

關(guān)注

0文章

2瀏覽量

6317

原文標(biāo)題:【2021集創(chuàng)賽作品分享】第三期 | Cortex-M3語(yǔ)音識(shí)別聲源定位系統(tǒng)

文章出處:【微信號(hào):Ithingedu,微信公眾號(hào):安芯教育科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

幾款性價(jià)比很不錯(cuò)的門禁人臉識(shí)別系統(tǒng)及其常見(jiàn)應(yīng)用

基于語(yǔ)音識(shí)別的智能會(huì)議系統(tǒng)具備哪些交互功能

RFID識(shí)別系統(tǒng)

物聯(lián)網(wǎng)系統(tǒng)智能控制產(chǎn)品的語(yǔ)音識(shí)別方案_離線語(yǔ)音識(shí)別芯片分析

智能玩具用離線語(yǔ)音識(shí)別芯片有什么優(yōu)勢(shì)

基于FPGA的指紋識(shí)別系統(tǒng)設(shè)計(jì)

多目標(biāo)智能識(shí)別系統(tǒng)

基于OpenCV的人臉識(shí)別系統(tǒng)設(shè)計(jì)

語(yǔ)音識(shí)別和自然語(yǔ)言處理的區(qū)別和聯(lián)系

整合離線語(yǔ)音識(shí)別ASR和TTS,內(nèi)存映射時(shí)發(fā)生內(nèi)存不足怎么解決?

基于GIS的SAR多目標(biāo)智能識(shí)別系統(tǒng)

車載語(yǔ)音識(shí)別系統(tǒng)語(yǔ)音數(shù)據(jù)采集標(biāo)注案例

基于Coretex-M3 Design Start的語(yǔ)音識(shí)別和聲源定位識(shí)別系統(tǒng)

基于Coretex-M3 Design Start的語(yǔ)音識(shí)別和聲源定位識(shí)別系統(tǒng)

評(píng)論