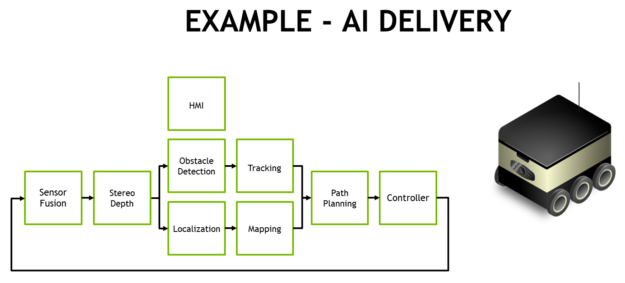

面向 AI 開發人員的全球終極嵌入式解決方案JetsonAGXXavier現已作為 NVIDIA 的獨立生產模塊發貨。英偉達 AGX 系統的成員對于自主機器,Jetson AGX Xavier 非常適合將先進的 AI 和計算機視覺部署到邊緣,使現場機器人平臺具有工作站級性能,并能夠在不依賴人工干預和云連接的情況下完全自主運行。由 Jetson AGX Xavier 提供支持的智能機器可以自由地在其環境中進行交互和安全導航,不受復雜地形和動態障礙物的阻礙,完全自主地完成現實世界的任務。這包括需要高級實時感知和推理才能執行的包裹遞送和工業檢查。作為世界上第一臺專為機器人和邊緣計算設計的計算機,Jetson AGX Xavier 的高性能可以處理視覺里程計、傳感器融合、定位和映射,障礙物檢測和對下一代機器人至關重要的路徑規劃算法。圖 1 顯示了現在全球可用的生產計算模塊。開發人員現在可以開始批量部署新的自主機器。

最新一代 NVIDIA 業界領先的Jetson AGX系列嵌入式 Linux 高性能計算機,Jetson AGX Xavier 提供 GPU 工作站級性能,具有無與倫比的 32 TeraOPS (TOPS) 峰值計算和 750Gbps 的高速 I/O,體積小巧100x87mm 外形尺寸。用戶可以根據應用需要配置 10W、15W 和 30W 的工作模式。Jetson AGX Xavier 為可部署到邊緣的計算密度、能源效率和 AI 推理功能樹立了新的標桿,使具有端到端自主能力的下一級智能機器成為可能。

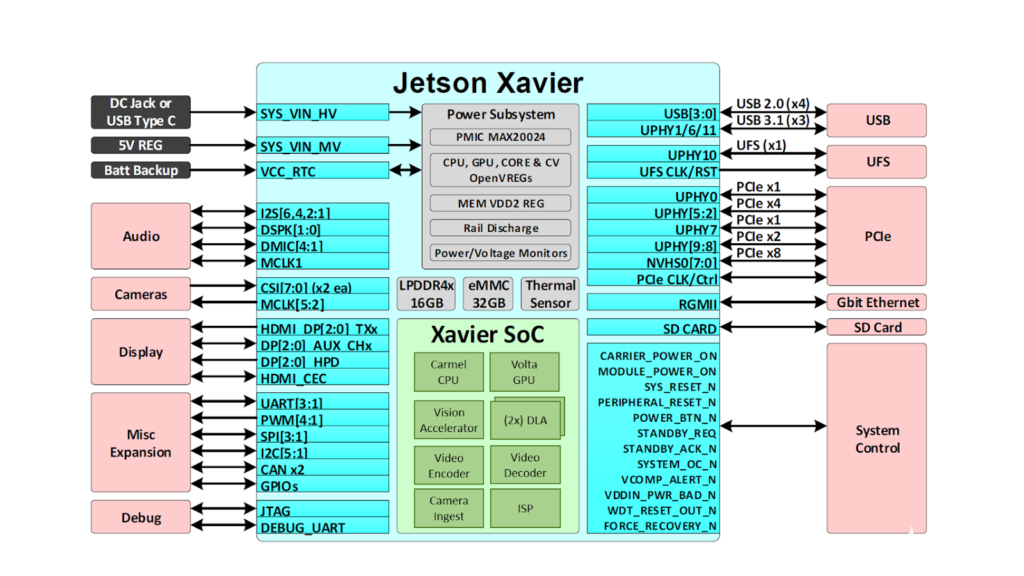

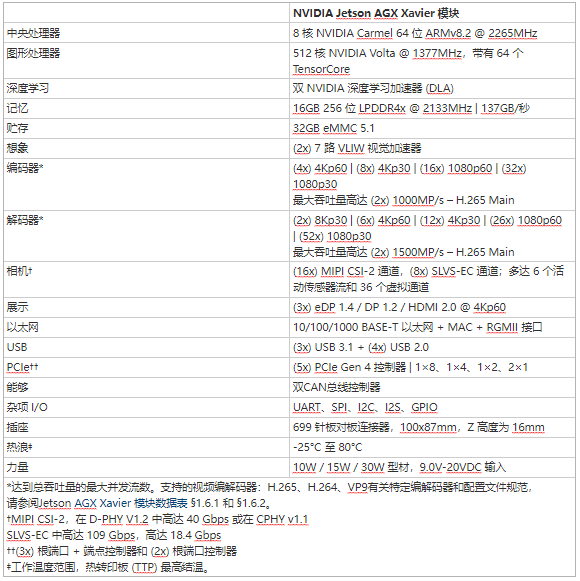

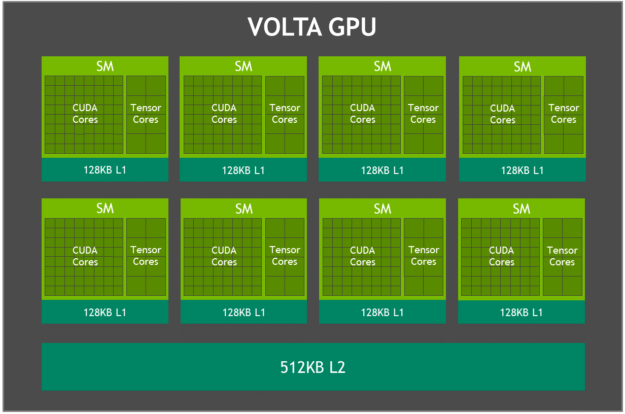

Jetson 使用深度學習和計算機視覺為世界上許多最先進的機器人和自主機器背后的 AI 提供動力,同時專注于性能、效率和可編程性。Jetson AGX Xavier,如圖 2 所示,由超過 90 億個晶體管組成,基于有史以來最復雜的片上系統 (SoC)。該平臺包含一個集成的 512 核 NVIDIA Volta GPU,包括 64 個張量核心、8 核 NVIDIA Carmel ARMv8.2 64 位 CPU、16GB 256 位 LPDDR4x、雙 NVIDIA深度學習加速器(DLA) 引擎、NVIDIA Vision Accelerator 引擎、高清視頻編解碼器、128Gbps 的專用攝像頭攝取和 16 通道 PCIe Gen 4 擴展。256 位接口上的內存帶寬為 137GB/s,而 DLA 引擎卸載了深度神經網絡 (DNN) 的推理。NVIDIA 用于 Jetson AGX Xavier 的 JetPack SDK 4.1.1 包括 CUDA 10.0、cuDNN 7.3 和 TensorRT 5.0,提供完整的 AI 軟件堆棧。

圖 2. Jetson AGX Xavier 提供一組豐富的高速 I/O

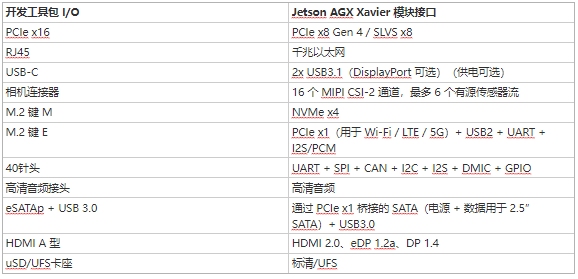

這使開發人員能夠在機器人、智能視頻分析、醫療儀器、嵌入式物聯網邊緣設備等應用中部署加速 AI。與其前身 Jetson TX1 和 TX2 一樣,Jetson AGX Xavier 使用系統級模塊 (SoM) 范例。所有處理都包含在計算模塊上,高速 I/O 位于通過高密度板對板連接器提供的分線載體或外殼上。以這種方式在模塊上封裝功能使開發人員可以輕松地將 Jetson Xavier 集成到他們自己的設計中。NVIDIA 發布了全面的文檔和參考設計文件,可供嵌入式設計人員下載,以使用 Jetson AGX Xavier 創建自己的設備和平臺。請務必咨詢JetsonAGXXavier 模塊數據表和JetsonAGXXavier OEM 產品設計指南,了解表 1 中列出的全部產品功能,以及機電規格、模塊引腳排列、電源排序和信號路由指南。

Jetson AGX Xavier 包括超過 750Gbps 的高速 I/O,為流式傳感器和高速外圍設備提供了非凡的帶寬。它是首批支持 PCIe Gen 4 的嵌入式設備之一,在五個 PCIe Gen 4 控制器上提供 16 個通道,其中三個可以在根端口或端點模式下運行。16 個 MIPI CSI-2 通道可連接到四個 4 通道攝像頭、六個 2 通道攝像頭、六個 1 通道攝像頭或這些配置的組合,最多六個攝像頭,36 個虛擬通道允許同時連接更多攝像頭使用流聚合。其他高速 I/O 包括三個 USB 3.1 端口、SLVS-EC、UFS 和用于千兆以太網的 RGMII。開發者現在可以訪問 NVIDIA 的JetPack 4.1.1 開發者預覽版Jetson AGX Xavier 的軟件,列于表 2。開發者預覽版包括 Linux For Tegra (L4T) R31.1 板級支持包 (BSP),支持 Linux 內核 4.9 和目標上的 Ubuntu 18.04。在主機 PC 端,JetPack 4.1.1 支持 Ubuntu 16.04 和 Ubuntu 18.04。

JetPack 4.1.1 開發人員預覽版允許開發人員立即開始使用 Jetson AGX Xavier 對產品和應用程序進行原型設計,為生產部署做準備。NVIDIA 將繼續通過額外的功能增強和性能優化來改進 JetPack。請閱讀發行說明以了解此版本的亮點和軟件狀態。

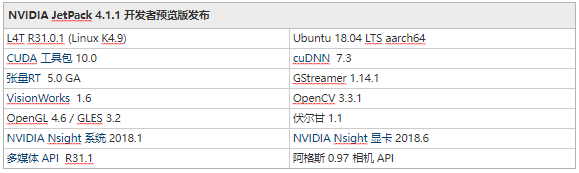

伏特顯卡

Jetson AGX Xavier 集成 Volta GPU,如圖 3 所示,提供 512 個 CUDA 內核和 64 個 Tensor 內核,可實現高達 11 TFLOPS FP16 或 22 TOPS 的 INT8 計算,最大時鐘頻率為 1.37GHz。它支持計算能力為 sm_72 的 CUDA 10。GPU 包括 8 個 Volta 流式多處理器 (SM),每個 Volta SM 有 64 個 CUDA 核心和 8 個張量核心。每個 Volta SM 都包含一個 128KB L1 緩存,比前幾代產品大 8 倍。SM 共享一個 512KB L2 緩存,提供比前幾代快 4 倍的訪問速度。

圖 3. Jetson AGX Xavier Volta GPU 框圖

每個 SM 由 4 個獨立的處理塊組成,稱為 SMP(流式多處理器分區),每個處理塊都包括自己的 L0 指令緩存、warp 調度程序、調度單元和寄存器文件,以及 CUDA 核心和張量核心。每個 SM 的 SMP 數量是 Pascal 的兩倍,Volta SM 具有改進的并發性,并支持更多的線程、warp 和運行中的線程塊。

張量核心

NVIDIA 張量核心是可編程的融合矩陣乘法和累加單元,可與 CUDA 核心同時執行。張量核心實現了新的浮點 HMMA(半精度矩陣乘法和累加)和 IMMA(整數矩陣乘法和累加)指令,用于加速密集線性代數計算、信號處理和深度學習推理。

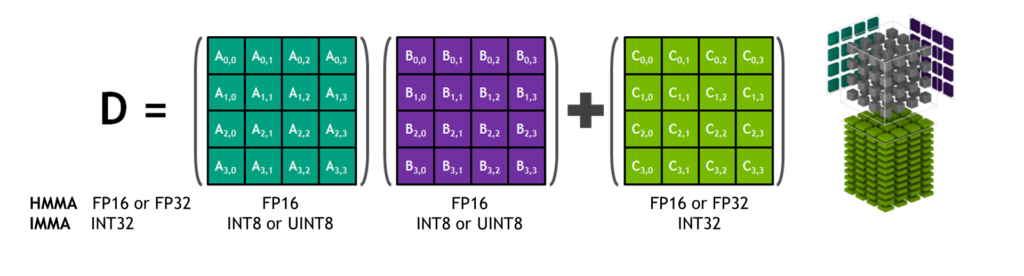

圖 4. Tensor Core HMMA/IMMA 4x4x4 矩陣乘法和累加

矩陣乘法輸入A和B是 HMMA 指令的 FP16 矩陣,而累加矩陣C和D可以是 FP16 或 FP32 矩陣。對于 IMMA,矩陣乘法輸入A是有符號或無符號 INT8 或 INT16 矩陣,B是有符號或無符號 INT8 矩陣,C和D累加器矩陣都是有符號 INT32。因此,精度和計算范圍足以避免內部累加期間的上溢和下溢情況。

包括 cuBLAS、cuDNN 和 TensorRT 在內的 NVIDIA 庫已更新為在內部使用 HMMA 和 IMMA,使程序員能夠輕松利用 Tensor Core 固有的性能提升。用戶還可以通過 CUDA 10 中包含的 wmma 命名空間和 mma.h 標頭中公開的新 API 直接在 warp 級別訪問 Tensor Core 操作。warp 級接口映射 16×16、32×8 和 8×32 大小每個扭曲的所有 32 個線程的矩陣。

深度學習加速器

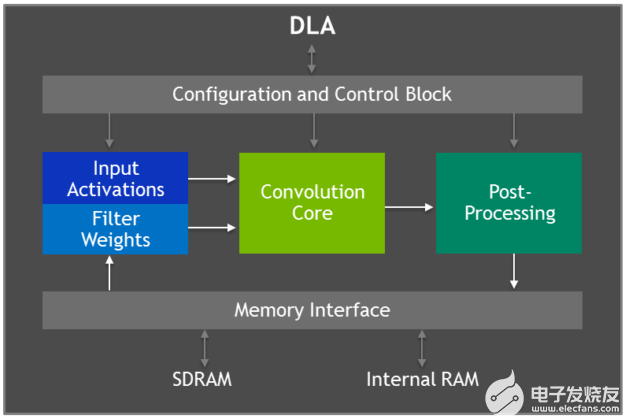

Jetson AGX Xavier 具有兩個 NVIDIA深度學習加速器(DLA) 引擎,如圖 5 所示,可卸載固定功能卷積神經網絡 (CNN) 的推理。這些引擎提高了能源效率并釋放了 GPU 來運行用戶實現的更復雜的網絡和動態任務。NVIDIA DLA 硬件架構是開源的,可從NVDLA.org 獲得。每個 DLA 具有高達 5 TOPS INT8 或 2.5 TFLOPS FP16 的性能,功耗僅為 0.5-1.5W。DLA 支持加速 CNN 層,例如卷積、反卷積、激活函數、最小/最大/均值池、局部響應歸一化和全連接層。

圖 5. 深度學習加速器 (DLA) 架構框圖

DLA 硬件由以下組件組成:

Convolution Core – 優化的高性能卷積引擎。

單數據處理器——用于激活功能的單點查找引擎。

平面數據處理器——用于池化的平面平均引擎。

通道數據處理器——用于高級標準化功能的多通道平均引擎。

專用內存和數據重塑引擎——用于張量重塑和復制操作的內存到內存轉換加速。

開發人員使用 TensorRT 5.0 對 DLA 引擎進行編程,以在網絡上執行推理,包括對 AlexNet、GoogleNet 和 ResNet-50 的支持。對于使用 DLA 不支持的層配置的網絡,TensorRT 為無法在 DLA 上運行的層提供 GPU 回退。JetPack 4.0 開發者預覽版最初將 DLA 精度限制為 FP16 模式,未來 JetPack 版本中將提供 INT8 精度和更高的 DLA 性能。

TensorRT 5.0 將以下 API 添加到其 IBuilder 接口以啟用 DLA:

setDeviceType()以及setDefaultDeviceType()默認選擇 GPU、DLA_0 或 DLA_1 來執行特定層或網絡中的所有層。

canRunOnDLA()檢查層是否可以按照配置在 DLA 上運行。

getMaxDLABatchSize()用于檢索 DLA 可以支持的最大批量大小。

allowGPUFallback()使 GPU 能夠執行 DLA 不支持的層。

請參閱TensorRT 5.0 開發人員指南的第 6 章,了解支持的層配置的完整列表以及在 TensorRT 中使用 DLA 的代碼示例。

深度學習推理基準

我們已經發布了 Jetson AGX Xavier 在常見 DNN(例如 ResNet、GoogleNet 和 VGG 的變體)上的深度學習推理基準測試結果。我們在 Jetson AGX Xavier 的 GPU 和 DLA 引擎上使用帶有 TensorRT 5.0 的 JetPack 4.1.1 開發者預覽版為 Jetson AGX Xavier 運行這些基準測試。GPU 和兩個 DLA 分別以 INT8 和 FP16 精度同時運行相同的網絡架構,并報告每種配置的總體性能。GPU 和 DLA 可以在實際用例中同時運行不同的網絡或網絡模型,并行或在處理管道中提供獨特的功能。在 TensorRT 中使用 INT8 與完整的 FP32 精度會導致精度損失 1% 或更少。

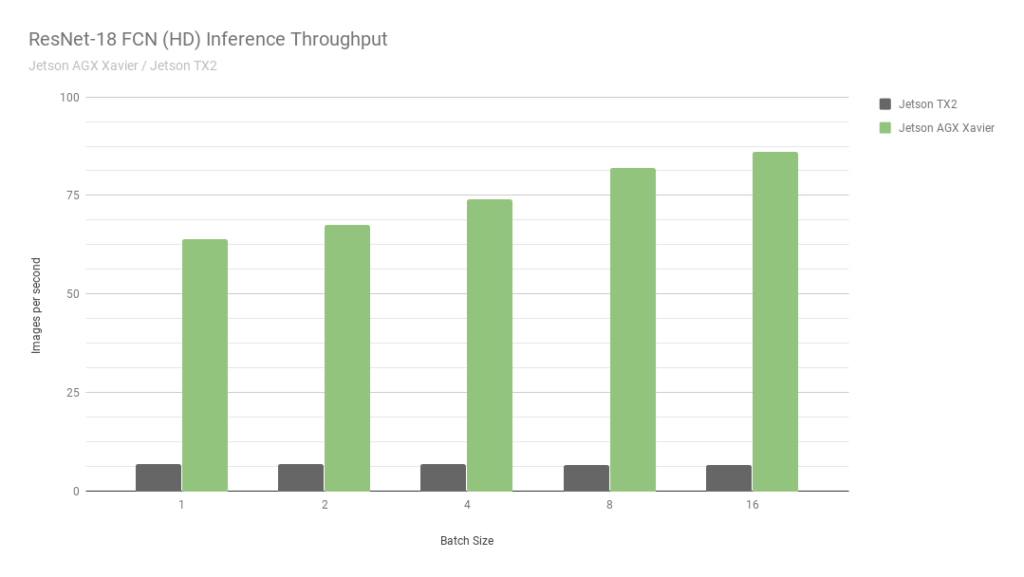

首先,讓我們考慮 ResNet-18 FCN (Fully Convolutional Network) 的結果,這是一個用于語義分割的 2048×1024 分辨率的全高清模型。分割為自由空間檢測和占用映射等任務提供每像素分類,并代表由自主機器計算的用于感知、路徑規劃和導航的深度學習工作負載。圖 6 顯示了在 Jetson AGX Xavier 與 Jetson TX2 上運行 ResNet-18 FCN 的測量吞吐量。

圖 6. Jetson AGX Xavier 和 Jetson TX2 的 ResNet-18 FCN 推理吞吐量

與 Jetson TX2 相比,Jetson AGX Xavier 目前在 ResNet-18 FCN 推理中的性能高達 13 倍。NVIDIA 將繼續在 JetPack 中發布軟件優化和功能增強,隨著時間的推移將進一步提高性能和功率特性。請注意,基準結果的完整列表報告了 Jetson AGX Xavier 的 ResNet-18 FCN 的性能,批次大小為 32,但是在圖 7 中,我們僅繪制了 16 的批次大小,因為 Jetson TX2 能夠運行 ResNet -18 FCN,最大批量為 16。

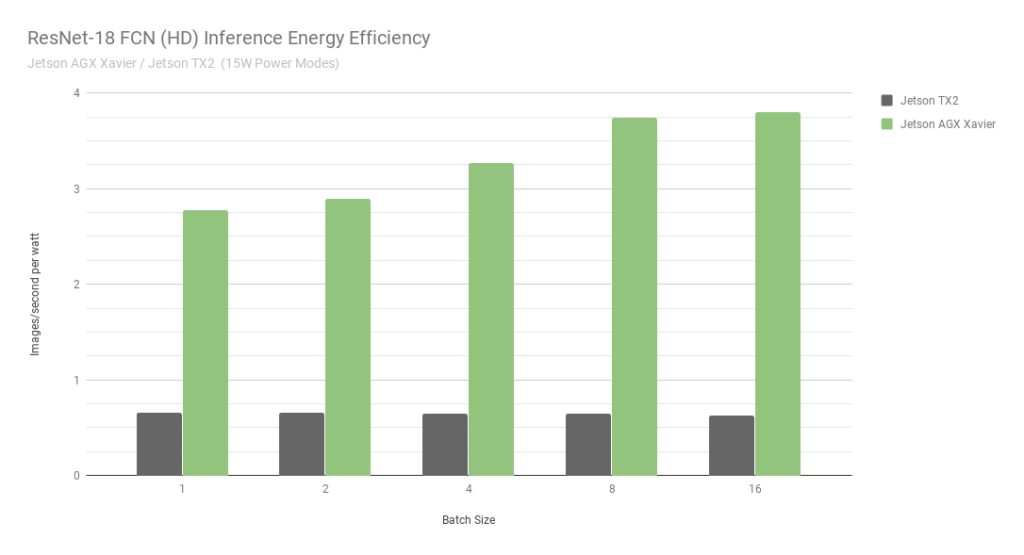

圖 7. ResNet-18 FCN 推理 Jetson AGX Xavier 和 Jetson TX2 的能效

在考慮使用每秒每瓦特處理圖像的能效時,Jetson AGX Xavier 目前在 ResNet-18 FCN 上的能效比 Jetson TX2 高 6 倍。我們通過使用板載 INA 電壓和電流監視器測量總模塊功耗來計算效率,包括 CPU、GPU、DLA、內存、其他 SoC 電源、I/O 和所有軌上的穩壓器效率損失。兩臺 Jetson 均在 15W 功率模式下運行。Jetson AGX Xavier 和 JetPack 附帶 10W、15W 和 30W 的可配置預設功率配置文件,可在運行時使用 nvpmodel 電源管理工具進行切換。用戶還可以使用不同的時鐘和 DVFS(動態電壓和頻率縮放)調節器設置來定義自己的自定義配置文件,這些配置文件已經過定制,以實現單個應用程序的最佳性能。

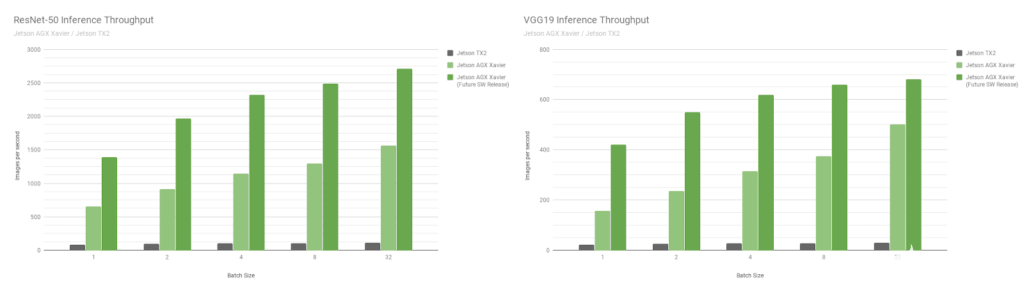

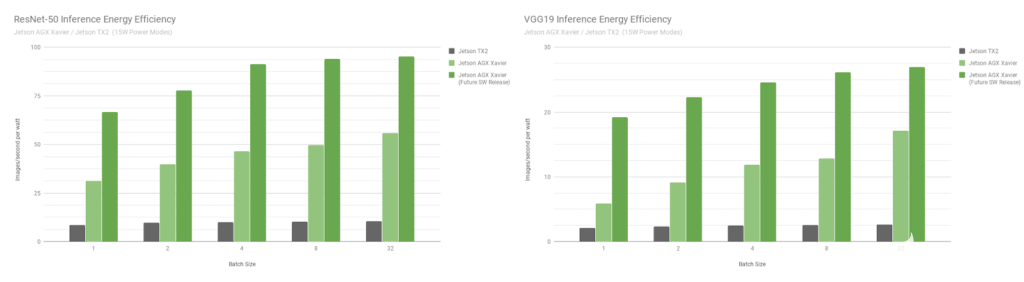

接下來,讓我們比較 Jetson AGX Xavier 基準在圖像識別網絡 ResNet-50 和 VGG19 上的批量大小 1 到 128 與 Jetson TX2。這些模型對分辨率為 224×224 的圖像塊進行分類,并經常用作各種對象檢測網絡中的編碼器主干。在較低分辨率下使用 8 或更高的批大小可用于近似在更高分辨率下批大小為 1 的性能和延遲。機器人平臺和自主機器通常包含多個相機和傳感器,這些相機和傳感器可以進行批處理以提高性能,此外還可以執行感興趣區域 (ROI) 的檢測,然后分批對 ROI 進行進一步分類。圖 8 還包括對 Jetson AGX Xavier 未來性能的估計,

圖 8. INT8 支持 DLA 和其他 GPU 優化后的估計性能

Jetson AGX Xavier 目前在 VGG19 上的吞吐量是 Jetson TX2 的 18 倍,在 ResNet-50 上的吞吐量是在 JetPack 4.1.1 上測量的 14 倍,如圖 9 所示。ResNet-50 的延遲低至 1.5 毫秒或更高650FPS,批量大小為 1。隨著未來的軟件改進,Jetson AGX Xavier 估計比 Jetson TX2 快 24 倍。請注意,對于舊版比較,我們還在完整的性能列表中提供了 GoogleNet 和 AlexNet 的數據。

圖 9. Jetson Xavier 和 Jetson TX2 的 ResNet-50 和 VGG19 能效

Jetson AGX Xavier 目前在 VGG19 推理方面的效率是 Jetson TX2 的 7 倍以上,在 ResNet-50 方面的效率提高了 5 倍,在考慮未來的軟件優化和增強時效率提高了 10 倍。有關推理基準的更多數據和詳細信息,請參閱完整的性能結果。我們還將在下一節中對 CPU 性能進行基準測試。

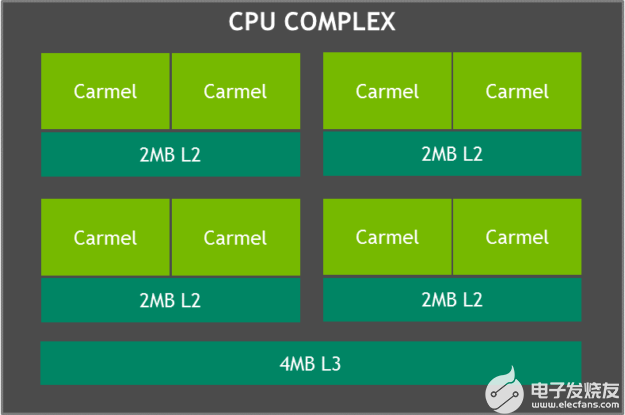

卡梅爾 CPU 復合體

Jetson AGX Xavier 的 CPU 復合體如圖 10 所示,由四個基于 ARMv8.2 的異構雙核 NVIDIA Carmel CPU 集群組成,最大時鐘頻率為 2.26GHz。每個內核包括 128KB 指令和 64KB 數據 L1 緩存以及兩個內核之間共享的 2MB L2 緩存。CPU 集群共享一個 4MB L3 緩存。

圖 10. 帶有 NVIDIA Carmel 集群的 Jetson Xavier CPU 復合體的框圖

Carmel CPU 內核具有 NVIDIA 的動態代碼優化、10 路超標量架構以及 ARMv8.2 的完整實現,包括完整的高級 SIMD、VFP(矢量浮點)和 ARMv8.2-FP16。

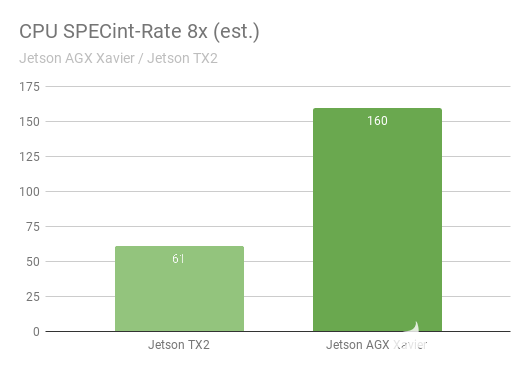

SPECint_rate 基準測量多核系統的 CPU 吞吐量。總體性能得分平均了幾個密集的子測試,包括壓縮、向量和圖形操作、代碼編譯以及為國際象棋和圍棋等游戲執行 AI。圖 11 顯示了幾代 CPU 性能提升超過 2.5 倍的基準測試結果。

圖 11. SPECInt2K_rate 8x* 基準測試中 Jetson AGX Xavier 與 Jetson TX2 的 CPU 性能 *Jetson AGX Xavier / Jetson TX2 SPECint 基準測試尚未正式提交給 SPEC,在發布時被視為估計值。

同時運行了 8 個 SPECint_rate 測試副本,保持 CPU 滿載。Jetson AGX Xavier 自然擁有八個 CPU 核心;Jetson TX2 的架構使用四個 Arm Cortex-A57 內核和兩個 NVIDIA Denver D15 內核。每個 Denver 核心運行兩個副本會產生更高的性能。

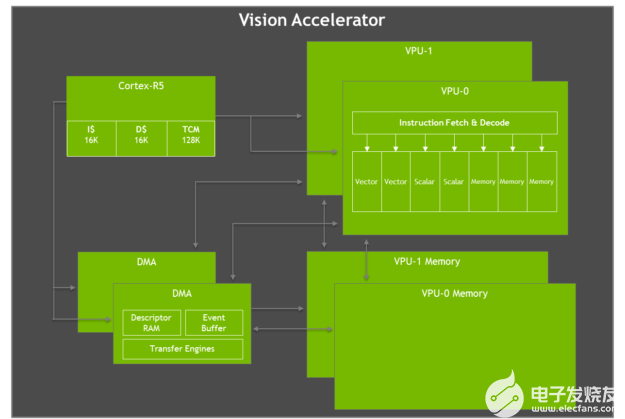

視覺加速器

Jetson AGX Xavier 具有兩個視覺加速器引擎,如圖 12 所示。每個引擎都包括一個雙 7 路 VLIW(超長指令字)矢量處理器,用于卸載計算機視覺算法,例如特征檢測和匹配、光流、立體視差塊匹配、以及低延遲和低功耗的點云處理。卷積、形態算子、直方圖、色彩空間轉換和扭曲等成像過濾器也是加速的理想選擇。

圖 12. Jetson AGX Xavier VLIW 視覺加速器架構框圖

每個視覺加速器包括一個用于命令和控制的 Cortex-R5 內核、兩個矢量處理單元(每個都有 192KB 的片上矢量存儲器)和兩個用于數據移動的 DMA 單元。7 路向量處理單元包含用于每條指令的兩個向量、兩個標量和三個內存操作的插槽。Early Access 軟件版本不支持 Vision Accelerator,但將在 JetPack 的未來版本中啟用。

NVIDIA Jetson AGX Xavier 開發者套件

JetsonAGXXavier 開發套件包含開發人員快速啟動和運行所需的一切該套件包括JetsonAGX Xavier 計算模塊、參考開源載板、電源和 JetPack SDK,使用戶能夠快速開始開發應用程序。Jetson AGX Xavier 開發者套件只需 1,299 美元即可購買。

Jetson AGX Xavier 開發工具包的尺寸為 105mm2,明顯小于 Jetson TX1 和 TX2 開發工具包,同時改進了可用的 I/O。I/O 功能包括兩個 USB3.1 端口(支持 DisplayPort 和 Power Delivery)、一個混合 eSATAp + USB3.0 端口、一個 PCIe x16 插槽(x8 電氣)、M.2 Key-M NVMe 和 M.2 Key 站點-E WLAN 夾層、千兆以太網、HDMI 2.0 和 8 攝像頭 MIPI CSI 連接器。有關通過開發工具包參考載板提供的 I/O 的完整列表,請參見下面的表 3。

我們為 Jetson AGX Xavier 整理了一個開源的為期兩天的深度學習演示教程,該教程指導開發人員通過訓練和部署 DNN 推理來執行圖像識別、對象檢測和分割,使您能夠快速開始創建自己的 AI應用程序。兩天演示使用云端的 NVIDIA DIGITS 交互式訓練系統或 GPU 加速的 PC,并使用 TensorRT 對 Jetson 上的圖像或實時攝像頭饋送執行加速推理。GitHub 上的為期兩天的演示代碼存儲庫已更新,包括對 Xavier DLA 和 GPU INT8 精度的支持。

智能視頻分析 (IVA)

人工智能和深度學習能夠有效利用大量數據,讓城市更安全、更方便,包括交通管理、智能停車和零售店的簡化結賬體驗等應用。NVIDIA Jetson 和 NVIDIADeepStream SDK使分布式智能攝像頭能夠在邊緣實時執行智能視頻分析,從而減少傳輸基礎設施上的大量帶寬負載,并提高安全性和匿名性。

在 Jetson AGX Xavier 上運行的 IVA 演示視頻捕獲,具有 30 個并發高清流

Jetson TX2 可以同時處理兩個高清流以及對象檢測和跟蹤。如上面的視頻所示,Jetson AGX Xavier 能夠以 1080p30 同時處理 30 個獨立的高清視頻流——提高了 15 倍。Jetson AGX Xavier 提供超過 1850MP/s 的總吞吐量,使其能夠解碼、預處理、使用基于 ResNet 的檢測執行推理,并在超過 1 毫秒的時間內可視化每一幀。Jetson AGX Xavier 的功能大大提高了邊緣視頻分析的性能和可擴展性。

自治的新時代

Jetson AGX Xavier 提供前所未有的機載機器人和智能機器性能水平。這些系統需要對人工智能驅動的感知、導航和操作具有苛刻的計算能力,以提供強大的自主操作。應用包括制造、工業檢測、精準農業和家庭服務。向最終消費者遞送包裹并支持倉庫、商店和工廠物流的自主遞送機器人代表了一類應用。

全自動交付和物流的典型處理流程需要多個階段的視覺和感知任務,如圖 14 所示。移動交付機器人通常具有多個外圍高清攝像頭,除了激光雷達和其他測距傳感器之外,還提供 360° 態勢感知。與慣性傳感器一起融合在軟件中。經常使用前向立體驅動攝像頭,需要預處理和立體深度映射。NVIDIA 創建了Stereo DNN模型,其準確性高于傳統的塊匹配方法來支持這一點。

圖 14. 自主配送和物流機器人的 AI 處理流程示例

SSD 或 Faster-RCNN 等對象檢測模型和基于特征的跟蹤通常會告知行人、車輛和地標的避障。對于倉庫和店面機器人,這些對象檢測模型可以定位感興趣的物品,例如產品、貨架和條形碼。面部識別、姿勢估計和自動語音識別 (ASR) 促進了人機交互 (HMI),使機器人能夠與人類進行有效協調和交流。

高幀率同步定位和映射 (SLAM) 對于保持機器人在 3D 中準確定位至關重要。GPS 本身缺乏亞米級定位的精度,并且在室內無法使用。SLAM 將最新的傳感器數據與系統在其點云中積累的先前數據進行配準和對齊。經常有噪聲的傳感器數據需要大量過濾才能正確定位,尤其是來自移動平臺的數據。

路徑規劃階段通常使用 ResNet-18 FCN、SegNet 或 DeepLab 等語義分割網絡來執行自由空間檢測,告訴機器人在哪里行駛而不被遮擋。現實世界中經常存在太多需要單獨檢測和跟蹤的通用障礙物類型,因此基于分割的方法用其分類標記每個像素或體素。與管道的前幾個階段一起,這會通知規劃者和控制回路它可以采取的安全路線。

Jetson AGX Xavier 的性能和效率使得這些機器人能夠實時處理所有需要的組件,以實現完全自主的安全運行,包括用于實時感知、導航和操作的高性能視覺算法。隨著獨立的 Jetson AGX Xavier 模塊現已投入生產,開發人員可以將這些 AI 解決方案部署到下一代自主機器。

立即開始構建下一波自主機器

Jetson AGX Xavier 為機器人和邊緣設備帶來了改變游戲規則的計算水平,為針對尺寸、重量和功率進行了優化的嵌入式平臺帶來了高端工作站性能。

關于作者

Dustin 是 NVIDIA Jetson 團隊的一名開發人員推廣員。Dustin 擁有機器人技術和嵌入式系統方面的背景,喜歡在社區中提供幫助并與 Jetson 合作開展項目。

審核編輯:郭婷

-

機器人

+關注

關注

211文章

28501瀏覽量

207473 -

NVIDIA

+關注

關注

14文章

5013瀏覽量

103246

發布評論請先 登錄

相關推薦

NVIDIA發布小巧高性價比的Jetson Orin Nano Super開發者套件

NVIDIA 推出高性價比的生成式 AI 超級計算機

u-blox深化與NVIDIA Jetson和NVIDIA DRIVE Hyperion平臺合作

使用NVIDIA AI平臺確保醫療數據安全

NVIDIA助力企業創建定制AI應用

初創公司借助NVIDIA Metropolis和Jetson提高生產線效率

使用NVIDIA Jetson打造機器人導盲犬

使用機器學習和NVIDIA Jetson邊緣AI和機器人平臺打造機器人導盲犬

GPU計算主板學習資料第735篇:基于3U VPX的AGX Xavier GPU計算主板 信號計算主板 視頻處理 相機信號

fx3系列的硬件主要由什么組成

NVIDIA JetPack 6.0版本的關鍵功能

HPE 攜手 NVIDIA 推出 NVIDIA AI Computing by HPE,加速生成式 AI 變革

Nvidia Jetson Nano + CYW55573/AWXB327MA-PUR M.2無法使用操作系統內置的網絡管理器管理Wi-Fi如何解決?

NVIDIA Jetson為嵌入式計算領域探索AI可能

NVIDIA Jetson AGX Xavier應用在AI和

NVIDIA Jetson AGX Xavier應用在AI和

評論