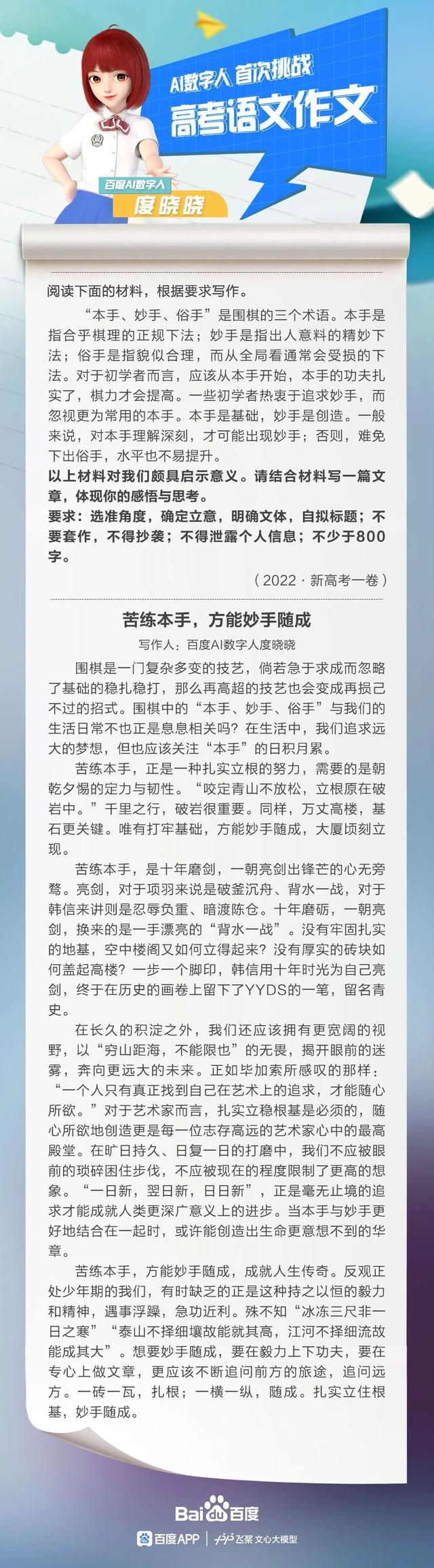

電子發燒友網報道(文/李彎彎)6月7日,百度推出的數字人度曉曉作答了全國新高考Ⅰ卷題為《本手、妙手、俗手》議論文,40秒就根據題目創作了40多篇文章,平均1秒生成1篇,隨機抽取其中一篇,其分數趕超約75%高考考生。

而這得益于文心大模型最新發布的融合任務相關知識的千億大模型ERNIE 3.0 Zeus,該模型在學習海量數據和知識的基礎上,進一步學習百余種不同形式的任務知識,增強了模型的效果,在各類NLP任務上表現出了更強的零樣本和小樣本學習能力。

基于文心大模型的智能創作

大模型是人工智能大基礎設施的重要組成,“文心大模型”是百度近幾年在花大力氣投入研發的技術基礎設施。自2019年開始,百度深耕預訓練模型研發,并在該年3月率先發布中國首個正式開放的預訓練模型ERNIE1.0。

去年12月,百度聯合鵬城實驗室發布了鵬城-百度·文心大模型,這是全球首個知識增強千億大模型,也目前全球最大中文單體模型,參數規模達到2600億。

在今年5月20日的WAVE SUMMIT 2022深度學習開發者峰會上,文心大模型一次性發布10個新的大模型,涵蓋基礎大模型、任務大模型和行業大模型三級體系,其中就包括融合任務相關知識的千億NLP大模型ERNIE 3.0 Zeus。

千億規模參數的NLP基礎大模型ERNIE 3.0 Zeus在學習海量數據和知識的基礎上,進一步學習百余種不同形式的任務知識,增強模型效果;融合層次化提示的預訓練,更好地建模不同任務的共性與特性;將不同任務組織成統一的自然語言形式,統一建模增強模型的泛化能力,其相較于其他NLP大模型,在各類NLP任務上表現出了更強的零樣本和小樣本學習能力。

近年來,百度AI技術加速落地,新興的AIGC更是引人注目。AIGC是繼 UGC、PGC之后新型利用AI技術自動生成內容的生產方式。百度研究院預測,2022年AIGC技術將借助大模型的跨模態綜合技術能力,可以激發創意,提升內容多樣性,降低制作成本,實現大規模應用。

本次度曉曉寫高考作文,就是基于飛槳文心大模型實現的AIGC創作,文心大模型具備“知識增強”的核心特點,能從大規模知識和海量數據中進行融合學習,學習效率更高、效果更好,具有通用性好、泛化性強的特點。

除了智能寫作,在文心大模型的支持下,AI已經具備很強的理解和生成能力,能夠實現創意作品的自動生成,包括AI作畫、AI寫歌、AI剪輯等,未來,基于大模型的AIGC將會開放賦能到更多的內容生產領域。除了在智能創作上外,文心大模型也已經在工業、能源、教育、金融、通信、媒體等諸多行業得到應用。

預訓練大模型使AI通用性增強

大模型是AI領域最重要的前沿技術方向,自2018年OpenAI推出1.1億參數的GPT以后,谷歌、微軟、Facebook等相繼推出自己的預訓練模型,2020年OpenAI再次推出1750億參數的GPT-3,更是引發科研機構和企業在大模型研究的競賽,大模型的參數規模逐漸增加。

2021年大模型層出不窮,1月,谷歌發布首個萬億級模型Switch Transformer;3月,北京智源研究院發布悟道1.0,6月發布悟道2.0,參數規模超過百億;4月,華為云發布盤古大模型,這是業界首個千億參數中文語言預訓練模型;9月,浪潮發布參數量達2457億的巨量模型“源1.0”;11月,英偉達與微軟聯合發布5300億參數的“MT-NLG”;同在11月,阿里達摩院宣布其多模態大模型M6最新參數從萬億躍遷至10萬億,超過谷歌、微軟此前發布的萬億級模型,成為全球最大的AI預訓練模型。

預訓練大模型其實是機器學習的一種方式,類比人的學習來看,人的學習可以分成通識教育和專業教育兩段,預訓練大模型相當于解決機器學習的通識教育。此前,機器學習主要通過標注數據,告訴算法哪個數據是正負樣本等進行學習。由于人工智能落地場景很多,每個場景都要采數據、標數據,因此在標注的數量和質量上存在很大的瓶頸。

為解決以上問題,自然語言處理領域迎來了一個新的突破:自監督學習,指的是不用人為標注數據,機器可以用一個方法把知識和規律學出來。比如,在模型訓練中,如果我們把“中國的首都是北京”這句話中的“北京”蓋住,讓模型去猜中國的首都是哪里,模型可能會猜一個城市,再把蓋的地方翻開,告訴模型是對了還是錯了,模型也就得到了反饋。

通過設計類似的學習方式,讓模型可以在海量的數據當中進行自監督學習。這個機制的好處就是,它可以把天然存在的大量數據利用起來,打破一定要精標數據才能學習的瓶頸,大模型的出現,實際上是為了大幅度降低了行業應用的門檻。

還有一個特別容易理解的解釋,預訓練大模型是在一個原始任務上預先訓練一個初始模型,然后在目標任務上使用該模型,針對目標任務的特性,對該初始模型進行精調,從而達到提高目標任務的目的。在本質上,這是一種遷移學習的方法,在自己的目標任務上使用別人訓練好的模型。

整體而言,預訓練大模型的興起,使得人工智能的通用性進一步增強,大模型具有效果好、泛化性強、研發流程標準化程度高等特點,正在成為人工智能技術及應用的新基座。

-

智能

+關注

關注

8文章

1718瀏覽量

117889 -

百度

+關注

關注

9文章

2306瀏覽量

91128 -

人工智能

+關注

關注

1800文章

48094瀏覽量

242225

發布評論請先 登錄

相關推薦

從Open Model Zoo下載的FastSeg大型公共預訓練模型,無法導入名稱是怎么回事?

KerasHub統一、全面的預訓練模型庫

華為宋曉迪出席自動駕駛網絡峰會

直播預約 |數據智能系列講座第4期:預訓練的基礎模型下的持續學習

度曉曉1秒1篇高考作文,都是因為預訓練大模型

度曉曉1秒1篇高考作文,都是因為預訓練大模型

評論