眾所周知,點(diǎn)云的有效分割是許多應(yīng)用的前提,例如在三維重建領(lǐng)域,需要對(duì)場(chǎng)景內(nèi)的物體首先進(jìn)行分類處理,然后才能進(jìn)行后期的識(shí)別和重建。傳統(tǒng)的點(diǎn)云分割主要依賴聚類算法和基于隨機(jī)采樣一致性的分割算法,在很多技術(shù)上得到了廣泛應(yīng)用,但當(dāng)點(diǎn)云規(guī)模不斷增大時(shí),傳統(tǒng)的分割算法已經(jīng)很難滿足實(shí)際需要,這時(shí)就需要結(jié)合深度學(xué)習(xí)進(jìn)行分割。因此,本文將重點(diǎn)介紹5種前沿的點(diǎn)云分割網(wǎng)絡(luò),包括PointNet/PointNet++、PCT、Cylinder以及JSNet網(wǎng)絡(luò),最后介紹5中常用的點(diǎn)云分割數(shù)據(jù)集。

“點(diǎn)云分割是根據(jù)空間、幾何和紋理等特征對(duì)點(diǎn)云進(jìn)行劃分,使得同一劃分內(nèi)的點(diǎn)云擁有相似的特征。”

01PointNet/PointNet++

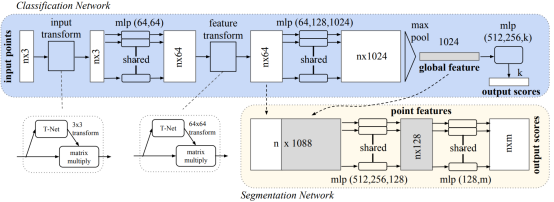

說起點(diǎn)云分割網(wǎng)絡(luò),就不得不介紹PointNet,它來源于CVPR的論文“Deep Learning on Point Sets for 3D Classification and Segmentation”。PointNet是首個(gè)輸入3D點(diǎn)云輸出分割結(jié)果的深度學(xué)習(xí)網(wǎng)絡(luò),屬于開山之作,成為了后續(xù)很多工作的BaseLine,網(wǎng)絡(luò)的總體結(jié)構(gòu)如圖1所示。

圖1 PointNet網(wǎng)絡(luò)

整體的PointNet網(wǎng)絡(luò)中,除了點(diǎn)云的感知以外,還有T-Net,即3D空間變換矩陣預(yù)測(cè)網(wǎng)絡(luò),這主要是由于點(diǎn)云分類的旋轉(zhuǎn)不變性,當(dāng)一個(gè)N×D在N的維度上隨意的打亂之后,其表述的其實(shí)是同一個(gè)物體,因此針對(duì)點(diǎn)云的置換不變性,其設(shè)計(jì)的網(wǎng)絡(luò)必須是一個(gè)對(duì)稱的函數(shù)。

在PointNet網(wǎng)絡(luò)中,對(duì)于每一個(gè)N×3的點(diǎn)云輸入,網(wǎng)絡(luò)先通過一個(gè)T-Net將其在空間上對(duì)齊(旋轉(zhuǎn)到正面),再通過MLP將其映射到64維的空間上,再進(jìn)行對(duì)齊,最后映射到1024維的空間上。這時(shí)對(duì)于每一個(gè)點(diǎn),都有一個(gè)1024維的向量表征,而這樣的向量表征對(duì)于一個(gè)3維的點(diǎn)云明顯是冗余的,因此這個(gè)時(shí)候引入最大池化操作,將1024維所有通道上都只保留最大的那一個(gè),這樣得到的1×1024的向量就是N個(gè)點(diǎn)云的全局特征。

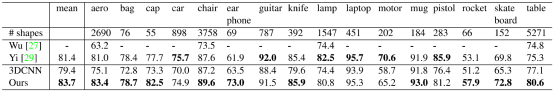

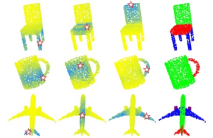

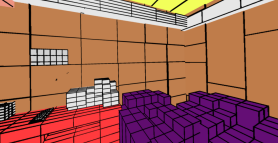

PointNet網(wǎng)絡(luò)在ShapeNet數(shù)據(jù)集上的實(shí)驗(yàn)效果如表1所示,可以看出,大多數(shù)分割都取得了SOAT效果。部分分割結(jié)果如圖2所示,可以看出分割結(jié)果相當(dāng)平穩(wěn),并且具有很強(qiáng)的魯棒性。

表1 PointNet在ShapeNet上的分割效果對(duì)比

圖2 PointNet部分分割結(jié)果

PointNet++主要是為了克服PointNet自身的一些缺點(diǎn),其中最大的缺點(diǎn)就是缺失局部特征。由于PointNet直接暴力地將所有的點(diǎn)最大池化為一個(gè)全局特征,因此局部點(diǎn)與點(diǎn)之間的聯(lián)系并沒有被網(wǎng)絡(luò)學(xué)習(xí)到。在分類和物體的Part Segmentation中,這樣的問題還可以通過中心化物體的坐標(biāo)軸部分地解決,但在場(chǎng)景分割中,這就會(huì)導(dǎo)致效果變差。

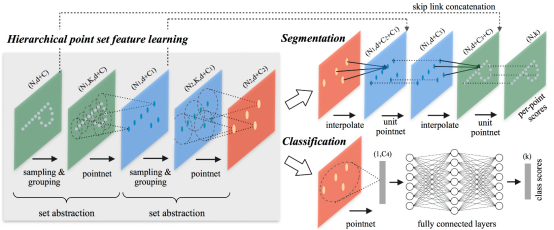

為了克服PointNet的缺點(diǎn),作者在PointNet++中主要借鑒了CNN的多層感受野的思想。CNN通過分層不斷地使用卷積核掃描圖像上的像素并做內(nèi)積,使得越到后面的特征圖感受野越大,同時(shí)每個(gè)像素包含的信息也越多。而PointNet++就是仿照了這樣的結(jié)構(gòu),先通過在整個(gè)點(diǎn)云的局部采樣并劃一個(gè)范圍,將里面的點(diǎn)作為局部的特征,用PointNet進(jìn)行一次特征的提取。因此,通過了多次這樣的操作以后,原本的點(diǎn)的個(gè)數(shù)變得越來越少,而每個(gè)點(diǎn)都是有上一層更多的點(diǎn)通過PointNet提取出來的局部特征,也就是每個(gè)點(diǎn)包含的信息變多了。

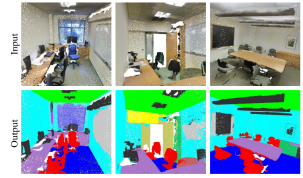

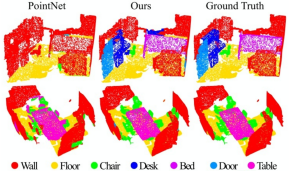

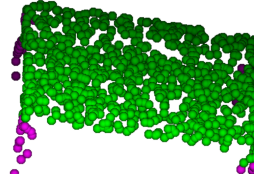

PointNet++的網(wǎng)絡(luò)結(jié)構(gòu)如圖3所示,同時(shí)作者對(duì)比了PointNet和PointNet++的分割效果如圖4所示,可見PointNet++的效果全面優(yōu)于PointNet。

圖3 PointNet++網(wǎng)絡(luò)結(jié)構(gòu)

圖4 PointNet++分割結(jié)果

02PCT網(wǎng)絡(luò)

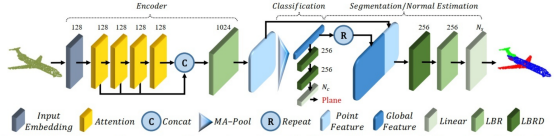

近年來,NLP領(lǐng)域的Transformer大火,同時(shí)也有大量學(xué)者將其從NLP領(lǐng)域遷移到圖像和點(diǎn)云領(lǐng)域。清華大學(xué)將Transformer應(yīng)用于3D點(diǎn)云分割技術(shù),設(shè)計(jì)了全新的PCT(Point Cloud Transformer)網(wǎng)絡(luò),其網(wǎng)絡(luò)結(jié)構(gòu)如圖5所示。

圖5 PCT網(wǎng)絡(luò)結(jié)構(gòu)

PCT應(yīng)用Transformer進(jìn)行點(diǎn)云分割的具體原理如圖6所示,其中星號(hào)代表Transformer的查詢向量,黃色到藍(lán)色代表注意力權(quán)重逐漸增加,最后一列代表分割結(jié)果。

圖6 PCT點(diǎn)云分割原理

為了更好地捕獲點(diǎn)云中的local context,作者在最遠(yuǎn)點(diǎn)采樣和最近鄰居搜索的支持下增強(qiáng)了輸入嵌入,同時(shí)Transformer在點(diǎn)云分割領(lǐng)域的成功,也逐漸打通了NLP、圖像、點(diǎn)云等不同領(lǐng)域的壁壘,對(duì)于“模型大一統(tǒng)”具有重要意義。PCT點(diǎn)云分割與其他分割算法的對(duì)比如圖7所示,大量的實(shí)驗(yàn)表明,PCT在形狀分類,part分割和法向量估算任務(wù)方面達(dá)到了最先進(jìn)的性能。

圖6 PCT點(diǎn)云分割效果與其他算法對(duì)比

03Cylinder網(wǎng)絡(luò)

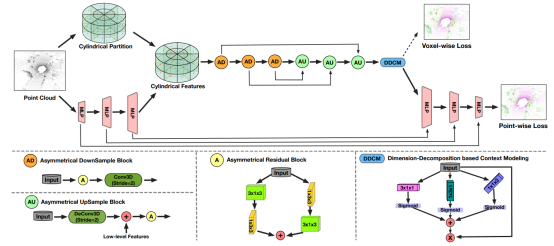

Cylinder網(wǎng)絡(luò)來源于CVPR論文“Cylindrical and Asymmetrical 3D Convolution Networks for LiDAR Segmentation”,Cylinder網(wǎng)絡(luò)結(jié)構(gòu)如圖7所示。Cylinder網(wǎng)絡(luò)由圓柱坐標(biāo)體素劃分和非對(duì)稱3D卷積網(wǎng)絡(luò)組成,作者認(rèn)為圓柱分割可以有效提高分割精度,此外作者還引入了一個(gè)point-wise模塊來改進(jìn)體素塊輸出,提高辨識(shí)精度。

圖7 Cylinder網(wǎng)絡(luò)結(jié)構(gòu)

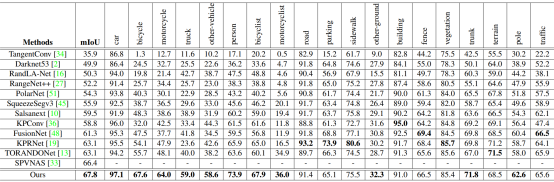

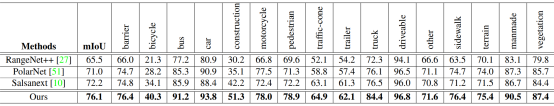

作者認(rèn)為基于柱坐標(biāo)的voxel的劃分,可以與激光雷達(dá)掃描過程保持一致。進(jìn)而有效地減少空voxel的比率。此外,作者將Cylinder網(wǎng)絡(luò)在兩個(gè)大型室外場(chǎng)景數(shù)據(jù)集(SemanticKITTI和nuScenes)上進(jìn)行了評(píng)估,評(píng)估效果對(duì)比如表2和表3所示。評(píng)估顯示,在SemanticKITTI數(shù)據(jù)集上,Cylinder網(wǎng)絡(luò)排名第一。在nuScenes數(shù)據(jù)集上,新方法的表現(xiàn)也大大超過了之前的方法。

表2 Cylinder網(wǎng)絡(luò)在SemanticKITTI數(shù)據(jù)集上的對(duì)比效果

表3 Cylinder網(wǎng)絡(luò)在nuScenes數(shù)據(jù)集上的對(duì)比效果

04JSNet網(wǎng)絡(luò)

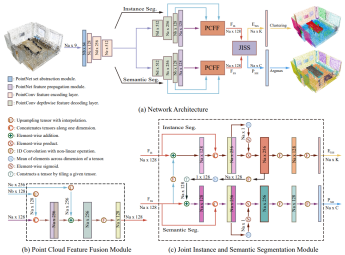

JSNet來源于AAAI論文“JSNet: Joint Instance and Semantic Segmentation of 3D Point Clouds”,JSNet可以同時(shí)解決3D點(diǎn)云的實(shí)例和語(yǔ)義分割問題,其網(wǎng)絡(luò)結(jié)構(gòu)如圖8所示。

圖8JSNet網(wǎng)絡(luò)結(jié)構(gòu)

JSNet首先建立有效的骨干網(wǎng)絡(luò),以從原始點(diǎn)云數(shù)據(jù)中提取魯棒的特征。其次為了獲得更多的判別特征,提出了一種點(diǎn)云特征融合模塊來融合骨干網(wǎng)的不同層特征。此外,JSNet開發(fā)了聯(lián)合實(shí)例語(yǔ)義分割模塊以將語(yǔ)義特征轉(zhuǎn)換為實(shí)例嵌入空間,然后將轉(zhuǎn)換后的特征進(jìn)一步與實(shí)例特征融合以促進(jìn)實(shí)例分割。同時(shí),該模塊還將實(shí)例特征聚合到語(yǔ)義特征空間中,以促進(jìn)語(yǔ)義分割。最后,JSNet通過對(duì)實(shí)例嵌入應(yīng)用簡(jiǎn)單的均值漂移聚類來生成實(shí)例預(yù)測(cè)。

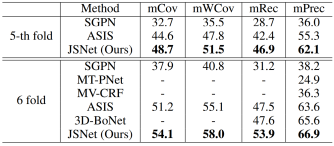

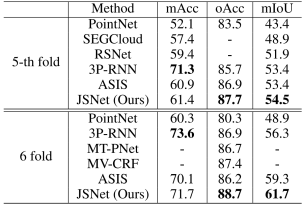

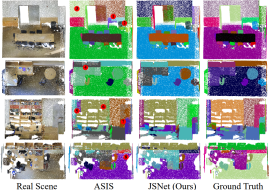

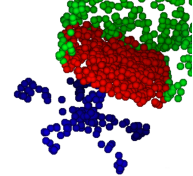

如表4和表5所示是JSNet網(wǎng)絡(luò)在大型3D室內(nèi)點(diǎn)云數(shù)據(jù)集S3DIS上的評(píng)估結(jié)果,圖9是JSNet網(wǎng)絡(luò)的分割效果。實(shí)驗(yàn)結(jié)果表明,JSNet網(wǎng)絡(luò)在3D實(shí)例分割中的性能優(yōu)于最新方法,在3D語(yǔ)義預(yù)測(cè)方面有重大改進(jìn),同時(shí)有利于零件分割。

表4 JSNet網(wǎng)絡(luò)在S3DIS數(shù)據(jù)集上的實(shí)例分割結(jié)果

表5 JSNet網(wǎng)絡(luò)在S3DIS數(shù)據(jù)集上的語(yǔ)義分割結(jié)果

圖9 JSNet網(wǎng)絡(luò)的分割效果

05點(diǎn)云分割數(shù)據(jù)集

深度神經(jīng)網(wǎng)絡(luò)的訓(xùn)練往往需要大量的數(shù)據(jù)集,同時(shí)深度神經(jīng)網(wǎng)絡(luò)性能的優(yōu)劣也往往是在公開數(shù)據(jù)集上進(jìn)行評(píng)估,因此選擇合適的數(shù)據(jù)集至關(guān)重要。常用的點(diǎn)云分割數(shù)據(jù)集主要有如下幾個(gè):

5.1 Semantic3D

經(jīng)典的大型室外場(chǎng)景點(diǎn)云分割數(shù)據(jù)集,由激光雷達(dá)掃描周圍場(chǎng)景得到。Semantic3D提供了一個(gè)帶有大標(biāo)簽的自然場(chǎng)景的3D點(diǎn)云數(shù)據(jù)集,總計(jì)超過40億個(gè)點(diǎn),8個(gè)類別標(biāo)簽。

數(shù)據(jù)集包含了各種城市和鄉(xiāng)村場(chǎng)景,如農(nóng)場(chǎng),市政廳,運(yùn)動(dòng)場(chǎng),城堡和廣場(chǎng)。該數(shù)據(jù)集包含15個(gè)訓(xùn)練數(shù)據(jù)集和15個(gè)測(cè)試數(shù)據(jù)集,另外還包括4個(gè)縮減了的測(cè)試數(shù)據(jù)集。數(shù)據(jù)集中的點(diǎn)都含有RGB和深度信息,并被標(biāo)記為8個(gè)語(yǔ)義類別,分別是1:人造地形;2:自然地形;3:高植被;4:低植被;5:建筑物;6:硬景觀;7:掃描人工制品,8:汽車,附加標(biāo)簽0:未標(biāo)記點(diǎn),標(biāo)記沒有地面真值的點(diǎn)。

數(shù)據(jù)集地址:http://www.semantic3d.net/

5.2 S3DIS

S3DIS數(shù)據(jù)集是斯坦福大學(xué)開發(fā)的帶有像素級(jí)語(yǔ)義標(biāo)注的語(yǔ)義數(shù)據(jù)集,是常用的室內(nèi)場(chǎng)景分割數(shù)據(jù)集,使用Matterport相機(jī)收集數(shù)據(jù),包含6個(gè)Area,13個(gè)語(yǔ)義元素,11種場(chǎng)景。

其中13個(gè)語(yǔ)義元素分別包括:天花板ceiling、地板floor、墻壁wall、梁beam、柱column、窗window、門door、桌子table、椅子chair、沙發(fā)sofa、書柜bookcase、板board、混雜元素(其他)clutter;11種場(chǎng)景分別包括辦公室office、會(huì)議室conference room、走廊hallway、禮堂auditorium、開放空間open space、大堂lobby、休息室lounge、儲(chǔ)藏室pantry、復(fù)印室copy room、儲(chǔ)藏室storage和衛(wèi)生間WC。

數(shù)據(jù)集地址:http://buildingparser.stanford.edu/dataset.html

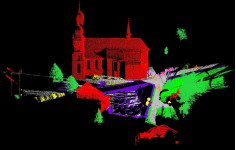

5.3 SemanticKITTI

SemanticKITTI數(shù)據(jù)集是一個(gè)基于KITTI Vision Benchmark里程計(jì)數(shù)據(jù)集的大型戶外點(diǎn)云數(shù)據(jù)集,顯示了市中心的交通、住宅區(qū),以及德國(guó)卡爾斯魯厄周圍的高速公路場(chǎng)景和鄉(xiāng)村道路。原始里程計(jì)數(shù)據(jù)集由22個(gè)序列組成,作者將序列00到10拆分為訓(xùn)練集,將11到21拆分為測(cè)試集,并且為了與原始基準(zhǔn)保持一致,作者對(duì)訓(xùn)練和測(cè)試集采用相同的劃分,采用和KITTI數(shù)據(jù)集相同的標(biāo)定方法,這使得該數(shù)據(jù)集和KITTI數(shù)據(jù)集等數(shù)據(jù)集可以通用。

SemanticKITTI數(shù)據(jù)集作者提供了精確的序列掃描注釋,并且在點(diǎn)注釋中顯示了前所未有的細(xì)節(jié),包含28個(gè)類,確保了類與Mapillary Visiotas數(shù)據(jù)集和Cityscapes數(shù)據(jù)集有很大的重疊,并在必要時(shí)進(jìn)行了修改,以考慮稀疏性和垂直視野。

數(shù)據(jù)集地址:http://www.semantic-kitti.org/index.html

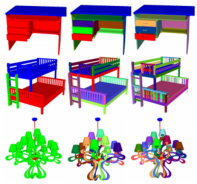

5.4 ShapeNet

ShapeNet數(shù)據(jù)集是一個(gè)由對(duì)象的三維CAD模型表示的形狀存儲(chǔ)庫(kù),注釋豐富,規(guī)模較大。ShapeNet包含來自多種語(yǔ)義類別的3D模型,并按照WordNet分類法組織,能夠完成部件分割任務(wù),即不僅知道這個(gè)點(diǎn)云數(shù)據(jù)大的分割,還要將它的小部件進(jìn)行分割。它總共包括十六個(gè)大的類別,每個(gè)大的類別有可以分成若干個(gè)小類別,十六個(gè)類別具體包括:飛機(jī)Airplane、包Bag、帽子Cap、汽車Car、椅子Chair、耳機(jī)Earphone、吉他Guitar、刀Knife、燈Lamp、電腦Laptop、摩托車Motorbike、杯子Mug、手槍Pistol、火箭Rocket、滑板Skateboard、桌子Table。

數(shù)據(jù)集地址:https://www.shapenet.org/

5.5 PartNet

PartNet數(shù)據(jù)集是用于細(xì)粒度和分層零件級(jí)3D對(duì)象理解的大規(guī)模基準(zhǔn)。數(shù)據(jù)集包含573585個(gè)零件實(shí)例,涵蓋26671個(gè)3D模型,涵蓋24個(gè)對(duì)象類別。PartNet數(shù)據(jù)集啟用并充當(dāng)許多任務(wù)的催化劑,例如形狀分析,動(dòng)態(tài)3D場(chǎng)景建模和仿真,可負(fù)擔(dān)性分析等。數(shù)據(jù)集建立了用于評(píng)估3D零件識(shí)別的三個(gè)基準(zhǔn)測(cè)試任務(wù):細(xì)粒度語(yǔ)義分割,分層語(yǔ)義分割和實(shí)例分割。

數(shù)據(jù)集地址:https://shapenet.org/download/parts

06結(jié)論

近年來,隨著自動(dòng)駕駛和三維重建技術(shù)的不斷發(fā)展,需要處理的點(diǎn)云規(guī)模越來越龐大,傳統(tǒng)的聚類算法和基于隨機(jī)采樣一致性的分割算法較難滿足實(shí)時(shí)性和精度要求。而基于深度學(xué)習(xí)的點(diǎn)云分割網(wǎng)絡(luò)較好地解決了上述問題,本文重點(diǎn)介紹了幾種前沿的點(diǎn)云分割網(wǎng)絡(luò),包括PointNet/PointNet++、PCT、Cylinder以及JSNet網(wǎng)絡(luò),并介紹了5種常用的點(diǎn)云分割數(shù)據(jù)集。讀者在應(yīng)用深度學(xué)習(xí)進(jìn)行點(diǎn)云分割或設(shè)計(jì)點(diǎn)云分割網(wǎng)絡(luò)時(shí),要根據(jù)自身需求和實(shí)際工況,有針對(duì)地選擇合適的點(diǎn)云分割網(wǎng)絡(luò)和數(shù)據(jù)集。

審核編輯 :李倩

-

函數(shù)

+關(guān)注

關(guān)注

3文章

4338瀏覽量

62740 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24737 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5507瀏覽量

121272

原文標(biāo)題:基于深度學(xué)習(xí)的點(diǎn)云分割網(wǎng)絡(luò)及點(diǎn)云分割數(shù)據(jù)集

文章出處:【微信號(hào):vision263com,微信公眾號(hào):新機(jī)器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

Comcast將5G核心網(wǎng)絡(luò)遷移至亞馬遜云科技

什么是三維點(diǎn)云分割

阻礙云計(jì)算采用5種原因

語(yǔ)義分割25種損失函數(shù)綜述和展望

畫面分割器怎么調(diào)試

畫面分割器怎么連接

圖像語(yǔ)義分割的實(shí)用性是什么

圖像分割和語(yǔ)義分割的區(qū)別與聯(lián)系

圖像分割與語(yǔ)義分割中的CNN模型綜述

云網(wǎng)絡(luò)與云計(jì)算:有什么區(qū)別?

基于深度學(xué)習(xí)的方法在處理3D點(diǎn)云進(jìn)行缺陷分類應(yīng)用

CK-RA6M5上的RA AWS云連接,帶蜂窩網(wǎng)絡(luò)-入門指南

5G網(wǎng)絡(luò)通信有哪些技術(shù)痛點(diǎn)?光耦技術(shù)在5G網(wǎng)絡(luò)通信的應(yīng)用

OpenCV兩種不同方法實(shí)現(xiàn)粘連大米分割計(jì)數(shù)

15倍加速!SuperCluster:最強(qiáng)3D點(diǎn)云全景分割!

5種前沿的點(diǎn)云分割網(wǎng)絡(luò)

5種前沿的點(diǎn)云分割網(wǎng)絡(luò)

評(píng)論