目前CV領域中包括兩種典型的訓練模式,第一種是傳統的圖像分類訓練,以離散的label為目標,人工標注、收集干凈、大量的訓練數據,訓練圖像識別模型。第二種方法是最近比較火的基于對比學習的圖文匹配訓練方法,利用圖像和其對應的文本描述,采用對比學習的方法訓練模型。這兩種方法各有優劣,前者可以達到非常高的圖像識別精度、比較強的遷移能力,但是依賴人工標注數據;后者可以利用海量噪聲可能較大的圖像文本對作為訓練數據,在few-shot learning、zero-shot learning上取得很好的效果,但是判別能力相比用干凈label訓練的方法較弱。今天給大家介紹一篇CVPR 2022微軟發表的工作,融合兩種數據的一個大一統對比學習框架。

論文題目:Unified Contrastive Learning in Image-Text-Label Space

下載地址:https://arxiv.org/pdf/2204.03610.pdf

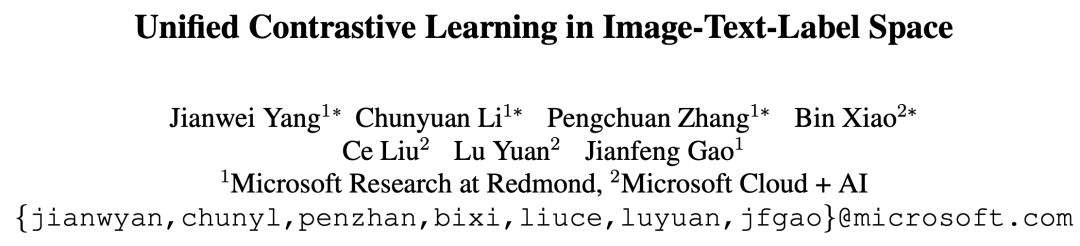

CVPR 2022微軟發表的這篇工作,希望同時利用圖像、文本、label三者的信息,構建一個統一的對比學習框架,同時利用兩種訓練模式的優勢。下圖反映了兩種訓練模式的差異,Image-Label以離散label為目標,將相同概念的圖像視為一組,完全忽視文本信息;而Image-Text以圖文對匹配為目標,每一對圖文可以視作一個單獨的label,文本側引入豐富的語義信息。

1

兩種數據的融合

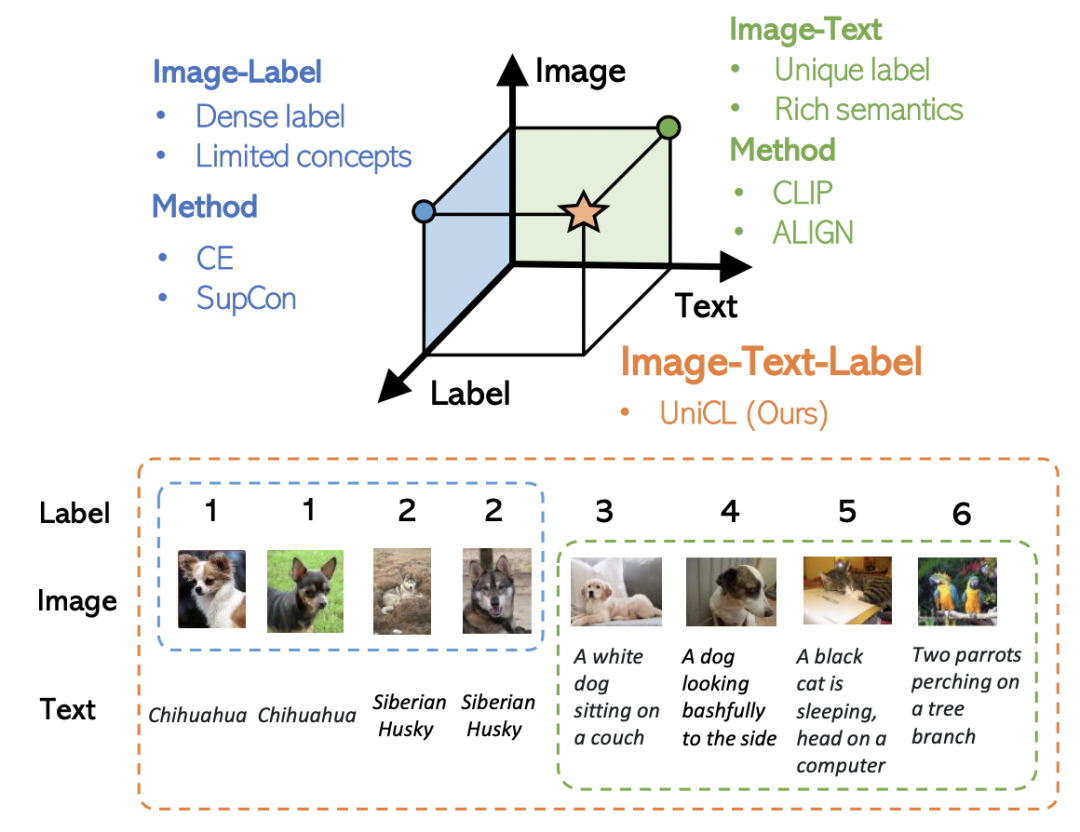

上面所說的Image-Label和Image-Text兩種數據,可以表示成一個統一的形式:(圖像,文本,label)三元組。其中,對于Image-Lable數據,文本是每個label對應的類別名稱,label對應的每個類別的離散標簽;對于Image-Text數據,文本是每個圖像的文本描述,label對于每對匹配的圖文對都是不同的。將兩種數據融合到一起,如下圖右側所示,可以形成一個矩陣,填充部分為正樣本,其他為負樣本。Image-Label數據中,對應類別的圖文為正樣本;Image-Text中對角線為正樣本。

2

損失函數

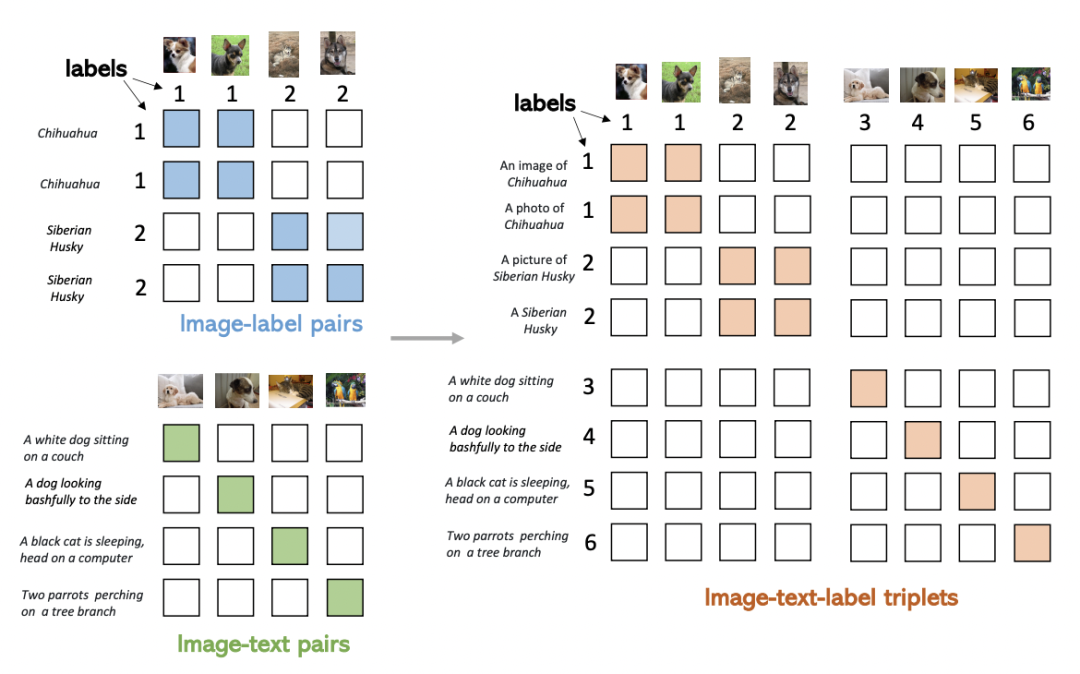

在上述矩陣的基礎上,可以利用對比學習的思路構建融合Image-Label和Image-Text兩種數據優化函數。對于一個batch內的所有樣本,分別使用圖像Encoder和文本Encoder得到圖像和文本的表示,并進行歸一化,然后計算圖像文本之間的相似度,和CLIP類似。其中Image-to-Text損失函數可以表示為:

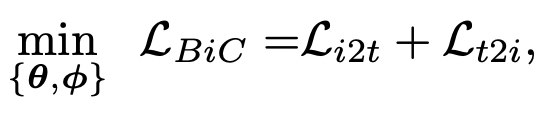

以樣本i(文本)為中心,k表示當前batch內,和樣本i的label相同的圖像,j表示batch內所有其他樣本。也就是說,對于每個文本,損失函數的分子是和該文本匹配的圖像,分母是batch內所有圖像。Text-to-Image損失函數也類似。最終BiC loss是二者之和:

3

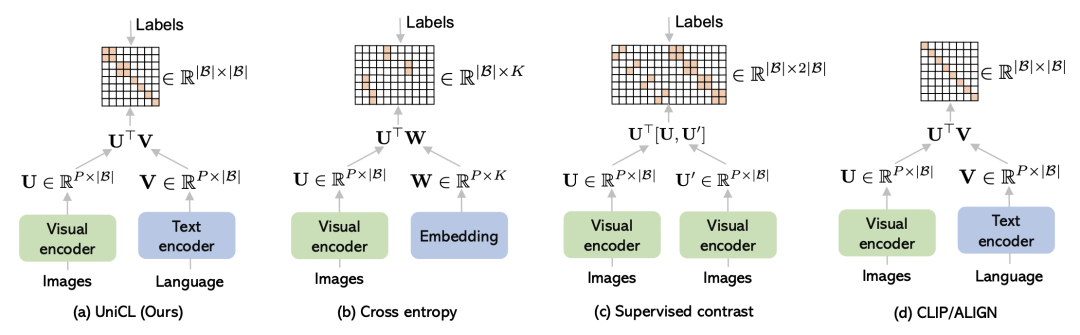

與其他損失函數的對比

BiC loss和交叉熵、Supervised Contrast以及CLIP三種方法的損失函數差別如下圖所示,這幾種損失函數之間存在著一定的聯系。

與交叉熵損失的關系:如果text encoder只是一個普通的全連接,并且batch size相比類別數量足夠大,以至于一個batch內所有類別的樣本都出現過,那么BiC和交叉熵等價。因此BiC相比交叉熵更具一般性,BiC讓具有相似文本描述的圖像表示形成類簇,不具有相似文本描述的圖像被拉遠。文本側也更加靈活,能夠使用任意種類的文本輸入,結合更豐富的文本Encoder聯合學習。

與SupCon的關系:SupCon是圖像對比學習,訓練數據每對pair都是圖像,共用一個Encoder;而BiC針對的是跨模態對比學習,圖片和文本跨模態對齊。但是兩者的核心思路都是根據有label數據,將batch內出現樣本更多置為正樣本。

與CLIP的關系:和CLIP的主要差別在于,利用label信息將一部分非對角線上的元素視為正樣本。如果這里不使用Image-Label數據,那么就和CLIP相同。

4

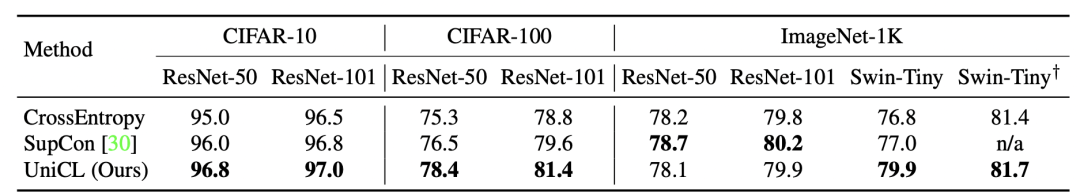

實驗效果

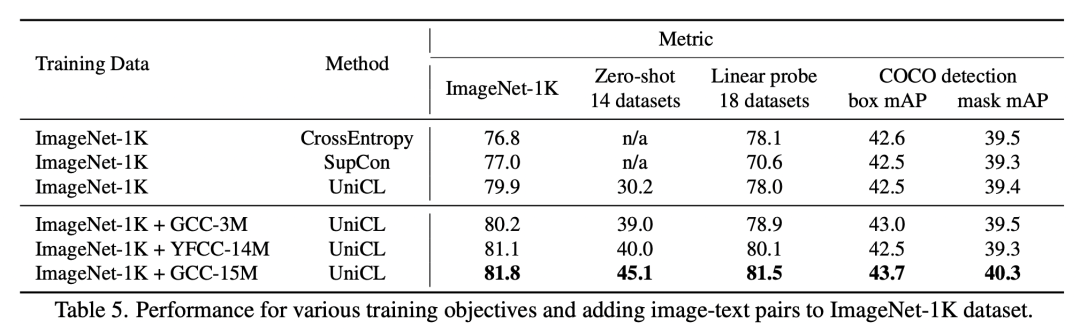

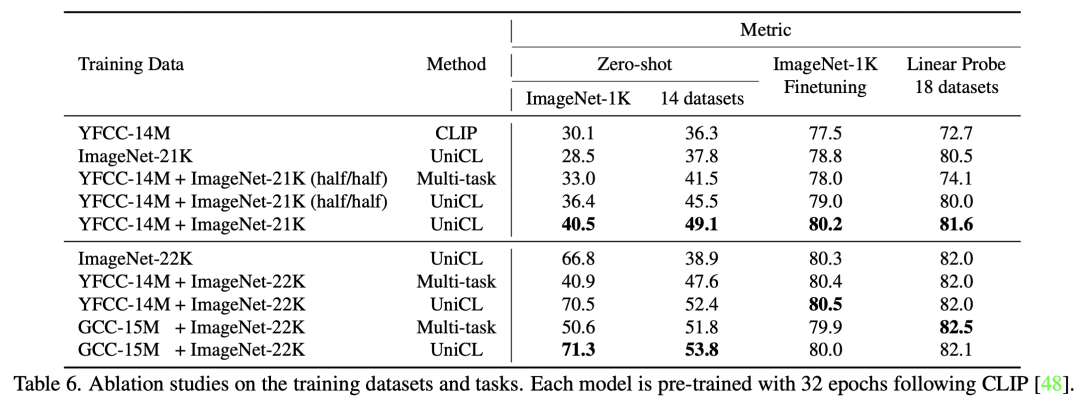

圖像分類效果對比:相比使用交叉熵損失和有監督對比學習,文中提出的UniCL在多個模型和數據集上取得較好的效果。尤其是在小數據集上訓練時,UniCL比交叉熵訓練效果提升更明顯,因為引入的圖文匹配方式讓具有相似語義圖像聚集在一起,緩解了過擬合問題。

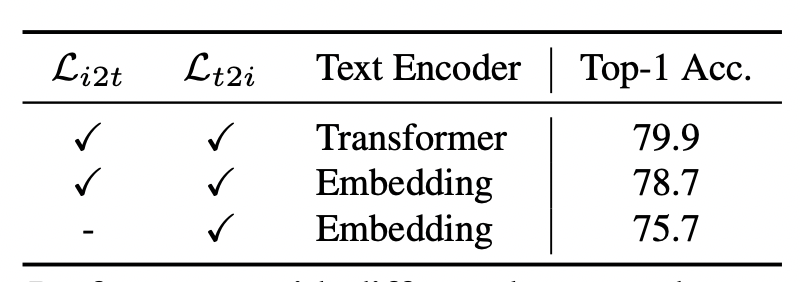

文本Encoder和損失函數對比:文中也對比了文本Encoder是否引入的效果,如果將Transformer替換成線性層,效果有所下降,表明文本Encoder的引入能夠幫助模型學習到1000多個類別之間的關系文本語義關系,有助于提升圖像分類效果。同時,如果去掉i2t的loss只保留t2i的loss,會導致效果大幅下降。

Image-Text引入對Image-Label效果提升:對于上面3行和下面3行,下面3行引入額外Image-Text數據的圖像分類效果要顯著優于只使用圖像分類數據的效果。

Image-Label引入對Image-Text效果提升:通過下面實驗對比,引入Image-Label對Image-Text效果有一定提升作用。

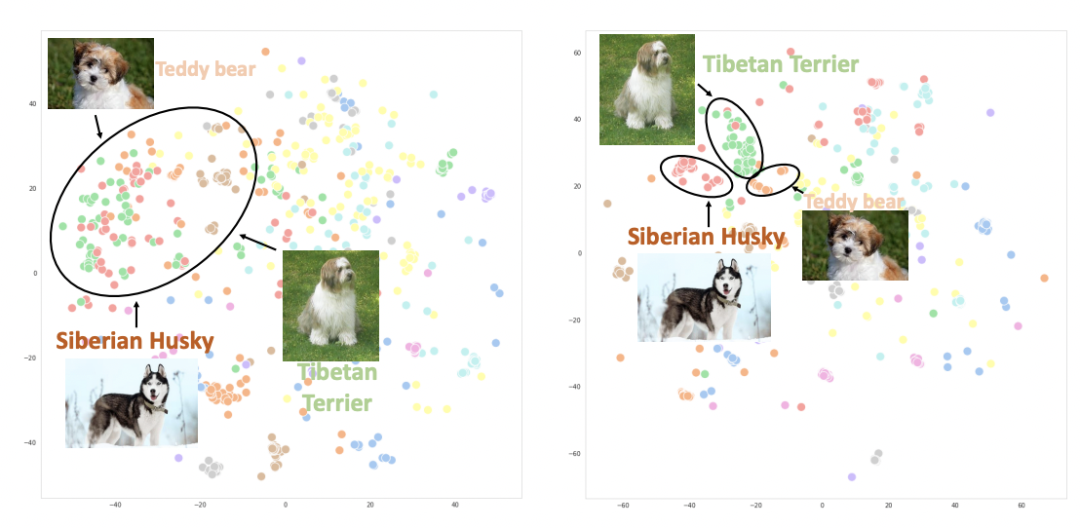

下圖繪制了使用CLIP(左)和UniCL(右)兩種方法訓練的圖像embedding的t-sne圖。可以看到,使用CLIP訓練的模型,不同類別的圖像表示混在一起;而使用UniCL訓練的模型,不同類別的圖像表示能夠比較好的區分。

5

總結

本文介紹了融合Image-Text和Image-Label兩種數據的的多模態訓練新方式,充分利用了不同的圖像-文本數據,信息相互補充,相比單獨使用一個數據取得非常好的效果。Label的引入也讓對比學習的正負樣本構造更加科學。

原文標題:圖文匹配 + 圖像分類 = 統一多模態對比學習框架

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

數據

+關注

關注

8文章

7080瀏覽量

89175 -

圖像識別

+關注

關注

9文章

520瀏覽量

38290 -

函數

+關注

關注

3文章

4338瀏覽量

62739

原文標題:圖文匹配 + 圖像分類 = 統一多模態對比學習框架

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

《DNK210使用指南 -CanMV版 V1.0》第三十七章 image圖像對比實驗

《DNK210使用指南 -CanMV版 V1.0》第三十三章 image元素繪制實驗

利用OpenVINO部署Qwen2多模態模型

Labview與Halcon圖片Image互相轉換

鴻蒙ArkTS聲明式組件:Image

OpenHarmony實戰開發-如何實現模態轉場

未來已來,多傳感器融合感知是自動駕駛破局的關鍵

關于多跳通信和單跳通信兩種方式有什么區別

機器人基于開源的多模態語言視覺大模型

CMOS Image sensor的基礎知識

融合Image-Text和Image-Label兩種數據的多模態訓練新方式

融合Image-Text和Image-Label兩種數據的多模態訓練新方式

評論