【導讀】谷歌大神Jeff Dean最近親自操刀發新作,提出了一個大規模多任務學習框架μ2Net,基本把各大數據集多任務學習的SOTA刷了個遍,但這次為何網友有點不買賬了?很簡單,差錢。

2021年10月,Jeff Dean親自撰文介紹了一個全新的機器學習架構——Pathways。 目的很簡單,就是讓一個AI能夠跨越數以萬計的的任務,理解不同類型的數據,并同時以極高的效率實現:

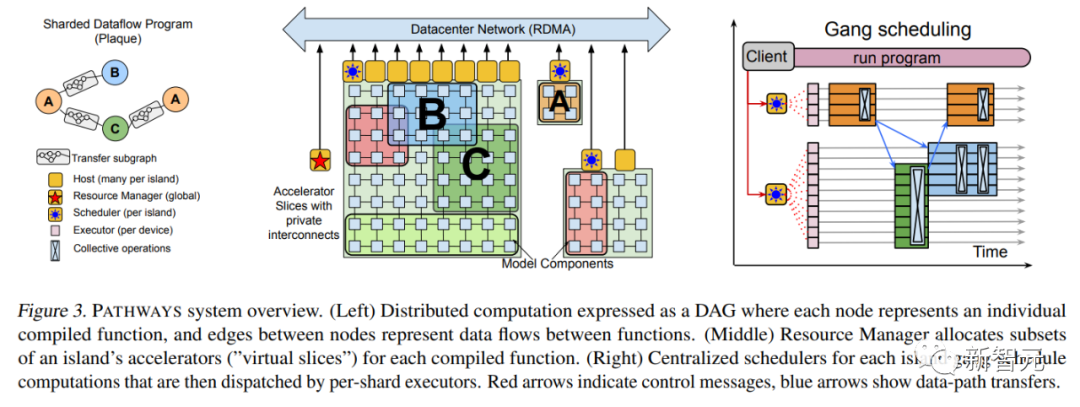

在大半年之后的2022年3月,Jeff Dean終于發布了Pathways的論文。

論文連接:https://arxiv.org/abs/2203.12533 其中,補充了不少技術上的細節,比如最基本的系統架構等等。

2022年4月,谷歌用Pathways的PaLM語言模型橫空出世,接連打破多項自然語言處理任務的SOTA,這個擁有5400億參數的Transformer語言模型再次證明了「大力出奇跡」。 除了用到強大的Pathways系統外,論文中介紹PaLM的訓練用到了6144個TPU v4,使用了7800億token的高質量數據集,并且其中有一定比例的非英文多語種語料。

論文地址:https://arxiv.org/abs/2204.02311 最近,Jeff Dean一篇新作又引發了大家對Pathways的猜測。

Pathways的拼圖又合上了一塊?

這篇論文的作者只有兩位:大名鼎鼎的Jeff Dean和來自意大利的工程師Andrea Gesmundo。 有趣的是,不僅Gesmundo很低調,而且前兩天剛吹完自家Imagen的Jeff Dean也完全沒有在推特上提及此事。 而有網友拜讀之后推測,這可能是下一代AI架構Pathways的組成部分。

論文地址:https://arxiv.org/abs/2205.12755 本文的思路是這樣的: 通過動態地將新任務納入一個大型運行系統,可以利用稀疏多任務機器學習模型的碎片,來實現新任務質量的提升,并可以在相關任務之間自動分享模型的碎片。 這種方法可以提高每個任務的質量,并在收斂時間、訓練實例數量、能源消耗等方面提高模型效率。本文提出的機器學習問題框架,可以視作標準多任務和持續學習形式化的概括和綜合。 在這個框架下,再大的任務集都可以被聯合解決。 而且,隨著時間的推移,任務集中可以加入連續的新任務流來實現擴展。預訓練任務和下游任務之間的區別也不存在了。 因為,隨著新任務的加入,系統會尋找如何將已有的知識和表征與新的模型能力相結合,以實現每個新任務的高質量水平。在解決一個新任務時獲得的知識和學到的表征,也可用于任何未來的任務,或繼續學習現有任務。 這個方法名為「突變多任務網絡」或μ2Net。(μ=Mutation)

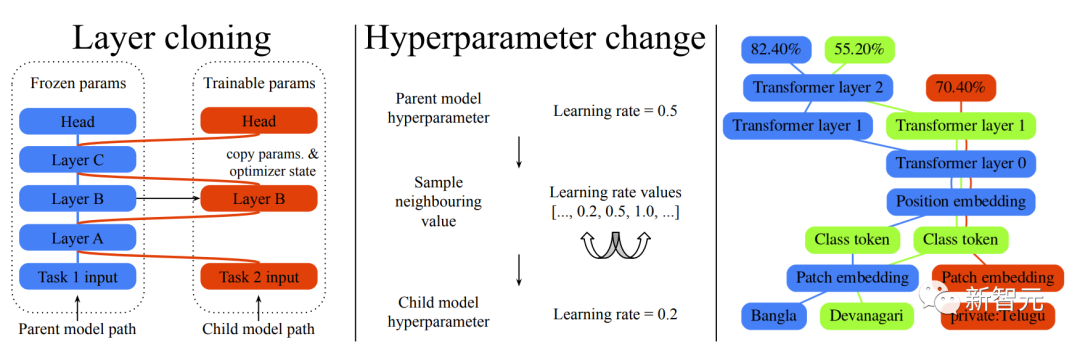

用于大規模持續學習實驗的兩類突變模型 簡單說,就是生成一個大規模的多任務網絡,去聯合解決多個任務。不僅每個任務的質量和效率都獲得了提升,還可以通過動態增加新的任務來實現模型的擴展。 通過對以前任務的學習,嵌入到系統中的知識積累越多,后續任務的解決方案的質量就越高。 此外,在減少每個任務新添加的參數方面,新任務的解決效率可以不斷提高。生成的多任務模型是稀疏激活的,模型集成了基于任務的路由機制,隨著模型的擴展,保證每個任務的計算成本的上升是有界限的。

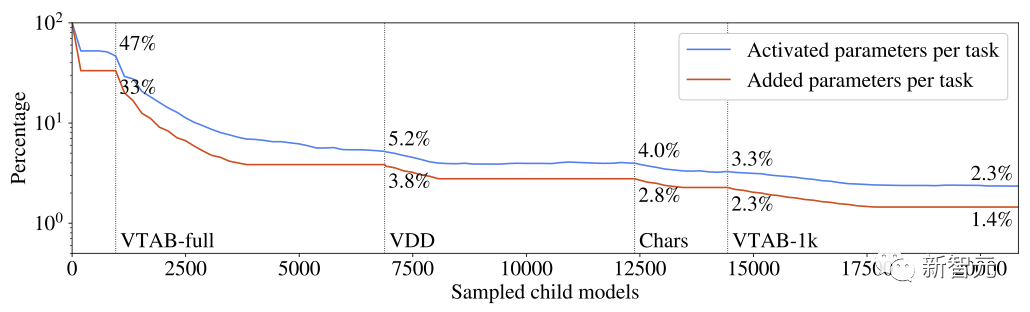

每個任務激活的和增加的參數占多任務系統參數總數的百分比 從每個任務學到的知識被分割成可以被多個任務重用的部分。實驗證明,這種分塊技術避免了多任務和持續學習模型的常見問題,如災難性遺忘、梯度干擾和負遷移。 對任務路線空間的探索和對每個任務最相關的先驗知識子集的識別是由一個進化算法引導的,該算法旨在動態地調整探索/利用的平衡,而不需要手動調整元參數。同樣的進化邏輯被用于動態調整超參數多任務模型組件。

既然叫「突變網絡」,這個突變是怎么解釋的? 深度神經網絡通常由架構和超參數來定義。本文中的架構是由一連串的神經網絡層組成的。每個層將輸入向量映射到一個可變維度的輸出向量,網絡實例化的細節,比如優化器或數據預處理的配置,則由超參數確定。 所以這里講的突變也分為兩類,層克隆突變和超參數突變。 層克隆突變創建了一個可以被子模型訓練的任何父模型圖層的副本。如果父模型的某層沒有被選中進行克隆,會凍結當前狀態并與子模型共享,以保證預先存在的模型的不變性。 超參數突變則用于修改子層從父層繼承的配置。每個超參數的新值可以從一組有效值中抽取。對于數字超參數,有效值集被排序為一個列表,采樣時僅限于相鄰值,以應用一個增量變化約束。 來看看實際效果如何:

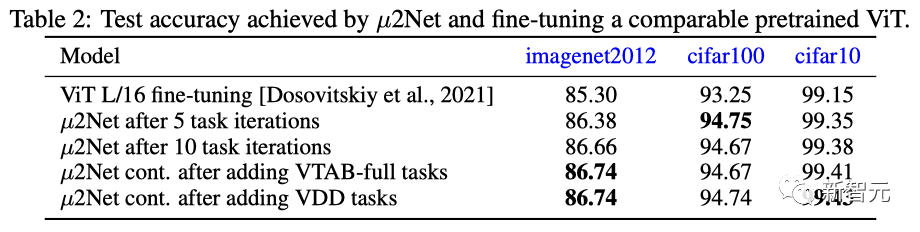

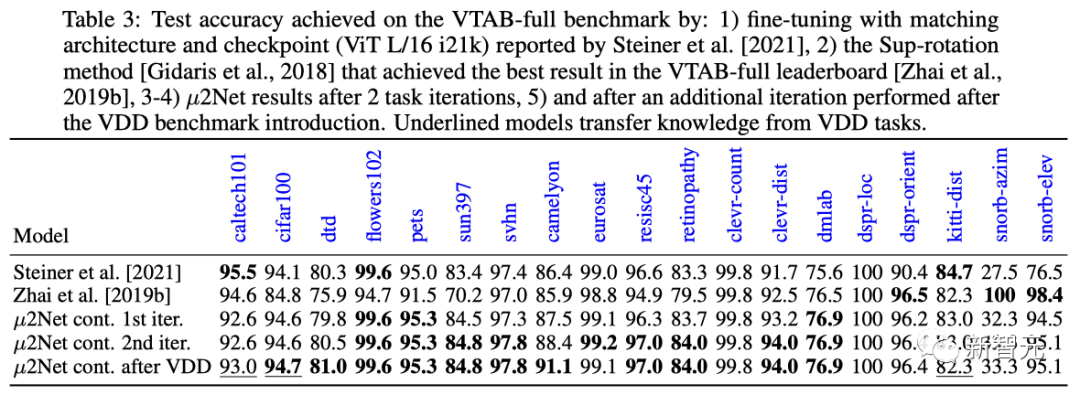

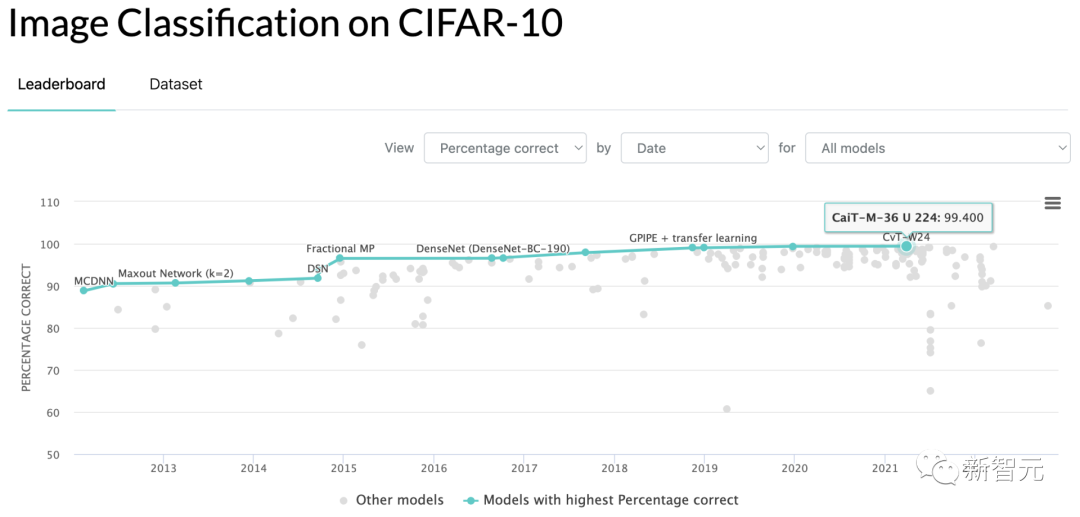

在ImageNet 2012、cifar100、cifar10三個數據集上,μ2Net在5任務迭代、10任務迭代后的表現均超過了當前最通用和性能最好的ViT預訓練微調模型。 在任務擴展方面,在加入VTAB-full和VDD持續學習任務后,μ2Net性能表現獲得進一步提升,在cifar10數據集上的VDD持續學習任務表現達到了99.43%的最佳成績。

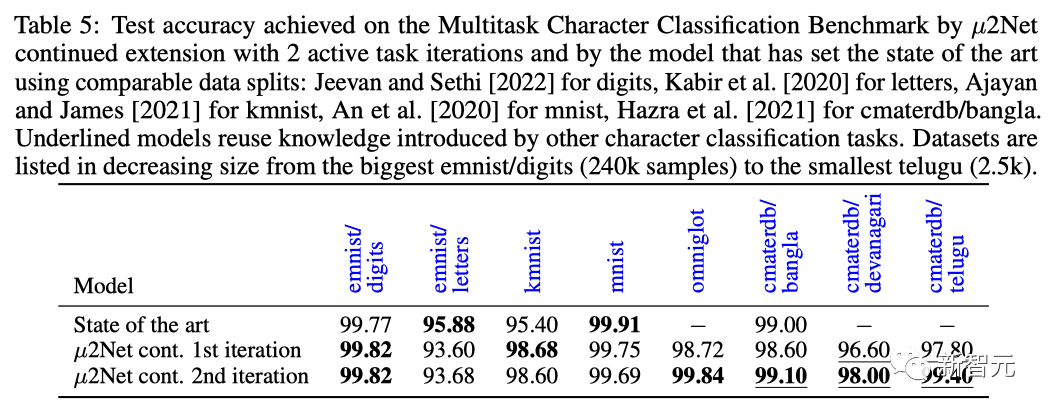

在多任務字符分類基準任務上,在兩次任務迭代后,μ2Net在大部分數據集上刷新了SOTA水平,數據集規模由2.5k到240k樣本容量不等。

簡單來說,在這個架構之下,模型學習的任務越多,系統學到的知識就越多,也就越容易解決新的任務。 比如,一個ViT-L架構(3.07億個參數)可以演變成一個具有1308.7億個參數的多任務系統,并解決69個任務。 此外,隨著系統的增長,參數激活的稀疏性使每個任務的計算量和內存用量保持不變。實驗表面,每個任務平均增加的參數減少了38%,而多任務系統只激活了每個任務總參數的2.3%。 當然,在這一點上,它只是一個架構和初步實驗。

網友:論文很好,但……

雖然論文很棒棒,但好像有人不買賬。 有些熱愛戳穿皇帝新衣的網友,在reddit上發帖,稱他再也不相信愛情……哦不,「頂級實驗室/研究機構」出品的AI論文了。 這位ID為「Acurite先生」的網友稱,他自然相信這些論文里的數據與模型運行結果。 但,就拿Jeff Dean老師的這篇論文來說吧,18頁的論文說了特別復雜的進化卷積與多任務學習算法,厲害,亮眼,好頂贊。 不過,有兩點不得不提出: 第一,Jeff Dean們在論文中提出的證明自己勝過競品的跑分結果,是CIFAR-10基準測試準確度99.43,勝過了當前SOTA的99.40…… 也不能說這是忽悠,但真的很讓人難以措辭形容。

第二,論文末尾有用TPU跑算法得出最終結果的時間耗費表,總計17810小時。 假設有人不在谷歌干、又想復現論文結果,按照每小時3.22美元的市價租TPU來再跑一次,那花費就是57348美元。 有啥意思呢?連日常論文都要設置鈔能力門檻了嗎? 當然,這種做派現在是業界風氣,包括但不限于谷歌、OpenAI這些大玩家。大家都往模型里灌少少改進現狀的創意、和多多的預處理數據與基準。 然后,只要運行結果在數值上比對家高出哪怕百分點后的小數點后二位,研究者也可以理直氣壯地在簡歷上新增一行論文題目啦! 這么搞,對學界和業界有啥真的推動?普通研究生又花不起錢來驗證你的結論,普通企業又沒法在項目里使用這么無聊的跑分。 還是那句話,有啥意思呢? 這難道就是AI界的可接受舒適區么?一小撥大企業、和偶爾的頂尖學校,天天炫耀我有錢可以為所欲為、你沒錢只好跟后面吃灰? 這么玩下去,干脆另開個計算機學期刊,專收那些結果可以在消費級單機顯卡上八小時跑出復現的論文算了。 跟帖里,有論文任務的研究生們紛紛訴苦。 有位ID是「支持向量機」的網友說,自己是小型實驗室里的從業者,因為這個勢頭,已經快完全喪失繼續搞深度學習的動力了。 因為靠自己實驗室的預算,根本沒法和這些巨無霸比,出不了鈔能力打底的跑分結果。 即使你有個理論上的新點子,要寫成能過評議的論文也難。因為現在論文評議人里,被大廠的鈔能力養出了「美圖偏見」,論文里用來測試的圖像不好看,一切白搭。 不是說巨無霸大廠一無是處啊,GPT和DALL-E這些項目真的是開天辟地。但如果我自己的機器跑不動,我激動個啥呢。 另有一個博士生網友現身說法,跟帖佐證「支持向量機」。 博士生前兩年遞交了一份關于流模型的論文,主要著重于發現可采樣的數據潛在空間,對模型的圖片生成質量沒影響。 結果論文打分人給的批評意見是:「生成的圖像看起來不如用GAN生成的好」。 另一個ID叫「烏代」的研究生也說,2021年他提交的參加會議論文,打分人給的批評意見是:「數據不夠花哨。」

看來人力不敵鈔能力,真是東西心理攸同、中外道術未裂的世界性趨勢。 不過三十年河東、三十年河西,說不定算法草根化、全民大寫碼,會帶來第二次車庫創業企業打敗IBM的奇跡呢。

審核編輯 :李倩

-

框架

+關注

關注

0文章

403瀏覽量

17475 -

機器學習

+關注

關注

66文章

8406瀏覽量

132565 -

數據集

+關注

關注

4文章

1208瀏覽量

24689

原文標題:Jeff Dean大規模多任務學習SOTA遭吐槽,復現一遍要6萬美元!

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

時空引導下的時間序列自監督學習框架

NPU與機器學習算法的關系

使用EMBark進行大規模推薦系統訓練Embedding加速

【「大模型時代的基礎架構」閱讀體驗】+ 第一、二章學習感受

TensorFlow與PyTorch深度學習框架的比較與選擇

【大規模語言模型:從理論到實踐】- 每日進步一點點

專用集成電路都是大規模的嗎為什么呢

專用集成電路都是大規模的嗎對嗎

名單公布!【書籍評測活動NO.30】大規模語言模型:從理論到實踐

谷歌推出AI框架,實現AI模型的自然語言學習

大規模數據中心網絡演進的七大主流趨勢

谷歌模型框架是什么軟件?谷歌模型框架怎么用?

如何選擇RTOS?使用R-Rhealstone框架評估

一個大規模多任務學習框架μ2Net

一個大規模多任務學習框架μ2Net

評論