作者

武卓博士

曾主持國家級及省部級科研項目十余項,已授權國際國內專利十余項。

目前,數字化浪潮席卷全球,人類社會已經進入智能時代。萬物互聯的數字化浪潮下,端—邊—云協同是實現數字化智能化的重要架構之一。本文我們將簡要分析邊云協同的必要性,并介紹如何使用英特爾開源的OpenVINO工具套件,在“端—邊—云”快速實現高性能人工智能推理。

1邊云協同的必要性及

OpenVINO工具套件簡介

眾所周知,18世紀60年代人類開始了第一次工業革命,從此進入“蒸汽時代”,接著進入了電氣時代和信息時代,當前人類社會正在發生第四次工業革命,即智能時代。英特爾首席執行官帕特·基辛格在2021年世界互聯網大會烏鎮峰會上指出,要擁抱四大超級技術力量。這四大超級技術力量分別是:第一,無所不在的計算。計算能力正滲透到我們生活的方方面面,作為人和技術的交互點,跨越現有和新興設備。第二,無處不在的連接,即萬物互聯。第三,從云到邊緣的基礎設施。它創造一個動態可靠的路徑來連接計算和數據,實現規模和容量無限擴展的云與無限延伸的智能邊緣相結合。第四是人工智能。這四大超級技術力量并不是技術孤島,而且相互協同,相互融合,共同推動產業的巨大變革。

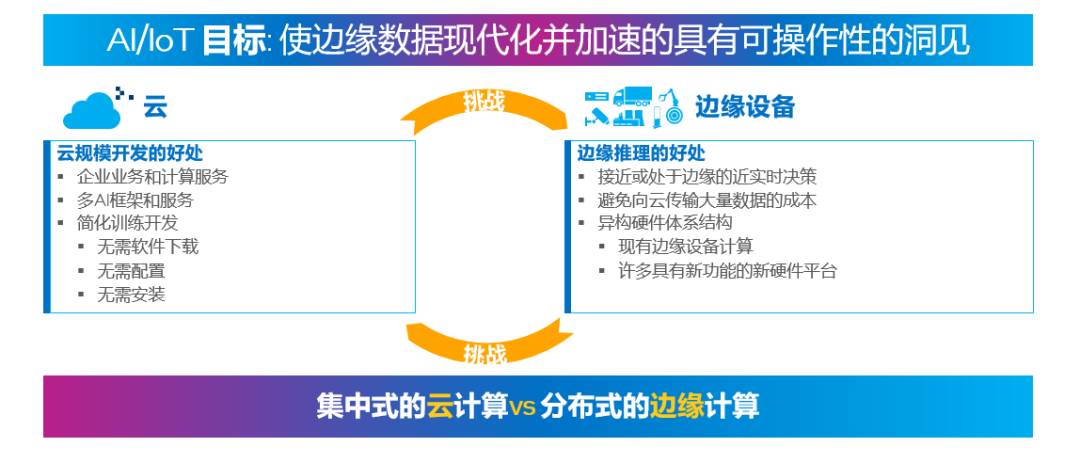

四大超級技術力量使得數據一旦產生之后,能夠在相應的節點做快速且及時的處理,從而減少數據處理的延時;高價值數據經過邊緣提取后,高效率的傳遞到云端,借助云端的超級計算力量挖掘數據背后隱含的價值,讓用戶可以開發相應的服務,實現科技向善。沒有邊云協同,這四大超級技術力量將被割裂,數據將成為孤島,智能時代要求的智能化、無人化和集群化將無法實現。如下圖所示,將云端規模開發的優勢與邊緣端推理的好處結合起來,能夠使得邊云協同的優勢發揮到最大化,將無限的數據變成可操作的洞察力。

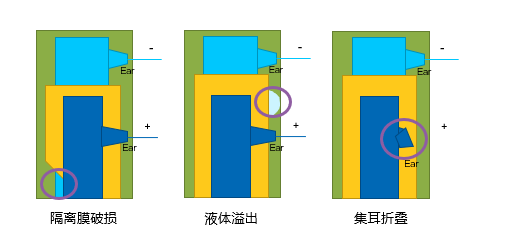

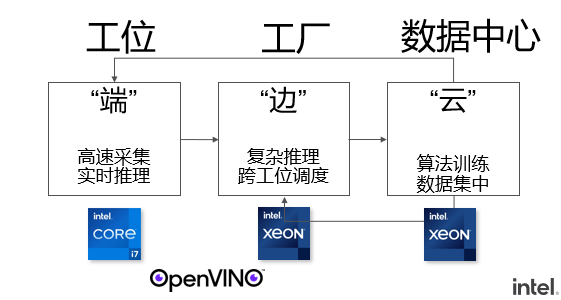

下圖是一個智能制造工廠中,利用“端—邊—云”協同架構,利用人工智能技術實現實時產品缺陷檢測的例子。在這個場景中,每個工位構成了“端”,在工位上架設的攝像頭可以每秒采集超過400張產品生產過程中的圖片。因此,在端這一側利用 AI 推理技術,對實時產生的大量圖片進行 AI 推理,從而避免將海量數據同時傳輸到云端產生的高成本及延時。生產流水線構成了這個場景中的“邊”,一些更為復雜的推理任務可以實時的在邊側完成,并進行跨工位的調度。最終所有的推理結果可以進一步推送到云端,進行數據集中以及更為深層次的分析,同時邊緣端產生的部分數據也可以推送至云端,作為訓練數據的補充,用于對深度學習模型進行重訓練,以獲得更高的準確性。

通過上述的例子,我們可以看出,在邊云協同的架構中,一個很重要的步驟就是將 AI 的推理擴展到邊緣端,避免邊緣端產生的大量數據向云端同時進行傳輸所引起的高成本,可以獲得接近或處于邊緣的近實時決策。而能夠實現邊緣端方便進行 AI 模型部署及推理加速的重要工具之一,就是由英特爾開源的OpenVINO工具套件。

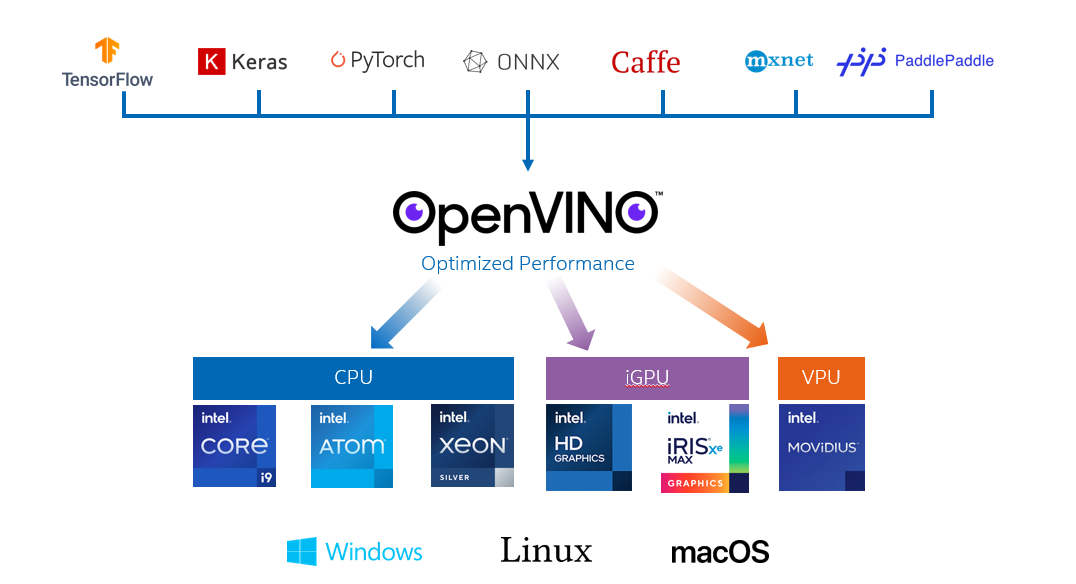

OpenVINO工具套件經過近四年的發展和演進,現已正式發布了迄今為止變化最大的版本,即 OpenVINO 2022.1版本。在這一版本中,不僅支持包括基于 Tensorflow,PyTorch 在內的深度學習框,更可以支持深受中國開發者喜愛的 PaddlePaddle 飛槳深度學習框架。同時,為了方便開發者在邊緣端部署深度學習模型,實現“一次撰寫,任意部署(Write once,deploy anywhere)”的目的,OpenVINO可以支持包括英特爾 CPU、集成 GPU(iGPU)以及 VPU 在內的多個硬件平臺的部署。只需要改動一行代碼,就可以實現多硬件平臺部署。

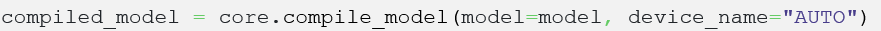

尤為值得一提的是,在 OpenVINO2022.1版本中,為了使得開發者更加便捷的使用 OpenVINO進行深度學習的推理,更推出了 AUTO 插件(“auto device”)。開發者只需要使用這樣的一行代碼

就可以在邊緣端實施 AI 推理時,由 AUTO 插件自動化的檢測開發者環境中可以用來進行 AI 推理的設備,并自動化的選擇更為合適的硬件設備進行 AI 推理。另外,根據不同使用場景的使用需求不同,AUTO 插件在使用時,還允許開發者選擇不同的“performance hint”性能指標模式,從而按照使用需求,獲得高吞吐量或者低延時的推理性能。

2在微軟云機器學習平臺 Azure ML 上利用

OpenVINO快速實現 AI 推理

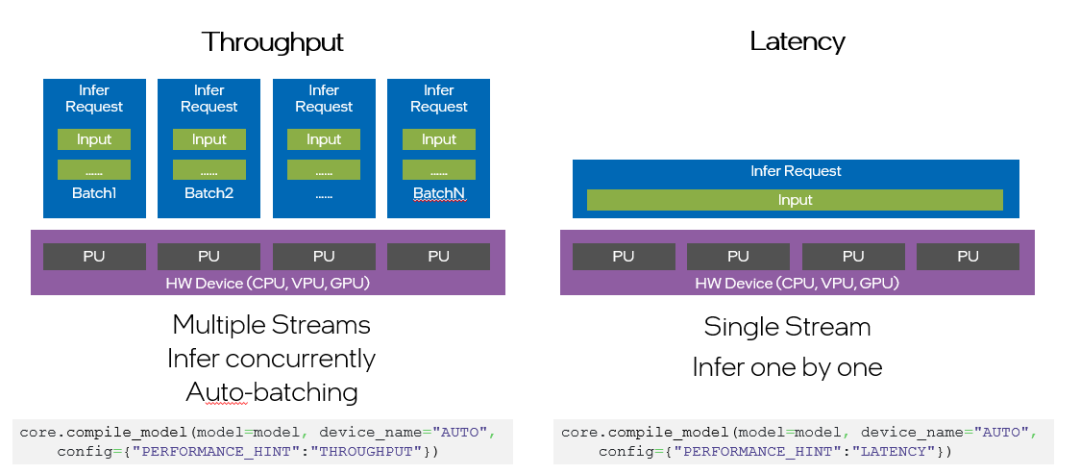

除了在邊緣端可以很方便地利用 OpenVINO工具套件進行快速部署以外,在云端,比如微軟云 Azure 的機器學習平臺 Azure ML 上,也可以利用 OpenVINO工具套件快速實現深度學習模型的部署,并進行相應的深度學習模型的優化及推理加速。實現步驟如下:

步驟一

在 Azure 上注冊個人賬號,并在機器學習平臺上建立自己的工作室,就類似于建立一個自己運行推理的專用路徑。工作室建立好之后,每次運行 AI 推理時,只需要點擊“啟動工作室”之后,就可以進入可以進行模型部署及推理的頁面了。

步驟二

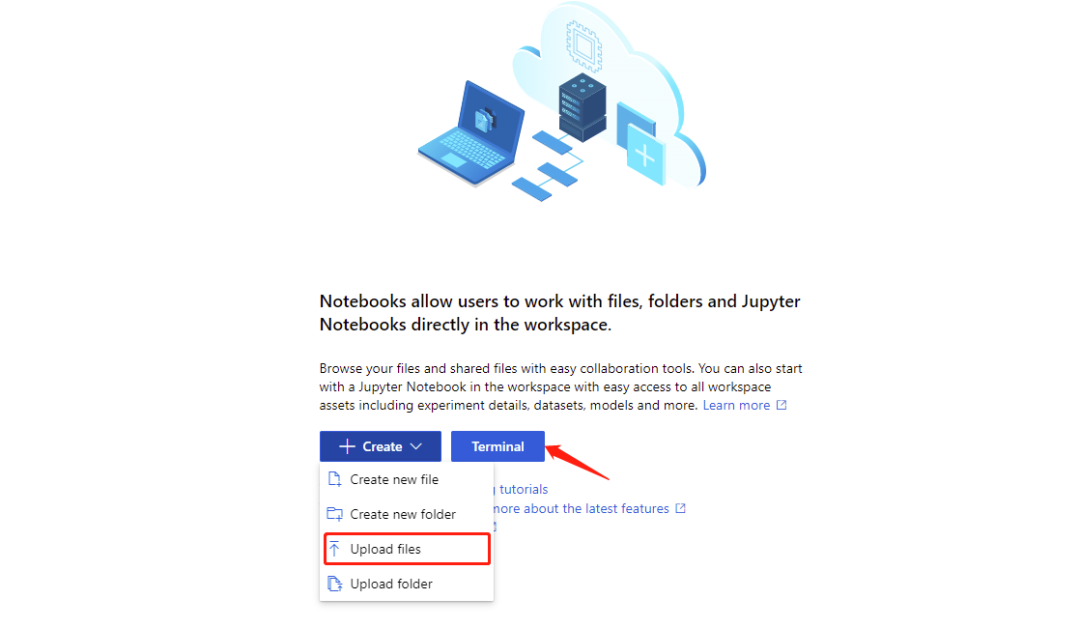

在啟動工作室之后,即進入以下頁面。由于我們是利用OpenVINOnotebooks的 notebook代碼示例資源,因此,我們在頁面上相應選擇Notebooks,即進入可以使用Jupyter Notebook 運行代碼,進行 AI 推理的頁面。

頁面地址:https://github.com/openvinotoolkit/openvino_notebooks

步驟三

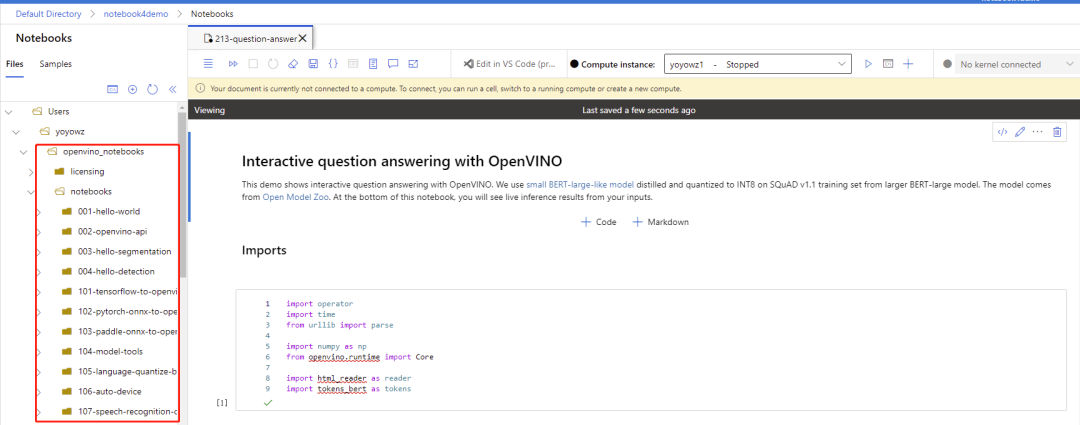

在進入 Notebooks 頁面后,即可根據界面提示由本地上傳所有 Notebooks 文件夾中的代碼示例。也可以新建終端 Terminals,在終端頁面以 git clone 的方式,直接將OpenVINO Notebooks 在 GitHub 上的資源導入在 Azure ML 平臺上的工作室。

所有 notebooks 代碼示例導入過后,即可看到文件夾內包含的所有代碼示例。

步驟四

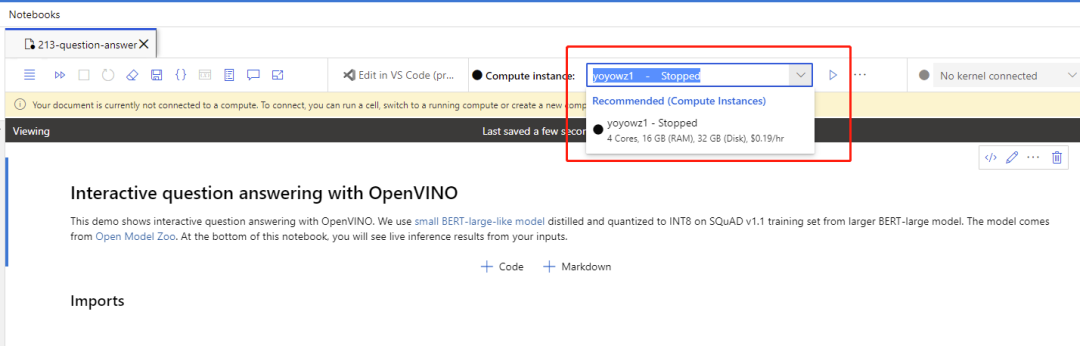

申請 Azure 上的計算資源,運行 notebook 代碼。

以運行 Notebook 213 機器問答代碼示例,在申請好并打開計算資源的使用后,運行機器問答 notebook 代碼示例,運行結果如下,

3小結:

在上面的內容中,我們跟大家分享了邊云協同的必要性,以及在邊緣端能夠實現快速深度學習模型優化、推理及任意部署的英特爾開源 OpenVINO工具套件。并通過一個實例,向大家展示了如何在 Azure 機器學習平臺上利用 OpenVINO快速實現深度學習模型的推理。

關于英特爾 OpenVINO開源工具套件的詳細資料,包括其中我們提供的三百多個經驗證并優化的預訓練模型的詳細資料,請您點擊:

https://www.intel.com/content/www/us/en/developer/tools/openvino-toolkit/overview.html

除此之外,為了方便大家了解并快速掌握 OpenVINO工具套件的使用,我們還提供了一系列開源的 Jupyter notebook demo。運行這些 notebook,就能快速了解在不同場景下如何利用 OpenVINO工具套件實現一系列、包括 OCR 在內的、計算機視覺及自然語言處理任務。OpenVINO notebooks的資源可以在 Github 以下地址下載安裝:

https://github.com/openvinotoolkit/openvino_notebooks

審核編輯:湯梓紅

-

英特爾

+關注

關注

61文章

9953瀏覽量

171700 -

機器學習

+關注

關注

66文章

8408瀏覽量

132573 -

微軟云

+關注

關注

0文章

11瀏覽量

2964

原文標題:使用OpenVINO? 在“端—邊—云”快速實現高性能人工智能推理

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

利用Arm Kleidi技術實現PyTorch優化

如何在低功耗MCU上實現人工智能和機器學習

微軟發布Azure AI Foundry,推動云服務增長

基于Arm Neoverse的微軟全新Azure虛擬機上線

微軟Azure首獲英偉達GB200 AI服務器

Palantir計劃在微軟Azure平臺上部署其人工智能產品

如影數字人生成平臺SenseAvatar上線微軟全球云市場

全球云服務市場增長,亞馬遜AWS、微軟Azure及谷歌GCP差距拉大

簡單兩步使用OpenVINO?搞定Qwen2的量化與部署任務

機器學習(ML)推理主要計算之存內計算芯片

簡單三步使用OpenVINO?搞定ChatGLM3的本地部署

FPGA在深度學習應用中或將取代GPU

是德科技推出AI數據中心測試平臺旨在加速AI/ML網絡驗證和優化的創新

在微軟云機器學習平臺Azure ML上利用OpenVINO快速實現AI推理

在微軟云機器學習平臺Azure ML上利用OpenVINO快速實現AI推理

評論