近年來,深度神經(jīng)網(wǎng)絡(luò)在將計(jì)算機(jī)視覺算法的準(zhǔn)確性提升到一個(gè)新的水平方面取得了重大進(jìn)展。OpenVINO 工具包就是這樣一個(gè)示例,它可以在提供高性能的同時(shí)優(yōu)化 DNN 模型。

英特爾其 OpenVINO 工具套件的最新版本 (2022.1),可為任何地方的開發(fā)人員提供更簡單的部署。OpenVINO 是“Open Visual Inference and Neural Network Optimization”的縮寫,是一個(gè)跨平臺的深度學(xué)習(xí)工具包,可提供額外的深度學(xué)習(xí)模型、設(shè)備可移植性和更高的推理性能,代碼更改更少。它專注于通過一次寫入、隨處部署的方法來增強(qiáng)深度神經(jīng)網(wǎng)絡(luò)推理,從而優(yōu)化應(yīng)用程序的開發(fā)生命周期。

該工具包有兩個(gè)版本,一個(gè)開源 OpenVINO 工具包和一個(gè)英特爾 Distribution of OpenVINO 工具包。OpenVINO 工具包主要用于開發(fā)各種問題的快速解決方案,如模擬人類視覺、語音識別、自然語言處理、推薦系統(tǒng)等。它為開發(fā)人員在其 AI 界面上工作以及采用和維護(hù)提供了一種更簡單的替代方案他們的代碼。OpenVINO 建立在最新一代人工神經(jīng)網(wǎng)絡(luò) (ANN) 的基礎(chǔ)上,例如卷積神經(jīng)網(wǎng)絡(luò) (CNN) 以及循環(huán)和基于注意力的網(wǎng)絡(luò)。

在英特爾硬件中,OpenVINO 包含計(jì)算機(jī)視覺和非計(jì)算機(jī)視覺工作負(fù)載。通過其眾多功能,它確保了最大的性能并加快了應(yīng)用程序的開發(fā)。它提供了來自自己的 Open Model Zoo 的預(yù)訓(xùn)練模型,這些模型提供了優(yōu)化的模型。OpenVINO 提供了模型優(yōu)化器 API,可以轉(zhuǎn)換您提供的模型并為推理做好準(zhǔn)備。推理引擎允許用戶通過編譯優(yōu)化的網(wǎng)絡(luò)和管理特定設(shè)備上的推理操作來調(diào)整性能。而且由于該工具包與大多數(shù)框架兼容,因此干擾最小,性能最高。

英特爾的 OpenVINO 工具套件分發(fā)版旨在促進(jìn)和簡化高性能計(jì)算機(jī)視覺和深度學(xué)習(xí)推理應(yīng)用程序在廣泛使用的英特爾平臺上的開發(fā)、創(chuàng)建和部署。OpenVINO 的應(yīng)用范圍從自動化和安全到農(nóng)業(yè)、醫(yī)療保健等等。

版本 2022.1 的功能

此版本為之前的 2021.3 版本提供了錯(cuò)誤修復(fù)和功能更改。

更新,更清潔的 API

這個(gè)新版本使維護(hù)開發(fā)人員的代碼變得更加容易。它可以與最小化轉(zhuǎn)換的 TensorFlow 約定集成。此版本減少了模型優(yōu)化器中的 API 參數(shù),以最大限度地降低復(fù)雜性。另一方面,在開放式神經(jīng)網(wǎng)絡(luò)交換 (ONNX*) 模型上的模型轉(zhuǎn)換性能得到了顯著提升。

更廣泛的模型支持

用戶可以在包括自然語言處理 (NLP)、雙精度和計(jì)算機(jī)視覺在內(nèi)的各種深度學(xué)習(xí)模型中輕松部署應(yīng)用程序。以 NLP 為重點(diǎn),以及額外類別的異常檢測,預(yù)訓(xùn)練模型可用于工業(yè)檢查、降噪、問答、翻譯和文本到語音。

便攜性和性能

此版本承諾通過跨 CPU、GPU 等的自動設(shè)備發(fā)現(xiàn)、負(fù)載平衡和動態(tài)推理并行性來提升性能。

OpenVINO 工具包附加組件

計(jì)算機(jī)視覺注釋工具

數(shù)據(jù)集管理框架

深度學(xué)習(xí)流媒體

神經(jīng)網(wǎng)絡(luò)壓縮框架

OpenVINO 模型服務(wù)器

OpenVINO 安全插件

培訓(xùn)擴(kuò)展

OpenVINO 的工作原理

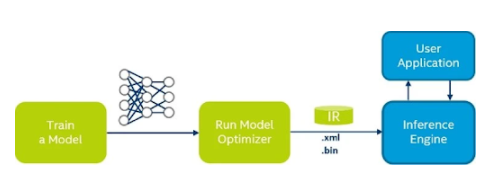

圖片來源:Viso.ai

OpenVINO 工具包由各種開發(fā)和部署工具組成,其中包括一套完全配置的預(yù)訓(xùn)練模型和用于評估的硬件。以下步驟描述了 OpenVINO 的工作原理:

先決條件:設(shè)置 OpenVINO

在開始實(shí)際工作流程之前,請確保您選擇了主機(jī)、目標(biāo)平臺和模型。該工具支持 Linux、Windows、macOS 和 Raspbian 等操作系統(tǒng)。至于深度學(xué)習(xí)模型訓(xùn)練框架,它支持TensorFlow、Caffe、MXNet、Kaldi,以及開放神經(jīng)網(wǎng)絡(luò)交換(ONNX)模型格式。

第 1 步:訓(xùn)練模型

第一步是準(zhǔn)備和訓(xùn)練深度學(xué)習(xí)模型。您可以從 Open Model Zoo 中找到預(yù)訓(xùn)練的模型,也可以構(gòu)建自己的模型。OpenVINO 為公共模型提供經(jīng)過驗(yàn)證的支持,并在存儲庫中提供一系列代碼示例和演示。您可以使用腳本為用于訓(xùn)練模型的框架配置模型優(yōu)化器。

第 2 步:轉(zhuǎn)換和優(yōu)化模型

配置模型后,您可以運(yùn)行模型優(yōu)化器將模型轉(zhuǎn)換為中間表示 (IR),該中間表示 (IR) 以一對文件(.xml 和 .bin)的形式表示。除了這對文件(.xml 和 .bin)之外,模型優(yōu)化器還通過輸出診斷消息來幫助進(jìn)一步調(diào)整。

第 3 步:調(diào)整性能

在這一步中,推理引擎用于編譯優(yōu)化模型。推理引擎是一種高級(C、C++ 或 Python*)推理 API,它作為每種硬件類型的動態(tài)加載插件實(shí)現(xiàn)。它為每個(gè)硬件提供最佳性能,無需維護(hù)多個(gè)代碼路徑。

第 4 步:部署應(yīng)用程序

推理引擎用于部署應(yīng)用程序。使用部署管理器,您可以通過將模型、IR 文件、應(yīng)用程序和相關(guān)依賴項(xiàng)組裝到目標(biāo)設(shè)備的運(yùn)行時(shí)包中來創(chuàng)建開發(fā)包。

綜上所述,這個(gè)新版本的 OpenVINO 工具包提供了許多好處,不僅優(yōu)化了用戶部署應(yīng)用程序的體驗(yàn),還增強(qiáng)了性能參數(shù)。它使用戶能夠開發(fā)具有易于部署、更多深度學(xué)習(xí)模型、更多設(shè)備可移植性和更高推理性能且代碼更改更少的應(yīng)用程序。

審核編輯:郭婷

-

Linux

+關(guān)注

關(guān)注

87文章

11312瀏覽量

209695 -

C++

+關(guān)注

關(guān)注

22文章

2110瀏覽量

73685 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5504瀏覽量

121220

發(fā)布評論請先 登錄

相關(guān)推薦

最新Simplicity SDK軟件開發(fā)工具包發(fā)布

基于EasyGo Vs工具包和Nl veristand軟件進(jìn)行的永磁同步電機(jī)實(shí)時(shí)仿真

GPU深度學(xué)習(xí)應(yīng)用案例

FPGA仿真工具包軟件EasyGo Vs Addon介紹

澎峰科技高性能大模型推理引擎PerfXLM解析

FPGA做深度學(xué)習(xí)能走多遠(yuǎn)?

采用德州儀器 (TI) 工具包進(jìn)行模擬前端設(shè)計(jì)應(yīng)用說明

深度學(xué)習(xí)編譯器和推理引擎的區(qū)別

使用freeRTOS開發(fā)工具包時(shí),在哪里可以找到freeRTOS的版本?

深度學(xué)習(xí)編譯工具鏈中的核心——圖優(yōu)化

QE for Motor V1.3.0:汽車開發(fā)輔助工具解決方案工具包

求助,請問有沒有l(wèi)abview opc ua工具包 2018 啊

labview工具包下載

利用ProfiShark 構(gòu)建便攜式網(wǎng)絡(luò)取證工具包

Torch TensorRT是一個(gè)優(yōu)化PyTorch模型推理性能的工具

用于深度學(xué)習(xí)推理的高性能工具包

用于深度學(xué)習(xí)推理的高性能工具包

評論