Citadel 的研究人員最近開發了一種深度神經網絡(DNNs),可以檢測一種稱為分布式拒絕服務(DDoS)DNS 放大的網絡攻擊,然后使用兩種不同的算法生成可以欺騙 DNN 的對抗性示例。

近年來,深度學習已證明自己是網絡安全中非常有價值的工具,因為它可以幫助網絡入侵檢測系統對攻擊進行分類并檢測新攻擊。對抗性學習是利用機器學習生成一組受擾動的輸入,然后饋送到神經網絡以對其進行錯誤分類的過程。目前對抗性學習領域的大部分工作都是在圖像處理和自然語言處理中使用各種算法進行的。

Citadel 的研究人員最近開發了一種深度神經網絡(DNNs),可以檢測一種稱為分布式拒絕服務(DDoS)DNS 放大的網絡攻擊,然后使用兩種不同的算法生成可以欺騙 DNN 的對抗性示例。

該研究以「A Deep Learning Approach to Create DNS Amplification Attacks」為題,于 2022 年 6 月 29 日發布在 arXiv 預印平臺。

現代網絡入侵檢測系統(NIDS)一直在發展,以利用人工智能和機器學習的當前進步,即深度學習。深度學習是通過神經網絡的實現嵌入的。深度學習技術的引入使 NIDS 能夠檢測大范圍的網絡威脅。雖然在分類網絡攻擊的范圍內神經網絡的實現相對較新,但圍繞機器學習分類在圖像處理和自然語言處理 ( NLP ) 等其他領域的使用已經進行了廣泛的研究。研究人員發現,神經網絡特別容易受到對抗性攻擊,其中要分類的數據受到干擾,以欺騙神經網絡接收不正確的分類。然而,對抗性攻擊已成為對神經網絡的真正威脅。雖然這些攻擊可能會產生重大后果,但這些在網絡安全領域被放大了。依賴配備神經網絡的 NIDS 的公司和組織可能容易受到嚴重滲透。這些 NIDS 的實現可能容易受到這些攻擊,并將有價值的信息暴露給惡意行為者。

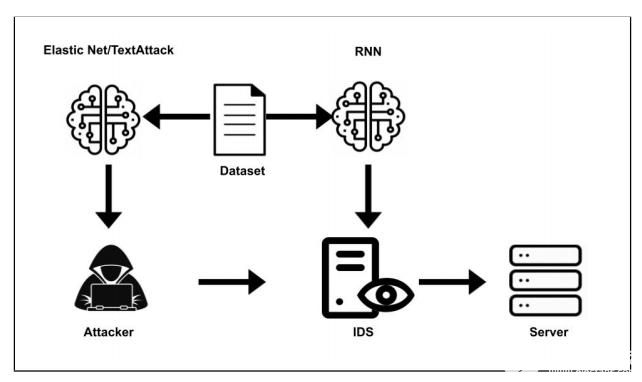

圖示:實驗結構圖。(來源:論文)已經開發了許多攻擊算法來實現圖像處理中的這一目標,例如 Carlini & Wagner Attack、Deepfool 和快速梯度符號法 ( FGSM ) 。在這些工作中表現出卓越的一種算法是對深度神經網絡(EAD)的彈性網絡攻擊。EAD 算法已與當前的深度神經網絡(DNN)對抗性攻擊算法進行了比較,并且在擾動最小的情況下優于其他算法。這些算法突出了現代 DNN 的脆弱性。圖像分類器可以通過對圖像的少量擾動有效地被愚弄。

NLP 領域的對抗性算法研究也產生了許多好的算法。這些算法是為 NLP 量身定制的,因此它們與圖像處理算法有很大不同。NLP 數據是離散的,而圖像更連續,因此需要非常專門的算法來保留被擾動的文本的語法結構,而對于圖像,像素可以沿著色譜連續擾動。由 提出的 TextAttack 算法越來越受歡迎。TextAttack 接收文本數據并通過替換字典中的單詞、刪除單詞中的字符甚至向單詞添加字符來擾亂它。就像在圖像分類中一樣,NLP 分類器被對其輸入的最小擾動所愚弄。

NIDS 利用神經網絡的范圍為惡意行為者破壞網絡提供了新的攻擊向量。這對在網絡入侵環境中實現的神經網絡的實際彈性以及這些算法的適用性提出了質疑。

這項研究和實驗構建了一個神經網絡,可以有效地檢測 DNS 放大攻擊,并利用 EAD 算法和 TextAttack 生成將被錯誤分類的對抗性示例(AE)。使用來自 KDD DDoS-2019 數據集的數據創建并訓練了一個模型,該數據集包含多種類型的 DDoS 攻擊,其中使用了 DNS 放大數據。

圖示:DNS 放大示意圖。(來源:論文)上圖突出顯示了共享數據集的實驗的白盒性質。攻擊者和 IDS 為他們的模型使用相同的數據集。在 IDS 方面,受害者使用數據集創建神經網絡來對 DNS 放大攻擊進行分類,而攻擊者利用相同的數據根據受害者的模型創建 AE。

在這個項目中,研究人員比較了圖像處理和 NLP 對抗算法如何處理網絡數據,形成了一個神經網絡來訓練 KDD DNS 數據并將這些算法中的每一個應用于它。

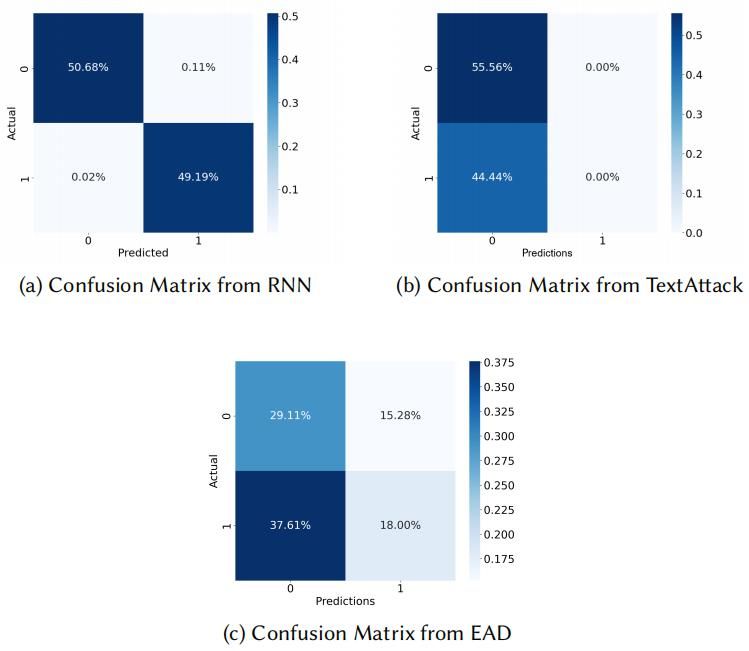

為了評估 EAD 和 TextAttack 實驗的結果,研究人員使用了兩個指標:平均擾動和攻擊成功率。如下圖所示,在進行攻擊之前獲取了模型的基線。

圖示:仿真結果。(來源:論文)為了計算由每種算法創建的 AE 的平均擾動,采用了未擾動數據包和擾動數據包之間的距離。為了計算每對數據包的百分比,評估了數據包中每個特征的百分比差異,然后按相應算法進行平均。結果如下圖所示。

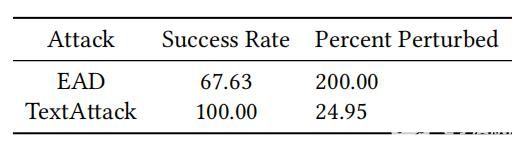

圖示:EAD vs TextAttack Perturbation Percentage and Success Rate。(來源:論文)兩種算法在平均擾動百分比方面存在巨大差異。EADs 高擾動率的原因是因為它作為優化的一部分始終將數據包特征全部擾動為 0,從而導致 200% 的距離。TextAttack 創建了一個更正常的距離,因為每個單獨的數據包特征單獨受到單個字符插入或刪除的輕微干擾。

借助 TextAttack,AE 能夠成功地在攻擊方面欺騙分類器,同時還允許良性數據包流保持良性。EAD 混淆矩陣也顯示出類似的結果,但方差略大。兩次攻擊都有很高的誤報率,這是攻擊的目標。它們也有很高的真陽性率,這表明它們可以保留良性數據包而不會將它們轉化為可分類的攻擊。被歸類為良性的攻擊的百分比用于計算攻擊成功率。結果表明,這兩種算法都能夠產生能夠欺騙 DNS 放大分類器的高質量 AE。

結語

在這項研究中,研究人員提出了一個 RNN 來訓練 DNS 放大數據。EAD 和 TextAttack 算法被應用于這個模型來欺騙它。根據它們與網絡流量數據的性能以及它們保存數據性質的程度,對這兩種算法進行了評估和比較。結果表明,欺騙機器學習 NIDS 是可能且相對容易的,這再次證實了這些深度學習算法很容易受到對抗性學習的影響。可以使為圖像處理或 NLP 創建的對抗算法適應網絡分類器。

雖然這些算法能夠擾亂網絡流量數據,但它們不一定能制作出真實的數據包,從而導致未來開發一種純粹用于網絡流量分類器的新對抗算法。研究人員發現 TextAttack 算法可以產生 100% 幾率欺騙模型的 AE。EAD 算法的 AE 有 67.63% 的機會欺騙模型。TextAttack 算法的擾動率為 24.95%,EAD 算法對數據包的擾動率為 200%。

未來的目標是創建一種新的對抗性攻擊,專門針對網絡流量分類器的攻擊而設計,并通過對抗性學習和訓練蒸餾來實施防御。

該團隊未來的下一個目標是將在 DNS 放大分類器上所做的工作應用于 IoT DDoS 攻擊。特別是針對許多物聯網設備使用的受限應用協議(CoAP)的 DDoS 攻擊。這將包括創建一個類似于來自 CoAP 流量(包括惡意數據包)的 KDD 的數據集。然后,這將應用于使用 NIDS 對 IoT 環境進行的真實世界模擬。

審核編輯 黃昊宇

-

深度學習

+關注

關注

73文章

5500瀏覽量

121113 -

nlp

+關注

關注

1文章

488瀏覽量

22033 -

DSN

+關注

關注

0文章

8瀏覽量

4589

發布評論請先 登錄

相關推薦

NPU在深度學習中的應用

一種基于深度學習的二維拉曼光譜算法

激光雷達技術的基于深度學習的進步

AI大模型與深度學習的關系

PyTorch深度學習開發環境搭建指南

深度學習模型量化方法

一種產生DSN放大攻擊的深度學習技術

一種產生DSN放大攻擊的深度學習技術

評論