隨著人工智能領域獲得牽引力,這些設備變得越來越計算和耗電。隨后,邊緣設備上的處理負載隨著系統架構的性能和復雜性而顯著增加。因此,在系統中灌輸了更高分辨率的圖像和更復雜的算法,隨著對AI處理的需求不斷增長,以實現高TOPS性能,這需要進一步優化。

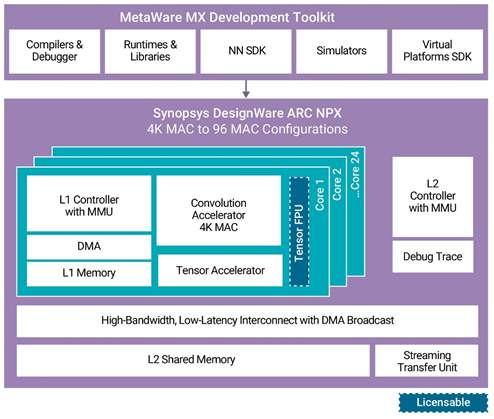

Synopsys 發布了神經處理單元 (NPU)、知識產權 (IP) 內核和工具鏈,以滿足 AI 片上系統 (SoC) 中日益復雜的神經網絡模型的性能需求。其新的設計軟件 ARC NPX6 和 NPX6FS NPU IP 可處理實時計算的需求,同時為 AI 應用消耗超低功耗。此外,該公司的新 MetaWare MX 開發工具提供了一個完整的編譯環境,具有自動化神經網絡算法分區,可最大限度地提高最新 NPU 上應用軟件開發的資源效率。

使用新的設計軟件 ARC NPX6 和 NPX6FS NPU IP 以及元軟件 MX 開發工具包,設計人員可以利用最新的神經網絡模型,滿足不斷升級的性能期望,并加快其下一代智能 SoC 的上市時間。ARC NPX6 NPU IP 系列包括許多處理深度學習算法覆蓋的產品,包括對象識別、圖像質量增強和場景分割等計算機視覺任務,以及音頻和自然語言處理等大型 AI 應用。設計中的單個內核可以從 4K MAC 擴展到 96K MAC,以實現超過 250 TOPS 和超過 440 TOPS 的單個 AI 引擎性能,并且很少。

NPX6 NPU IP 包含對多達 8 個 NPU 的多 NPU 群集的硬件和軟件支持,稀疏性為 3500 TOPS。由于硬件和軟件中的高級帶寬功能以及內存層次結構(每個內核中包含L1內存以及用于訪問常見L2內存的高性能,低延遲連接),可以擴展到大量MAC數量。對于受益于神經網絡內部 BF16 或 FP16 的應用,提供了可選的張量浮點單元。

MetaWare MX 開發工具包為應用軟件開發提供了軟件編程環境,包括神經網絡軟件開發工具包 (NN SDK) 和虛擬模型支持。NN SDK 會自動將使用流行框架(如巨炬、張量流或 ONNX)訓練的神經網絡轉換為 NPX 優化的可執行代碼。

這個概念是,NPX6 NPU處理器IP隨后可用于制造各種產品,從幾個TOPS到數千個TOPS,所有這些都可以使用單個工具鏈編寫。

可擴展的實時 AI/神經處理器 IP,具有多達 3,500 個 TOPS 的性能,支持 CNN、RNN/LSTM、變壓器、推薦器網絡和其他神經網絡。

功率效率(高達 30 TOPS/W)在業界無與倫比。

卷積加速器的 1-24 個內核,增加了 4K MAC/內核

張量加速器,支持張量運算符集體系結構并允許變量激活 (TOSA)

軟件開發套件

用于自動混合模式量化的工具

降低帶寬的架構和軟件工具特性

通過并行處理各個層來減少延遲。

設計軟件 ARC VPX 矢量 DSP 無縫集成。

生產力很高。張量流和巨炬框架,以及ONNX交換標準,由元軟件MX開發工具包支持。

此外,ARC NPX6FS NPU IP 符合 ISO 26262 ASIL D 標準,用于隨機硬件故障檢測和系統功能安全開發流程。這些處理器具有符合 ISO 26262 的特定安全機制,可處理下一代區域性設計的混合關鍵性和虛擬化需求,以及全面的安全文檔。

ARC 元軟件 MX 開發工具包包括神經網絡軟件開發工具包 (SDK)、編譯器和調試器、虛擬平臺 SDK、運行時和庫以及高級仿真模型。它提供了一個統一的工具鏈環境來加速應用程序開發,并在MAC資源之間智能地劃分算法以實現最佳處理。MetaWare MX 安全開發工具包包含安全手冊和安全指南,可幫助開發人員滿足 ISO 26262 標準,并為安全關鍵型汽車應用的 ISO 26262 合規性測試做準備。

利用 NPU 集群加速邊緣 AI 應用

為了滿足人工智能應用不斷增長的性能和復雜需求,恩智浦NPU IP核提供高性能、可擴展的實時人工智能和神經處理IP,具有多達3500個TOPS,支持各種神經網絡,如CNN、RNN/LSTM、變壓器和推薦器網絡。

此外,它通過并行處理各個層來減少延遲。此外,高生產力的元軟件 MX 開發工具包支持張量流和巨魔框架以及 ONNX 交換格式。

審核編輯:郭婷

-

處理器

+關注

關注

68文章

19281瀏覽量

229780 -

神經網絡

+關注

關注

42文章

4771瀏覽量

100752 -

人工智能

+關注

關注

1791文章

47258瀏覽量

238415

發布評論請先 登錄

相關推薦

AI模型部署邊緣設備的奇妙之旅:如何實現手寫數字識別

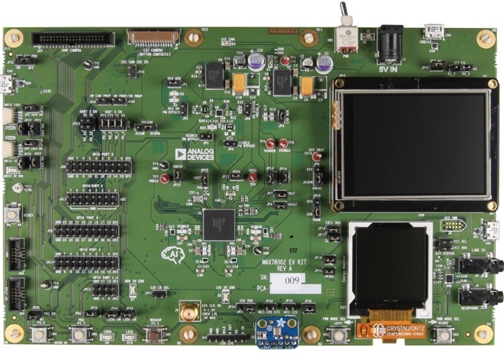

使用 ADI 的 MAX78002 MCU 開發邊緣 AI 應用

基于FPGA的類腦計算平臺 —PYNQ 集群的無監督圖像識別類腦計算系統

邊緣AI網關,將具備更強大的計算和學習能力

邊緣計算單元多接入能力怎么算

risc-v多核芯片在AI方面的應用

全新AMD銳龍8000F系列處理器整機正式發售 配備神經處理單元(NPU)

使用神經處理單元集群轉換邊緣AI

使用神經處理單元集群轉換邊緣AI

評論